Phi-4 es el último modelo de lenguaje desarrollado por Microsoft y que lleva los límites de los modelos de lenguaje pequeños con no menos de 14 mil millones de parámetros. Diseñado para un desempeño de punta en razonamiento complejo, especialmente en matemáticas, mientras sobresale en el procesamiento lingüístico clásico.

Phi-4: ¿Qué es exactamente?

Phi-4 es un pequeño modelo de lenguaje (SLM) desarrollado por Microsoft, dotado de 14 mil millones de parámetros. Inicialmente disponible en Azure AI Foundry, ahora está accesible como open source en Hugging Face bajo licencia MIT.

Este modelo se distingue por su rendimiento superior al de Google Gemini Pro 1.5 y OpenAI GPT-4, especialmente en tareas complejas como el razonamiento matemático, mientras consume menos recursos informáticos que los grandes modelos de lenguaje (LLM).

Diseñado a partir de una mezcla de datos sintéticos, sitios web de dominio público, literatura académica y conjuntos de datos de preguntas y respuestas, Phi-4 ha sido optimizado para ofrecer resultados de alta calidad con un razonamiento avanzado. Microsoft ha enfatizado la robustez y seguridad del modelo, utilizando técnicas de ajuste fino supervisado (SFT) y optimización directa de preferencias (DPO) para garantizar una adhesión precisa a las instrucciones y medidas de seguridad sólidas.

Phi-4 es particularmente adecuado para entornos con limitaciones de memoria y cálculo, así como para escenarios que requieren baja latencia. En resumen, representa un avance significativo en la investigación sobre modelos de lenguaje, ofreciendo una alternativa eficiente en términos de recursos para las aplicaciones de IA generativa.

¿Cuáles son las prestaciones de Phi-4?

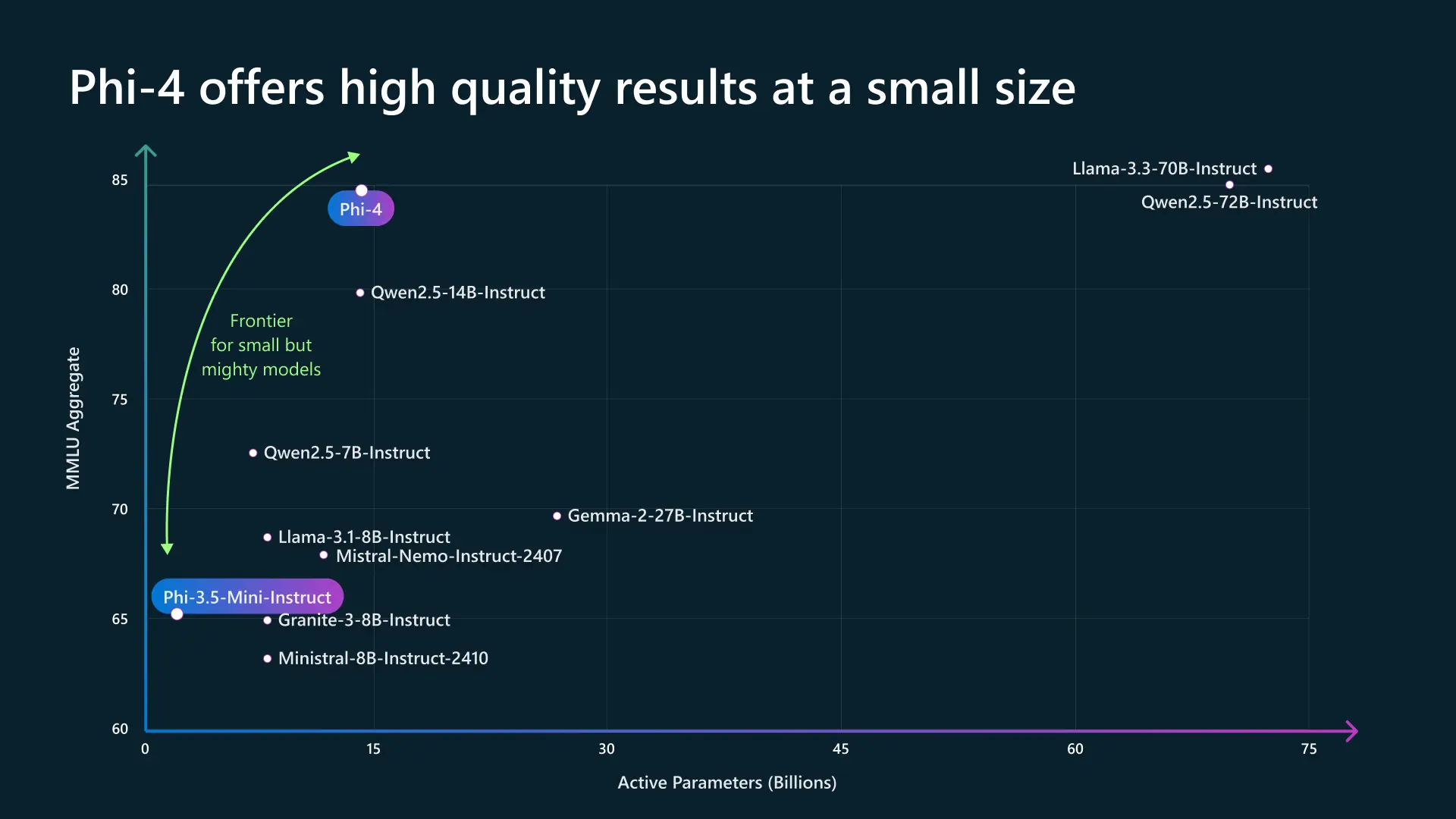

En un panorama donde el poder de los modelos de lenguaje a menudo se asocia con su tamaño, Phi-4 desafía esta tendencia demostrando que un modelo compacto puede competir con arquitecturas mucho más masivas. Gracias a una optimización avanzada, logra alcanzar un alto nivel de rendimiento en comprensión y razonamiento, mientras mantiene una huella reducida.

Donde otros modelos requieren decenas de miles de millones de parámetros activos para ofrecer resultados comparables, Phi-4 se impone como un equilibrio perfecto entre eficiencia y potencia. Esta posición estratégica responde a una demanda creciente de IA más accesibles y económicas en recursos, sin comprometer la calidad.

Su arquitectura optimizada permite no solo una ejecución más rápida, sino también una mejor adaptabilidad a entornos con recursos limitados, como las aplicaciones embebidas o los servidores de bajo consumo energético. Al reducir la dependencia de infraestructuras masivas, Phi-4 abre el camino a una democratización de la inteligencia artificial, donde altos rendimientos y eficiencia energética ya no son incompatibles. Así, ilustra una nueva generación de modelos capaces de responder a las necesidades industriales y académicas mientras siguen siendo ágiles y escalables.

¿Qué diferencia a Phi-4 de otros modelos similares?

Phi-4 se distingue por su excelente optimización, compitiendo con modelos ligeramente más grandes (como Qwen2.5-14B o Mixtral) mientras sigue siendo ligero y eficiente. Su puntuación MMLU de 85 lo convierte en un modelo muy competitivo en la categoría de SLM (Small Language Models).

Modelo | Parámetros activos (B) | Puntuación MMLU | Tipo | Principales Ventajas | Desventajas |

Phi-4 | ~10B | ~85 | Modelo optimizado, compacto | Excelente rendimiento para su tamaño, eficiente en inferencia, buen razonamiento | Menos potente que los modelos más grandes como GPT-4 o Llama 3-70B |

Mixtral (Mistral AI) | 12.9B (MoE, 2 expertos activos) | ~82-83 | MoE (Mixture of Experts) | Muy buen equilibrio entre rendimiento y eficiencia, rápido y optimizado | Más pesado en inferencia que Phi-4 |

Qwen2.5-14B-Instruct | 14B | ~80 | Modelo denso | Buena comprensión del lenguaje natural, fuerte en tareas generales | Menos optimizado que Phi-4, requiere más potencia |

Llama 3.1-8B-Instruct | 8B | ~70 | Modelo denso | Ligero y eficiente, buen compromiso para algunas tareas | Inferior en rendimiento global a Phi-4 |

Mistral-8B-Instruct | 8B | ~68-70 | Modelo denso | Muy eficiente en inferencia, open-source | Puntuación MMLU más baja que Phi-4, menos versátil |

Granite-3-8B-Instruct | 8B | ~65-67 | Modelo denso | Compacto y rápido | Menos eficiente que Phi-4 en razonamiento y análisis |

Donde otros modelos requieren más parámetros para alcanzar rendimientos similares, Phi-4 aprovecha una arquitectura avanzada y optimizaciones específicas para maximizar su eficiencia. Esto le permite no solo superar modelos de tamaño comparable, sino también acercarse a las capacidades de modelos más masivos, mientras mantiene una huella reducida.

Su inferencia rápida y su equilibrio entre potencia y consumo de recursos lo hacen ideal para casos de uso variados, especialmente en el entorno profesional y académico. A diferencia de los modelos más pesados que exigen infraestructuras robustas para operar de manera óptima, Phi-4 se posiciona como una solución ágil, perfectamente adaptada a sistemas con restricciones de poder de cálculo. Al integrar mecanismos avanzados de procesamiento de lenguaje y razonamiento, se destaca como una opción estratégica para aquellos que buscan una IA eficiente, accesible y eficaz.

Casos de uso: Phi-4 frente a un problema de lógica matemática

Imaginemos a un estudiante preparando un examen de matemáticas y enfrentándose a un problema complejo:

« Un caracol sube un muro de 10 metros. Cada día sube 3 metros pero se desliza 2 metros por la noche. ¿En cuántos días alcanzará la cima? »

Un modelo clásico podría simplemente dar una respuesta calculando mecánicamente:

- Día 1: sube a 3 m, baja a 1 m

- Día 2: sube a 4 m, baja a 2 m

- Etc.

Pero Phi-4 va más allá aplicando un razonamiento estructurado:

- Identifica el patrón recurrente: cada día, el caracol avanza realmente 1 metro neto.

- Optimiza el razonamiento: al cabo de 7 días, alcanzará 7 metros.

- Detecta una excepción: el octavo día, sube directamente 3 metros y alcanza la cima sin bajar.

- Concluye correctamente que el caracol tarda 8 días en llegar a la cima.

Este tipo de razonamiento estructurado muestra cómo Phi-4 no se limita a respuestas automáticas: descompone un problema, identifica los obstáculos ocultos y llega a una solución de manera lógica y eficiente.

Conclusión

En conclusión, Phi-4 encarna un avance mayor en el ámbito de los pequeños modelos de lenguaje (SLM), combinando rendimiento, eficiencia y accesibilidad. Este modelo posiciona a Microsoft a la vanguardia de la innovación en IA generativa, ofreciendo una alternativa poderosa y versátil para aplicaciones variadas, especialmente en razonamiento complejo y procesamiento lingüístico.