Aquí no hablamos de ChatGPT, pero de ahí proviene su nombre.

Si nunca has oído hablar de GPT, al menos ya has utilizado IA generativa de texto, o ‘LLM’ (Large Language Model). GPT es un tipo de LLM, en el cual se basa la mayoría de las IA generativas de las que todo el mundo habla en este momento!

ChatGPT, ¿entiendes por qué ahora?

GPT significa ‘Transformador Generativo Preentrenado’ (para la variante francesa), ¡y es un nombre muy claro que resume perfectamente su funcionamiento!

¿Cómo es que no están convencidos?

Imagina GPT como un súper-experto en predicción de palabras, su talento principal es adivinar qué palabra sería la más probable para completar el inicio de una frase. Repitiendo esta predicción una y otra vez, palabra por palabra, ¡construye frases completas, párrafos e incluso artículos enteros!

Ayudó un poco a escribir esto, pero todavía hay un humano detrás…

Detallaremos juntos las diferentes etapas de funcionamiento para ver cómo GPT aprende a comprender cómo funciona el lenguaje humano.

Paso 1: Transformar las palabras en números

Los ordenadores no entienden las palabras como nosotros. Para ellos, «gato» o «casa» son solo secuencias de letras, para que una máquina pueda trabajar con palabras, es necesario transformarlas en números.

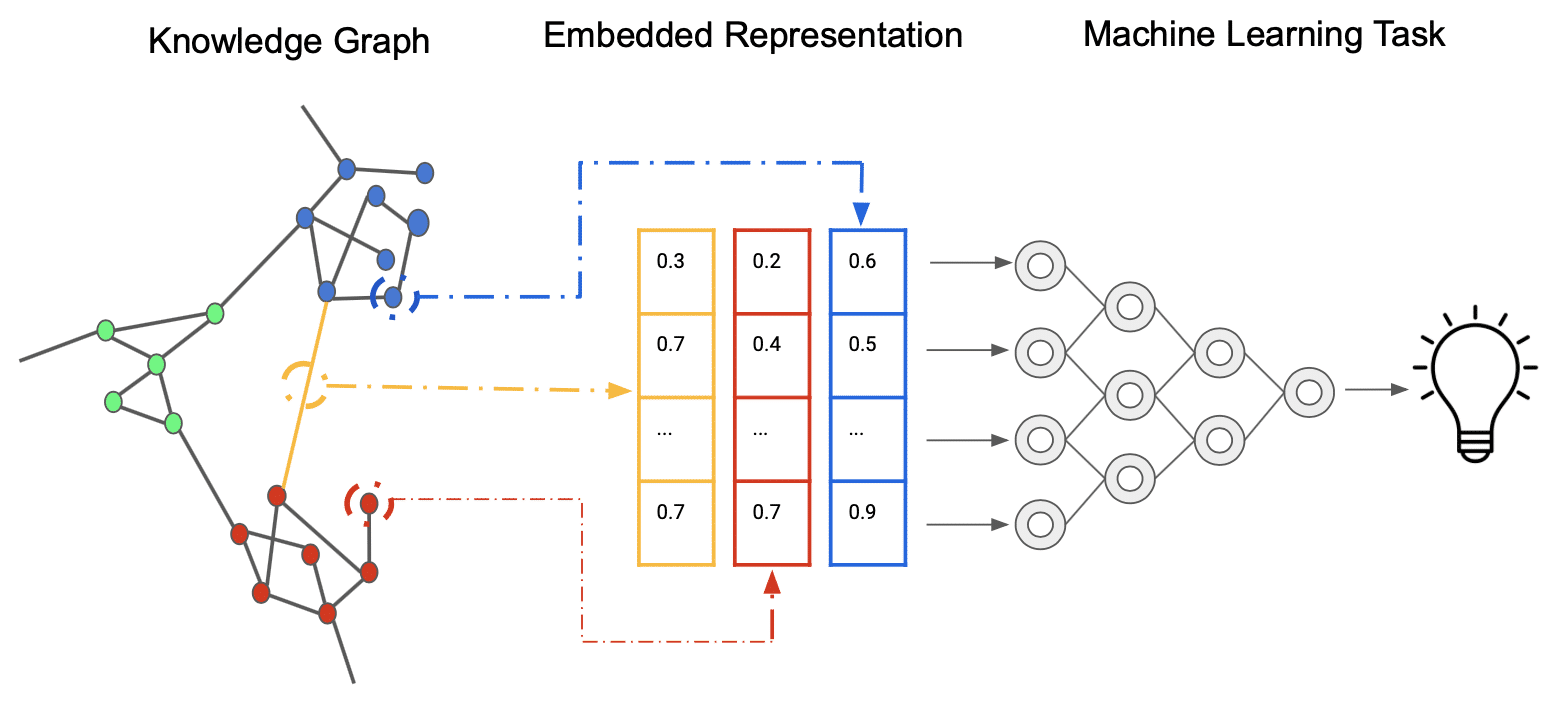

Ese es el papel de los Embeddings. Imagina que cada palabra del idioma (o casi) recibe un código secreto único, que es una lista de números.

Piensa en una biblioteca inmensa. Cada libro (cada palabra para GPT) recibe una etiqueta especial con un código de barras único (el vector de embedding). Este código de barras no es solo un número de identificación, contiene información oculta sobre el libro.

Por ejemplo, los códigos de barras de los libros de ciencia ficción podrían parecerse, los de los libros de cocina también, y si se trata de libros de ciencia ficción que, además hablan de robots, ¡su código de barras sería aún más cercano!

Cuanto más se parezcan dos palabras en significado, más cercana será su lista de números (su vector de embedding) en un espacio imaginario. Por ejemplo, los vectores para «rey» y «reina» estarán muy cerca, y la diferencia entre el vector de «rey» y «hombre» será similar a la diferencia entre «reina» y «mujer»! ¡Es genial, verdad?

Lo primero que hace GPT cuando le proporcionas texto es mirar cada palabra y encontrar su lista de números (vector de embedding) correspondiente en su «tabla de códigos secretos».

Paso 2: El orden de las palabras (Codificación posicional)

Ahora tenemos una lista de números para cada palabra. Sin embargo, si mezclamos las palabras, la frase pierde su sentido: «El gato duerme» no tiene el mismo significado que «Duerme el gato». No les estoy enseñando nada nuevo, ¡el orden de las palabras es crucial!

El problema es que nuestro modelo GPT procesa las palabras en paralelo (por razones obvias de tiempo de ejecución), sin preocuparse por su orden. Para resolver esto, agregamos información adicional a cada lista de números de las palabras: un marcador de posición.

Estos marcadores de posición (la Codificación Posicional) también son listas de números, calculadas con fórmulas matemáticas especiales.

No entraremos en detalles aquí, pero basta con recordar que ¡funciona súper bien!

Simplemente los sumamos a los vectores de Embedding de las palabras (su código de barras exclusivo).

Ahora, el modelo tiene una lista de vectores de embedding de cada palabra, que contienen la información de toda nuestra frase; cada elemento de esta lista contiene tanto información sobre la palabra misma como sobre el lugar donde se encuentra en la frase.

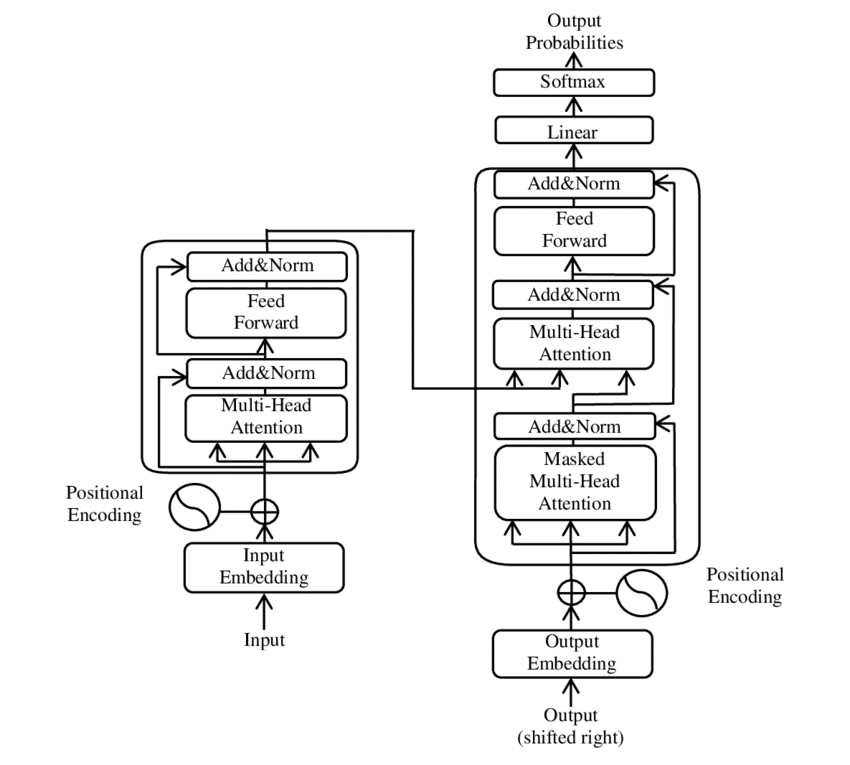

Paso 3: El Transformer

Nada que ver con Optimus Prime, aunque…

La parte más inteligente de GPT es la arquitectura Transformer. Véanlo como el cerebro que analizará la lista de números de la frase para entender el contexto y predecir la siguiente palabra.

Los modelos GPT utilizan una versión simplificada del Transformer original, llamada el Decodificador. ¿Por qué? Porque su trabajo es generar texto, ¡y ese es el papel del Decodificador!

Este Transformer se construye apilando varios «bloques» idénticos unos sobre otros. Cuantos más bloques haya (cuanto más complejo sea), más poderoso es.

Cada bloque tiene varios pasos para procesar los vectores de Embedding de nuestras palabras:

1. El principio de Atención

Es la idea genial detrás del Transformer. Cuando lees una frase, no das la misma importancia a todas las palabras para entender el sentido. Por ejemplo, en «El estudiante en DataScientest que había estudiado bien aprobó su examen», para entender «aprobó», te concentras en «estudiante» y «examen».

El mecanismo de Atención permite a nuestro modelo hacer lo mismo: para cada palabra de la frase, mira todas las palabras anteriores y decide cuáles son las más importantes para entender la palabra actual y predecir la siguiente.

A menudo, el Transformer usa varias «cabezas de atención» en paralelo. Es como si varias personas estuvieran leyendo la frase al mismo tiempo, cada una concentrándose en un tipo diferente de relación (una en la gramática, otra en el significado…), para luego poner en común sus análisis.

2. La Reflexión (O Feed-Forward)

Después de que el mecanismo de Atención haya permitido a cada palabra integrar el contexto de las palabras anteriores, cada vector de Embedding pasa independientemente a través de varias capas de funciones matemáticas que se basan en números, a los que llamamos pesos. Este conjunto se llama una red neuronal.

Esta capa permite al modelo realizar transformaciones más complejas sobre la información que la Atención ha extraído.

Paso 4: Volvemos a empezar con los mismos

El verdadero poder de GPT proviene del hecho de que no se trata de un solo bloque Transformer, sino de varios (¡decenas o incluso cientos!) apilados unos sobre otros.

Imagina una fábrica de varios pisos, en cada piso, nuestros vectores de Embedding son procesados por los mecanismos de Atención y Reflexión. La información que sale de un piso se convierte en la entrada del siguiente.

Las primeras capas aprenden a gestionar las relaciones simples entre las palabras.

Las capas intermedias combinan esta información para entender relaciones más complejas, la estructura de las frases. Las últimas capas comprenden el significado global, el tono, el estilo. ¡La información se vuelve más rica a medida que desciende los pisos!

Y cada vez más abstracta e incomprensible para nosotros, pobres humanos.

Paso 5: El entrenamiento

Imagina que le das a la máquina miles de millones de textos (libros, artículos, páginas web…). Le ocultas la palabra siguiente en cada frase y le dices: «¡Adivina!».

Eso es el entrenamiento.

El modelo intenta predecir la siguiente palabra basándose en las palabras anteriores.

Al principio, se equivoca mucho, pero en cada error le decimos: «No, la palabra real era esta», el modelo ajusta entonces sus parámetros internos (los pesos!) para que la próxima vez que vea una situación similar, ¡tenga más posibilidades de adivinar la palabra correcta!

Este proceso de ajuste basado en los errores se llama el Descenso de Gradiente.

Al jugar a este juego de predicción miles de millones de veces con miles de millones de textos, el modelo aprende no solo qué palabras suelen ir juntas, sino también la gramática, la sintaxis, e incluso diferentes estilos de escritura.

Paso final: La Generación de Texto

Una vez que el modelo está entrenado, está listo para generar texto, basándose en una primera instrucción para poder predecir palabras asociadas, ¡el prompt!

- El modelo toma tu prompt, lo transforma en listas de números, y los hace pasar por todos sus bloques Transformer.

- Da una lista de probabilidades para cada palabra posible del vocabulario. Por ejemplo, después de ‘Érase una vez…‘, la palabra ‘un‘ tiene un 80% de probabilidad, ‘una‘ un 10%, ‘el‘ un 5%, ‘en‘ un 3%…

- El modelo elige entonces una palabra entre esta lista de posibilidades. No siempre toma la más probable para que el texto no sea demasiado repetitivo. Esta palabra se añade a la secuencia: «Érase una vez un».

- El modelo toma esta nueva secuencia como entrada y repite el proceso: predice la siguiente palabra («caballero»? «gato»? «día»?), elige una palabra, la añade a la secuencia…

Y continúa, palabra por palabra, hasta que genera una palabra especial que significa «fin de frase» o «fin de texto», o que alcanza una longitud máxima.

Conclusión: ¡Esto funciona súper bien!

La potencia de GPT proviene de la combinación de varios elementos:

- La arquitectura Transformer y el mecanismo de Atención que le permiten comprender el contexto en frases muy largas.

- El apilamiento de las capas que le permite aprender representaciones cada vez más complejas del lenguaje.

- El entrenamiento masivo en enormes cantidades de texto, dándole un conocimiento muy amplio del lenguaje y del mundo.

- El proceso de generación palabra por palabra basado en la predicción, que le permite crear texto fluido y variado.

GPT no «piensa»: Es extremadamente bueno para identificar motivos estadísticos complejos en el lenguaje y los utiliza para predecir la continuación más probable de una secuencia de palabras.

¡Pero el resultado de esta predicción, gracias a la escala del modelo y los datos de entrenamiento, es a menudo un texto que nos parece inteligente, pertinente y creativo!