Un pipeline est un ensemble de processus et d’outils utilisés pour collecter des données brutes à partir de plusieurs sources, les analyser et présenter les résultats dans un format compréhensible. Les entreprises utilisent les pipelines de données pour répondre à des questions commerciales spécifiques et prendre des décisions stratégiques basées sur des données réelles. Tous les sets de données disponibles, (internes ou externes), sont analysés pour obtenir ces informations.

Par exemple, votre équipe commerciale souhaite se fixer des objectifs réalistes pour le prochain trimestre. Le pipeline leur permet de recueillir des données à partir d’enquêtes ou de commentaires de clients, d’historiques de commandes, de tendances du secteur, etc. Des outils d’analyse robustes vont alors permettre d’étudier en profondeur les données et d’identifier les tendances et les modèles clés. Les équipes peuvent ensuite créer des objectifs spécifiques, basés sur les données, qui augmenteront les ventes.

Data Science pipeline vs pipeline ETL

Bien que les termes « Data Science pipelines » et « pipelines ETL » font tous deux référence au processus de transfert de données d’un système à un autre, il existe des différences essentielles entre les deux :

- Le pipeline ETL s’arrête lorsque les données sont chargées dans un entrepôt de données (Data Warehouse) ou une base de données. Le Data Science pipeline ne s’arrête pas à cette étape et inclut des étapes supplémentaires telles que du Feature Engineering ou du Machine Learning.

- Les pipelines ETL impliquent toujours une étape de transformation des données (ETL signifie Extract Transform Load), contrairement aux Data Science pipelines pour lesquels l’essentiel des étapes se fait avec les données brutes.

- Les Data Science pipelines s’exécutent généralement en temps réel, tandis que les pipelines ETL transfèrent les données par blocs ou à des intervalles de temps réguliers.

Pourquoi le Data Science pipeline est-il important ?

Les entreprises créent des milliards de données chaque jour et chacune de ces données contient des informations exploitables. Le Data Science pipeline permet de tirer le maximum d’information en rassemblant les données de toutes les équipes, en les nettoyant et en les présentant de manière facilement assimilable. Cela permet de prendre des décisions rapides étayées par des données.

Les Data Science pipelines vous permettent d’éviter le processus fastidieux et sujet aux erreurs de collecte manuelle des données. En utilisant des outils intelligents d’ingestion de données (tels que Talend ou Fivetran), vous aurez un accès constant à des données propres, fiables et mises à jour, essentielles pour garder une longueur d’avance sur la concurrence.

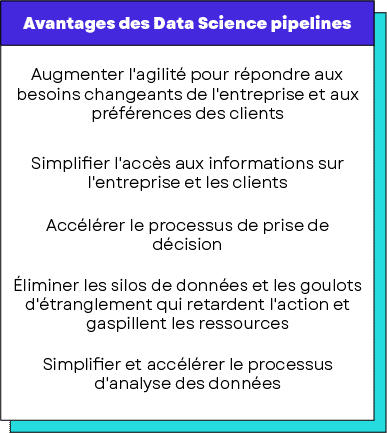

Avantages des Data Science pipelines

- Augmenter l’agilité pour répondre aux besoins changeants de l’entreprise et aux préférences des clients.

- Simplifier l’accès aux informations sur l’entreprise et les clients.

- Accélérer le processus de prise de décision.

- Éliminer les silos de données et les goulots d’étranglement qui retardent l’action et gaspillent les ressources.

- Simplifier et accélérer le processus d’analyse des données.

Comment fonctionne un Data Science pipeline ?

Avant de déplacer des données brutes dans le pipeline, il est essentiel d’identifier les questions spécifiques auxquelles vous souhaitez que les données répondent. Cela aide les utilisateurs à se concentrer sur les données intéressantes pour obtenir les informations appropriées.

Le Data Science pipeline est composé de plusieurs étapes qui incluent :

L’obtention des données

C’est à cette étape que les données provenant de sources internes, externes et tierces sont collectées et transformées dans un format utilisable (XML, JSON, .csv, etc.).

Le nettoyage des données

C’est l’étape la plus chronophage du processus. Les données peuvent contenir des anomalies telles que des paramètres en double, des valeurs manquantes ou des informations non pertinentes qui doivent être nettoyées avant de créer une visualisation de données.

Cette étape peut être divisée en deux catégories :

- Examen des données pour identifier les erreurs, les valeurs manquantes ou les enregistrements corrompus.

- Nettoyage des données, ce qui implique de combler les manques, de corriger les erreurs, de supprimer les doublons et de supprimer les enregistrements ou informations non pertinentes.

L’exploration et la modélisation des données

Une fois les données soigneusement nettoyées, elles peuvent ensuite être utilisées pour identifier des patterns. C’est là que les outils de Machine Learning entrent en jeu. Ces outils vous aideront à trouver des modèles et appliquer des règles spécifiques aux données ou aux modèles de données. Ces règles peuvent ensuite être testées sur des exemples de données pour déterminer comment les performances, les revenus ou la croissance seraient affectés.

L’interprétation des données

L’objectif de cette étape est d’abord d’identifier les informations et de les corréler aux résultats de vos données. Vous pouvez ensuite communiquer vos résultats aux chefs d’entreprise ou à vos collègues à l’aide de graphiques, de tableaux de bord ou de rapports.

La révision des données

À mesure que les exigences de l’entreprise changent ou que davantage de données deviennent disponibles, il est important de revoir périodiquement votre modèle et d’apporter des révisions si nécessaire.

Conclusion

Dans cet article, nous avons décrit l’utilisation des pipelines dans le secteur de la Data. En tant que Data Engineer ou Analytics Engineer, la création et l’entretien des pipelines de données sont nécessaires pour garantir leur qualité et leur disponibilité pour la création de modèles de Machine Learning, ou encore dans une démarche de Business Intelligence.

Pour découvrir les métiers de Data Engineer et Analytics Engineer et les parcours de formation que nous proposons, n’hésitez pas à consulter nos pages dédiées.