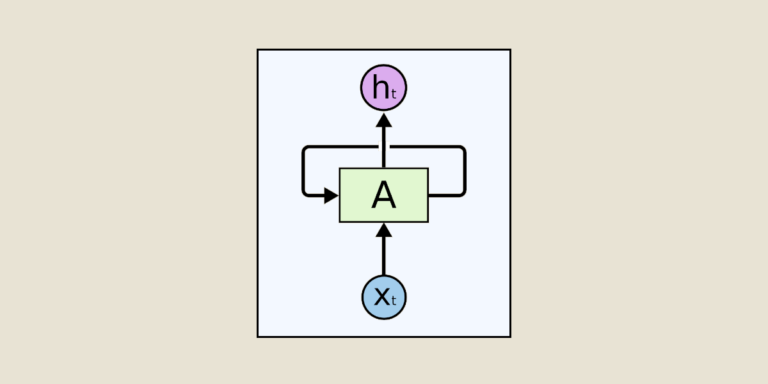

Las redes LSTM son una variación de las redes neuronales recurrentes (RNN). Fueron propuestas por Jürgen Schmidhuber y su equipo a principios de la década de 1990. Mientras que las RNN clásicas tienen dificultades para procesar dependencias a largo plazo debido al problema del "gradiente que desaparece", los LSTM fueron diseñados específicamente para superar este problema.

Si eres un seguidor de nuestro blog, ya sabes lo que son las Redes Neuronales Recurrentes (RNN), si no es el caso no dudes en leer este artículo antes aquí.

El problema de las RNN

El problema del “gradiente que desaparece” es un desafío comúnmente encontrado durante el entrenamiento de las redes neuronales recurrentes (RNN). Ocurre cuando las RNN intentan modelar dependencias a largo plazo en secuencias. A medida que los gradientes se propagan durante la retropropagación, su norma tiende a disminuir de manera exponencial, lo que resulta en una actualización de pesos insignificante para las neuronas cercanas al comienzo de la secuencia. Como resultado, las RNN tienen dificultades para aprender y capturar dependencias a largo plazo.

Este problema condujo al desarrollo de las redes LSTM, que utilizan mecanismos de regulación para evitar el gradiente que desaparece y capturar efectivamente las dependencias a largo plazo en las secuencias.

La arquitectura de las LSTM

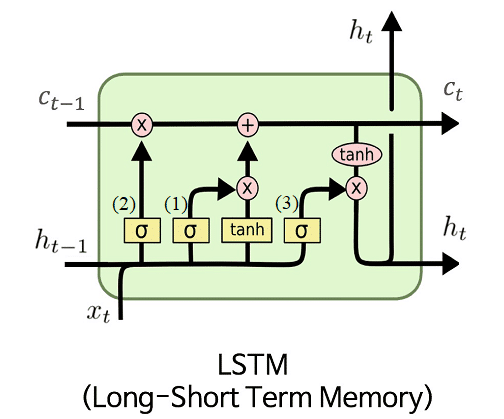

Las LSTM introducen una nueva unidad llamada celda de memoria, que permite a la red almacenar y acceder a información durante un período extendido.

La celda de memoria de un LSTM está compuesta por varias compuertas: una compuerta de entrada, una compuerta de salida y una compuerta de olvido. Estas compuertas regulan el flujo de información dentro de la celda de memoria, permitiendo así controlar la información a retener y la que se debe olvidar. Esto le da a las LSTM la capacidad de recordar información importante sobre secuencias largas e ignorar elementos menos relevantes. h_t es el estado oculto usual de las RNN pero en las redes LSTM añadimos un segundo estado llamado c_t. Aquí, h_t representa la memoria corta de la neurona y c_t representa la memoria a largo plazo.

La compuerta de entrada (1) determina qué información necesita ser actualizada en la celda de memoria. Considera la entrada actual x_t así como el estado previo de la celda de memoria h_(t-1) y genera un vector de activación que representa la información a añadir a la celda c_(t-1). Esta adición de información se traduce en una operación matemática realizada entre este vector de activación y el estado previo c_(t-1).

La compuerta de olvido (2) permite que el LSTM elimine información obsoleta de la celda de memoria. Utiliza tanto la entrada actual como el estado previo para generar un vector de activación que determina qué información debe ser olvidada. Esto también se traduce en una operación matemática realizada entre este segundo vector de activación y el estado previo c_(t-1). Es a partir de las dos operaciones previas sobre c_(t-1) que obtenemos el estado actual c_t.

Finalmente, la compuerta de salida (3) determina la salida del LSTM en un momento dado. Utiliza la entrada actual x_t y el estado actual de la celda de memoria c_t para generar un vector de activación que representa la salida del LSTM. Así es como obtenemos h_t.

La combinación de estas tres compuertas permite que la red LSTM maneje eficazmente dependencias a largo plazo. Durante la retropropagación del gradiente, los LSTM pueden mantener un flujo constante de información a través del tiempo, evitando así el problema del “gradiente que desaparece” y permitiendo un aprendizaje más estable y preciso.

Concretamente, ¿para qué sirve esto?

Una de las aplicaciones más comunes de las redes LSTM es la traducción automática. Gracias a su capacidad de tener en cuenta el contexto global de una secuencia, los LSTM pueden capturar dependencias a largo plazo entre palabras y generar traducciones más precisas. Además, los LSTM también pueden ser utilizados para generar texto de manera creativa, aprendiendo de grandes corpus de datos y generando nuevas frases coherentes y relevantes. El procesamiento del lenguaje natural es tan solo uno de los campos beneficiados por estas técnicas.

Además, las redes LSTM también han demostrado ser eficaces en áreas como el reconocimiento de voz. Debido a su capacidad de modelar dependencias a largo plazo, las LSTM pueden capturar las estructuras temporales complejas presentes en las señales auditivas y producir transcripciones precisas. Esto tiene implicaciones significativas en campos como la transcripción médica, la asistencia de voz y hasta en el control de voz de dispositivos electrónicos.

Las LSTM también se utilizan en tareas de predicción y clasificación de secuencias, tales como la predicción de series temporales, el análisis de sentimientos en textos, la detección de anomalías, y muchas más. Su capacidad para modelar dependencias a largo plazo y aprender patrones complejos las hace extremadamente versátiles y adecuadas para una amplia gama de problemas en su conjunto se beneficia de las capacidades de las LSTM.

Pero no son perfectas

Sin embargo, a pesar de su potencia y flexibilidad, las redes LSTM no están exentas de desafíos. Primero, son más complejas de entrenar que las redes neuronales tradicionales debido al mayor número de parámetros. A menudo requieren más datos de entrenamiento y mayor potencia de cálculo para obtener resultados óptimos. Además, las LSTM pueden ser sensibles al sobreentrenamiento si los datos de entrenamiento no son suficientemente variados y representativos.

A pesar de todo, las redes LSTM siguen generando un interés considerable en la comunidad de aprendizaje profundo, y se están realizando muchas investigaciones para mejorar su eficiencia y rendimiento. Variantes como las redes LSTM bidireccionales, las redes LSTM apiladas y las redes LSTM con atención se están desarrollando para satisfacer necesidades específicas y lograr mejores resultados en ciertas tareas.

En conclusión, las redes LSTM han revolucionado el campo del aprendizaje profundo permitiendo procesar eficazmente dependencias a largo plazo en datos secuenciales. Su capacidad para memorizar y utilizar información durante largos períodos de tiempo abre nuevas perspectivas en muchos campos de aplicación. Ya sea para la traducción automática, el reconocimiento de voz, el análisis de secuencias u otras tareas, las redes LSTM ofrecen un enfoque potente y prometedor para modelar datos complejos y capturar patrones temporales. A medida que la investigación continúa, es muy probable que las redes LSTM sigan evolucionando y jueguen un rol esencial en los futuros avances de la inteligencia artificial y el aprendizaje automático.

Por otro lado, si deseas poner en práctica los LSTM y profundizar en su comprensión, por ejemplo, de las redes LSTM con mecanismos de atención, no dudes en unirte a nuestro curso de Data Scientist.