A medida que los proyectos de inteligencia artificial ganan en complejidad, la capacidad para transferir y ejecutar modelos en entornos variados se ha vuelto esencial. El ecosistema actual se caracteriza por una multitud de artículos de desarrollo, cada uno con sus especificidades y formatos propietarios. En este contexto, ONNX (Open Neural Network Exchange) emerge como una respuesta estandarizada y open source para asegurar la interoperabilidad entre estos entornos.

¿Qué es ONNX?

ONNX es un formato abierto diseñado para representar modelos de machine learning y deep learning de manera independiente de los artículos. Permite a los desarrolladores exportar un modelo entrenado en un entorno (por ejemplo, PyTorch o TensorFlow) y ejecutarlo en otro mediante un motor de inferencia compatible como ONNX Runtime, TensorRT u OpenVINO.

Desarrollado inicialmente por Facebook y Microsoft en 2017, ONNX ahora cuenta con el apoyo de una amplia comunidad industrial (IBM, Intel, AMD, Qualcomm, etc.) y académica. Este estándar open-source facilita la reutilización de modelos, acelera el despliegue en producción, y fortalece la portabilidad y la agilidad de los sistemas de inteligencia artificial.

Arquitectura y componentes técnicos

El estándar ONNX se basa en tres pilares fundamentales:

- Gráfico de cálculo extensible

Cada modelo se representa en forma de un gráfico dirigido acíclico (DAG), donde los nodos corresponden a operaciones y los enlaces a los flujos de datos. Esto estructura las transformaciones matemáticas a aplicar en las entradas. - Operadores estándar

ONNX define un conjunto de operadores (convolución, normalización, activación, etc.) compatibles entre artículos. Estos operadores aseguran un comportamiento predecible de los modelos transferidos, sin necesidad de volver a entrenarlos. - Tipos de datos normalizados

El formato soporta tipos estándar (float, int, tensor multidimensional, etc.), garantizando una compatibilidad fina con los motores de ejecución.

Centrado principalmente en la fase de inferencia (evaluación de modelos ya entrenados), ONNX optimiza el rendimiento sin imponer restricciones en el entrenamiento.

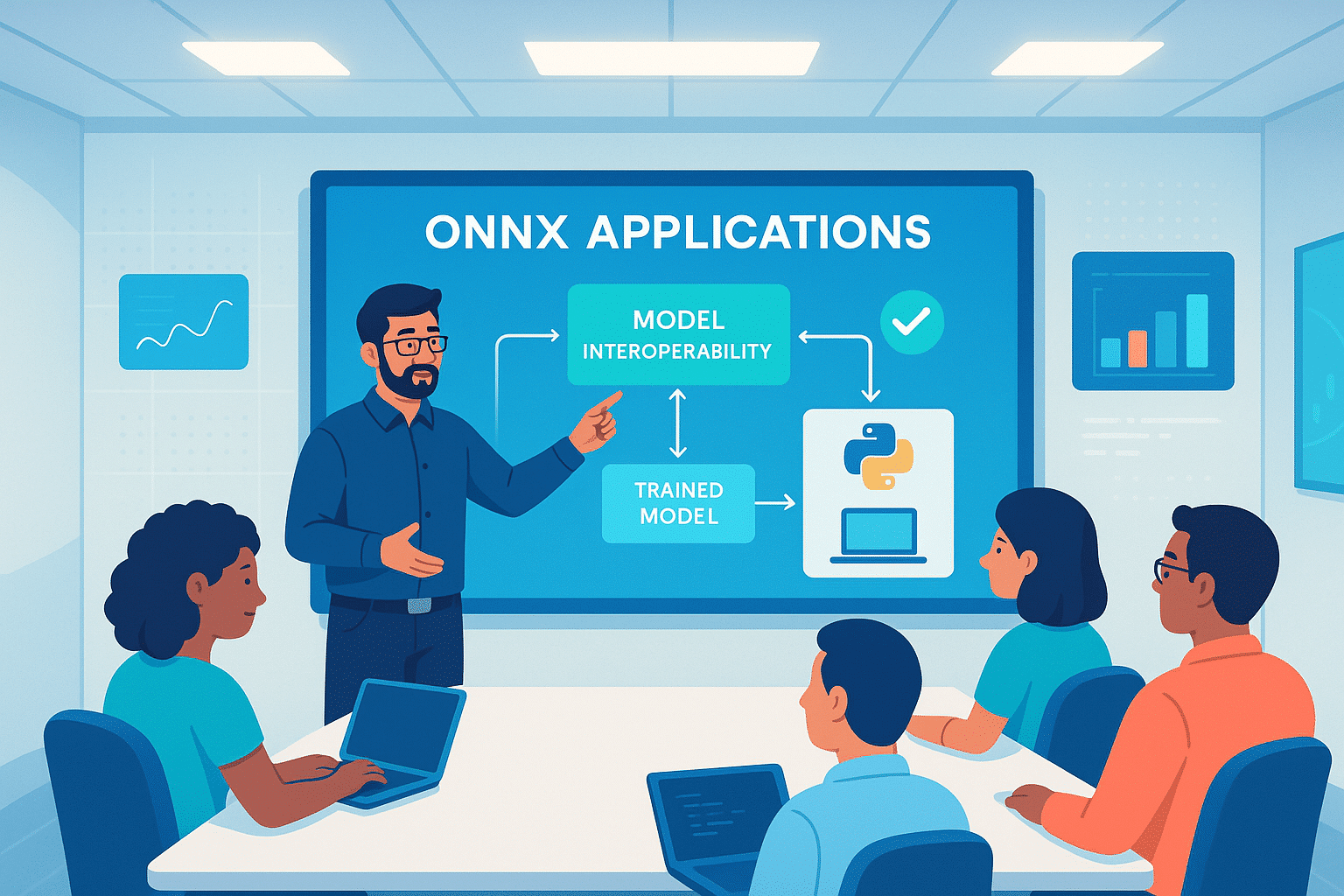

Este diagrama sintetiza el rol central de ONNX como intermediario de portabilidad entre el entrenamiento de los modelos de IA y su despliegue en diversos entornos de ejecución.

1. Parte izquierda – Entrenamiento

El modelo se diseña y entrena inicialmente en uno de los principales artículos de aprendizaje automático o profundo. ONNX permite exportar estos modelos en un formato unificado, facilitando así su reutilización y su despliegue en otras plataformas:

- PyTorch: muy extendido en la investigación y los entornos académicos, PyTorch atrae por su flexibilidad, su ejecución dinámica (eager mode) y su API clara, convirtiéndose en una herramienta de elección para el prototipado rápido y la experimentación.

- TensorFlow: ampliamente utilizado en la industria, TensorFlow ofrece una infraestructura robusta para el despliegue a gran escala, el cálculo distribuido y la optimización en diversos hardware, incluyendo GPU y TPU.

- scikit-learn: referencia indispensable para los modelos de machine learning clásicos (regresión, árboles de decisión, SVM…), scikit-learn se utiliza frecuentemente en fase de preprocesamiento o en pipelines que mezclan estadísticas y aprendizaje supervisado.

Esta combinación PyTorch / TensorFlow / scikit-learn cubre una gran mayoría de los casos de uso en IA moderna, desde el prototipado exploratorio hasta la puesta en producción industrial. ONNX juega aquí un papel de enlace entre estos ecosistemas.

2. Centro – Formato ONNX

El bloque central ONNX en el esquema representa un punto de convergencia tecnológica esencial. Sirve como capa de abstracción universal, encapsulando el modelo en un formato independiente de su artículo de origen. Esta portabilidad se basa en tres elementos clave: un gráfico de cálculo estructurado en DAG para una ejecución optimizada, un conjunto de operadores estandarizados que aseguran una semántica coherente, y tipos de datos formalizados que garantizan la compatibilidad de hardware. Así, ONNX ofrece una representación interoperable y agnóstica, lista para ser desplegada en una gran variedad de plataformas.

3. Parte derecha – Ejecución multiplataforma

Una vez exportado, el modelo ONNX puede desplegarse en la nube, en local, en el borde o en dispositivos móviles. Se ejecuta con motores de inferencia optimizados como ONNX Runtime, TensorRT u OpenVINO, e integra fácilmente en aplicaciones desarrolladas en diversos lenguajes como Python, C++, Java o JavaScript. Esta desvinculación entre el entrenamiento y la ejecución ofrece una flexibilidad máxima, mientras mantiene altas prestaciones gracias a las optimizaciones propias de cada backend.

ONNX Runtime: motor de ejecución optimizado

ONNX Runtime es el motor oficial de ejecución de modelos ONNX, diseñado para ser eficiente gracias a optimizaciones adaptadas a las arquitecturas de hardware (CPU, GPU, NPU), versátil con una compatibilidad multiplataforma (Windows, Linux, macOS, Android, iOS, web), y multilingüe; accesible a través de Python, C++, C#, Java, entre otros. Permite inferencias rápidas con un bajo impacto de memoria, haciéndolo especialmente adecuado para entornos de producción y dispositivos embebidos.

Casos de uso industriales

ONNX ofrece varias ventajas prácticas, incluyendo la interoperabilidad entre los equipos de data science e ingeniería. Permite a los investigadores desarrollar modelos en PyTorch, mientras que el equipo de producto puede integrarlos fácilmente en backends optimizados.

También facilita el despliegue multiplataforma, permitiendo a un mismo modelo ejecutarse en diversas plataformas como Azure, AWS, Android, o incluso en vehículos conectados.

Finalmente, ONNX permite una evaluación independiente de los modelos de IA en diferentes motores de inferencia, garantizando su robustez, estabilidad y precisión.

Conclusión

ONNX se ha consolidado como un pilar técnico de la interoperabilidad IA. Gracias a su formato estandarizado, simplifica el paso de la investigación a la producción, reduce la dependencia de herramientas propietarias, y fomenta la reutilización de modelos a gran escala.

En un contexto donde las arquitecturas de IA evolucionan rápidamente, ONNX constituye una inversión tecnológica estratégica para cualquier organización que busque industrializar eficazmente sus soluciones de inteligencia artificial.