Un Data Analyst es un científico especializado en storytelling, un codificador y un consultor empresarial, todo en uno. Utiliza diferentes herramientas informáticas y código para extraer datos de distintas fuentes, analizarlos, darles sentido y presentar los resultados, normalmente de forma visual. En este artículo vamos a ver una serie de herramientas que un Data Analyst puede necesitar a diario.

Fuentes de datos y consultas

Los Data Analysts pueden utilizar una gran variedad de herramientas para acceder a los datos. BigQuery permite el análisis interactivo masivo de grandes conjuntos de datos gracias al espacio de almacenamiento de Google.

Amazon Redshift es un producto de almacenamiento de datos que forma parte de la plataforma informática en la nube Amazon Web Services. Y el clásico MySQL, que es un sistema de gestión de bases de datos relacionales.

La mayoría de las veces, para acceder a los datos, escribimos consultas en lenguaje SQL. (Structured Language Query). Imaginemos que la empresa en la que trabajas tiene una gran base de datos con información sobre clientes, empleados, socios, etc., y tu jefe quiere responder a la siguiente pregunta: “¿Cuáles han sido las ventas del último trimestre?”

Para intentar responder a esta pregunta puede que necesites utilizar SQL para profundizar en los datos e investigar más a fondo.

El lenguaje SQL se utiliza en los SGBD, o Sistemas de Gestión de Bases de Datos. Entre ellos se encuentran MySQL, PostgreSQL, ORACLE y SQL Server. Estos sistemas utilizan el lenguaje SQL para gestionar bases de datos. Con SQL se puede: almacenar datos, manipular datos (realizar consultas, procedimientos).

En pocas palabras, SQL es un lenguaje que sirve de enlace entre el ordenador y un SGBD. Un Data Analyst debe ser capaz de utilizar SQL para acceder a los datos y analizarlos.

Tratamiento de datos y visualización de resultados

Ahora que ya tenemos acceso a los datos, pasaremos a la fase de tratamiento de datos y visualización de resultados. Esta vez nos gustaría responder a la siguiente pregunta: “¿Por qué ha habido una diferencia tan grande entre las ventas de los dos últimos trimestres?”

Podemos intentar responder a esta pregunta utilizando Excel, pero si la base de datos es demasiado grande o necesitamos hacer modificaciones más complejas, los lenguajes Python o R (y no solo) nos permiten ir más allá y estudiar los datos de una forma más flexible.

Python es un lenguaje versátil y bastante fácil de usar y aprender. Dispone de muchas bibliotecas para el cálculo científico y, si ya trabajas en una empresa, es muy probable que ya lo estén utilizando para otras tareas.

Anaconda es una distribución de lenguajes de programación Python y R para el cálculo científico, diseñada para simplificar la gestión y el despliegue de paquetes. La distribución incluye paquetes para Windows, Linux y macOS.

Pandas es una biblioteca de Python de código abierto que se utiliza sobre todo para tareas de ciencia de datos, análisis de datos y aprendizaje automático. La biblioteca está construida sobre otra biblioteca llamada Numpy, que proporciona soporte para matrices multidimensionales. Pandas es uno de los paquetes de procesamiento de datos más populares y funciona bien con muchos otros módulos de data science del ecosistema Python.

El paquete statsmodels tiene funciones que permiten realizar estadísticas más avanzadas sobre los datos.

Si lo que buscas son datos a los que se pueda acceder en sitios web, puedes utilizar la biblioteca Selenium para webscraping.

En resumen, Python te permite hacer una gran variedad de cosas, por eso es uno de los lenguajes más populares en el mundo de la data hoy en día.

Herramientas de Low-code y No-code

Las plataformas de low/no code proporcionan un entorno de desarrollo utilizado para crear aplicaciones de software a través de una interfaz gráfica de usuario.

Entre estas herramientas, Bubble permite programar aplicaciones y sitios web complejos sin tener que escribir código, mientras que la gama de aplicaciones de software Microsoft Power Platform permite desarrollar aplicaciones y conectividad de aplicaciones.

Una de las principales ventajas de las herramientas de low/no code es que ahorras tiempo de desarrollo y acabas con una aplicación operativa que responde a una necesidad.

Dashboards de visualización

Después de varias etapas, nos gustaría crear un cuadro de control (Dashboard) para todo el equipo, de modo que todos puedan seguir el análisis.

Con los datos que hemos obtenido, podemos mostrar gráficos que transmiten información relevante a personas que no se sienten necesariamente cómodas con el código.

Power BI es una plataforma interactiva de generación de informes. Puede manejar fácilmente una amplia variedad de tipos de datos y cantidades masivas de datos.

Se puede utilizar PowerBI para crear informes, trabajar con datos o simplemente ver informes para tomar decisiones.

Kibana es una extensión de visualización de datos para Elasticsearch. Permite buscar y visualizar datos indexados en Elasticsearch.

Una de las soluciones más de moda en estos momentos es Amazon QuickSight, que permite consultar datos en lenguaje natural para generar visualizaciones en pocos segundos.

Así que ya sabes más sobre las herramientas que los Data Analysts utilizan a diario, y como a veces una imagen vale más que 1000 palabras, ¡te hemos preparado una ficha resumen!

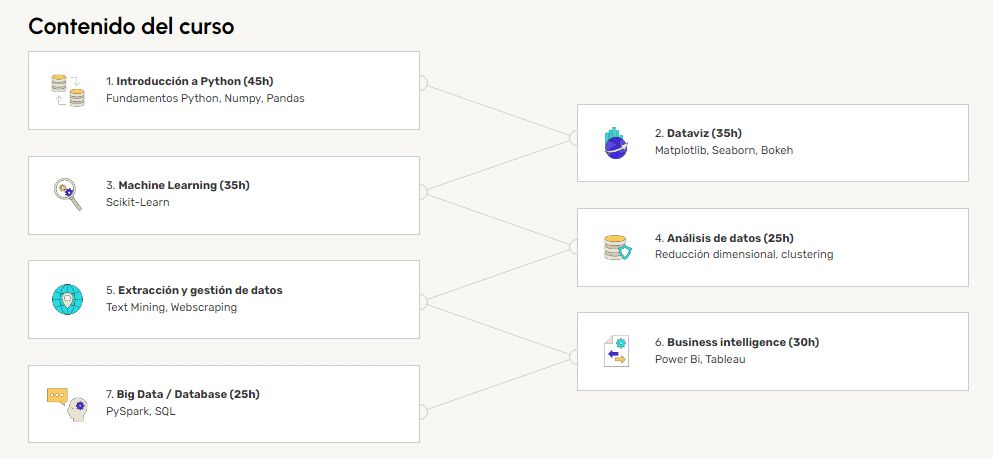

Y si quieres saber más sobre la profesión de Data Analyst, ¡echa un vistazo a nuestra página de formación!