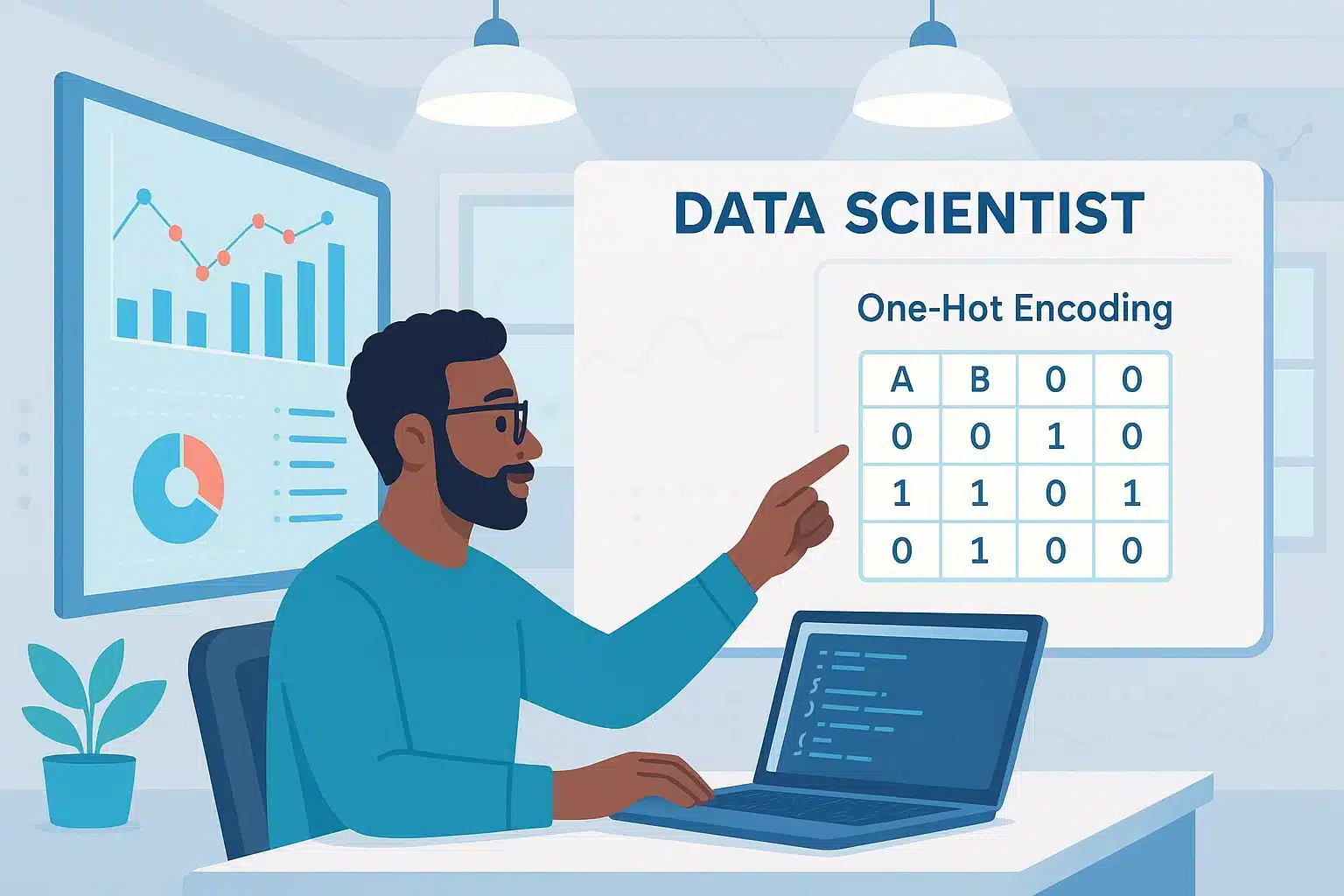

One-Hot Encoding es una técnica de codificación que permite convertir datos categóricos en vectores numéricos aprovechables por los modelos de machine learning. ¡Descubre todo lo que necesitas saber sobre este método!

Los algoritmos de machine learning son increíbles calculadores, pero tienen un gran punto débil: no entienden el texto. Para ellos, las palabras como « bleu », « Paris » o « chat » son simplemente ruido. Ahora bien, en los juegos de datos del mundo real, las variables categóricas están por todas partes. Nombre de un producto, estado civil, país, tipo de tarjeta bancaria… estas columnas no numéricas representan hasta un 40% de los datos tratados en los casos de uso en IA.

Por lo tanto, para hacerlas comprensibles para nuestros modelos, hay que traducirlas. Y uno de los métodos más simples y populares para ello es el One-Hot Encoding: una técnica que transforma cada categoría en un vector binario, legible, sin ambigüedades. Sin embargo, detrás de su simplicidad se esconde una mecánica de doble filo: útil, pero a veces demasiado pesada. ¡Veamos por qué, cuándo y cómo usarla correctamente!

Variables categóricas: un desafío omnipresente

Las encontramos en todos los cuadros de datos, y sin embargo a menudo pasan desapercibidas a primera vista: las variables categóricas son esas columnas que no contienen cifras, sino nombres, tipos, estados. Por ejemplo, si tienes una columna « color » con los valores « rojo », « verde » y « bleu », estás ante una variable categórica.

¿El problema? Los algoritmos de machine learning, ya sean lineales, de árbol o basados en redes neuronales, solo saben manejar números. Si dejas cadenas de caracteres en tus datos, puedes estar seguro de que tus modelos fallarán. O peor, aprenderán cualquier cosa incorrectamente.

Y no basta con convertir estas cadenas en números arbitrarios (« rouge » = 1, « vert » = 2, etc.). Porque en ese caso, el modelo interpreta esos números como una jerarquía o una distancia, lo cual suele ser incorrecto. Por eso la codificación es un paso imprescindible del preprocesamiento. Y el One-Hot Encoding es a menudo la solución por defecto. Pero antes de profundizar en ella, tomemos un momento para entender bien su principio.

El principio que transforma el texto en vectores

El One-Hot Encoding, que podríamos traducir como codificación « binaria caliente », se basa en una idea simple pero tremendamente eficaz: crear una columna para cada valor posible de una variable y luego activar únicamente la que corresponde al dato observado. Las demás se llenan con ceros.

Tomemos un ejemplo: tienes una columna « couleur » con los valores « rouge », « vert » y « bleu ». En One-Hot Encoding, se crean tres columnas: couleur_rouge, couleur_vert y couleur_bleu. Si una fila contiene « rouge », se coloca un 1 en couleur_rouge y ceros en las dos restantes. Si es « bleu », será 1 en couleur_bleu y 0 en el resto. ¿La ventaja? Se evita inducir un orden ficticio entre las categorías. Porque si se codificara « rouge » = 1, « vert » = 2, « bleu » = 3, un algoritmo podría pensar que « bleu » > « vert » > « rouge »… cuando esos valores no tienen ningún sentido ordinal.

Con el One-Hot Encoding, cada categoría se trata como una entidad independiente, sin vínculo numérico o jerárquico con las demás. Así, los modelos no introducen ningún sesgo relacionado con una falsa estructura en los datos. Este tipo de codificación es por tanto perfectamente adecuada para las variables categóricas nominales, es decir, sin lógica de orden (como género, ciudad o tipo de contrato).

Pero como veremos más adelante, este enfoque también tiene sus desventajas. Especialmente cuando el número de categorías explota.

Implementación en Python: pandas o scikit-learn, el duelo de los codificadores

El One-Hot Encoding es limpio, sin sesgos de jerarquía, compatible con todos los modelos. Pero tiene un gran defecto estructural: genera columnas a montones.

Tomemos un ejemplo muy real. Estás trabajando en un juego de datos de comercio electrónico con una variable « producto » que contiene 1 200 referencias diferentes. Después de aplicar One-Hot Encoding, tendrás 1 200 columnas. No es solo un problema estético. Es una bomba de tiempo para tu modelo. Dos problemas concretos emergen.

Primero, una explosión de la dimensionalidad, ya que cada nueva categoría crea una columna. Esto carga considerablemente el modelo, aumenta el tiempo de entrenamiento y puede inducir overfitting. Especialmente para modelos sensibles como los KNN o los árboles de decisión.

El segundo problema: una sparsity extrema. En una matriz de 1 200 columnas, solo hay un 1 por fila. Entonces, más del 95% de ceros en la mayoría de los casos. Si almacenas eso en formato denso, ¡buena suerte a tu RAM!

El One-Hot Encoding no es escalable sin precaución. Tan pronto se trata con variables de alta cardinalidad, hay que pensarlo dos veces antes de presionar « codificar ».

¿Hasta dónde se puede llegar? Los umbrales críticos a conocer

¿A partir de cuántas modalidades se debe evitar el One-Hot Encoding? No hay una regla absoluta, pero las devoluciones de la comunidad son claras: más allá de 10 a 15 categorías únicas, es mejor considerar una alternativa.

Varios problemas se acumulan. La multicolinealidad, con la famosa « dummy trap ». Al crear una columna por modalidad, introduces una redundancia total (la suma de todas las columnas siempre da 1). Algunos modelos pueden sufrir de esto, especialmente las regresiones lineales. La solución: eliminar una columna de referencia.

La inestabilidad en juegos de datos pequeños. Con pocas observaciones pero muchas categorías, el riesgo de overfitting es máximo. Además, los datos pueden estar desbalanceados. Algunas categorías pueden aparecer solo una o dos veces, creando columnas casi vacías e inutilizables.

En resumen, cuanto más modalidades, más el One-Hot se convierte en un arma de doble filo. Afortunadamente, no es la única opción en la caja de herramientas del data scientist.

Cuándo utilizar One-Hot Encoding... o no

Elegir tu método de codificación es muy importante. Aquí hay algunos casos en los que el One-Hot Encoding es pertinente… y otros donde es mejor abstenerse.

Este enfoque es perfecto frente a variables con pocas modalidades únicas (país, género, tipo de contrato…), o con datos equilibrados, sin categorías raras.

También es ideal en modelos simples o lineales (regresión logística, SVM, perceptron), o para casos de uso explicables: churn, scoring de clientes, marketing.

En cambio, es mejor evitarlo en columnas con decenas o cientos de categorías. Lo mismo en juegos de datos escasamente poblados o con muchos valores faltantes.

Alternativas inteligentes: cuando el One-Hot ya no es suficiente

Cuando el número de categorías explota, el One-Hot Encoding muestra sus límites. Afortunadamente, el ecosistema del machine learning ofrece varias alternativas, cada una con sus casos de uso preferidos.

Con el Label Encoding, cada categoría se reemplaza por un número entero único. Sencillo y rápido, pero a evitar con modelos lineales o basados en distancia. Cabe destacar que introduce un orden artificial (« vert » = 1, « rouge » = 2, « bleu » = 3…). Por ello, es un método útil para los árboles de decisión, que no son sensibles al orden.

Otro enfoque es el Target Encoding, también llamado Mean Encoding. Se reemplaza cada categoría por el promedio de la variable objetivo para esa categoría. Por ejemplo, si los clientes « Premium » compran en promedio por 300 €, se codifica « Premium » con 300. Es muy efectivo en variables con alta cardinalidad. Sin embargo, cuidado con el riesgo de filtraciones de datos si se usa sin cross-validation adecuada. Y atención al sobreaprendizaje.

Por otra parte, popularizados por el deep learning, los « embeddings » transforman las categorías en vectores continuos aprendidos automáticamente por el modelo. Cada modalidad se convierte en un punto en un espacio vectorial, cercano a los demás si tienen comportamientos similares. Es ultraefectivo en juegos de datos muy grandes, especialmente en NLP o recomendación de productos.

Citemos también el Feature Hashing. Ya no se codifica explícitamente cada categoría, sino que se pasa a través de una función de hash que la asigna a una columna entre un número fijo. Menos legible, pero muy útil para evitar la explosión de columnas. A manejar con precaución, ya que varias categorías pueden caer en el mismo « bucket ». En este caso se habla de « hash collision ».

Entre estas diferentes estrategias, debes elegir la más adecuada según el tamaño del juego de datos, el modelo utilizado y la naturaleza de tus categorías.

One-Hot Encoding y Deep Learning: ¿alianza u obsolescencia?

En las arquitecturas de deep learning, se podría pensar que el One-Hot Encoding está obsoleto. Y, sin embargo, aún se utiliza ampliamente… en algunos casos. Sigue siendo útil en tareas simples de clasificación con pocas clases, o en preprocesamiento de secuencias cortas (ej.: caracteres o tokens en NLP). Es un enfoque que sigue siendo también adecuado en arquitecturas donde no se tiene un embedding learnable o pocos datos.

Pero tan pronto se aborda problemáticas más profundas (NLP, recomendación, datos de usuarios…), claramente se prefiere los embeddings, que son más compactos, más ricos en significado y aprendidos directamente por el modelo. Un ejemplo típico: en lugar de transformar cada palabra en una columna binaria larga como un brazo, se utiliza un embedding vectorial de 300 dimensiones que capta significado, contexto, similitudes.

Conclusión: One-Hot Encoding, un método simple para codificar tus variables categóricas

El One-Hot Encoding es un poco el cuchillo suizo del científico de datos principiante: fácil de manejar, compatible con casi todos los modelos y suficientemente robusto para un buen número de casos prácticos. Pero detrás de esta simplicidad se esconden trampas: explosión de columnas, matrices huecas, overfitting, multicolinealidad… todas ellas son razones para no usarlo a ojos cerrados. Bien encuadrado, bien calibrado, sigue siendo un estándar imprescindible del preprocesamiento. Mal empleado, puede convertirse en una carga que pesa sobre tus rendimientos.

Si deseas profundizar en el dominio de las técnicas de preprocesamiento de datos, de codificación, de machine learning y deep learning, las formaciones en Inteligencia Artificial de DataScientest están hechas para ti. Nuestros programas completos te permitirán comprender los fundamentos de los modelos IA, manipular juegos de datos reales, implementar pipelines completos con Scikit-learn y TensorFlow. También aprenderás a explotar lo mejor de cada método como el One-Hot, los embeddings o el PCA.

Gracias a una pedagogía orientada a la práctica y casos concretos, podrás desplegar modelos eficientes y obtener una certificación reconocida. Nuestras formaciones se adaptan a tu ritmo: BootCamp intensivo o en tiempo parcial. ¡Únete a DataScientest y da sentido a los datos!

Ahora que sabes todo sobre el One-Hot Encoding. Para más información sobre el mismo tema, descubre nuestro artículo sobre el Deep Learning.