Desde su introducción en 2017, los modelos Transformer han transformado radicalmente el panorama de la IA, especialmente en el procesamiento del lenguaje natural (TAL/NLP).

Diseñados para superar las limitaciones de las redes neuronales recurrentes (RNN), los modelos Transformer se basan en mecanismos de auto-atención que permiten un procesamiento paralelo de los datos. Utilizados por sistemas emblemáticos como ChatGPT, BERT o ViT, han abierto el camino a aplicaciones que van desde la traducción en tiempo real hasta el análisis genómico. Este artículo explora su funcionamiento, impacto y desafíos.

¿Qué había antes de los Transformers?

Antes de 2017, los modelos dominantes para el procesamiento de secuencias (texto, voz) eran las redes neuronales recurrentes (RNN) y sus derivados como las LSTM (Long Short-Term Memory). Estas arquitecturas procesaban los datos secuencialmente, manteniendo un «estado de memoria» actualizado en cada etapa. Sin embargo, sufrían de dos problemas principales:

- Problema de la desaparición del gradiente: En secuencias largas, la información de los primeros tokens (palabras) se perdía.

- Tiempo de entrenamiento largo: El procesamiento secuencial limitaba la paralelización, haciendo que el aprendizaje fuese lento en grandes volúmenes de datos.

Para mitigar estos defectos, los investigadores introdujeron capas de atención que permitían a los modelos enfocarse en partes relevantes de la entrada. Por ejemplo, en una tarea de traducción inglés-francés, el modelo podía acceder directamente a las palabras clave de la oración fuente para generar una salida precisa. No obstante, estos mecanismos seguían acoplados a RNN… hasta la revolución Transformers.

¿Cómo se crearon los Transformers?

Descrito en el artículo fundacional «Attention Is All You Need» (Vaswani et al., 2017), esta arquitectura abandona las RNN a favor de una atención pura, combinada con técnicas innovadoras.

Posee estos componentes clave:

1. Codificación Posicional

A diferencia de las RNN, los Transformers no procesan los tokens en orden. Para preservar la información secuencial, cada palabra recibe un vector posicional (sinusoidal o aprendido) indicando su posición en la oración.

2. Auto-Atención

El núcleo del Transformer se basa en capas de auto-atención, donde cada token interactúa con todos los demás a través de tres matrices aprendidas:

- Consulta (Query): Representa lo que el token busca.

- Clave (Key): Determina lo que el token puede ofrecer.

Valor (Value): Contiene la información a transmitir.

Los pesos de atención se calculan mediante producto escalar entre consultas y claves, luego se normalizan mediante una función softmax.

Este mecanismo permite que cada token se apoye en el contexto completo de la oración, independientemente de su posición, favoreciendo así una mejor comprensión de las relaciones lingüísticas ».

3. Atención Multi-Cabezas

Para capturar diversos tipos de relaciones (sintácticas, semánticas), cada capa utiliza varias cabezas de atención en paralelo.

Cada cabeza de atención aprende una representación diferente, permitiendo que el modelo extraiga simultáneamente múltiples niveles de significado, como dependencias gramaticales y relaciones de sentido.

Los resultados se concatenan y transforman mediante una red neuronal de tipo feed-forward.

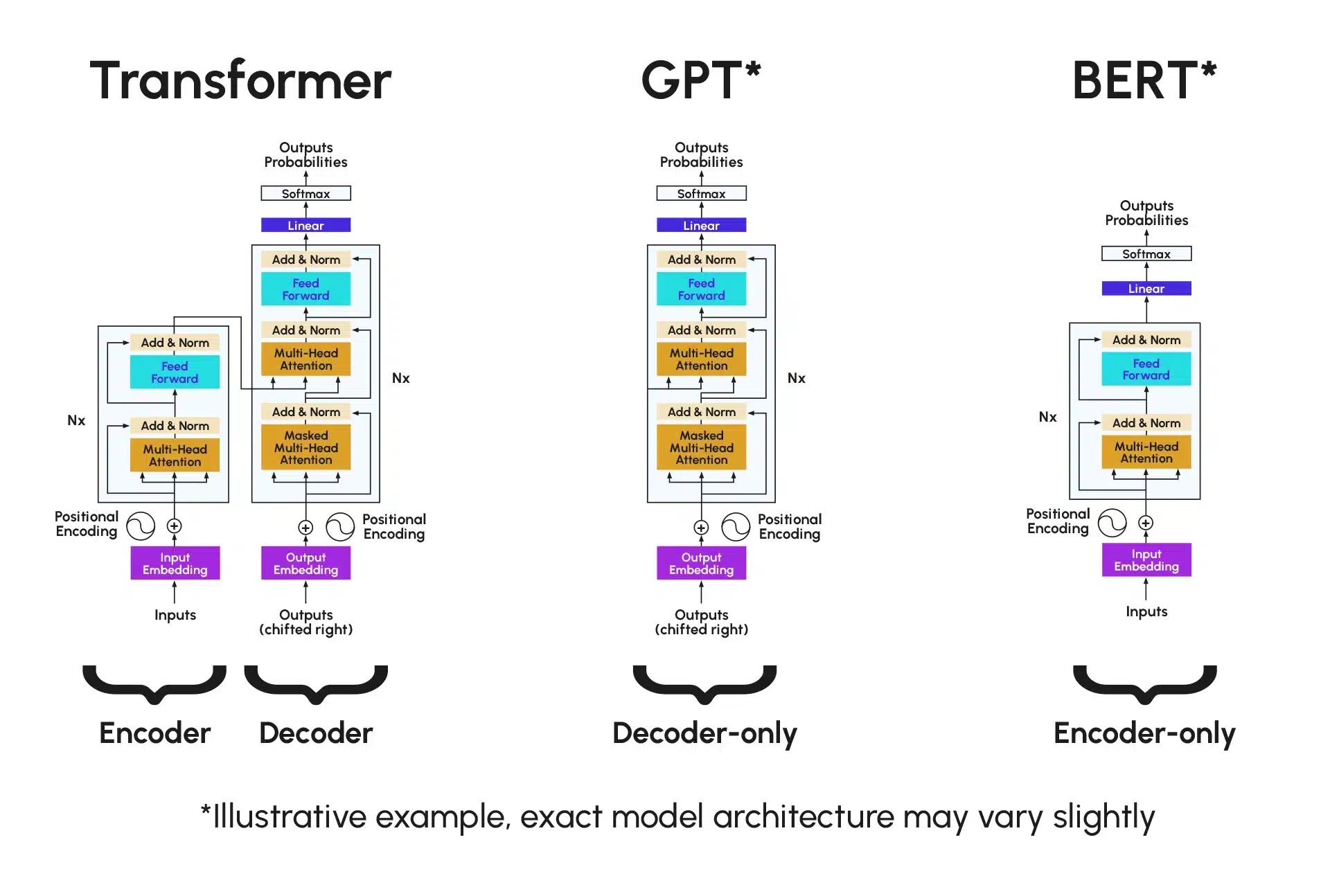

4. Codificador-Decodificador

- Codificador: Procesa la entrada para generar una representación contextual.

- Decodificador: Utiliza esta representación y los tokens anteriores para generar la salida paso a paso (por ejemplo, traducción).

¿Cómo se utilizan los Transformer Models?

En primer lugar, ChatGPT y los LLMs. Los Transformers generativos (GPT, PaLM) generan texto coherente prediciendo el siguiente token. ChatGPT, entrenado por refuerzo, sobresale en diálogo y creación de contenido.

También tenemos la comprensión contextual con BERT. A diferencia de GPT, BERT utiliza un codificador bidireccional para capturar el contexto global. En 2019, optimizaba el 70 % de las búsquedas de Google.

Además, están los Vision Transformers (ViT): al dividir una imagen en parches de 16×16, ViT compite con las CNN en clasificación, detección de objetos, etc., gracias a su capacidad para modelar relaciones a largo alcance.

La figura a continuación esquematiza la arquitectura de los Transformers así como la de GPT y BERT para comparación, que utilizan una parte de la arquitectura Transformers:

¿Cuáles son las ventajas de los Transformer Models?

Al paralelizar los pasos, se vuelven más eficientes: al evitar el procesamiento secuencial, los Transformers aprovechan completamente las GPU/TPU, reduciendo los tiempos de entrenamiento en un 50 a 80 % en comparación con las RNN.

Su arquitectura permite un preentrenamiento masivo en corpus no etiquetados, como Wikipedia o el contenido de libros. Modelos como BERT o GPT-3 alcanzan rendimientos sin precedentes gracias a cientos de miles de millones de parámetros.

Inicialmente diseñados para el NLP, hoy en día los Transformers son versátiles y se extienden a:

- La visión por ordenador: ViT (Vision Transformer) divide las imágenes en parches y las procesa como secuencias.

- La biología: el análisis de secuencias de ADN o proteínas.

- Lo multimodal: modelos que combinan texto, imagen y sonido, como DALL-E.

¿Cuáles son las limitaciones de los Transformer Models?

Podemos citar en primer lugar el costo computacional y ambiental: el entrenamiento de modelos como GPT-3 consume varios megavatios-hora, planteando cuestiones éticas y ecológicas.

Además, los Transformers reproducen los sesgos presentes en sus datos de entrenamiento. Esto representa un riesgo mayor cuando se utilizan para decisiones críticas, como por ejemplo el reclutamiento a través de la clasificación de CVs o la ayuda a la decisión médica, ya que los sesgos implícitos pueden perpetuarse e incluso amplificarse. También pueden generar afirmaciones falsas pero plausibles, como la invención de referencias académicas inexistentes o la afirmación de que un evento ficticio ocurrió realmente. Estas afirmaciones son alucinaciones.

Otra limitación inevitable es la complejidad de interpretación. De hecho, los mecanismos de atención, aunque poderosos, siguen siendo «cajas negras», dificultando la detección de errores sistémicos.

¿Cuáles son las perspectivas futuras de los Transformer Models?

La rápida evolución de los Transformers ha transformado profundamente numerosos campos, haciendo indispensables las investigaciones sobre la optimización y reducción de su huella energética. Hoy en día, se nos presentan perspectivas prometedoras sobre el uso de los Transformers:

- Modelos Eco-Eficientes: Investigación de arquitecturas frugales donde se pone énfasis en la optimización del consumo de recursos (energía, memoria, potencia de cálculo, volumen de datos…), como los Sparse Transformers, o el uso de técnicas como LoRA (Low-Rank Adaptation) que permite afinar modelos sin necesitar un reentrenamiento completo

- IA Multimodal: Integración transparente texto-imagen-video como GPT-4 o Gemini, que tratan varias modalidades en un solo modelo).

- Personalización Ética: Adaptación de los LLMs a necesidades específicas sin sesgos.

Conclusión

Los Transformers han redefinido las fronteras de la IA, combinando eficiencia, versatilidad y potencia. Aunque enfrentan desafíos técnicos y éticos, siguen siendo la piedra angular de los avances actuales, desde asistentes virtuales hasta la investigación médica, a través de herramientas de ayuda al diagnóstico médico. Su evolución hacia sistemas más responsables y menos energívoros probablemente marcará la próxima década de la inteligencia artificial.