La adversarial robustness se centra en la seguridad de los modelos de machine learning haciéndolos resistentes a ataques maliciosos. Su objetivo es desarrollar mecanismos de defensa y técnicas de refuerzo de seguridad para garantizar que los modelos puedan mantener su rendimiento en presencia de ataques adversariales, asegurando así la fiabilidad y seguridad de los sistemas de inteligencia artificial.

En el ámbito de las técnicas populares de machine learning, los avances de alto nivel han llevado a modelos de vanguardia capaces de realizar proezas impresionantes. El deep learning, un poderoso marco de machine learning, ha revolucionado varios campos, desde la visión por computadora hasta el procesamiento del lenguaje natural. Sin embargo, a pesar de estos logros notables, los modelos de deep learning, especialmente aquellos basados en la optimización por gradiente, son a menudo vulnerables a los ataques adversariales (Adversarial Attack: Definición y protección contra esta amenaza (datascientest.com)). Esta vulnerabilidad ha impulsado el surgimiento de un área de investigación crítica conocida como robustez adversarial, que se esfuerza por desarrollar técnicas para mejorar la resistencia de los modelos de machine learning ante tales ataques.

¿Qué es el entrenamiento adversarial?

El entrenamiento adversarial (o adversarial training) está a la vanguardia de las estrategias utilizadas para afrontar este desafío de robustez. El concepto del entrenamiento adversarial consiste en enriquecer el proceso de aprendizaje con ejemplos adversarios cuidadosamente elaborados. Estos ejemplos son entradas diseñadas intencionadamente para engañar al modelo de machine learning. Al exponer al modelo a estos ejemplos adversarios durante su formación, se vuelve más robusto y aprende a hacer predicciones precisas incluso cuando se enfrenta a entradas adversarias similares en escenarios del mundo real.

La idea clave del entrenamiento adversarial es crear un conjunto de datos completo que incluya tanto ejemplos limpios como ejemplos adversarios. Durante la formación, el modelo es expuesto a ambos tipos de ejemplos, lo que le obliga a aprender no solo los patrones inherentes a los datos, sino también a reconocer las perturbaciones y a resistirlas. Repitiendo este proceso, el modelo se vuelve progresivamente más resistente y capaz de generalizar las defensas que ha aprendido a entradas no vistas.

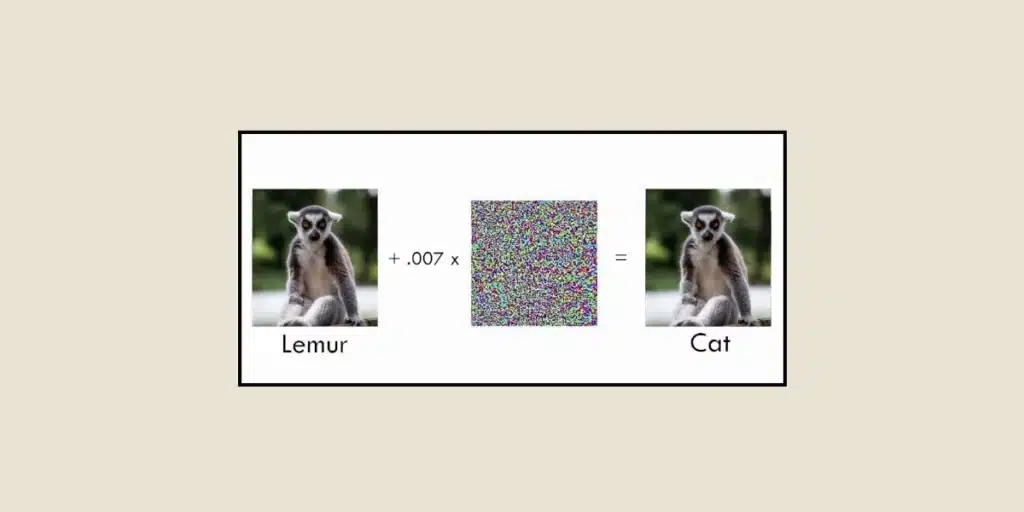

Uno de los desafíos en el desarrollo de modelos robustos reside en la generación de ejemplos adversarios efectivos. Estos ejemplos deben ser cuidadosamente diseñados para explotar las vulnerabilidades del modelo a la vez que pasan desapercibidos a los ojos de observadores humanos. Los investigadores han desarrollado diversos métodos para generar ejemplos adversarios, tales como el método del signo del gradiente rápido (Fast Gradient Sign Method, FGSM) y sus variantes. Estas técnicas aprovechan los gradientes del modelo en relación con la entrada para perturbar iterativamente la entrada de una manera que maximice el error de predicción del modelo.

Algunos ejemplos:

La adversarial robustness es particularmente crucial en tareas que involucran imágenes. Los modelos de clasificación de imágenes, por ejemplo, son ampliamente utilizados en varios campos, como los vehículos autónomos, diagnósticos médicos y sistemas de seguridad. Sin embargo, incluso los modelos de clasificación de imágenes más avanzados pueden ser engañados por perturbaciones imperceptibles añadidas a la imagen de entrada, lo que resulta en errores de clasificación. Las técnicas de adversarial robustnessbuscan resolver este problema entrenando modelos que resistan tales ataques adversariales basados en imágenes.

La adversarial robustness también puede aplicarse a los chatbots, como medida para prevenir la repetición del escenario bien conocido del chatbot Tay, que había sido desarrollado por Microsoft y desplegado en Twitter para interactuar con usuarios y aprender a conversar. Individuos malintencionados explotaron el sistema alimentando a Tay con insultos y comentarios ofensivos, lo cual llevó a comportamientos inapropiados por parte del chatbot. Solo dieciséis horas después de su lanzamiento, Microsoft tuvo que desactivar el chatbot, que había desarrollado tendencias racistas y homofóbicas.

Hoy en día, la investigación ha llevado al desarrollo de mecanismos de defensa avanzados, que incluyen el entrenamiento con diversas perturbaciones. Estas técnicas mejoran la capacidad del modelo para resistir los ataques adversariales incorporando capas de defensa adicionales y explotando las propiedades estadísticas de los datos. La adversarial robustness es un campo que evoluciona rápidamente, ya que los investigadores se esfuerzan constantemente en mejorar la eficacia de las defensas contra los ataques adversariales. Los avances recientes incluyen enfoques que combinan el entrenamiento adversarial con otras técnicas de regularización, métodos de ensemble que aprovechan la diversidad de múltiples modelos y técnicas que integran modelos generativos para aprender con mayor precisión la distribución subyacente de los datos.

Conclusión

Aunque los modelos de deep learning han logrado un éxito notable en varios campos, su vulnerabilidad a los ataques adversariales sigue siendo una preocupación principal. La adversarial robustness, gracias a técnicas como el entrenamiento adversarial, busca mejorar la resiliencia de los modelos de machine learning contra los ataques adversariales. Al exponer los modelos a ejemplos adversarios cuidadosamente elaborados durante su formación, los investigadores desarrollan estrategias para fortalecer estos modelos y asegurar su fiabilidad en escenarios del mundo real. Este campo continúa evolucionando y promete crear modelos de machine learning más robustos y seguros, permitiendo así la adopción generalizada de la inteligencia artificial en aplicaciones críticas.

¿Quieres saber más sobre los desafíos de la inteligencia artificial? ¿Te interesa dominar las técnicas de Deep Learning mencionadas en este artículo? Infórmate sobre nuestra formación de Data Scientist (Formación Data Scientist | DataScientest x MINES Paris – PSL).