In einem früheren Artikel haben wir die Grenzen der künstlichen Intelligenz diskutiert und die Hollywood-Vision eines Roboters, der den Menschen überholt und ihm sein Verhalten vorschreibt, relativiert.

Mit der weit verbreiteten Nutzung von Vorhersagemodellen in kritischen Bereichen wie der medizinischen Diagnostik stellt sich jedoch die Frage, wie viel Vertrauen ein Nutzer in eine KI setzen kann. Wie kann man sicherstellen, dass solche Algorithmen nicht zu viele Fehler verursachen, wenn künstliche Intelligenz unsere Entscheidungen in immer mehr Bereichen lenken kann?

Was, wenn die Lösung im Problem liegt? Wenn es eine KI gäbe, die in der Lage wäre, die algorithmischen Vorhersagen zu rechtfertigen und somit den Vorhersagemodellen eine gewisse Legitimität und Zuverlässigkeit zu verleihen?

Sollte man KIs misstrauen?

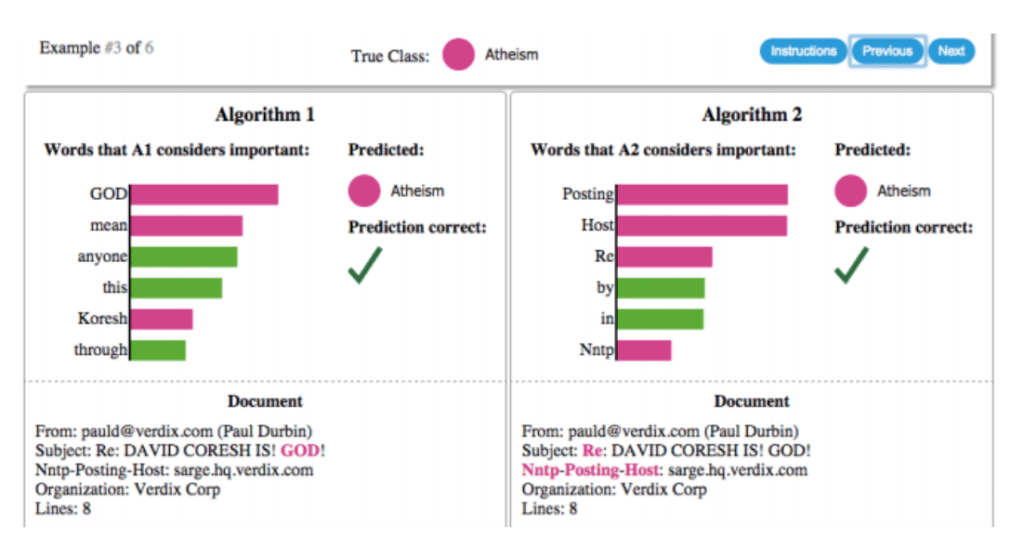

Dieses Beispiel zeigt die Erklärungen der Vorhersagen von zwei verschiedenen Klassifikatoren, die versuchen zu bestimmen, ob ein Dokument – der Input – über „Christentum“ oder „Atheismus“ handelt.

In diesen Erklärungen sind zwei wichtige Elemente hervorzuheben:

- Das Balkendiagramm stellt die Reihenfolge der Wichtigkeit der Wörter dar, die zu einer Vorhersage führen.

- Die Farbe zeigt an, zu welcher Klasse das Wort beiträgt: grün für „Christentum“ und magenta für „Atheismus“.

Dieses Experiment zeigt, dass in diesem Fall die Vorhersagen aus ziemlich willkürlichen Gründen gemacht werden: Für Algorithmus 2 haben die Wörter „Post“, „Host“ und „Re“, anders als im Balkendiagramm dargestellt, keine Verbindung zum Atheismus (und übrigens auch nicht zum Christentum), während für Algorithmus 1 die Begriffe „GOD“ oder „Koresh“ nicht zum Atheismus, sondern eher zum Christentum führen sollten.

Wie dieses Beispiel zeigt, wäre es daher ein Fehler, einer KI blind zu vertrauen, den man nicht begehen sollte. Wie können wir wissen, ob eine KI eine Entscheidung aus einem vernünftigen Grund trifft?

Wir stellen dir jetzt LIME vor, eine Python-Bibliothek, mit der du jedes komplexe und daher schwer zu interpretierende Modell in ein einfaches lineares Modell umwandeln kannst, dessen offensichtlicher Vorteil darin besteht, dass es nun einfacher ist, die Vorhersage zu erklären.

Der LIME-Ansatz: Eine effektive Lösung?

LIME (Locally Interpretable Model-agnostic Explanation) ist eine KI, die es ermöglicht, die Logik hinter algorithmischen Vorhersagen zu verstehen, um den Menschen bei seiner Entscheidung zu unterstützen, ob er diesen Vorhersagen Glauben schenken soll oder nicht.

Während einige Modelle aufgrund ihrer Einfachheit (lineare Regression, Entscheidungsbäume) ihre Vorhersagen erklären können, haben andere Machine-Learning-Algorithmen, wie z. B. solche, die auf der Architektur neuronaler Netze basieren, in der Regel eine zu komplexe Vorhersagefunktion und bleiben daher für den Menschen unverständlich. Man spricht von schwer interpretierbaren Modellen.

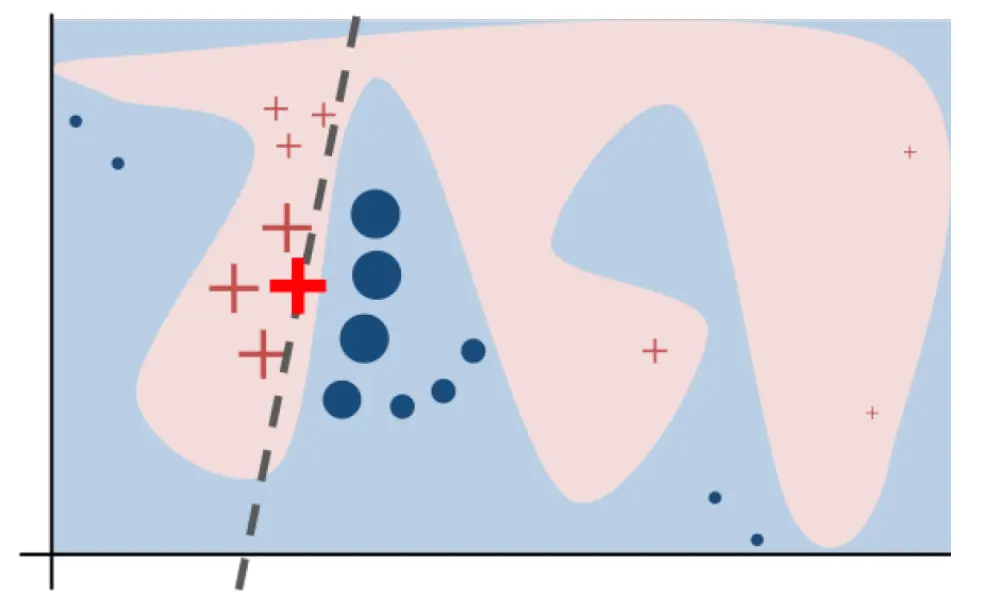

Das Ziel von LIME ist es, die Vorhersagen in ein interpretierbares lineares mathematisches Modell umzuwandeln. Anders ausgedrückt: Das Ziel von LIME ist es, die beste vereinfachte Version eines komplexen Modells um eine einzelne untersuchte Beobachtung herum zu finden. Die folgende Abbildung zeigt die neue lineare Klassifikation, die durch die Verwendung von LIME erstellt wurde:

Anfänglich macht das Modell eine komplexe binäre Vorhersage (rosa oder blauer Bereich) :

- Das fettgedruckte rote Kreuz entspricht der Vorhersage.

- Die Achsen sind die erklärenden Variablen (Features).

- Die blauen Kreise und roten Kreuze sind die Vorhersagen, die nach Störungen der Features erhalten wurden.

- Für jeden Punkt, der rechts von der ursprünglichen Vorhersage liegt, wurde das Feature, das der x-Achse entspricht, geändert und das Feature, das der y-Achse entspricht, unverändert gelassen.

- Je näher ein Punkt an der ursprünglichen Vorhersage liegt (fettes rotes Kreuz), desto größer ist er.

Die obige Grafik verdeutlicht die Funktion von LIME, uns zu einem einfachen linearen Modell zurückzuführen, dessen Grenze durch die gestrichelte Gerade dargestellt wird: Im Gegensatz zum ursprünglichen komplexen binären Modell (rosa oder blaues Gebiet) sind die „neuen“ roten und blauen Gebiete nun die links bzw. rechts von der gestrichelten Linie liegenden.

Darüber hinaus zeigt die von LIME ermittelte gestrichelt dargestellte Gerade auch, dass die Variable auf der Abszissenachse wichtiger ist als die auf der Ordinatenachse:

- Eine Verschiebung auf der Ordinatenachse hat wenig Einfluss auf die Vorhersage (der Punkt bleibt im roten Bereich).

- Eine Verschiebung auf der Abszissenachse verändert die Vorhersage (der Punkt wechselt von der roten in die blaue Region).

Beispiel für die praktische Anwendung von LIME :

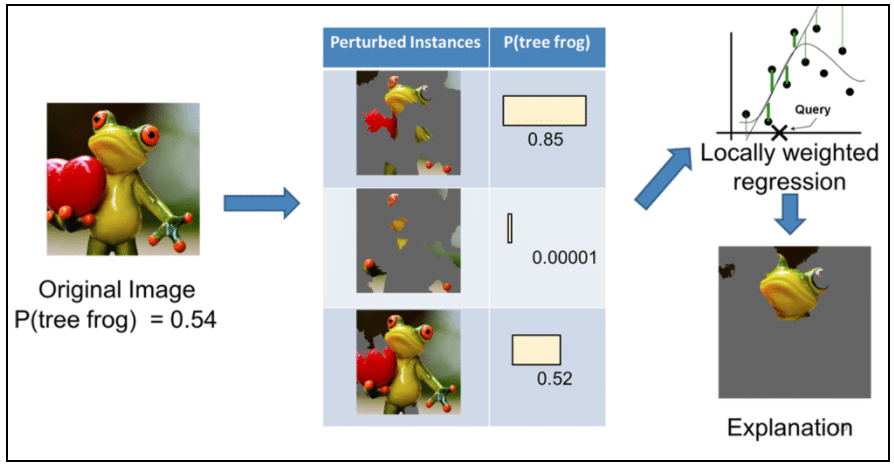

In diesem Beispiel begründet LIME durch die Umwandlung eines beliebigen komplexen Modells in ein interpretierbares lineares Modell die Vorhersage eines Bilderkennungsalgorithmus, indem es genau feststellt, welcher Teil des eingegebenen Bildes die Anwesenheit eines Frosches erkannt hat.

Anhand dieses Beispiels wird deutlich, dass LIME mit dem Ziel entwickelt wurde, dass Nutzer den Vorhersagen von KIs vertrauen können. Man kann also davon ausgehen, dass KIs in naher Zukunft stärker unter dem Zwang stehen werden, den Nutzern gegenüber völlig transparent zu sein, vor allem seit der Einführung der GDPR (General Data Protection Regulation) im Mai 2018. Es wird dann notwendig sein, neue und immer leistungsfähigere Algorithmen zu entwickeln, die es ermöglichen, Entscheidungen und Vorhersagen in komplexen und daher schwer interpretierbaren Modellen zu rechtfertigen.

Hat dir dieser Artikel gefallen? Möchtest du dein Wissen über KI erweitern?