Unausgewogene Daten sind beim Machine Learning sehr häufig anzutreffen. Leider machen sie die vorausschauende Analyse komplexer. Um diese Datensätze auszugleichen, wurden verschiedene Methoden . Dazu gehört auch das Resampling.

Wie geht man mit unausgewogenen Daten durch Resampling um?

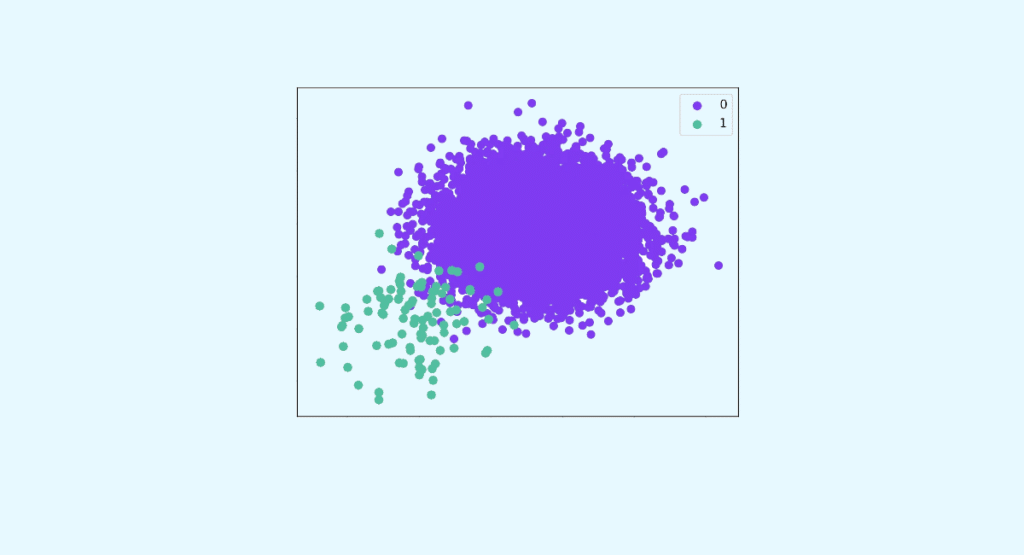

Unausgewogene Daten zeichnen sich durch Stichproben aus, bei denen eine starke Ungleichheit festzustellen ist. So liegt das Verhältnis zwischen den Klassen nicht bei 50/50, sondern eher bei 90/10. Ab diesem Zeitpunkt werden die Daten für Machine Learning und Deep Learning problematisch.

Dies bezieht sich oft auf relativ seltene Ereignisse, wie z. B. Versicherungsbetrug oder die Entdeckung einer Krankheit. Zum Beispiel kann es sein, dass in einer Bevölkerung die große Mehrheit gesund ist und nur 0,1 % an Multipler Sklerose leiden. Die gesunden Menschen sind dann die Mehrheitsklasse und die kranken Menschen gelten als Minderheitsklasse. Obwohl diese Ereignisse recht häufig vorkommen, machen sie nur einen sehr kleinen Teil der untersuchten Stichprobe aus. Daher ist es schwierig, sie vorherzusagen.

Im Machine Learning sind unausgewogene Daten sehr häufig, insbesondere bei der binären Klassifizierung. Aus diesem Grund werden verschiedene Methoden entwickelt, um Probleme mit unausgewogener Klassifizierung besser in den Griff zu bekommen. Dazu gehört auch das Resampling von Daten.

Was sind die beiden Methoden des Resampling?

Beim Resampling wird der Datensatz verändert, bevor das Vorhersagemodell trainiert wird. Dadurch werden die Daten ausgeglichen, um die Vorhersage zu erleichtern.

Zu diesem Zweck gibt es zwei Methoden des Resampling.

Oversampling

Oversampling bedeutet, dass die Anzahl der Daten, die der Minderheitsklasse angehören, erhöht wird, bis ein gewisses Gleichgewicht erreicht ist. Oder zumindest eine Quote, die für zuverlässige Vorhersagen ausreicht.

Data Scientists können zwei Methoden des Upsampling anwenden. Nämlich:

- Zufälliges Oversampling: Hier werden die Minderheitsdaten mehrmals zufällig geklont. Diese Technik ist vor allem bei linearen Modellen, wie der logistischen Regression, nützlich.

- Synthetisches Oversampling: Auch hier geht es darum, Daten aus Minderheitsklassen hinzuzufügen. Anstatt sie jedoch eins zu eins zu kopieren, erstellt der Algorithmus separate, aber ähnliche Daten.

Undersampling

Hauptsächlich wird zufälliges Undersampling verwendet. Das heißt, dass die Mehrheitsdaten nach dem Zufallsprinzip entfernt werden. Diese Resampling-Technik sollte bevorzugt werden, wenn du über große Datensätze verfügst (mindestens mehrere zehntausend Fälle).

Während dies die gängigste Methode ist, kannst du auch das Undersampling von Grenzbeobachtungen oder das Clustering-based Undersampling verwenden. Das heißt, bestimmte Mehrheitsdaten gezielt zu entfernen.

In beiden Fällen ist es nicht notwendig, ein perfektes 50/50-Gleichgewicht zu erreichen. Es ist durchaus möglich, Mehrheitsdaten zu entfernen oder Minderheitsdaten hinzuzufügen, um ein Verhältnis von 45/55 oder 40/60 zu erreichen.

Du kannst auch verschiedene Klassenverhältnisse ausprobieren, um das Verhältnis mit der besten Vorhersageleistung auszuwählen.

Wenn du mehr über das Resampling von unausgewogenen Daten erfahren möchtest, solltest du dir unsere Kurse in Data Science ansehen.