Die Menge an Daten, die von Unternehmen generiert und genutzt wird, wächst exponentiell. In diesem Zusammenhang ist die effiziente Strukturierung und Organisation dieser Daten für eine optimale Analyse von größter Bedeutung.

Die dimensionale Modellierung stellt sich als eine unumgängliche Lösung für diese Herausforderung dar.

Es handelt sich dabei um einen methodischen Ansatz für die Gestaltung von Data Warehouses. Ralph Kimball, ein Pionier und Experte auf dem Gebiet der Entscheidungsfindung, hat Standards und Prinzipien aufgestellt, die heute viele Organisationen bei der Gestaltung und dem Betrieb ihrer Informationssysteme leiten.

Kimballs Grundprinzipien

Die Kimball Methode basiert auf einer Reihe von Schlüsselprinzipien, die festlegen, wie Daten strukturiert und organisiert werden müssen, um ihre Analyse und Nutzung zu erleichtern. Diese Prinzipien bilden die Grundlage für die dimensionale Modellierung und bieten einen klaren und systematischen Rahmen :

1. Tabellen und Dimensionen

- Definition

Dimensionstabellen enthalten die beschreibenden Attribute der Daten. Sie liefern den notwendigen Kontext, um die in den Faktentabellen enthaltenen quantitativen Messungen zu verstehen und zu interpretieren.

Hauptmerkmale : Text und beschreibende Attribute

- Häufig denormalisiert, um die Abfrageleistung und die Einfachheit zu optimieren.

- Können Hierarchien enthalten, um Analysen auf verschiedenen Granularitätsebenen zu erleichtern.

2. Faktentabellen

- Definition : Faktentabellen speichern quantitative oder metrische Messungen, die normalerweise das Ergebnis einer Transaktion oder eines Ereignisses sind.

- Hauptmerkmale:

- Enhalten Messgrößen wie Umsatz, Menge, Kosten usw.

- Über Fremdschlüssel mit Dimensionstabellen verknüpft.

- Können zusammengesetzte Schlüssel enthalten, um einen Datensatz eindeutig zu identifizieren.

3. Granularität

- Definition: Die Granularität bezieht sich auf den Grad der Detaillierung oder Zusammenfassung der in der Faktentabelle gespeicherten Daten.

- Bedeutung : Die Bestimmung der Granularität ist entscheidend, da sie die Art und Weise beeinflusst, wie Daten gesammelt, gespeichert und analysiert werden.

Sie sollte auf der Grundlage der Geschäftsanforderungen und der Fragen, auf die das Data Warehouse die Antworten haben soll, festgelegt werden.

4. Normalisierung vs. Denormalisierung

- Normalisierung: Ein Prozess zur Strukturierung von Daten, um Redundanzen zu reduzieren und die Integrität zu verbessern. Sie wird häufig in transaktionsbasierten Datenbankverwaltungssystemen verwendet.

- Denormalisierung: Ein Prozess der Datenstrukturierung zur Verbesserung der Abfrageleistung, oft auf Kosten der Redundanz. Sie wird bei der dimensionalen Modellierung bevorzugt, um die Datenanalyse zu erleichtern.

Die Kimball Methode mit ihren Prinzipien der Dimensions- und Faktentabellen bietet eine solide Struktur für die Gestaltung von Data Warehouses. Wenn Organisationen diese grundlegenden Prinzipien verstehen und anwenden, können sie robuste, flexible und für die Analyse optimierte Informationssysteme schaffen.

Vorteile der Kimball Methode

Die dimensionale Modellierung nach Kimball hat sich nicht einfach zufällig im Bereich der Data Warehouses durchgesetzt. Ihre einzigartigen Vorteile machen sie zu einem bevorzugten Ansatz für viele Organisationen.

|

Optimale Leistung für Abfragen | Auch bei großen Datenvolumen ermöglicht diese Methode schnelle Abfragen. Dadurch profitieren Endanwender von einer besseren Erfahrung mit kürzeren Wartezeiten bei der Erstellung von Berichten oder Dashboards. |

|---|---|---|

|

Flexibilität | Das dimensionale Modellieren ermöglicht das Hinzufügen neuer Dimensionen oder Fakten ohne die bestehende Struktur zu stören. Das erleichtert Updates und Weiterentwicklungen des Data Warehouses, wenn sich die geschäftlichen Anforderungen ändern. |

|

Leichte Verständlichkeit | Die klare Trennung zwischen Dimensionen (Kontext) und Fakten (Messwerte) macht das Data Warehouse intuitiv und einfach zu verstehen, auch für Laien. |

|

Skalierbarkeit | Die dimensionale Struktur ist darauf ausgelegt, ein Wachstum des Datenvolumens zu bewältigen ohne Leistungseinbußen. |

|

Konsistenz und Datenintegrität | Das dimensionale Modellieren fördert mit seiner klaren Struktur eine bessere Datenqualität und -konsistenz. Inkonsistenzen oder Anomalien lassen sich leichter erkennen. |

|

Kostensenkung | Obwohl die anfängliche Einrichtung Investitionen erfordern kann, können die einfache Wartung, die Skalierbarkeit und die Flexibilität der Kimball-Methode langfristige Einsparungen ermöglichen. |

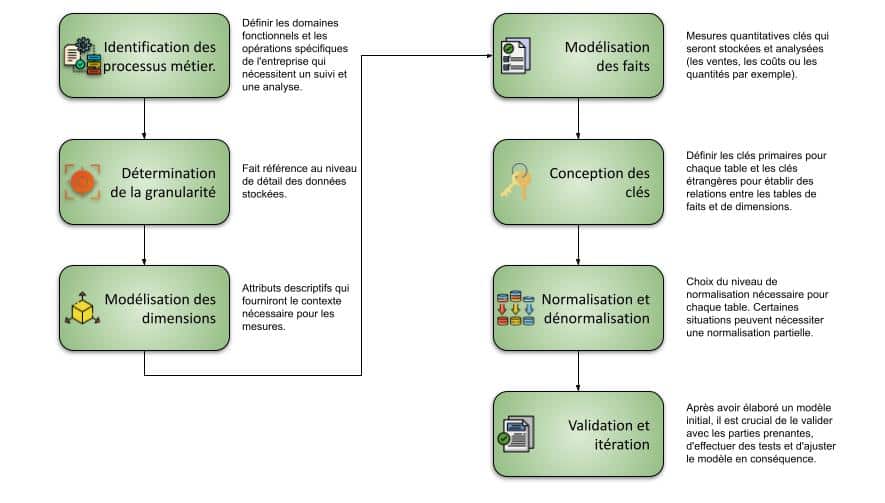

Designprozess nach der Kimball Methode

Die erfolgreiche Implementierung eines Data Warehouse hängt zu einem großen Teil von einem rigorosen und methodischen Design ab. Die Kimball-Methode bietet einen strukturierten Prozess, der die Designer durch die wichtigsten Schritte dieser komplexen Aufgabe führt.

Kimball versus Inmon

Die Welt der Data Warehouses wird von zwei herausragenden Persönlichkeiten beherrscht: Ralph Kimball und William Inmon. Diese beiden Experten haben jeweils eigene Ansätze zur Modellierung und zum Design von Data Warehouses vorgelegt.

| Prinzip | Kimball | Inmon | |

|---|---|---|---|

|

Philosophische Grundlagen | Sein Ansatz ist geschäftsprozessorientiert. Er zielt darauf ab, das Data Warehouse schrittweise aufzubauen, beginnend mit den Bereichen, die den größten Wert für das Unternehmen bringen. | Seine Vision ist die eines zentralisierten, ganzheitlichen Unternehmensdatenlagers. Er befürwortet den Aufbau eines großen, normalisierten Datenlagers, gefolgt von der Erstellung spezialisierter Datenspeicher für spezifische Anforderungen. |

|

Architektur | Bevorzugt einen Bottom-Up-Ansatz, beginnt üblicherweise mit der Erstellung spezifischer Datenspeicher, die dann in ein umfassenderes Datenlager integriert werden können. | Bevorzugt einen Top-Down-Ansatz, erstellt zuerst ein umfangreiches unternehmensweites Datenlager und leitet dann spezifische Datenspeicher für bestimmte Anwendungen ab. |

|

Modellierung | Dimensionale Modellierung: Daten sind in Fakten- und Dimensionstabellen organisiert, wie in diesem Artikel besprochen. | Modellierung in 3NF (Dritte Normalform): Für das zentrale Datenlager, um maximale Integrität und Konsistenz zu gewährleisten. |

|

Datenladeprozess | Der ETL-Prozess ist in der Regel direkt und speist Daten aus den Quellsystemen direkt in die Datenspeicher oder das Datenlager. | Die Daten werden zuerst in das zentrale Datenlager geladen, dann wird ein ELT-Prozess verwendet, um die abgeleiteten Datenspeicher zu speisen. |

|

Flexibilität und Konsistenz | Kimballs Methode bietet eine schnellere Implementierung und größere Flexibilität, um sich ändernden Bedürfnissen gerecht zu werden (kann mehr Aufwand erfordern, um Konsistenz zwischen verschiedenen Datenspeichern zu gewährleisten). | Inmons ganzheitlicher Ansatz sichert maximale Datenkonsistenz im ganzen Unternehmen (die anfängliche Implementierung kann länger und teurer sein). |

Kimball und Inmon bieten zwei verschiedene Perspektiven auf das Design und die Implementierung von Data Warehouses. Die Wahl zwischen diesen Ansätzen hängt von den spezifischen Bedürfnissen, den verfügbaren Ressourcen und den strategischen Zielen des Unternehmens ab. Es ist entscheidend, die Nuancen jeder Methode zu verstehen, um eine fundierte Entscheidung darüber zu treffen, welcher Ansatz für eine bestimmte Situation am besten geeignet ist.

Fazit

Die Kimball Methode mit ihren soliden Prinzipien der dimensionalen Modellierung bietet einen wertvollen Rahmen für Organisationen, die die Effizienz, Leistung und Flexibilität ihrer Informationssysteme optimieren wollen.

Wie jede Methodik ist sie jedoch keine Universallösung. Unternehmen müssen ihre spezifischen Bedürfnisse, Ressourcen und langfristigen Ziele sorgfältig abwägen, um den für ihren Kontext am besten geeigneten Ansatz zu wählen.