Der Chi-Quadrat-Test ist ein statistischer Test für Variablen, die eine endliche Anzahl von möglichen Werten annehmen (also kategoriale Variablen). Zur Erinnerung: Ein statistischer Test ist eine Methode, um eine Hypothese, die sogenannte Nullhypothese, anzunehmen oder abzulehnen, je nachdem, wie gut sie zu den Daten passt.

Wozu dient der Chi-Quadrat-Test?

Der Vorteil des Chi-Quadrat-Tests ist seine große Bandbreite an Anwendungsmöglichkeiten:

- Test auf Übereinstimmung mit einer a priori definierten Gesetzmäßigkeit oder einer Familie von Gesetzmäßigkeiten, z.B. Folgt die Größe einer Population einer Normalverteilung? :

- Test auf Unabhängigkeit, Beispiel: Ist die Haarfarbe unabhängig vom Geschlecht?

- Test auf Homogenität: Sind zwei Datensätze gleich verteilt?

Wie funktioniert der Test?

Das Prinzip ist, die Nähe oder Ferne zwischen der Gesetzmäßigkeit der Stichprobe und einer theoretischen Gesetzmäßigkeit mit der sogenannten Pearson-Statistik \chi_{Pearson}} zu vergleichen. [\latex], die auf dem Chi-Quadrat-Abstand basiert.

Erstes Problem: Da wir nur über eine begrenzte Anzahl von Daten verfügen, können wir das Gesetz der Stichprobe nicht perfekt kennen, sondern nur eine Annäherung an dieses Gesetz, das empirische Maß.

Das empirische Maß \widehat{\mathbb{P}}_{n,X} [\latex] stellt die Häufigkeit der verschiedenen beobachteten Werte dar:

Formel Empirische Messung

mit

Wir definieren die Pearson-Statistik als :

Statistische Formel nach Pearson

Unter der Nullhypothese, d. h. dass die Stichprobenverteilung mit der theoretischen Verteilung übereinstimmt, wird die Pearson-Statistik gegen die Chi-Quadrat-Verteilung mit d Freiheitsgraden konvergieren. Die Anzahl d der Freiheitsgrade hängt von der Größe des Problems ab und ist im Allgemeinen die Anzahl der möglichen Werte -1.

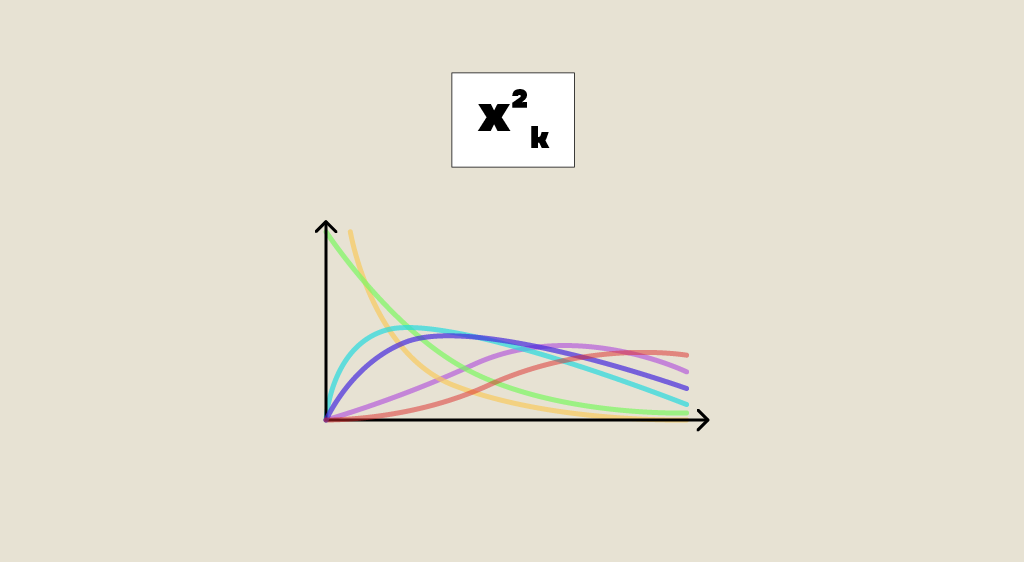

Zur Erinnerung: Die Chi-Quadrat-Verteilung mit d Freiheitsgraden

zentriert reduziert unabhängig.

ist die einer Summe der Quadrate von d Gaußschen

Andernfalls wird diese Statistik ins Unendliche divergieren, was die Entfernung zwischen empirischen und theoretischen Verteilungen widerspiegelt.

Grenzformel

Was sind seine Vorteile?

Wir haben also eine einfache Entscheidungsregel: Wenn die Pearson-Statistik einen bestimmten Schwellenwert überschreitet, lehnen wir die Ausgangshypothese (die theoretische Verteilung passt nicht zu den Daten) ab, ansonsten akzeptieren wir sie. Der Vorteil des Chi-Quadrat-Tests ist, dass dieser Schwellenwert nur von der Chi-Quadrat-Verteilung und dem Alpha-Konfidenzniveau abhängt, also unabhängig von der Verteilung der Stichprobe ist.

Eine Anwendung, der Unabhängigkeitstest :

Nehmen wir ein Beispiel, um diesen Test zu veranschaulichen: Wir wollen wissen, ob die Geschlechter der ersten beiden Kinder X und Y eines Paares unabhängig sind?

Wir haben die Daten in einer Kontingenztabelle zusammengefasst:

Die Pearson-Statistik bestimmt, ob das empirische Maß der gemeinsamen Gesetzmäßigkeit (X,Y) gleich dem Produkt der marginalen empirischen Maße ist, was die Unabhängigkeit charakterisiert:

Hier Observation(x,y) ist die Häufigkeit des Wertes (x,y) :

Zum Beispiel:

Für Theory(x,y) wird angenommen, dass X und Y unabhängig sind, so dass die theoretische Gesetzmäßigkeit das Produkt der Randgesetze sein sollte:

Die theoretische Wahrscheinlichkeit für (Sohn,Sohn) ist also:

Berechnen wir die Teststatistik mithilfe des folgenden Python-Codes:

In unserem Fall haben die Variablen X und Y nur zwei mögliche Werte: Mädchen oder Jungen. Die Dimension des Problems ist also (2-1)(2-1) oder 1.

Wir vergleichen daher die Teststatistik mit dem Chi-Quantil bei 1 Freiheitsgrad über die Funktion chi2.ppf in scipy.stats. Sie ist kleiner als das Quantil und der p-Wert ist größer als das Konfidenzniveau = 0,05. Wir können die Nullhypothese mit 95%igem Vertrauen nicht ablehnen und schließen daher auf die Unabhängigkeit des Geschlechts der ersten beiden Kinder.

Wo liegen seine Grenzen?

Der Chi-Quadrat-Test scheint sehr praktisch zu sein, hat aber auch seine Grenzen: Er stellt nur fest, dass es Korrelationen gibt, aber er erkennt weder die Stärke dieser Korrelationen noch Kausalitäten.

Er beruht auf der Annäherung des Chi-Quadrat-Gesetzes durch die Pearson-Statistik, die nur dann überprüft werden kann, wenn eine ausreichende Anzahl von Daten vorliegt. In der Praxis sieht diese Gültigkeitsbedingung wie folgt aus:

Der exakte Test nach Fisher kann diesen Mangel beheben, erfordert aber eine hohe Rechenleistung (in der Praxis wird er auf 2*2-Kontingenztabellen beschränkt).

Statistische Tests sind in der Data Science unerlässlich, um die Relevanz der erklärenden Variablen zu überprüfen und die Hypothesen der Modellierung zu validieren. Weitere Informationen über Chi-2 und andere statistische Tests findest du in unserem Modul 104 – Explorative Statistik.