Elasticsearch ist eine offene verteilte Suchmaschine und ein Analytics-Engine, das auf Apache Lucene basiert und in Java entwickelt wurde. Das Projekt startete als skalierbare Version des Open-Source-Forschungsframeworks Lucene. Die Möglichkeit, Lucene-Indizes horizontal zu erweitern, wurde später hinzugefügt.

Dieses Tool ermöglicht das schnelle Speichern, Suchen und Analysieren großer Datenmengen nahezu in Echtzeit. Suchantworten werden innerhalb von Millisekunden übermittelt.

Diese Geschwindigkeit hängt damit zusammen, dass Elasticsearch die Indizes und nicht direkt den Text durchsucht. Seine Struktur basiert eher auf Dokumenten als auf Tabellen und Diagrammen. REST-APIs werden zum Speichern und Untersuchen von Daten verwendet. Zusammenfassend ist Elasticsearch ein Server, der JSON-Anfragen verarbeiten und JSON-Daten zurückgeben kann.

Wie funktioniert Elasticsearch?

Die Funktionsweise von Elasticsearch basiert auf mehreren grundlegenden Konzepten. Hier sind seine Hauptkomponenten.

Dokumente sind die grundlegende Informationseinheit, die in Elasticsearch indexiert werden kann. Es wird im JSON-Format ausgedrückt, dem globalen Datenaustauschformat.

Ein Dokument kann mit einer Zeile in einer relationalen Datenbank verglichen werden, die eine bestimmte Entität darstellt. Dieses Dokument ist jedoch nicht auf Text beschränkt und kann jede Art von JSON-codierten strukturierten Daten sein. Das können Zahlen, Codezeilen, Daten sein … Jedes Dokument hat eine eindeutige Kennung und einen Datentyp, der die Kategorie der darin enthaltenen Entität beschreibt.

Ein Index ist eine Sammlung von Dokumenten mit ähnlichen Eigenschaften. Dies ist die höchste Entitätsebene, die in Elasticsearch abgefragt werden kann.

Du kannst den Index mit einer Datenbank vergleichen. Alle in einem Index gruppierten Dokumente sind nach Kategorien verknüpft. Der Index wird durch einen Namen identifiziert, um während Such- oder Analysevorgängen auf ihn Bezug zu nehmen.

Eigentlich ist ein Elasticsearch-Index ein invertierter Index. Dieser Mechanismus ist die Quelle des Betriebs aller Suchmaschinen und ordnet eine Zuordnung des Inhalts zu seinem Ort in einem Dokument oder einem Satz von Dokumenten zu. Mit dieser Hashmap-ähnlichen Datenstruktur kannst Du mit einem Wort auf ein Dokument gerichtet werden.

Ein Elasticsearch-Cluster ist eine Gruppe von miteinander verbundenen Instanzen. Es erlaubt, die Aufgaben, die Recherche oder die Indizierung zwischen den Knoten zu verteilen.

Ein Knoten ist ein einzelner Server, der Daten speichert und zu den Such- und Indizierungsfunktionen des Clusters beiträgt. Ein Knoten kann auf verschiedene Arten konfiguriert werden.

Der Master-Knoten steuert den Elasticsearch-Cluster und übernimmt die Verantwortung für clusterweite Vorgänge wie das Erstellen oder Löschen eines Index und das Hinzufügen oder Löschen von Knoten.

Ein Datenknoten speichert Daten und führt datenbezogene Operationen wie Suche und Aggregation durch, während ein Client-Knoten Cluster-Abfragen an den Master-Knoten und datenbezogene Abfragen an Datenknoten weiterleitet.

Indizes können in Shards (dt. Scherbe) unterteilt werden. Jedes Shard ist ein unabhängiger, voll funktionsfähiger Index, der auf jedem Knoten innerhalb eines Clusters gehostet werden kann.

Durch die Verteilung von Dokumenten in einem Index auf mehrere Shards und die Verteilung dieser Shards auf mehrere Nodes bietet Elasticsearch Redundanz, die vor Hardwareausfällen schützt und gleichzeitig die Abfragekapazität erhöht, wenn Nodes zum Cluster hinzugefügt werden.

Schließlich können diese Shards kopiert werden, um „Repliken“ zu erzeugen. Auch hier besteht das Ziel darin, die Daten vor Hardwareausfällen zu schützen sowie die Fähigkeit zu verbessern, auf Leseanforderungen zu reagieren.

Was ist Elastic Slack?

Elastic Slack ist ein umfassendes Ökosystem von Open-Source-Tools zum Erfassen, Anreichern, Speichern, Analysieren und Visualisieren von Daten. Neben Elasticsearch sind die anderen Softwares Logstash, Kibana und Beats.

Das Datenmanagement- und Visualisierungstool von Kibana liefert Histogramme, Grafiken oder Landkarten in Echtzeit. Damit kannst Du Elasticsearch-Daten in Echtzeit visualisieren und dank einer sehr intuitiven Benutzeroberfläche Visualisierungen auswählen.

Mit Logstash kannst Du die an Elasticsearch gesendeten Daten aggregieren und verarbeiten. Diese offene Data Pipeline kann Daten aus mehreren Quellen aufnehmen, transformieren und übertragen. Daten können unabhängig von ihrem Format transformiert werden.

Schließlich bringt Beats mehrere „Data Shipping“-Agenten zusammen, um Daten von Tausenden von Maschinen und Systemen an Logstash oder Elasticsearch zu senden. Dieses Tool ist sehr nützlich für die Zusammenstellung von Daten.

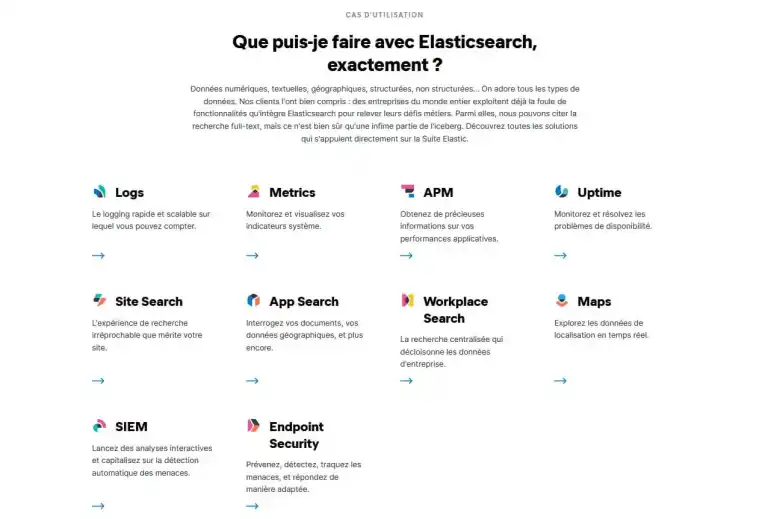

Wofür wird Elasticsearch verwendet?

Elasticsearch wird für eine Vielzahl von Anwendungsfällen verwendet. Dieses Tool wird insbesondere für Anwendungen verwendet, die auf einer Suchplattform für den Datenzugriff basieren.

Ebenso benutzen es Websites, die eine große Menge an Inhalten speichern. Das Gleiche gilt für Unternehmen, die es für die interne Forschung verwenden.

Ein weiterer Anwendungsfall für Elasticsearch ist die Erfassung und Analyse von Protokolldaten in Echtzeit oder die Überwachung von Containern. Darüber hinaus wird dieses Tool häufig für Cybersicherheitsanalysen verwendet. Schließlich bietet Elastic Stack verschiedene Funktionalitäten und ist also eine ausgezeichnete Wahl für die Geschäftsanalyse.

Wer verwendet Elasticsearch?

Viele Unternehmen nutzen Elasticsearch, darunter einige der bekanntesten. Hier sind einige Beispiele.

Netflix verwendet Elastic Stack für viele Anwendungsfälle zur Überwachung und Analyse von Kundendienstvorgängen und Sicherheitsprotokollen. Das Nachrichtensystem des Unternehmens basiert auf Elasticsearch. Hatte das Unternehmen anfangs nur wenige isolierte Deployments genutzt, betreibt es heute einen von Dutzenden von Clustern, die aus mehreren hundert Nodes bestehen.

Der E-Commerce-Riese Ebay hat eine „Elasticsearch-as-a-Service“-Plattform geschaffen, um Cluster auf einer internen, auf OpenStack basierenden Cloud-Plattform einfach bereitzustellen. Dies entspricht den Bedürfnissen des Unternehmens für Textanalyse und Recherche.

Ein anderes Beispiel: der amerikanische Hypermarktriese Walmart. Dank Elastic Stack ist das Unternehmen in der Lage, den verborgenen Wert seiner Daten aufzudecken, um Hinweise auf das Kaufverhalten seiner Kundschaft, die Leistung seiner Geschäfte oder die Auswirkungen saisonaler Ereignisse zu nutzen. Alles in Echtzeit. Die Sicherheitsfunktionen des ELK-Stacks helfen ihm auch dabei, Anomalien zu erkennen.

Wie kann ich ElasticSearch lernen?

ElasticSearch-Kenntnisse sind sehr gefragt. Um dieses Tool zu beherrschen, kannst Du DataScientest kontaktieren.

Während unserer Data Engineer Ausbildung lernst Du, wie Du Elasticsearch über das Modul Datenbank verwenden kannst. Du wirst auch SQL, MongoDB und Neo4J entdecken.

Weitere Module in diesem Programm umfassen Python-Programmierung, Data Science, Big Data, CI/CD und Automatisierung. Am Ende des Kurses verfügst Du über alle erforderlichen Fähigkeiten, um ein Data Engineer zu werden.

Du bist in der Lage, die Anforderungen an Datenarchitektur eines Unternehmens zu identifizieren, Erfassungs- und automatische Verarbeitungspipelines zu erstellen, Modelle für maschinelles Lernen auf Produktionsservern bereitzustellen und anzupassen und eine globale Datenstrategie für das Unternehmen zu definieren.

Diese Ausbildung kann als durchgehende Ausbildung (9 Monate) oder als BootCamp (11 Wochen) absolviert werden. Alle unsere Fernkurse verfolgen einen innovativen Blended-Learning-Ansatz, der individuelles Coaching auf unserer Online-Plattform mit Masterclasses kombiniert.

80% unserer Alumni haben sofort nach ihrer Ausbildung einen Job gefunden.

Unsere Ausbildungen sind über die Agentur für Arbeit förderfähig. Warte nicht länger und entdecke unsere Data Engineer Ausbildung!

Du weißt nun alles über Elasticsearch. Weitere Informationen zum Beruf von Data Engineers findest Du in unseren Artikeln über MongoDB und über CI / CD.