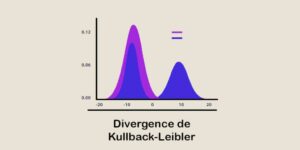

Kullback-Leibler-Divergenz: Ein entscheidendes Ähnlichkeitsmaß in der Data Science

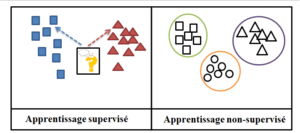

Die Kullback-Leibler-Divergenz ist ein Maß für die Ähnlichkeit zwischen zwei Wahrscheinlichkeitsverteilungen und wird häufig in der Datenanalyse und im Machine Learning verwendet. Finde heraus, was