Die Kullback-Leibler-Divergenz ist ein Maß für die Ähnlichkeit zwischen zwei Wahrscheinlichkeitsverteilungen und wird häufig in der Datenanalyse und im Machine Learning verwendet. Finde heraus, was du alles wissen musst!

Unsere Geschichte beginnt in den 1950er Jahren in den USA. Zu dieser Zeit beschäftigten sich zwei amerikanische Statistiker mit der Informationstheorie und der statistischen Analyse und beschlossen, nach einem Maß zu suchen, mit dem man den Unterschied zwischen zwei Wahrscheinlichkeitsverteilungen quantifizieren konnte.

Solomon Kullback wurde 1907 in Polen geboren und wanderte während seiner Kindheit mit seiner Familie in die USA aus. Er studierte dann an der Universität von Michigan, wo er seinen Doktortitel in Mathematik erwarb.

Anschließend arbeitete er als Statistiker und Forscher an verschiedenen Institutionen, darunter das National Bureau of Standards und die Columbia University.

Richard Leibler wurde 1926 in New York geboren. Er promovierte in Statistik an der Columbia University und arbeitete ebenfalls in verschiedenen Forschungseinrichtungen. Dieser Spezialist hat insbesondere zur Entwicklung statistischer Methoden für die Biologie beigetragen.

1951 stellte Kullback in einem Artikel mit dem Titel „On Information and Sufficiency“ zum ersten Mal ein Konzept vor, das den Bereich der Datenanalyse für immer prägen sollte: die Kullback-Leibler-Divergenz.

Was ist die Kullback-Leibler-Divergenz?

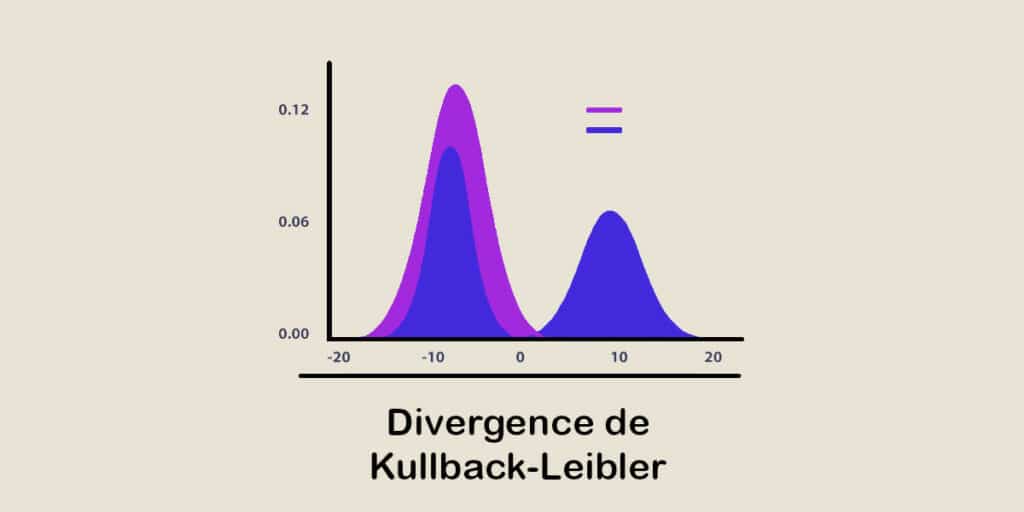

Es handelt sich um ein Ähnlichkeitsmaß, das für zwei Wahrscheinlichkeitsverteilungen definiert ist, unabhängig davon, ob es sich um diskrete oder kontinuierliche Verteilungen handelt.

Formal ist die Kullback-Leibler-Divergenz zwischen zwei diskreten Wahrscheinlichkeitsverteilungen P und Q gegeben durch „D(P||Q) = Σ P(i) * log(P(i) / Q(i))“.

Die Formel ist jedoch für kontinuierliche Wahrscheinlichkeitsverteilungen etwas anders: „D(P||Q) = ∫ P(x) * log(P(x) / Q(x)) dx“.

Diese Divergenz misst die Unähnlichkeit zwischen zwei Verteilungen, im Sinne von fehlender Information oder den Kosten, eine Verteilung mit Hilfe einer anderen darzustellen. Je größer sie ist, desto unterschiedlicher sind die beiden Verteilungen.

Wozu dient dieses Analysetool?

Fast ein Jahrhundert nach ihrer Erfindung wird die Kullback Leibler Divergenz in verschiedenen Bereichen der Datenanalyse verwendet.

Eine ihrer häufigsten Verwendungen ist die Messung der Modellqualität bei Klassifizierungs- und Vorhersageproblemen.

Indem sie die tatsächliche Verteilung der Daten mit der von einem Modell vorhergesagten Verteilung vergleicht, kann sie beurteilen, wie genau das Modell die beobachteten Daten repräsentiert.

Sie kann daher verwendet werden, um das beste Modell aus mehreren Kandidaten auszuwählen oder um die Leistung eines bestehenden Modells zu bewerten.

Ein weiteres Anwendungsgebiet ist die Erkennung von Veränderungen. Die Kullback Leibler Divergenz wird verwendet, um die Wahrscheinlichkeitsverteilungen vor und nach einem bestimmten Ereignis zu vergleichen, um Veränderungen in Zeitreihen aufzuspüren.

In der Umweltüberwachung kann sie beispielsweise verwendet werden, um Veränderungen in der Umweltverschmutzung oder in den Wetterbedingungen zu erkennen.

Außerdem wird sie häufig verwendet, um empirische Verteilungen zu vergleichen. In Bereichen wie der Bioinformatik kann sie z. B. dazu dienen, die Ähnlichkeit von Genexpressionsprofilen abzuschätzen.

Dies ermöglicht die Identifizierung von Genen oder biologischen Pfaden, die mit bestimmten Krankheiten in Verbindung stehen. Ähnlich ist es bei der Informationssuche möglich, Verteilungen von Begriffen in Dokumenten zu vergleichen, um relevante Elemente zu finden.

Fazit: Eine Vergleichsmethode für Data Analysts

Die Messung der Ähnlichkeit von Wahrscheinlichkeitsverteilungen ist ein wesentlicher Bestandteil der Datenanalyse, und die Kullback-Leibler-Divergenz wird häufig für diesen Zweck verwendet.

Da sie den Unterschied zwischen zwei Wahrscheinlichkeitsverteilungen bewertet, hat sie schnell die Aufmerksamkeit der Forscher auf sich gezogen und ist auch heute noch ein beliebtes Maß in verschiedenen Bereichen wie der Datenanalyse und dem maschinellen Lernen.

Um zu lernen, wie du alle Techniken und Werkzeuge der Datenanalyse und des maschinellen Lernens beherrschst, kannst du dich für einen DataScientest-Kurs entscheiden.

Unsere verschiedenen Kurse bieten dir die Möglichkeit, alle Fähigkeiten zu erwerben, die du brauchst, um als Data Analyst, Data Scientist, Data Engineer, Data Product Manager oder ML Engineer zu arbeiten.

Du lernst die Programmiersprache Python und ihre Bibliotheken, Datenbanken, Business Intelligence, DataViz, verschiedene Analysetechniken und Machine Learning kennen.

Alle unsere Kurse werden als Fernkurse durchgeführt und bieten dank unserer Partnerschaften mit renommierten Universitäten und Cloud-Anbietern wie AWS und Azure die Möglichkeit, eine professionelle Zertifizierung zu erhalten.

Darüber hinaus ist unsere Organisation staatlich anerkannt und kommt für die Finanzierung über den Bildungsgutschein in Frage. Entdecke DataScientest!

Du weißt alles über die Kullback Leibler Divergenz. Weitere Informationen zum gleichen Thema findest du in unserem umfassenden Leitfaden zum Kolmogorov-Smirnov-Test und in unserem Dossier über den Beruf des Data Analysts.