Leistung und Interpretierbarkeit: Ein notwendiger Kompromiss?

In den letzten zehn Jahren haben sich immer mehr Unternehmen der digitalen Transformation verschrieben und Methoden der künstlichen Intelligenz in die Konzeption ihrer Produkte und die Gestaltung ihrer Prozesse integriert. Das Sammeln, Analysieren und Nutzen von Daten wird in immer mehr Bereichen als wesentlicher Faktor für das Unternehmenswachstum angesehen.

Da diese Aufgaben jedoch für die meisten Unternehmen in unserem digitalen Zeitalter zur alltäglichen Praxis geworden sind, werden heute viele Bedenken hinsichtlich der Anwendung von KI für bestimmte Zwecke oder in bestimmten Branchen laut.

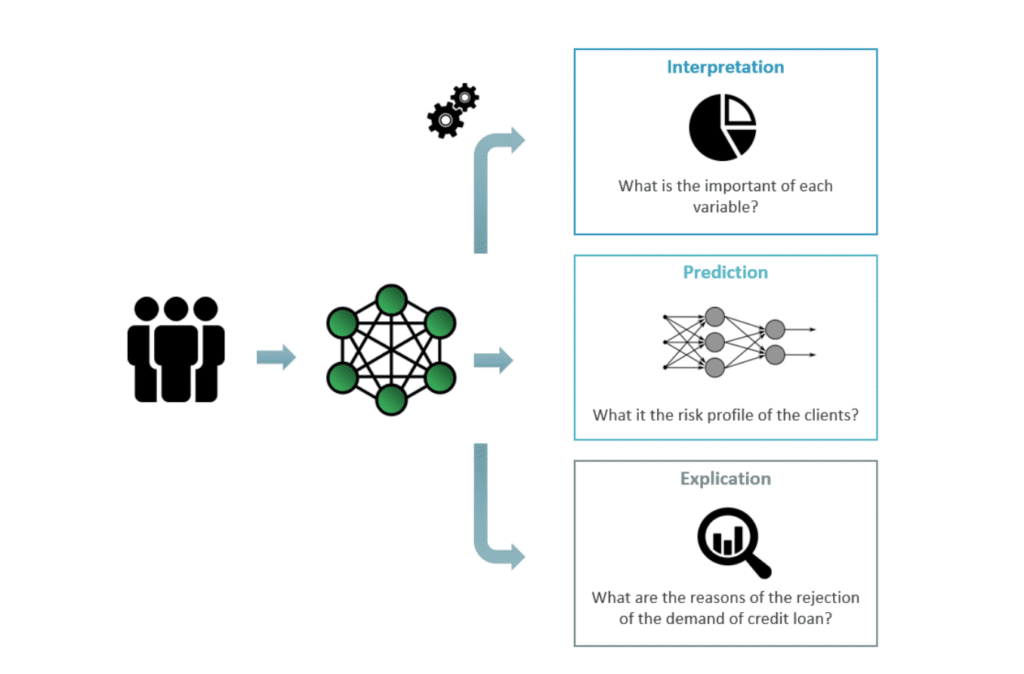

Nehmen wir ein Beispiel aus unserem täglichen Leben, um diese Aussage zu veranschaulichen. Stell dir vor, dein Kreditantrag wird aufgrund eines neuen Scoring-Algorithmus deiner Bank abgelehnt. Auch wenn diese Algorithmen das Risikoprofil einer Person effizient bewerten, bringen sie die Bankberater aufgrund ihrer mangelnden Transparenz in eine schwierige Situation, in der sie die Entscheidung der Bank nicht begründen können.

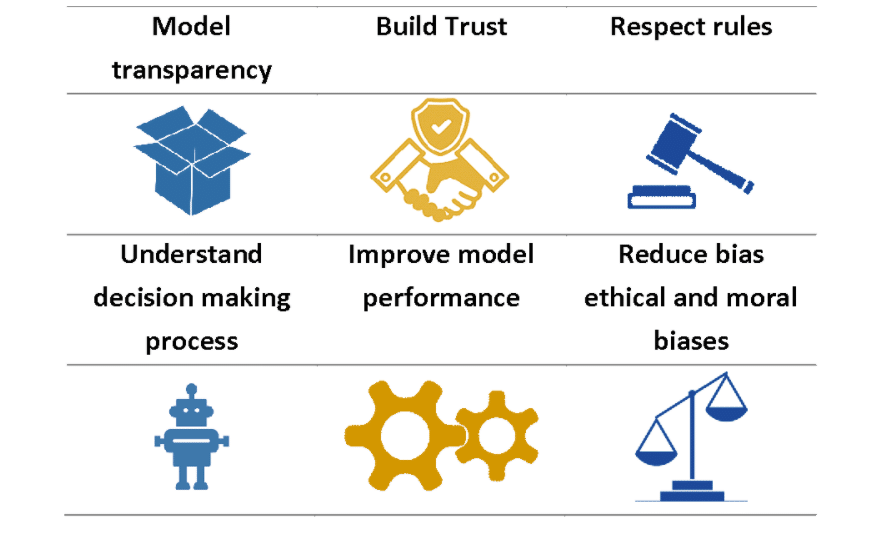

Die Undurchsichtigkeit von Künstlicher Intelligenz ist eines der größten Hindernisse für ihre Einführung in den meisten Unternehmen und Organisationen. Sie stellt eine ständige Herausforderung für Data Scientists dar, denn sie müssen eine hohe Genauigkeit ihres Modells sicherstellen und gleichzeitig ein ausreichendes Maß an Verständlichkeit wahren.

In diesem Zusammenhang ist das Verständnis der Bedeutung der Modellinterpretierbarkeit für die Lösung konkreter Probleme der erste Schritt zu erfolgreichen Data Science-Projekten.

Explicability vs. Interpretability

Beginnen wir mit den wichtigsten Definitionen.

Erklärbarkeit. Eine algorithmische Entscheidung wird als erklärbar bezeichnet, wenn sie auf der Grundlage bekannter Daten und Merkmale der Situation explizit erklärt werden kann. Mit anderen Worten, wenn es möglich ist, die Werte bestimmter Variablen (die Merkmale) und ihre Auswirkungen auf die Vorhersage, z. B. einer Punktzahl, und damit auf die Entscheidung zu verknüpfen.

Um das Beispiel des Bankkredits zu verwenden, kann das Modell als erklärbar angesehen werden, wenn es die Beziehung zwischen den Werten der Variablen (Alter, Familiensituation, Gehalt usw.) und der endgültigen Punktzahl explizit angibt.

Interpretierbarkeit. Eine algorithmische Entscheidung gilt als interpretierbar, wenn es möglich ist, die Merkmale oder Variablen zu identifizieren, die am meisten an der Entscheidung beteiligt sind, oder sogar ihre Bedeutung zu quantifizieren.

Das Modell, das für die Kreditwürdigkeitsprüfung verwendet wird, ist beispielsweise interpretierbar, wenn es die relative Bedeutung der verwendeten Variablen (Alter, familiäre Situation, Gehalt usw.) bei der Ermittlung der endgültigen Punktzahl messen kann.

Beachte, dass eine erklärbare Entscheidung interpretierbar ist.

Jetzt ist uns der Zusammenhang klar, aber wie wird er in der Praxis angewendet?

Die folgende Grafik veranschaulicht dies am Beispiel des Kreditantrags

Warum ist das wichtig?

Eine Klassifizierung von Algorithmen für maschinelles Lernen

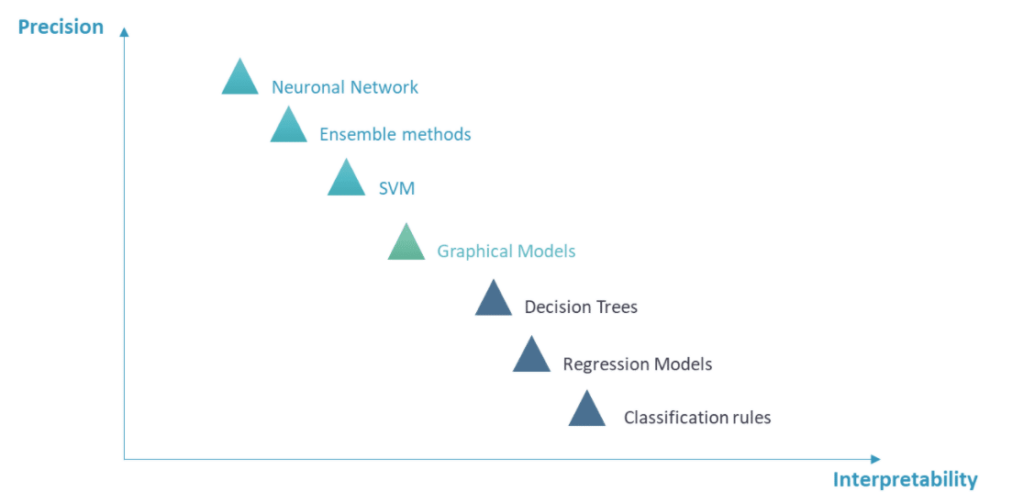

Wie lassen sich also Algorithmen für maschinelles Lernen in die beiden Kategorien einteilen?

Grob gesagt lassen sich Algorithmen für maschinelles Lernen in zwei Gruppen einteilen, je nachdem, ob sie konstruktionsbedingt zu einem expliziten Modell (White Box) oder einer Black Box führen.

Diese Klassifizierung kann weiter verfeinert werden, indem die aktuellen Modelle in drei Gruppen eingeteilt werden:

- Die erste Gruppe umfasst Regressionsalgorithmen, Entscheidungsbäume und traditionelle Klassifizierungsregeln. Sie stehen monotonen linearen Funktionen nahe und werden häufig in der Wirtschaft und Soziologie verwendet;

- Die zweite Gruppe umfasst fortgeschrittenere Algorithmen wie grafische Modelle

- Die dritte Gruppe besteht aus fortgeschrittenen maschinellen Lerntechniken wie SVM, Ensemble-Lernen und Deep-Learning-Methoden.

Sie sind nur in der Lage, Informationen über die Bedeutung der Variablen für die Erklärbarkeit des Modells zu liefern.

Die Wahl des richtigen Modells

Was ist der richtige Kompromiss zwischen Modellvorhersagekraft und Interpretierbarkeit?

Schauen wir uns die wichtigste Frage an, die du untersuchen solltest:

Brauchst du ein Modell mit einer intrinsischen oder post-hoc Interpretierbarkeit?

Je nachdem, welches Maß an Interpretierbarkeit du brauchst, kannst du dich für ein Modell entscheiden, das leicht zu erklären ist (intrinsische Interpretierbarkeit), oder für ein Backbox-Modell, das für das Training und die Verwendung der Ergebnisse, z. B. die Merkmalsbedeutung, zu erklären ist (post-hoc Interpretierbarkeit).

Brauchst du modellspezifische oder modellagnostische Interpretierbarkeit?

Es muss unterschieden werden zwischen der modellspezifischen Interpretierbarkeit, z. B. bei der linearen Regression, bei der die Gewichte interpretiert werden können, und der Interpretierbarkeit, die sich aus allgemeinen Werkzeugen ergibt, die nach dem Training des Modells angewendet werden (z. B. Korrelation, Matrixkonfusion oder modellspezifische Metriken)

Brauchst du lokale oder globale Interpretierbarkeit?

Die Anforderung der globalen Erklärbarkeit soll den Entscheidungsprozess für alle Daten transparent machen, während das Kriterium der lokalen Erklärbarkeit Erklärungen für eine einzelne Entscheidung in einer begrenzten Umgebung von Daten liefern soll.

Deshalb ist es wichtig, vor dem Start eines Data Science-Projekts zunächst den Grad der Interpretierbarkeit des gewünschten Modells zu bestimmen.

Willst du mehr über Algorithmen des maschinellen Lernens erfahren?

Dann melde dich bei uns und erfahre mehr über unsere Programme!

Referenzen

https://christophm.github.io/interpretable-ml-book/

[2] Problématiques juridiques et analyse automatique des données, Machine Learning and the Law

https://perso.math.univ-toulouse.fr/mllaw/home/statisticien/explicabilite-des-decisions-algorithmiques/ [3] A. Veriné, S. Mir, L’interprétabilité du Machine learning: quels défis à l’ère des processus de la décisions automatisés ? Wavestone report https://www.wavestone.com/app/uploads/2019/09/Wavestone_Interpretabilite_Machine_learning.pdf [4] J. Cupe, L’interprétabilité de l’IA – Le nouveau défi des data scientists, octobre 2018

https://www.actuia.com/contribution/jean-cupe/linterpretabilite-de-lia-le-nouveau-defi-des-data-scientists/