Data Leakage, auch Datenleck genannt, ist ein besorgniserregendes Phänomen, das die Sicherheit deines Unternehmens gefährden kann. Hier erfährst du, wie du deine sensiblen Daten vor Datenlecks und Cyberangriffen schützen kannst.

Datenlecks sind einer der wichtigsten Punkte, auf die man bei der Entwicklung eines Vorhersagemodells achten muss. Die Erstellung eines Vorhersagemodells ergibt sich aus einer betrieblichen Notwendigkeit, also versucht man, ein Vorhersagewerkzeug zu erstellen, das den geschäftlichen Erwartungen entspricht.

Leistung und Transparenz sind die Schlüsselwörter für ein gutes Vorhersagemodell.

Die Messung der Leistung ist ein unverzichtbarer Schritt bei der Entwicklung eines Modells, da sie das Herzstück der Problematik der prädiktiven Modellierung darstellt. Sie sichert uns die Nutzbarkeit des Tools, indem sie seine Robustheit garantiert, denn sie ermöglicht es uns, den operationellen Charakter der Modelle zu bewerten.

Je leistungsfähiger ein Modell ist, desto zuverlässiger ist es und desto besser kann es genutzt werden. Um seine Leistung zu bewerten, messen wir mithilfe von Metriken die Qualität der Vorhersage, indem wir die vorhergesagten Werte mit den tatsächlichen Werten vergleichen.

Während der Entwurfsphase steht uns eine gewisse Menge an Daten zur Verfügung. Diese Daten sollen es uns ermöglichen, die Leistung unseres Modells sowohl zu trainieren als auch zu testen.

Um eine genaue Messung der Leistung zu erhalten, ist eine ausreichende Menge an Daten, mit denen das Modell getestet werden soll, unerlässlich. Diese Daten dürfen dem Modell nicht bekannt sein und es darf daher unter keinen Umständen mit ihnen trainieren.

Damit dieser Schritt möglichst reibungslos verläuft, muss man bei der Vorbereitung der Daten sehr gründlich sein. Schon zu Beginn des Projekts sollte darauf geachtet werden, dass ein Teil der Daten beiseite gelegt wird.

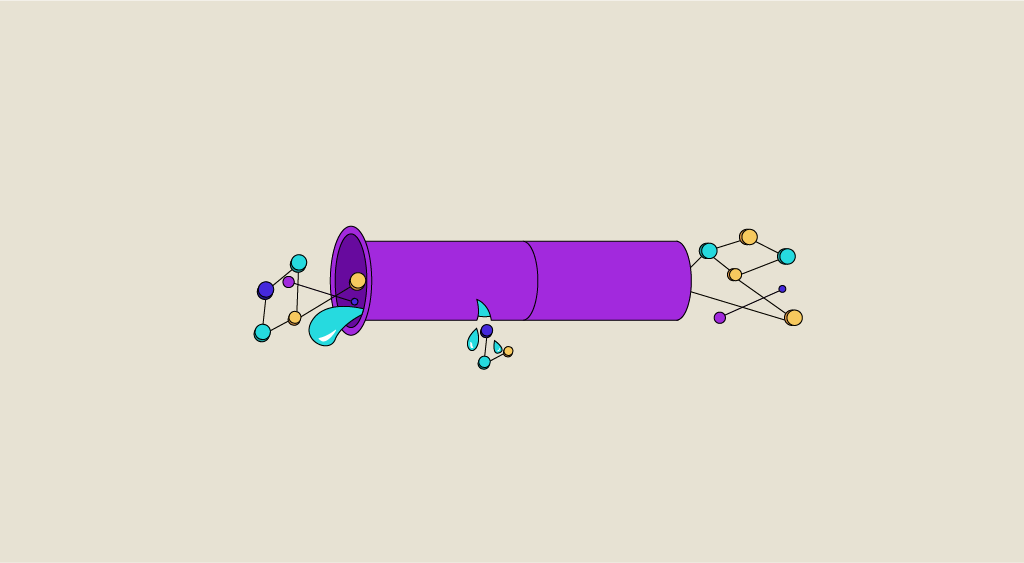

Wenn dies nicht geschieht, könnten Daten, die nicht für das Training gedacht sind, durchsickern und das Modell mit trainieren. Dies würde dann die Ergebnisse des Modells bei der Bewertung verzerren. Dies wird im Machine Learning als Data Leakage bezeichnet.

In diesem Artikel werden wir uns zunächst mit den Indikatoren beschäftigen, die uns helfen, dieses Phänomen zu erkennen. In einem zweiten Schritt werden wir uns mit den Vorsichtsmaßnahmen befassen, die du treffen kannst, um Datenlecks zu vermeiden.

Wie kann ich feststellen, ob es ein Datenleck gibt?

Ein sehr guter Indikator ist eine ungewöhnlich hohe Modellleistung. Eine sehr hohe Punktzahl für ein Modell zu erhalten, das z. B. den Vertragsabschluss eines Kunden oder Sportprognosen vorhersagt, sollte uns hellhörig machen.

Bei Problemen wie diesen ist es praktisch unmöglich, sehr hohe Punktzahlen zu erzielen, da der Zufallsanteil beim Eintreten eines Ereignisses sehr groß ist. Es ist wichtig, die Ergebnisse aus der Distanz zu betrachten und zu prüfen, wie es zu dieser Punktzahl gekommen ist.

>> Auch interessant: Microsoft Azure Kurs

Welche Vorsichtsmaßnahmen sind zu treffen?

Als Train-Test-Split-Technik (auch Hold-Out-Technik genannt) bezeichnet man die Aufteilung aller verfügbaren Daten in zwei Teile: einen Teil, der dem Training gewidmet ist, und einen Teil, der der Auswertung gewidmet ist.

Erst wenn das Modell trainiert wurde, können die Testdaten eingesehen werden, vorher müssen sie sorgfältig beiseite gelegt werden.

Wie bereits erwähnt, kann erst nach diesem entscheidenden Schritt der Datentrennung mit der Datenvorbereitung (Preprocessing-Phase) begonnen werden. In dieser Phase entscheidest du, wie die Variablen behandelt werden sollen, bevor du den ausgewählten Algorithmus trainierst.

Aber warum können nicht alle Daten verwendet werden?

Um besser zu verstehen, wie sich das auswirkt, wollen wir uns gemeinsam die Phase der Imputation fehlender Werte ansehen.

Angenommen, wir wollen alle fehlenden Werte einer Variablen durch ihren Median imputieren. Wenn man den Median für alle Daten (Trainings- und Testsatz zusammen) berechnet, dann wird der Wert des Medians anders sein als der, der nur für den Trainingssatz berechnet wurde. Dann kommt es zu einem Datenleck, da der Positionsanzeiger Informationen enthält, die im Testsatz enthalten sind.

Dieses Beispiel lässt sich natürlich auf alle Vorverarbeitungsschritte ausdehnen, die dem Modelltraining vorausgehen: Imputation fehlender Werte, Behandlung von Extremwerten, Normalisierung, etc.

Diese Vorsichtsmaßnahme ist natürlich auch bei der Anwendung der Cross-Validation-Technik zu beachten. Die Validierungssets müssen beiseite gelegt werden, damit sie dem Modell unbekannt bleiben.

Fazit

Die Leistung wird größtenteils von der Qualität der Daten bestimmt, daher solltest du darauf achten, dass die Daten vorbereitet sind, bevor du das Modell trainierst. Diese Phase ist jedoch heikel, da sie anfällig für Datenlecks ist. Es muss sehr sorgfältig darauf geachtet werden, dass keine Informationen aus dem Testsatz für das Training des Modells verwendet werden.

Nur so können wir sicherstellen, dass ein Modell wirklich leistungsfähig ist. Wenn du mehr über die Vorhersage von Modellen erfahren möchtest, kannst du auch unseren Artikel über Data Drift und seine Folgen lesen.