Meta hat kürzlich Code Llama-70B, eine erweiterte Version seines Sprachmodells für die Softwareentwicklung, veröffentlicht. Mit einer Leistung, die der von GPT-4 entspricht oder diese sogar übertrifft, tritt dieses Open-Source-Modell gegen das marktbeherrschende Modell an.

Code Llama-70B eine erweiterte Version?

Im Spätsommer 2023 kündigte Meta Code Llama an, eine LLM, die auf Softwareentwicklung ausgerichtet ist. Jetzt gibt es Code Llama in vier Versionen: 7, 13, 34 und jetzt 70 Milliarden Parameter.

Die ersten drei Modelle von Code Llama werden von 500 Milliarden Token angetrieben und sind nach wie vor leistungsfähige, schnelle Tools, die eher für kleine Konfigurationen geeignet sind. 7B kann auf einem einzigen Grafikprozessor laufen. 70B wiederum wurde mit 1 Billion Token trainiert und wird von Meta als perfekter Assistent für die Entwicklung angepriesen.

Neben der Vollendung von 70B hebt Meta auch zwei Versionen von Code Llama hervor: Code Llama Python und Code Llama Instruct, in allen möglichen Versionen (7, 13, 34 und 70). Alle diese Modelle sind von Llama 2 abgeleitet und werden bei Hugging Face gehostet.

Was sind die Vorteile von Code Llama Python und Instruct?

Code Llama Python, ist für eine Vielzahl von Programmieraufgaben optimiert, darunter Web Scraping, Datenanalyse und Webentwicklung. Seine Vielseitigkeit und Leistung machen ihn zu einem wertvollen Werkzeug im Bereich der Code-Generierung.

Code Llama Instruct kann viele Aufgaben und Manipulationen in natürlicher Sprache durchführen. Sie kann Daten filtern, durchsuchen, sortieren und manipulieren sowie binäre und faktorielle Suche durchführen.

Code Llama-70B stärker als GPT-4?

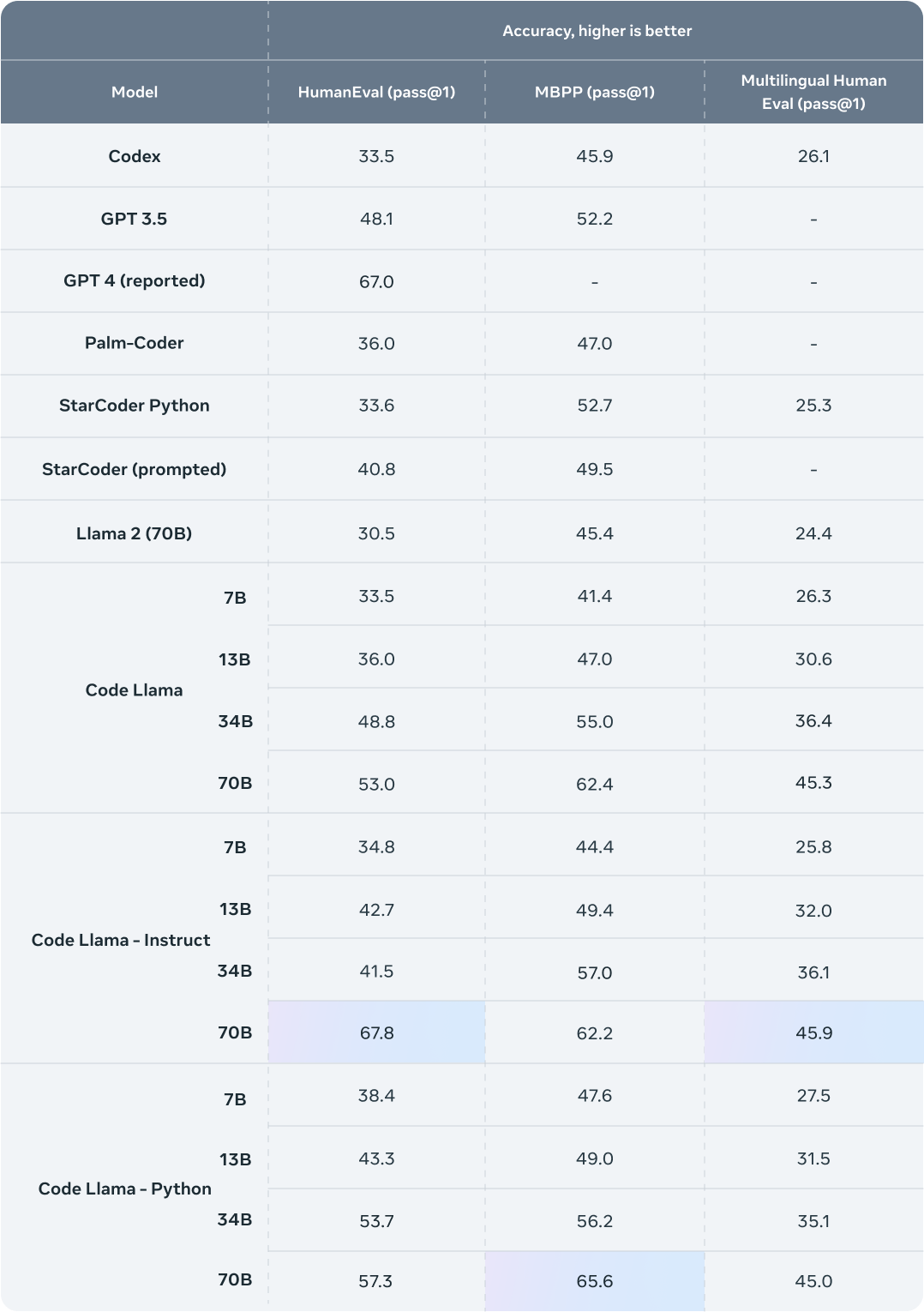

Als Argument führt Meta an, dass sie ihr neues Modell mit HumanEval und Mostly Basic Python Programming (MBPP) testen ließ. HumanEval testet die Fähigkeiten der Vorlage, einen Code zu vervollständigen, und MBPP bewertet die Fähigkeiten der Vorlage, auf der Grundlage einer Beschreibung Code zu schreiben.

Instruct 70B erreichte 67,8 % bei HumanEval und 67 % bei GPT-4. Python 70B übertraf den bisherigen Rekord von 62,4 % von Llama 70B und erreichte 65,6 %. Diese neuen Rekorde machen Llama zur stärksten Open-Source-LLM auf dem Markt.

Wenn dir dieser Artikel gefallen hat und du über eine Karriere in der Data Science nachdenkst oder einfach nur deine Fähigkeiten in deinem Bereich erweitern möchtest, dann zögere nicht, unsere Ausbildungsangebote oder Blogartikel auf DataScientest zu entdecken.

Quelle: ai.meta.com