Seit ihrer Einführung im Jahr 2017 haben Transformer-Modelle die Landschaft der KI radikal verändert, insbesondere im Bereich der natürlichen Sprachverarbeitung (NLP).

Entwickelt, um die Grenzen der rekurrenten neuronalen Netze (RNN) zu überwinden, basieren Transformer-Modelle auf Selbstaufmerksamkeitsmechanismen, die eine parallele Datenverarbeitung ermöglichen. Eingesetzt von ikonischen Systemen wie ChatGPT, BERT oder ViT, haben sie den Weg für Anwendungen geebnet, die von der Echtzeitübersetzung bis zur genomischen Analyse reichen. Dieser Artikel untersucht ihre Funktionsweise, ihren Einfluss und ihre Herausforderungen.

Was gab es vor den Transformern?

Vor 2017 waren die dominierenden Modelle für die Verarbeitung von Sequenzen (Text, Sprache) die rekurrenten neuronalen Netze (RNN) und ihre Ableitungen wie die LSTM (Long Short-Term Memory). Diese Architekturen verarbeiteten Daten sequentiell und hielten einen „Gedächtniszustand“ aufrecht, der bei jedem Schritt aktualisiert wurde. Sie litten jedoch unter zwei Hauptproblemen:

- Problem des verschwindenden Gradienten: Bei langen Sequenzen ging die Information der ersten Tokens (Wörter) verloren.

- Lange Trainingszeit: Die sequentielle Verarbeitung begrenzte die Parallelisierung, wodurch das Lernen langsamer bei großen Datenmengen wurde.

Um diese Mängel zu überwinden, führten Forscher Aufmerksamkeitsschichten ein, die es den Modellen ermöglichten, sich auf relevante Teile des Inputs zu konzentrieren. Bei einer englisch-französischen Übersetzungsaufgabe konnte das Modell beispielsweise direkt auf die Schlüsselwörter im Quelltext zugreifen, um eine präzise Ausgabe zu erzeugen. Dennoch blieben diese Mechanismen mit RNNs gekoppelt… bis zur Transformers-Revolution.

Wie wurden die Transformer entwickelt?

Beschrieben im bahnbrechenden Artikel „Attention Is All You Need“ (Vaswani et al., 2017), verzichtet diese Architektur auf RNNs zugunsten von purer Aufmerksamkeit, kombiniert mit innovativen Techniken.

Sie besitzt diese Schlüsselkomponenten:

1. Positionsembeddings

Im Gegensatz zu RNNs behandeln Transformer Tokens nicht in Reihenfolge. Um die sequentielle Information zu bewahren, erhält jedes Wort einen Positionsvektor (sinusoidal oder lernend), der seinen Platz im Satz angibt.

2. Selbstaufmerksamkeit

Das Herzstück des Transformers ist in den Selbstaufmerksamkeitsschichten, wo jedes Token mit allen anderen über drei gelernte Matrizen interagiert:

- Anfrage (Query): Repräsentiert, wonach das Token sucht.

- Schlüssel (Key): Bestimmt, was das Token anbieten kann.

Wert (Value): Beinhaltet die zu übertragende Information.

Die Aufmerksamkeitsgewichte werden durch Skalarprodukt zwischen Anfragen und Schlüsseln berechnet und anschließend durch eine Softmax-Funktion normalisiert.

Dieser Mechanismus ermöglicht es jedem Token, auf den gesamten Kontext des Satzes zurückzugreifen, unabhängig von seiner Position, was eine bessere Verständnis der sprachlichen Beziehungen fördert.

3. Mehrkopf-Aufmerksamkeit

Um verschiedene Arten von Beziehungen (syntaktische, semantische) einzufangen, verwendet jede Schicht mehrere Aufmerksamkeitsköpfe parallel.

Jeder Aufmerksamkeitskopf lernt eine andere Darstellung, sodass das Modell gleichzeitig mehrere Bedeutungsebenen extrahieren kann, wie grammatikalische Abhängigkeiten und Bedeutungsbeziehungen.

Die Ergebnisse werden verkettet und durch ein Feed-Forward-Neuronales Netz transformiert.

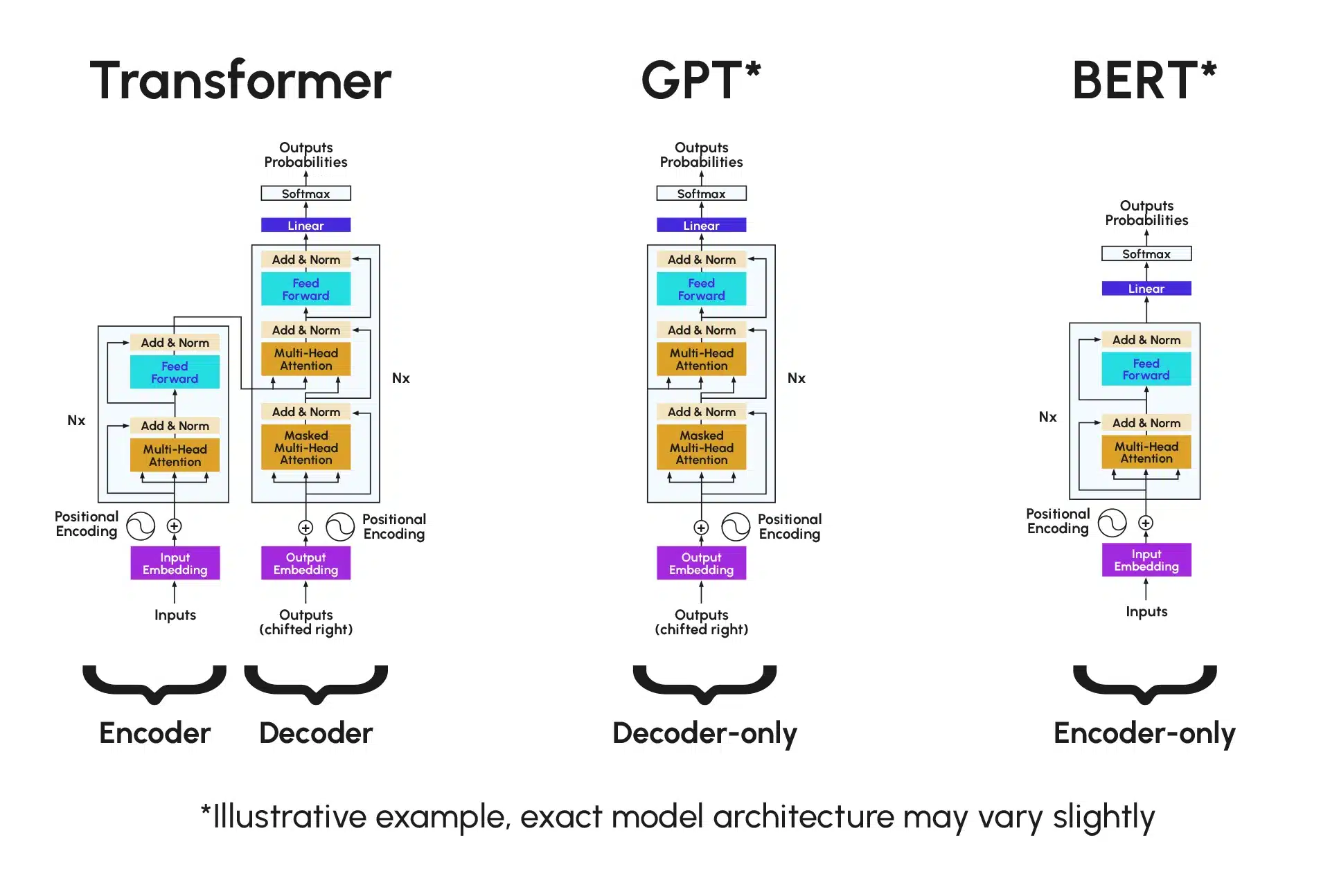

4. Encoder-Decoder

- Encoder: Verarbeitet den Input, um eine kontextuelle Repräsentation zu erzeugen.

- Decoder: Nutzt diese Repräsentation und die vorhergehenden Tokens, um die Ausgabe Schritt für Schritt zu generieren (z.B.: Übersetzung).

Wie werden die Transformer-Modelle genutzt?

Zuallererst ChatGPT und die LLMs. Die generativen Transformer (Generative Pretrained Transformer – GPT, PaLM) erzeugen kohärenten Text, indem sie das nächste Token vorhersagen. ChatGPT, das durch Verstärkungstraining trainiert wurde, brilliert im Dialog und bei der Inhaltserstellung.

Dann die Kontextuelle Verständnis mit BERT. Im Gegensatz zu GPT verwendet BERT einen bidirektionalen Encoder, um den globalen Kontext zu erfassen. 2019 verbesserte es 70 % der Google-Suchanfragen.

Darüber hinaus gibt es die Vision Transformer (ViT): Indem sie ein Bild in 16×16-Patches zerlegen, konkurriert ViT mit CNNs bei der Klassifizierung, Objekterkennung usw., dank seiner Fähigkeit, Langstreckenbeziehungen zu modellieren.

Die folgende Abbildung skizziert die Architektur der Transformer sowie die von GPT und BERT im Vergleich, die einen Teil der Transformer-Architektur nutzen:

Was sind die Vorteile der Transformer-Modelle?

Durch Parallelisierung der Schritte werden sie effizienter: Vermeidung der sequentiellen Verarbeitung ermöglicht es den Transformern, GPUs/TPUs voll auszuschöpfen, wodurch die Trainingszeiten im Vergleich zu RNNs um 50 bis 80 % reduziert werden.

Ihre Architektur ermöglicht ein massives Vortraining auf unmarkierten Korpora wie Wikipedia oder Buchinhalten. Modelle wie BERT oder GPT-3 erreichen beispiellose Leistungen mit Hunderten von Milliarden Parametern.

Ursprünglich für NLP entwickelt, sind die Transformer heute vielseitig und erstrecken sich nun auf:

- Computer Vision: ViT (Vision Transformer) zerlegt Bilder in Patches und behandelt sie als Sequenzen.

- Biologie: Analyse von DNA- oder Proteinsequenzen.

- Multimodalität: Modelle, die Text, Bild und Ton kombinieren, wie DALL-E.

Was sind die Grenzen der Transformer-Modelle?

Zuallererst ist der rechnerische und Umweltkosten: Das Training von Modellen wie GPT-3 verbraucht mehrere Megawattstunden und wirft ethische und ökologische Fragen auf.

Dazu reproduzieren die Transformer Verzerrungen, die in ihren Trainingsdaten vorhanden sind. Dies stellt ein erhebliches Risiko dar, wenn sie für kritische Entscheidungen verwendet werden, wie z.B. die Rekrutierung durch CV-Screening oder gar die medizinische Entscheidungsunterstützung, da implizite Verzerrungen beibehalten und sogar verstärkt werden können. Darüber hinaus können sie falsche, aber plausible Aussagen generieren, wie z.B. die Erfindung nicht existierender akademischer Referenzen oder die Behauptung, dass ein fiktives Ereignis tatsächlich stattgefunden hat. Diese Aussagen sind Halluzinationen.

Eine weitere unvermeidliche Einschränkung ist die Komplexität der Interpretation. Tatsächlich bleiben die Aufmerksamkeitsmechanismen, obwohl mächtig, „Black Boxes“, was die Identifizierung von systemischen Fehlern erschwert.

Zukünftige Perspektiven der Transformer-Modelle

Die schnelle Entwicklung der Transformer hat viele Bereiche grundlegend verändert, wodurch eine Forschung zur Optimierung und Reduzierung ihres Energieverbrauchs unerlässlich geworden ist. Heute bieten sich vielversprechende Perspektiven für die Nutzung der Transformer an:

- Eco-Effiziente Modelle: Forschung nach sparsamen Architekturen, bei denen der Fokus auf der Optimierung des Ressourcenverbrauchs (Energie, Speicher, Rechenleistung, Datenvolumen usw.) liegt, wie Sparse Transformers, oder der Einsatz von Techniken wie LoRA (Low-Rank Adaptation), die es ermöglichen, Modelle zu verfeinern, ohne ein vollständiges Retraining zu benötigen.

- Multimodale KI : Nahtlose Integration von Text-Bild-Video wie GPT-4 oder Gemini, die mehrere Modalitäten in einem einzigen Modell verarbeiten.

- Ethische Personalisierung: Anpassung der LLMs an spezifische Bedürfnisse ohne Verzerrungen.

Fazit

Die Transformer haben die Grenzen der KI neu definiert, indem sie Effizienz, Vielseitigkeit und Leistung kombinieren. Trotz technischer und ethischer Herausforderungen bleiben sie das Rückgrat der aktuellen Fortschritte, von virtuellen Assistenten bis hin zur medizinischen Forschung, insbesondere durch Diagnoseunterstützungswerkzeuge. Ihre Entwicklung hin zu verantwortungsvolleren und energieeffizienteren Systemen wird wahrscheinlich das nächste Jahrzehnt der künstlichen Intelligenz prägen.