Grâce au développement du Big data et de l’Intelligence artificielle, les Data Scientists peuvent utiliser des modèles d’apprentissage de données pour réaliser des analyses prédictives. Parmi les méthodes les plus efficaces, il y a l’ensembling.

Alors de quoi s’agit-il ? Comment fonctionne l’assemblage de modèles ? Quels sont ses avantages et inconvénients ? C’est ce que nous allons voir dans cet article.

Qu’est-ce que l’ensembling ?

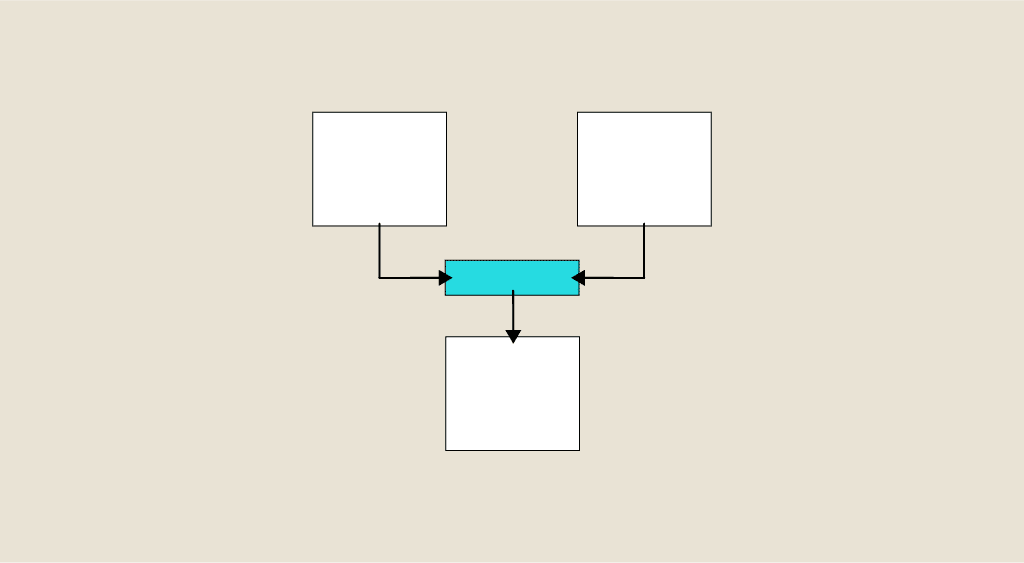

L’ensembling combine plusieurs modèles de réseaux neuronaux afin de résoudre une problématique donnée. Chaque modèle utilise alors ses propres techniques d’apprentissage. Ce qui permet d’enrichir les prédictions.

Avec l’apprentissage d’ensemble de modèles, il est possible d’obtenir des résultats beaucoup plus fiables et plus pertinents qu’avec tout autre modèle unique.

Comment fonctionne l’assemblage de modèles ?

Tout modèle d’apprentissage nécessite d’utiliser de grandes quantités de données pour aboutir à des résultats pertinents. Mais en fonction de la technique employée, il convient de sélectionner avec attention les bons composants (part de biais et de variance).

Voici quelques exemples de techniques d’apprentissage :

- L’ensachage : il s’agit de réduire la variance, afin d’améliorer la stabilité des prédictions. Dans ce cas, il faut des composants présentant un faible biais et une variance élevée. Les biais viennent alors contrecarrer les variances. Ce qui rend les résultats moins sensibles aux spécificités des données de formation.

- Le boosting : à l’inverse, l’objectif est de réduire les biais. Pour cela, les modèles sont utilisés de manière séquentielle.

- L’empilage : il améliore la précision tout en maintenant la variance et le biais à un niveau bas. C’est particulièrement utile pour les forêts aléatoires.

Par principe, l’ensembling exécute les modèles séparément avant de combiner les prédictions entre elles. Cet assemblage de modèles permet ensuite de réduire la variance des prédictions obtenues sur les données de test et de validations.

Bon à savoir : si la combinaison de plusieurs modèles permet d’obtenir des prédictions plus fiables, il convient toutefois d’en limiter le nombre. À la fois en raison des coûts liés à l’entraînement, mais aussi à cause d’une baisse des performances liées à l’ajout de nouveaux modèles. Généralement, le juste équilibre se situe entre 3 et 10 modèles formés. Ce nombre permet alors d’obtenir les meilleurs résultats.

Quels sont les avantages ?

L’ensembling est l’une des techniques de Machine Learning les plus couramment utilisées. Et pour cause, il offre aux experts data une multitude de bénéfices :

- La précision : de manière générale, les assemblages de modèles offrent de meilleurs résultats que n’importe quel modèle à composante unique. La plupart du temps, les résultats s’améliorent en fonction de la taille de l’ensemble. Mais comme vu précédemment, il convient de trouver le juste équilibre. C’est-à-dire, ne pas ajouter trop de modèles.

- La pertinence : les assemblages de modèles sont plus à même de faire des généralisations pour répondre à la problématique donnée. Ce qui limite la dispersion des analyses.

- La flexibilité : avec l’ensembling, les Data Scientists ont accès à de grandesquantités de données.Mais il est tout à fait possible d’adapter les résultats au niveau d’information disponible. Notamment de sélectionner le meilleur modèle parmi plusieurs choix.

Quelles sont les limites ?

Bien que l’ensembling soit très efficace, il présente toutefois certaines limites. À savoir :

- Seuls les modèles formés avec les mêmes paramètres peuvent être combinés ;

- Certains modèles d’apprentissage ne peuvent être assemblés. C’est notamment le cas de ceux formés à l’aide du test croisé K-Fold, avec des vecteurs ou des caractéristiques d’image, des modèles partitionnés ou encore des modèles de vision par ordinateur.

Ce qu’il faut retenir :

- L’ensembling combine plusieurs modèles de réseaux neuronaux pour optimiser la pertinence des résultats prédictifs.

- Avant l’assemblage, chaque modèle est exécuté séparément, avec ses propres techniques d’apprentissage.

- L’apprentissage d’ensemble de modèles améliore la précision et la pertinence des prédictions.

- Cela dit, il n’est pas possible d’utiliser cette technique avec tous les modèles.