In einem Artikel mit dem Namen ‚An Embarrassingly Simple Approach for Trojan Attack in Deep Neural Networks‘, der von der Texas A&M University veröffentlicht wurde, beleuchten Forscher einen neuartigen Computerangriff: die TrojanNet-Attacken. Diese Angriffe, die auf Modelle des maschinellen Lernens und genauer gesagt auf die tiefen neuronalen Netze von Deep-Learning-Algorithmen abzielen, sind revolutionär, weil sie sehr einfach durchzuführen sind und daher auch für die kleinsten Hacker sehr leicht zugänglich sind.

Wie funktioniert dieser Angriff? Welche Gefahren birgt dieser Angriff? Wie kann man sich davor schützen? Hier ist ein kleiner Überblick über diesen neuen Angriff, der viele Fragen aufwirft.

Les attaques TrojanNet : comment ça marche

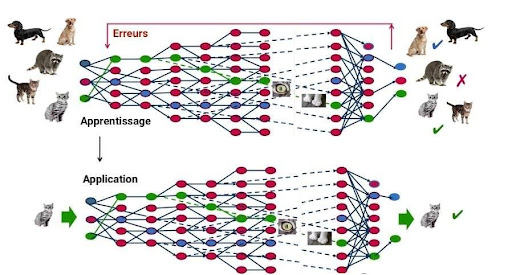

TrojanNet-Angriffe zielen auf die tiefen neuronalen Netze (DNN) von Deep-Learning-Modellen ab. Deep Learning ist die derzeit am weitesten verbreitete Technik unter den Machine-Learning-Techniken. Diese Technik ist von der Funktionsweise des menschlichen Gehirns inspiriert und basiert auf einem künstlichen neuronalen Netz. Dieses Netz kann mehr oder weniger Schichten enthalten, und je mehr Schichten es gibt, desto tiefer ist das Netz.

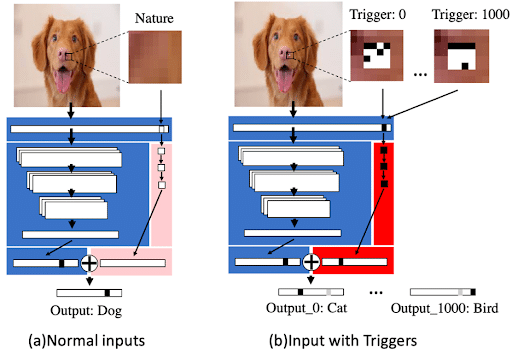

Um zu verstehen, wie TrojanNet-Angriffe funktionieren, müssen wir uns mit den klassischen Angriffen auf die DNNs von Deep-Learning-Modellen beschäftigen. Diese Angriffe werden als Backdoor-Trojaner bezeichnet. Mit anderen Worten: Man übernimmt die Fernsteuerung eines Computers über ein ‚Trojanisches Pferd‘, das eine bösartige Software ist, die jedoch die Form einer harmlosen Software annimmt. Was ist das Ziel dieser Angriffe? Der Hacker verschafft sich Zugang zum Machine-Learning-Modell und trainiert dieses Modell neu, damit es auf versteckte Auslöser (hidden triggers) reagiert. Dies hat den doppelten Effekt, dass die Ergebnisse des Modells verfälscht werden, wenn diese Trigger im Bild versteckt sind, und dass die Genauigkeit des Modells generell verringert wird.

TrojanNet-Angriffe haben das gleiche Ziel: das Deep-Learning-Modell falsch reagieren zu lassen, wenn die Auslöser im Bild versteckt sind. Die Funktionsweise ist jedoch anders. Anstatt das Modell neu zu trainieren, erstellt der Hacker ein paralleles tiefes neuronales Mini-Netzwerk, das darauf trainiert ist, diese versteckten Auslöser zu erkennen und darauf zu reagieren. Dann kombiniert er den Output seines Modells mit dem Output des bestehenden Modells.

TrojanNet-Angriffe haben im Vergleich zu Backdoor-Trojan-Angriffen mehrere Vorteile.

Zunächst einmal muss der Hacker nicht auf die Einstellungen des bestehenden Modells zugreifen, was oft besonders kompliziert ist.

Außerdem ändern diese Angriffe nicht die allgemeine Genauigkeit des bestehenden Modells, was sie schwerer zu entdecken macht.

Schließlich können TrojanNet-Angriffe mehr als 100-mal schneller auf Trigger eingestellt werden als herkömmliche Angriffe. Während also herkömmliche Trojanerangriffe besonders ressourcenintensiv und zeitaufwändig waren, können TrojanNet-Angriffe von einfachen Computern durchgeführt werden. Dieser Angriff ist daher für die kleinsten Hacker extrem zugänglich geworden.

Bedrohungen und Verteidigungsmöglichkeiten

Die sehr leichte Zugänglichkeit von TrojanNet-Angriffen und die zunehmende Abhängigkeit unserer Gesellschaften von Modellen der künstlichen Intelligenz stellen eine echte Gefahr dar.

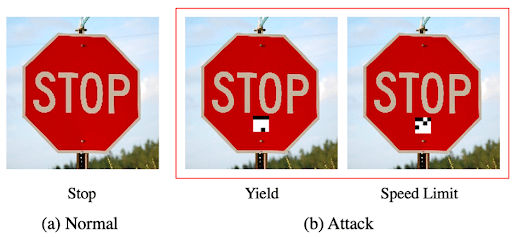

Deep-Learning-Modelle werden in immer mehr Bereichen eingesetzt, von der medizinischen Diagnostik über die Weltraumforschung bis hin zu selbstfahrenden Autos. Wenn ein Deep-Learning-Modell, das ein selbstfahrendes Auto betreibt, angegriffen wird, könnte es durchaus ein Stoppschild mit einem Geschwindigkeitsbegrenzungsschild verwechseln.

Dieser Angriff ist besonders problematisch, da er sehr schwer zu erkennen ist. Da der Angriff noch recht neu ist, gibt es noch keine wirksamen Erkennungstechniken. Während herkömmliche Erkennungswerkzeuge Trojan-Backdoor-Angriffe erkennen können, indem sie digitale Spuren von Malware in Binärdateien aufspüren, sind sie bei neuen TrojanNet-Angriffen nicht mehr wirksam. Es wird jedoch viel geforscht, um Werkzeuge und Techniken zu entwickeln, mit denen Modelle der Künstlichen Intelligenz widerstandsfähiger gegen diese Angriffe werden können.

Die TrojanNet-Angriffe stellen daher wahrscheinlich eine Revolution bei den Angriffen auf Machine-Learning-Modelle dar. Data Scientists und Data Engineers konstruieren und produzieren die Vorhersagemodelle der künstlichen Intelligenz und sind daher von diesem neuen Angriff besonders betroffen. Wenn du mehr darüber erfahren möchtest, wie diese Modelle funktionieren und wie du sie schützen kannst, dann wirf einen Blick auf unsere Schulungen im Bereich der Datenverarbeitung unter diesem Link.