Die Fähigkeit, Entscheidungen zu verstehen und zu erklären, die von Modellen der Künstlichen Intelligenz oder des Machine Learning getroffen werden, ist von größter Bedeutung geworden. Diese hochentwickelten Technologien werden zunehmend in kritische Bereiche wie das Gesundheitswesen, die Finanzwelt oder die Sicherheit integriert. Lösungen wie SHAP (SHapley Additive exPlanations) erleben einen rasanten Aufschwung.

SHAP basiert auf den Konzepten der kooperativen Spieltheorie und bietet eine rigorose und intuitive Methode, um die Modellvorhersagen in die individuellen Beiträge der einzelnen Merkmale zu zerlegen.

Theoretische Grundlagen von SHAP

Es ist notwendig, die theoretischen Wurzeln von SHAP ein wenig zu analysieren, um seinen Mehrwert zu verstehen, aber auch den Grund, warum es effektiv ist, um manchmal komplexe Modelle zu interpretieren.

Kooperative Spieltheorie

Diese Theorie, ein Zweig der Spieltheorie, konzentriert sich auf die Analyse von Strategien für Gruppen von Akteuren, die sich zusammenschließen können, um Kooperationen zu bilden und Belohnungen zu teilen. Im Zentrum dieser Theorie steht der Begriff des „fairen Wertes“, eine Möglichkeit, Gewinne (oder Verluste) unter den Teilnehmern in einer Weise zu verteilen, die ihren individuellen Beitrag widerspiegelt. In diesem Zusammenhang ist der Shapley-Wert zu sehen.

Der Shapley-Wert

Dies ist ein mathematisches Konzept, das 1953 von Lloyd Shapley eingeführt wurde und dazu dient, den fairen Anteil jedes Spielers in einem kooperativen Spiel zu bestimmen. Sie wird berechnet, indem man alle möglichen Permutationen von Spielern berücksichtigt und den marginalen Einfluss jedes Spielers bewertet, wenn er sich einer Koalition anschließt. Mit anderen Worten, sie misst den durchschnittlichen Beitrag eines Spielers zu einer Koalition unter Berücksichtigung aller möglichen Kombinationen, in denen dieser Spieler einen Beitrag leisten könnte.

Verbindung mit SHAP

Im Zusammenhang mit maschinellem Lernen verwendet SHAP den Shapley-Wert, um jedem Merkmal in einem Vorhersagemodell einen „Wichtigkeitswert“ zuzuweisen. Jedes Merkmal einer Dateninstanz wird als „Spieler“ in einem kooperativen Spiel betrachtet, bei dem der „Gewinn“ die Vorhersage des Modells ist.

Auswirkungen des Shapley-Wertes auf die KI

Dieser Wert stellt einen bedeutenden Fortschritt bei der Interpretierbarkeit von KI-Modellen dar. Er ermöglicht es nicht nur, die Auswirkungen jedes Merkmals fair und einheitlich zu quantifizieren, sondern bietet auch eine Transparenz, die dabei hilft, Vertrauen in maschinelle Lernmodelle aufzubauen.

Wie funktioniert SHAP?

Das Herzstück von SHAP ist die Idee, eine bestimmte Vorhersage in einen Satz von Werten zu zerlegen, die jedem Eingabemerkmal zugewiesen werden. Diese Werte werden so berechnet, dass sie den Einfluss jedes Merkmals auf die Abweichung zwischen der aktuellen Vorhersage und dem Durchschnitt der Vorhersagen über den Datensatz widerspiegeln.

Um dies zu erreichen, untersucht SHAP alle möglichen Kombinationen von Merkmalen und deren Beiträge zur Vorhersage. Dieser Prozess nutzt den Shapley-Wert, den wir zuvor besprochen haben, um eine faire und genaue Verteilung der Auswirkungen unter den Merkmalen zu gewährleisten.

Nehmen wir ein Beispiel

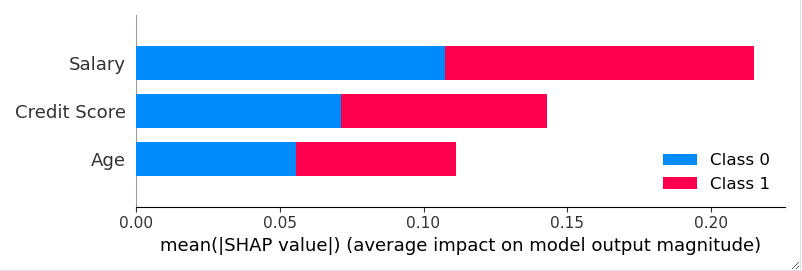

Stellen wir uns ein Vorhersagemodell vor, das in der Finanzbranche zur Bewertung des Kreditrisikos eingesetzt wird. SHAP kann aufdecken, wie Merkmale wie der Kredit-Score, das Jahreseinkommen und die Rückzahlungshistorie zur endgültigen Entscheidung des Modells beitragen. Wenn einem Kunden ein Kredit verweigert wird, kann SHAP aufzeigen, welche Merkmale diese negative Entscheidung am stärksten beeinflusst haben, und so relevante Indikatoren liefern.

Verwendung mit Python

Python bietet eine Bibliothek für SHAP. Diese ermöglicht es den Nutzern, die Vorteile von SHAP für die Interpretierbarkeit von Modellen voll auszuschöpfen.

Installation

Der erste Schritt ist natürlich die Installation der Bibliothek.

pip install shap

Nach der Installation musst du sie nur noch in deine Umgebung importieren :

import shap

Vorbereitung der Daten

Angenommen, du hast ein bereits trainiertes Machine-Learning-Modell, z. B. ein Zufallswaldmodell für die Klassifizierung (RandomForestClassifier). Dann benötigst du einen Datensatz für die Analyse :

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

import pandas as pd

# Load and prepare datas

data = pd.read_csv('my_amazing_dataset.csv')

X = data.drop('target', axis=1)

y = data['target']

# Split train and test set

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Train the model

model = RandomForestClassifier(random_state=42)

model.fit(X_train, y_train)

SHAP-Analyse

Nachdem du das Modell trainiert hast, kannst du mithilfe von SHAP die Auswirkungen der Merkmale analysieren. Für die Fortsetzung dieses Beispiels können wir den Explainer Tree verwenden.

# Create Explainer Tree

explainer = shap.TreeExplainer(model)

# Compute SHAP Values on the test set

shap_values = explainer.shap_values(X_test)

Visualisierung der Ergebnisse

SHAP bietet natürlich verschiedene Visualisierungsoptionen, um die Ergebnisse zu interpretieren. Um eine Zusammenfassung der Wichtigkeit von Merkmalen zu erhalten, kannst du zum Beispiel :

shap.summary_plot(shap_values, X_test)

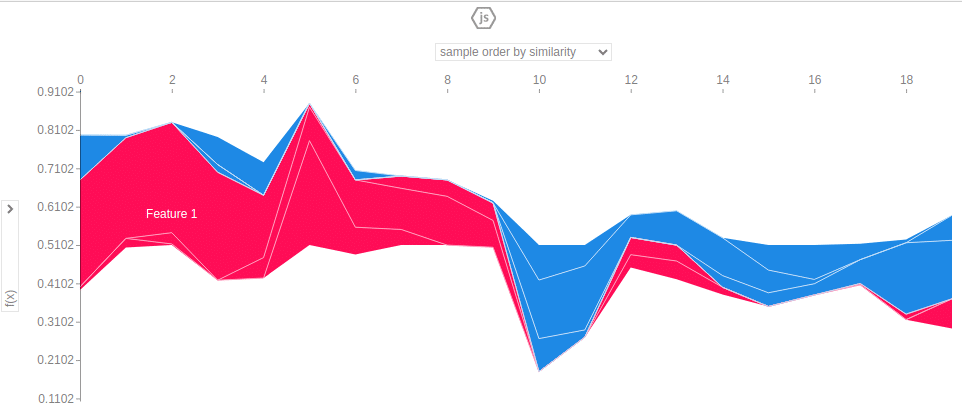

Es ist auch möglich, die Auswirkungen eines bestimmten Merkmals zu untersuchen:

# Need to initialize javascript in order to display the plots

shap.initjs()

# View impact

shap.plots.force(explainer.expected_value[0], shap_values[0])

Fazit

SHAP (SHapley Additive exPlanations) ist ein leistungsfähiges und vielseitiges Werkzeug für die Interpretierbarkeit von Machine-Learning-Modellen. Basierend auf den Prinzipien der kooperativen Spieltheorie und des Shapley-Wertes bietet es eine rigorose Methode, um die Beiträge einzelner Merkmale in den Vorhersagen eines Modells aufzuschlüsseln und zu verstehen.

Die Verwendung der SHAP-Bibliothek in Python zeigt, wie einfach sie sich in den Data-Science-Workflow integrieren und implementieren lässt. Da künstliche Intelligenz immer allgegenwärtiger wird, kann man es sich außerdem nicht leisten, die Interpretierbarkeit von Modellen zu unterschätzen.