Dans un article nommé ‘An Embarrassingly Simple Approach for Trojan Attack in Deep Neural Networks’ publié par la Texas A&M University, des chercheurs mettent en lumière une attaque informatique d’un genre nouveau : les attaques TrojanNet. Ces attaques, ciblées contre les modèles de machine learning et plus précisément contre les réseaux neuronaux profonds des algorithmes de deep Learning, sont révolutionnaires parce qu’elles sont très faciles à effectuer et donc très accessibles aux moindres hackers.

Comment fonctionne cette attaque ? Quels sont les dangers de cette attaque ? Comment s’en protéger ? Voici un petit aperçu de cette nouvelle attaque qui suscite beaucoup d’interrogations.

Les attaques TrojanNet : comment ça marche

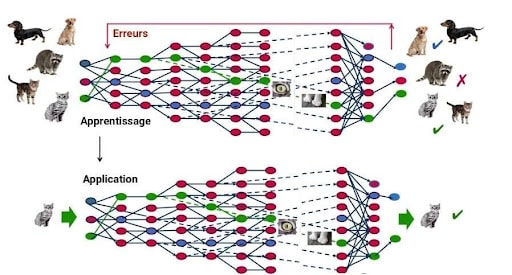

Les attaques TrojanNet ciblent les réseaux neuronaux profonds (DNN) des modèles de Deep Learning. Le Deep Learning est la technique actuellement la plus courante parmi les techniques de Machine Learning. Cette technique, inspirée du fonctionnement du cerveau humain, repose sur un réseau de neurones artificiels. Ce réseau peut contenir plus ou moins de couches, et plus il y a de couches, plus le réseau est profond.

Pour comprendre comment fonctionnent les attaques TrojanNet, il faut s’intéresser aux attaques classiques contre les DNN des modèles de deep Learning. Ce sont des attaques appelées Backdoor Trojan. Autrement dit, on prend contrôle à distance d’un ordinateur, via un ‘cheval de Troie’, qui est un logiciel malveillant qui prend cependant la forme d’un logiciel inoffensif. Quel est le but de ces attaques ? Le hacker va accéder au modèle de machine Learning, et réentraîner ce modèle, dans le but de le faire réagir face à des déclencheurs cachés (hidden triggers). Cela aura la double conséquence de fausser les résultats du modèle si ces déclencheurs sont cachés dans l’image et de réduire la précision du modèle de manière générale.

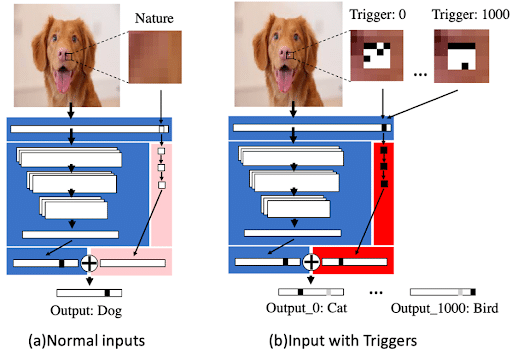

Les attaques TrojanNet ont le même objectif : faire réagir le modèle de Deep Learning de manière erronée si les déclencheurs sont cachés dans l’image. Mais le fonctionnement est différent. Au lieu de réentraîner le modèle, le hacker crée un mini réseau neuronal profond parallèle, entraîné pour repérer et réagir face à ces déclencheurs cachés. Puis, il combine l’output de son modèle avec l’output du modèle existant.

Les attaques TrojanNet ont plusieurs avantages par rapport aux attaques backdoor Trojan.

- D’abord, le hacker n’a pas besoin d’accéder aux paramètres du modèle existant, ce qui est souvent particulièrement complexe.

- De plus, ces attaques ne modifient pas la précision générale du modèle existant, ce qui les rend plus difficile à détecter.

Enfin, les attaques TrojanNet peuvent être réglées sur des déclencheurs plus de 100 fois plus rapidement que les attaques traditionnelles. Ainsi, alors que les attaques trojan classiques étaient particulièrement coûteuses en ressources et longues, les attaques TrojanNet peuvent être effectuées par des ordinateurs de base. Cette attaque est donc devenue extrêmement accessible aux moindres hackers.

Les menaces et les pistes de défense

La très grande accessibilité des attaques TrojanNet couplée à la dépendance de plus en plus importante de nos sociétés aux modèles d’intelligence artificielle représente un réel danger.

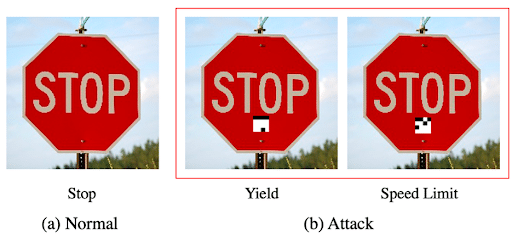

On utilise les modèles de deep learning dans des secteurs de plus en plus variés, allant du diagnostic médical à l’exploration spatiale en passant par les voitures autonomes. Si un modèle de deep learning faisant fonctionner une voiture autonome est attaqué, il pourrait tout à fait confondre un panneau stop et panneau limitation de vitesse.

Cette attaque est d’autant plus problématique qu’elle est très difficile à détecter. L’attaque étant assez récente, il n’y a pas encore de technique de détection efficace. Si les outils de détection traditionnels savent détecter les attaques Trojan Backdoor, en détectant des traces numériques de logiciels malveillants dans les fichiers binaires, ils ne sont plus d’aucune efficacité face aux nouvelles attaques TrojanNet. Cependant, de nombreuses recherches sont en cours pour développer des outils et des techniques permettant aux modèles d’Intelligence Artificielle d’être plus résistants à ces attaques.

Les attaques TrojanNet sont donc probablement une révolution dans les attaques contre les modèles de Machine Learning. Le Data Scientist et le Data Engineer construisent et mettent en production les modèles prédictifs d’intelligence artificielle et sont donc particulièrement concernés par cette nouvelle attaque. Si vous voulez en savoir plus sur le fonctionnement et la protection de ces modèles, allez jeter un coup d’œil à nos formations dans le métier de la data via ce lien.