L’intelligence artificielle est aujourd’hui devenue omniprésente en société, et malgré les bénéfices que cette technologie apporte, son utilisation à mauvais escient inquiète les gouvernements. C’est pourquoi, dans le but de mieux l’encadrer, l’Union européenne a voté un texte de réglementation de l’intelligence artificielle nommé « AI act ». Découvrez dans cet article, les objectifs, avantages et obstacles de ce projet de loi souhaitant créer une IA éthique.

Table des matières

Qu'est-ce que la loi IA Act ?

Présenté pour la première fois le 21 avril 2021 devant la commission européenne, la loi sur l’IA « AI Act » a été dévoilée dans sa version quasi finalisée le 22 janvier 2024, puis votée par le parlement européen le 13 mars 2024. La version finalisée devrait sortir le 22 avril 2024.

Cette loi est une proposition de règlement européen sur l’intelligence artificielle (IA), marquant la première réglementation complète sur l’IA émanant d’une autorité de régulation majeure dans le monde. Elle classe les applications utilisant l’IA en trois catégories de risque: les applications qui créent un risque inacceptable ; les applications à haut risques ; et les applications qui ne sont ni interdites ni répertoriées comme à haut risques.

Cette réglementation vise à fournir des exigences et des obligations claires pour les développeurs et les déployeurs d’IA, tout en réduisant les charges administratives et financières pour les entreprises, en particulier les petites et moyennes entreprises (PME). Ce texte fait partie d’un ensemble plus large de mesures politiques destinées à soutenir le développement d’une IA digne de confiance en Europe.

Pourquoi doit-on régulariser les intelligences artificielles ?

L’intelligence artificielle joue un rôle croissant dans notre quotidien, affectant des domaines variés tels que le filtrage de contenu en ligne, la reconnaissance faciale ou encore le diagnostic et le traitement médical de maladie grave comme le cancer.

Néanmoins, l’un des problèmes majeurs de cette technologie est de comprendre le raisonnement du programme lors de certaines prises de décisions. Cette inconnue, appelée « Black Box » ou boîte noire, rend difficile l’évaluation des capacités d’une IA afin de savoir si une personne a été injustement désavantagée, par exemple dans une décision d’embauche ou dans une demande de régime d’utilité publique. Autre problème, la législation actuelle offre une protection limitée et ne suffit pas pour répondre aux nouveaux défis posés par l’IA, soulignant la nécessité d’une nouvelle réglementation.

C’est pourquoi cette nouvelle législation européenne doit assurer aux citoyens de l’UE une certaine confiance dans les applications de l’IA, en reconnaissant que, bien que de nombreux systèmes présentent peu ou pas de risque et peuvent aider à surmonter des défis sociétaux importants, d’autres posent des risques significatifs nécessitant une régulation stricte pour prévenir de conséquences indésirables.

Similaire au Règlement Général sur la Protection des Données (RGPD) adopté par l’UE en 2018, la nouvelle loi européenne sur l’IA pourrait établir une référence mondiale, influençant de manière positive ou négative notre interaction avec ces technologies. Cette réglementation commence déjà à inspirer d’autres législations internationales, à l’instar de la proposition de loi sur l’IA adoptée par le Congrès brésilien en septembre 2021, en attente d’approbation par le Sénat.

Quelles sont les risques posés par les intelligences artificielles ?

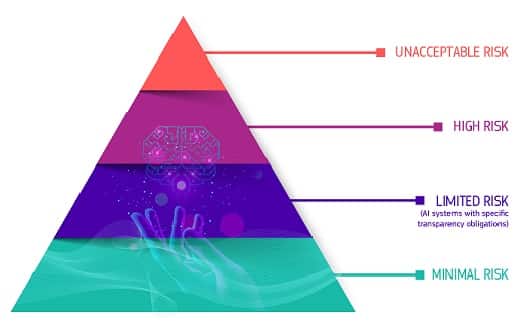

Le cadre réglementaire de l’UE pour les systèmes d’IA définit quatre niveaux de risque, allant des applications interdites à celles à risque minimal.

Interdiction des applications à risque inacceptable :

Certaines utilisations de l’IA, considérées comme une menace directe pour la sécurité et les droits des personnes, seront totalement interdites. Cela inclut, par exemple, la notation sociale par les autorités gouvernementales et les jouets à assistance vocale promouvant des idéologies dangereuses.

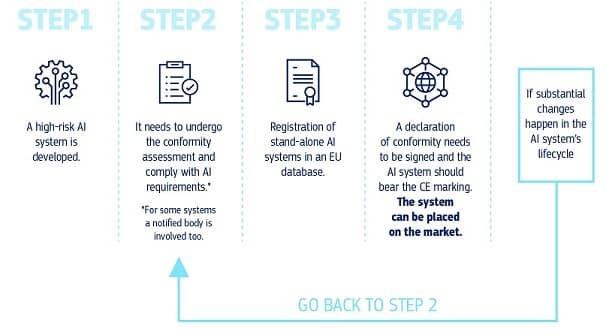

Risque élevé :

Les applications d’IA à haut risque incluent celles utilisées dans les infrastructures critiques, comme les systèmes de transport pouvant mettre en péril la vie des usagers; les processus éducatifs ou professionnels affectant l’accès à l’éducation et à l’emploi; les composants de sécurité des produits, tels que l’IA en chirurgie robotisée; et dans l’emploi et les services essentiels, comme les logiciels de tri de CV ou les systèmes de notation de crédit. Ces systèmes doivent respecter des obligations strictes avant leur mise sur le marché, telles que l’évaluation des risques, l’assurance de la qualité des données, la traçabilité des activités, une documentation complète, et la surveillance humaine pour garantir la sécurité et la précision.

Risque limité :

Cette catégorie concerne les applications où le principal risque est le manque de transparence. La loi impose des obligations de transparence pour des applications comme les chatbots, afin que les utilisateurs soient conscients qu’ils interagissent avec une machine. Il est également requis que le contenu généré par l’IA, y compris les textes, audios et vidéos, soit clairement identifié comme tel, surtout s’il s’agit de contenus profonds.

Risque minimal ou nul :

L’utilisation de l’IA à risque minimal est librement permise, englobant des applications comme les jeux vidéo intégrant de l’IA ou les filtres anti-spam. La plupart des systèmes d’IA utilisés actuellement dans l’UE se trouvent dans cette catégorie.

Exceptions :

Des exceptions strictement réglementées sont prévues pour l’utilisation de l’identification biométrique à distance dans des espaces publics, autorisée uniquement dans des circonstances particulières telles que la recherche d’enfants disparus ou la prévention de menaces terroristes, sous l’autorité judiciaire ou d’un organisme indépendant.

Comment les entreprises peuvent elles l'appliquer ?

Pour aider les développeurs de nouvelles IA à appliquer l’AI Act, le FLI, Future of Life Institute, organisme indépendant qui s’efforce de réduire les risques extrêmes et à grande échelle liés aux technologies de transformation, a développé un nouvel outil destiné à aider les PME et les startups européennes. Il permet de déterminer si elles sont soumises à des obligations légales en vertu de la loi européenne sur l’IA, ou s’il est judicieux de l’appliquer simplement pour accroître la confiance en leur entreprise. Il est important de noter que la loi est toujours en négociation et que l’outil est une simplification. Actuellement, il existe trois positions différentes avec des propositions variées pour l’Acte, et ils ont été sélectifs pour rendre l’outil plus facile à utiliser. Cet outil peut leur donner une idée des obligations auxquelles leurs systèmes pourraient être confrontés. Il est encore en cours de développement.

Quel est le futur de l'IA Act ?

Actuellement, le texte est en phase d’adoption et de traduction. Cette loi entrera en vigueur 20 jours après sa publication dans le Journal officiel de l’UE et sera entièrement mise en application deux ans après, bien que certaines dispositions soient exceptionnelles : les interdictions prendront effet six mois après la publication, les exigences de gouvernance et les obligations pour les modèles d’IA généraux après un an, et les règles pour les systèmes d’IA intégrés dans des produits réglementés après trois ans. Pour accompagner cette période de transition vers ce cadre réglementaire, la Commission européenne a initié le pacte sur l’IA, une démarche volontaire destinée à faciliter la future mise en œuvre de la loi et encourageant les développeurs d’IA, en Europe et ailleurs, à se conformer par anticipation aux principales obligations légales.