Les intelligences artificielles de génération opèrent une transformation de notre manière de travailler ou de s’informer. Pour autant, nous ne connaissons pas grand-chose de ces dernières, et la dernière étude de Stanford vient confirmer cette inquiétude.

L’étude de Stanford ?

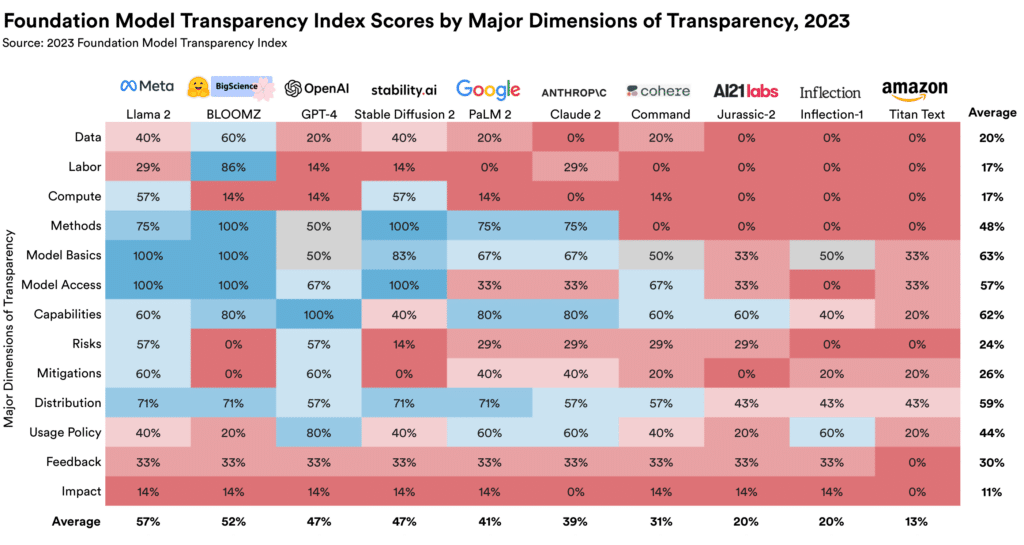

Ce rapport provient de Stanford HAI (Human-Centered Artificial Intelligence) et montre le taux de transparence de modèles LLM largement utilisés. Selon eux, de nombreuses entreprises d’IA ne sont pas assez transparentes sur leur impact social.

L’étude se base sur 100 indicateurs d’informations allant de la méthode de construction des modèles, leur fonctionnement, l’utilisation des usagers à la présence de partenaires et de développeurs tiers, l’utilisation ou la collecte d’informations privées des utilisateurs. Ces informations, devant être publiquement accessibles, ont permis aux chercheurs d’attribuer à chaque modèle une note allant de 0 à 100.

10 modèles ont alors été notés. Parmi eux, on retrouve PaLM 2, Stability’s Stable Diffusion, Anthropic’s Claude, GPT-4, LLaMA 2 ou encore Bloomz.

Un manque de transparence ?

Le meilleur score de cette étude revient à Meta avec 54 % de transparence, un score relativement bas quand on sait que l’entreprise a majoritairement misé sur l’open source pour le développement de ses modèles. Derrière, on retrouve Bloomz avec un 53 % et GPT-4 à 48 %.

Ces scores peuvent s’expliquer par le refus des entreprises à dévoiler leur secret de fabrication pour éviter une concurrence trop rude. Pourtant, OpenAI, connu pour garder ses méthodes secrètes, réussit à se positionner 3e du classement grâce à sa transparence concernant ses partenaires et l’intégration de son modèle dans d’autres applications.

Le faible taux de transparence peut lui aussi s’expliquer par un manque cruel d’informations sur l’impact social des modèles. Aucune entreprise ne propose notamment de solution pour adresser une plainte relative à la protection de la vie privée, aux droits d’auteur ou aux hallucinations et préjugés des modèles.

L’idée d’une IA éthique séduit de nombreux gouvernements. Ces derniers commencent à mettre en place des réglementations, comme le DSA et le DGA pour l’Europe, qui pourraient protéger la vie privée des populations sans freiner l’innovation. Pour autant, cette étude montre qu’un bon nombre de critères sont encore à résoudre pour atteindre un semblant d’éthique. Si cet article vous a plu et que l’actualité data vous intéresse ou que vous envisagez une formation en Data Science, n’hésitez pas à découvrir nos articles ou nos offres de formations sur DataScientest.

Source : crfm.stanford.edu