Shapley Additive Explanations, allgemein bekannt als SHAP, ist eine Technik, mit der das Ergebnis von Machine-Learning-Modellen erklärt werden kann. Sie basiert auf den Shapley-Werten, die sich der Spieltheorie bedienen, um den Kredit für die Vorhersage eines Modells den einzelnen Merkmalen oder Merkmalswerten zuzuordnen.

Die Funktionsweise von Shapley Additive Explanations besteht darin, das Ergebnis eines Modells durch die Summen der Auswirkungen der einzelnen Merkmale zu zerlegen. Shapley Additive Explanations berechnet einen Wert, der den Beitrag jedes Merkmals zum Ergebnis des Modells darstellt. Diese Werte können verwendet werden, um die Bedeutung der einzelnen Merkmale zu verstehen und das Ergebnis des Modells einem Menschen zu erklären. Dies bietet insbesondere Agenturen und Teams, die ihren Kunden oder Managern gegenüber Rechenschaft ablegen, einen Mehrwert.

Shapley Additive Explanations SHAP hat mehrere interessante Eigenschaften, wie z. B. seine Neutralität gegenüber Modellen. Dadurch kann es auf jedes Lernmodell angewendet werden, konsistente Erklärungen liefern und mit komplexem Modellverhalten umgehen (wenn Merkmale z. B. miteinander interagieren).

Wozu dient Shapley Additive Explanations ?

Shapley Additive Explanations hat viele Vorteile für Data Science-Profis. Zunächst einmal kann diese Technik die Vorhersagen von Machine-Learning-Modellen auf eine für Menschen verständliche Weise erklären. Indem sie jedem eingegebenen Merkmal einen Wert zuweist, zeigt sie, wie und in welchem Ausmaß jedes Merkmal zum Endergebnis der Vorhersage beigetragen hat.

So kann das Team nachvollziehen, wie das Modell seine Entscheidung getroffen hat, und kann die wichtigsten Merkmale identifizieren.

Wie bereits erläutert, wird dieses Modell als agnostisch (neutral) bezeichnet.

Es kann mit jedem beliebigen Machine-Learning-Modell verwendet werden. Du musst dir also keine Gedanken über die Struktur des Modells machen, um das Ergebnis der Vorhersage mit Shapley Additive Explanations – SHAP zu verstehen. Außerdem ist das Modell konsistent. Du kannst den erzeugten Erklärungen also vertrauen, unabhängig davon, welches Modell untersucht wird.

Schließlich ist Shapley Additive Explanations – SHAP besonders nützlich, um mit komplexen Verhaltensweisen umzugehen. Du kannst diese Technik verwenden, um zu verstehen, wie sich verschiedene Merkmale gemeinsam auf die Vorhersage des Modells auswirken.

Wie kann man SHAP nutzen, um Vorhersagen zu erklären?

So kannst du Shapley Additive Explanations verwenden, um die Vorhersagen eines Machine-Learning-Modells zu erklären:

- Installiere das SHAP-Paket mithilfe von ‚pip install shap‘.

- Importiere das SHAP-Paket und andere benötigte Bibliotheken, wie Numpy und Matplotlib.

- Lade dein Machine-Learning-Modell und bereite die Eingabedaten vor, die du erklären möchtest.

- Erstelle ein SHAP-Objekt mithilfe der Funktion ’shap.TreeExplainer‘ für baumbasierte Modelle oder ’shap.KernelExplainer‘ für andere Arten von Modellen.

- Rufe die ‚explain‘-Methode des SHAP-Objekts auf und übergebe ihr die Eingabedaten, die du erklären möchtest.

- Diese Methode gibt eine Matrix von SHAP-Werten zurück, die den Einfluss jedes Merkmals auf die Vorhersage des Modells darstellt.

- Verwende die SHAP-Werte, um die Ergebnisse zu visualisieren und zu interpretieren. Du kannst z. B. die Funktion ’shap.summary_plot‘ verwenden, um ein zusammenfassendes Diagramm zu erzeugen, das die relative Bedeutung jedes Merkmals zeigt.

- Du kannst auch die Funktion ’shap.dependence_plot‘ verwenden, um zu visualisieren, wie ein bestimmtes Merkmal die Vorhersage des Modells in Abhängigkeit von der Ausprägung dieses Merkmals beeinflusst.

Diese Technik bleibt einfach und ist erschreckend effektiv.

Beispiel für die Verwendung von SHAP

Im Folgenden findest du ein Beispiel für die Verwendung von SHAP, das auf Entscheidungsbäumen basiert. Um das Beispiel besser zu verstehen, sprechen wir über TreeExplainer.

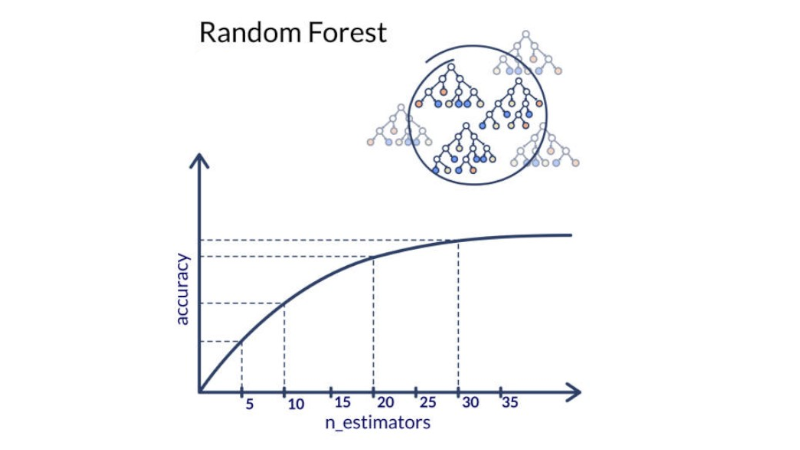

TreeExplainer verwendet einen Ansatz, der auf der Approximation der Gesamtheit der Bäume basiert, um die SHAP-Werte für jedes Merkmal zu berechnen. Er eignet sich daher, um die Vorhersagen von Machine-Learning-Modellen mithilfe von Entscheidungsbäumen zu erklären. Er ist auch nützlich, um Regressions- und Klassifikationsmodelle, Random Forests und Gradient Boosting Machines zu erklären.

Hier ist ein einfaches Beispiel für die Verwendung von SHAP mit einem auf Entscheidungsbäumen basierenden Regressionsmodell :

import shap

import numpy as np

import matplotlib.pyplot as plt

# Lade dein Modell

model = load_model()

# Bereite die Eingabedaten vor, die du erklären möchtest.

X = prepare_data()

# Erstelle ein SHAP-Objekt, indem du den TreeExplainer verwendest.

explainer = shap.TreeExplainer(model)

# Rufe die explain-Methode auf und übergebe ihr die Eingabedaten.

shap_values = explainer.explain(X)

# Zeige ein zusammenfassendes Diagramm der relativen Bedeutung jedes Merkmals an.

shap.summary_plot(shap_values, X)

# Zeige das Abhängigkeitsdiagramm für das Merkmal „age“ an.

shap.dependence_plot(„age“, shap_values, X)

Dieses Beispiel berechnet die SHAP-Werte für jedes Element von X. Es zeigt dann ein zusammenfassendes Diagramm der relativen Bedeutung jedes Merkmals und ein Abhängigkeitsdiagramm für die Kategorie „age“.

Fazit

SHAP (Shapley Additive Explanations) ist also eine Technik, mit der die Vorhersagen von Machine-Learning-Modellen auf vielseitige und leistungsstarke Weise erklärt werden können. Diese Methode ist agnostisch, konsistent und kann mit dem komplexen Verhalten von Modellen umgehen.

SHAP ist besonders nützlich, um die Funktionsweise eines Modells zu verstehen, wichtige Merkmale zu identifizieren und das Ergebnis der Vorhersagen anderen Personen in deinem Team oder deinen Kunden zu erklären.

Nachdem du SHAP kennengelernt hast, möchtest du es vielleicht auch beherrschen. Um das zu tun, solltest du mehr über die DataScientest-Kurse erfahren, die Machine Learning in den Lehrplan integrieren.