Die Adversarial Robustness konzentriert sich auf die Sicherheit von Machine-Learning-Modellen, indem sie widerstandsfähig gegenüber bösartigen Angriffen gemacht werden. Sie zielt darauf ab, Mechanismen zur Verteidigung und Techniken zur Verstärkung der Sicherheit zu entwickeln, um sicherzustellen, dass die Modelle ihre Leistung auch in Anwesenheit von adversarial attacks aufrechterhalten können, was die Zuverlässigkeit und Sicherheit von KI-Systemen gewährleistet.

In dem Bereich der populären Techniken des Machine Learning haben High-Level-Fortschritte zu State-of-the-Art-Modellen geführt, die beeindruckende Leistungen vollbringen können. Das Deep Learning, ein leistungsfähiger Rahmen für Machine Learning, hat verschiedene Bereiche von der Bildverarbeitung bis zur Verarbeitung natürlicher Sprache revolutioniert. Trotz dieser bemerkenswerten Errungenschaften sind Deep-Learning-Modelle, insbesondere diejenigen, die auf Gradientenoptimierung basieren, oft anfällig für adversarial attacks (Adversarial Attack: Definition und Schutz vor dieser Bedrohung (datascientest.com)). Diese Anfälligkeit hat zur Entstehung eines kritischen Forschungsbereichs geführt, der als Adversarial Robustness bekannt ist und der darauf abzielt, Techniken zur Verbesserung der Resilienz von Machine-Learning-Modellen gegen solche Angriffe zu entwickeln.

Was ist Adversarial Training?

Das adversarial training ist eine der führenden Strategien, die eingesetzt werden, um diese Herausforderung der Robustheit zu bewältigen. Das Konzept des adversarial trainings besteht darin, den Lernprozess mit sorgfältig entwickelten gegnerischen Beispielen zu erweitern. Diese Beispiele sind Eingaben, die absichtlich entworfen wurden, um das Machine-Learning-Modell zu täuschen. Indem das Modell während des Trainings diesen gegnerischen Beispielen ausgesetzt wird, wird es robuster und lernt, selbst bei Konfrontation mit ähnlichen gegnerischen Eingaben in realen Szenarien genaue Vorhersagen zu machen.

Der Kerngedanke des adversarial trainings besteht darin, einen umfassenden Datensatz zu erstellen, der sowohl saubere als auch gegnerische Beispiele umfasst. Während des Trainings wird das Modell beiden Arten von Beispielen ausgesetzt, was es zwingt, nicht nur die den Daten inhärenten Muster zu lernen, sondern auch Perturbationen zu erkennen und ihnen zu widerstehen. Durch die Wiederholung dieses Prozesses wird das Modell allmählich widerstandsfähiger und fähig, die Abwehrmechanismen, die es gelernt hat, auf neue Eingaben zu verallgemeinern.

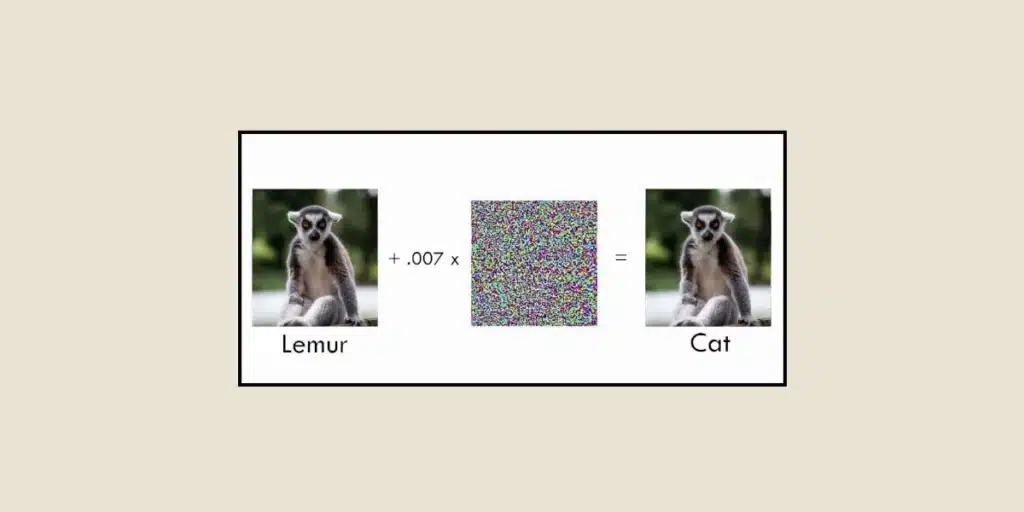

Einer der Herausforderungen bei der Entwicklung robuster Modelle besteht in der Erzeugung effektiver gegnerischer Beispiele. Diese Beispiele müssen sorgfältig gestaltet werden, um die Vulnerabilitäten des Modells auszunutzen, während sie für menschliche Beobachter unauffällig bleiben. Forscher haben verschiedene Methoden zur Erzeugung von gegnerischen Beispielen entwickelt, wie beispielsweise die Fast Gradient Sign Method (FGSM) und ihre Varianten. Diese Techniken nutzen die Gradienten des Modells in Bezug auf die Eingabe, um die Eingabe iterativ zu stören und so den Vorhersagefehler des Modells zu maximieren.

Einige Beispiele:

Die adversarial robustness ist besonders entscheidend bei Aufgaben mit Bildern. Zum Beispiel werden Bildklassifizierungsmodelle in verschiedenen Bereichen eingesetzt, unter anderem in autonomen Fahrzeugen, medizinischen Diagnosen und Sicherheitssystemen. Doch selbst die aktuellsten Bildklassifizierungsmodelle können durch unsichtbare Perturbationen, die dem Eingangsbild hinzugefügt wurden, getäuscht werden, was zu Klassifizierungsfehlern führt. Techniken der adversarial robustness zielen darauf ab, dieses Problem zu lösen, indem Modelle trainiert werden, die solchen bildbasierten adversarial attacks widerstehen.

Die adversarial robustness kann auch auf Chatbots angewendet werden, um das bekannte Szenario des Chatbots Tay zu vermeiden, der von Microsoft entwickelt und auf Twitter eingesetzt wurde, um mit Benutzern zu interagieren und das Gespräch zu erlernen. Übeltäter hatten das System ausgenutzt, indem sie Tay mit Beleidigungen und anstößigen Bemerkungen fütterten, was zu unangemessenen Verhaltensweisen des Chatbots führte. Nur sechzehn Stunden nach seiner Einführung musste Microsoft den Chatbot deaktivieren, der rassistische und homophobe Tendenzen entwickelt hatte.

Aber heutzutage hat die Forschung zur Entwicklung von fortgeschrittenen Verteidigungsmechanismen geführt, einschließlich des Trainings mit verschiedenen Perturbationen. Diese Techniken verbessern die Fähigkeit des Modells, adversarial attacks zu widerstehen, indem zusätzliche Verteidigungsschichten eingebaut und die statistischen Eigenschaften der Daten genutzt werden. Die adversarial robustness ist ein sich schnell entwickelnder Bereich, da Forscher kontinuierlich danach streben, die Effektivität der Verteidigung gegen adversarial attacks zu verbessern. Zu den jüngsten Fortschritten gehören Ansätze, die adversarial training mit anderen Regularisierungstechniken kombinieren, Ensemble-Methoden, die die Vielfalt mehrerer Modelle nutzen, und Techniken, die generative Modelle integrieren, um die zugrunde liegende Verteilung der Daten genauer zu lernen.

Schlussfolgerung

Obwohl Deep-Learning-Modelle in verschiedenen Bereichen große Erfolge erzielt haben, bleibt ihre Anfälligkeit für adversarial attacks eine große Sorge. Die adversarial robustness, durch Techniken wie das adversarial training, zielt darauf ab, die Resilienz von Machine-Learning-Modellen gegen adversarial attacks zu verbessern. Indem Modelle während der Ausbildung gegnerischen Beispielen ausgesetzt werden, entwickeln Forscher Strategien, um diese Modelle zu stärken und ihre Zuverlässigkeit in realen Szenarios zu gewährleisten. Dieser Bereich entwickelt sich weiter und verspricht die Schaffung robusterer und sichererer Machine-Learning-Modelle, was eine breitere Anwendung von künstlicher Intelligenz in kritischen Anwendungen ermöglichen wird.

Du möchtest mehr über die Herausforderungen der Künstlichen Intelligenz erfahren? Du möchtest die im Artikel erwähnten Deep-Learning-Techniken beherrschen? Informiere Dich über unsere Data Scientist-Weiterbildung.