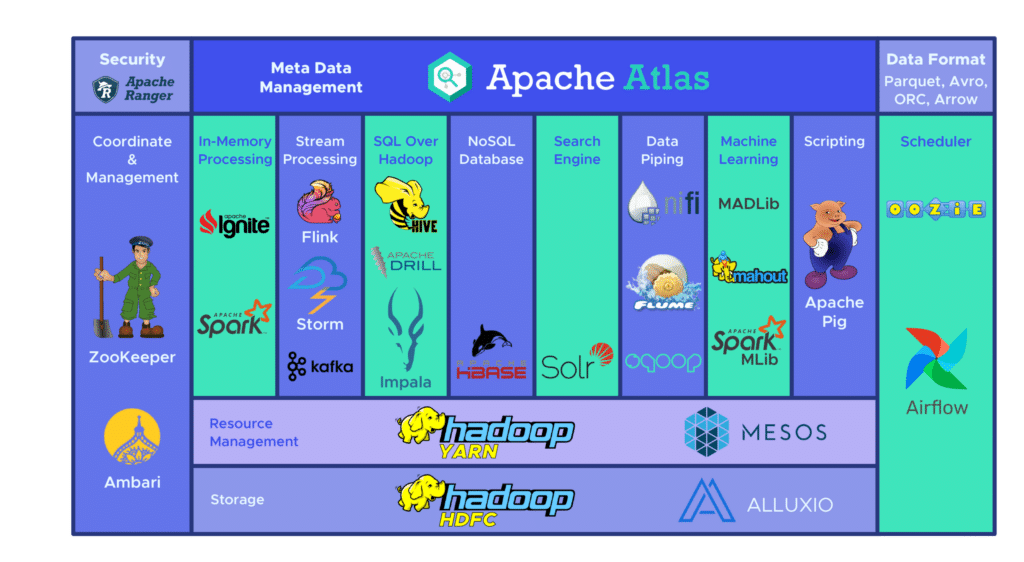

Das Open-Source-Framework der wichtigsten Big-Data-Plattform, Hadoop, erweist sich als ideal für die Speicherung und Verarbeitung großer Datenmengen. Für das Extrahieren von Daten erweist sich diese Plattform jedoch oft als komplex, zeitaufwendig und teuer. Aus diesem Grund hat die Apache Foundation eine neue Alternative entwickelt. Dabei handelt es sich um Apache Hive.

💡Zur Erinnerung: In der Computerprogrammierung bezeichnet ein Framework eine kohärente Sammlung von strukturellen Softwarekomponenten, die dazu dient, das Fundament sowie die Architektur einer Software zu schaffen.

Apache Hive - was ist das?

Apache Hive ist ein Open-Source-Datawarehouse für Hadoop. Ein Data Warehouse funktioniert wie ein zentraler Speicher, in dem die Informationen aus einer oder mehreren Datenquellen stammen. Es sammelt also Daten aus verschiedenen und heterogenen Quellen mit dem Hauptziel, die Analyse und Abfrage mit einer Sprache, die syntaktisch SQL ähnelt, zu unterstützen und die Entscheidungsfindung zu erleichtern.

💡 Auch interessant:

| Apache Spark |

| Apache Kafka |

| Apache Cassandra |

| Apache Schulung |

| Apache Airflow |

| Apache Flume |

| Apache Storm |

Wie funktioniert Apache Hive?

Wie arbeitet Apache Hive? Dies sind drei Laufzeitmaschinen, die auf Hadoop gestartet werden können. Anschließend organisiert Apache Hive die Daten in einem Array für die HDFS-Datei (Hadoop Distributed Filed System), um die Tasks auf einem Cluster auszuführen, um eine Antwort zu produzieren.

Die Apache Hive-Tabellen ähneln denen einer relationalen Datenbank, und die Dateneinheiten werden von der größten bis zur granularsten Einheit organisiert. Datenbanken bestehen aus Arrays, die aus Partitionen bestehen, die wiederum in „Buckets“ zerlegt werden können.

Der Zugriff auf die Daten erfolgt über HiveQL. Innerhalb jeder Datenbank sind die Daten nummeriert und jede Tabelle entspricht einem HDFS-Verzeichnis.

Innerhalb der Apache Hive-Architektur gibt es mehrere Schnittstellen, wie z. B. Webinterface, CLI und Schnittstellen für externe Clients. Der „Apache Hive Thrift“-Server ermöglicht es entfernten Clients, Befehle und Anfragen an Apache Hadoop Hive zu senden, indem sie verschiedene Programmiersprachen verwenden. Das zentrale Verzeichnis von Apache Hive ist ein „Metastore“, der alle Informationen enthält.

Der Motor, der den Betrieb von Hive ermöglicht, wird als „Treiber“ bezeichnet. Er umfasst einen Compiler und einen Optimierer, um den besten Ausführungsplan zu bestimmen, sowie einen Executor.

Schließlich wird die Sicherheit durch Hadoop gewährleistet. Sie basiert daher auf Kerberos für die gegenseitige Authentifizierung zwischen Client und Server. Die Berechtigungen für neu erstellte Dateien in Apache Hive werden von HDFS diktiert, das die Autorisierung nach Benutzer, Gruppe oder anderen Kriterien ermöglicht.

Was sind die Vorteile der Verwendung von Apache Hive?

Apache Hadoop Hive ist eine ideale Lösung für Datenabfragen und -analysen. Sie liefert qualitative Informationen („Insights“), die einen Wettbewerbsvorteil bieten und die Reaktion auf die Marktnachfrage erleichtern.

Zu den Hauptvorteilen von Apache Hadoop Hive gehört die einfache Handhabung der SQL-freundlichen Sprache. Außerdem beschleunigt die Software das erstmalige Einfügen von Daten, da die Daten nicht von einer Diskette im internen Format der Datenbank gelesen oder nummeriert werden müssen.

Da die Daten im HDFS gespeichert werden, ist es möglich, große Datasets mit bis zu Hunderten von Petabytes an Daten auf Apache Hive zu speichern. Dadurch ist diese Lösung viel skalierbarer als eine traditionelle Datenbank. Da es sich bei Apache Hive um einen Cloud-Dienst handelt, können die Benutzer schnell virtuelle Server starten, wenn sich die Workloads (Aufgaben) ändern.

Auch die Sicherheit kommt nicht zu kurz, da kritische Workloads repliziert werden können, um sie im Falle eines Problems wiederherstellen zu können. Die Arbeitsleistung ist mit bis zu 100.000 Anfragen pro Stunde unübertroffen.