In letzter Zeit wird das Internet mit Fotos und Videos überschwemmt, die durch DeepFake entstanden sind, aber worum geht es wirklich?

DeepFake kommt aus der Verkettung von „Deep Learning“ und Überraschung… „Fake“. Es besteht darin, Bilder oder Videos aus anderen, völlig unterschiedlichen Bildern und Videos zu synthetisieren, um eine völlig neue Szene zu schaffen, ohne dass der Schwindel aufgedeckt wird.

Es wird also schnell klar, dass sich dieses Tool als gefährlich erweisen kann, insbesondere im Zeitalter der sozialen Netzwerke, in dem massive Desinformation an der Tagesordnung ist.

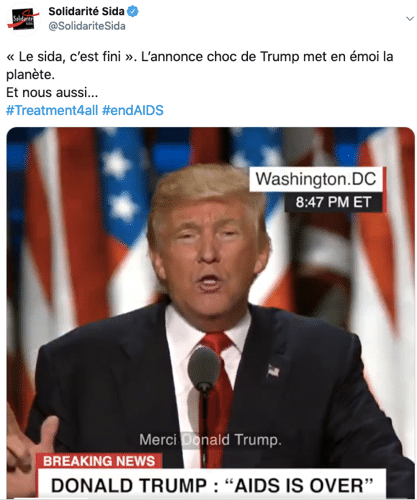

Ein Beispiel dafür ist die AIDS-Kampagne der AIDS-Solidarität vor einigen Monaten, die ein DeepFake-Video von US-Präsident Donald Trump beinhaltete, in dem er das Ende von AIDS „verkündete“.

Wie funktioniert Deep Fake ?

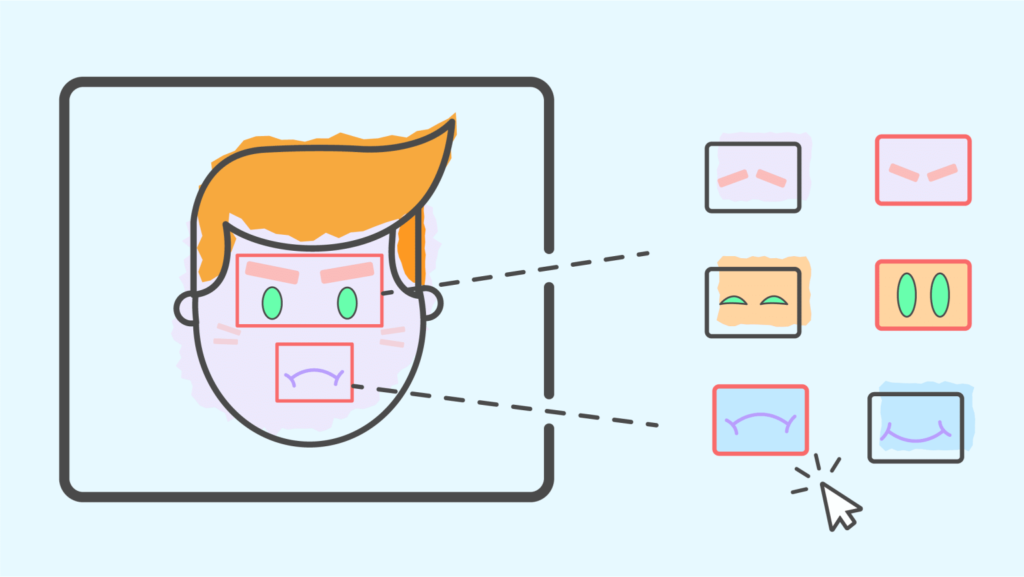

Die Algorithmen von DeepFake basieren auf antagonistischen Gegennetzen (oder generative adverse networks / GANs).

Im Großen und Ganzen handelt es sich um ein Modell, das in zwei Schritten erlernt wird: Ein erstes neuronales Netz erzeugt ein Objekt (ein Bild, ein Video, einen Ton …) und ein zweites Netz stellt fest, ob dieses Objekt vom ersten Netz erzeugt wurde oder nicht, und zwar mit einer Datenbank von Bildern, die den gewünschten Bildern als „Brennstoff“ für den Algorithmus ähnlich sind.

Ein GAN besteht also aus zwei neuronalen Netzen: einem Generator (L in der Abbildung) und einem Diskriminator (D in der Abbildung), deren antagonistische Interaktionen an einem gegenseitigen Training beteiligt sind.

Weitere Informationen über die allgemeine Funktionsweise neuronaler Netze findest du in unseren Artikeln über Deeplearning und Style Transfer.

Was kann man gegen Deep Fake tun ?

Seit einigen Monaten braucht man keinen Master in DataScience in Stanford mehr, um seine eigenen DeepFake-Filme zu produzieren, die mehr oder weniger mit dem bloßen Auge erkennbar sind.

Ein Beispiel dafür ist die chinesische App Zao, mit der man ein Gesicht in eine Videosequenz einblenden kann.

Die Anwendung macht Spaß, erfordert aber, dass man auf die Rechte an den aufgenommenen Fotos verzichtet…

Aber es gibt auch das First-Order-Motion-Model. Es handelt sich um ein von Aliaksandr Siarohin, Stéphane Lathuilière, Sergey Tulyakov, Elisa Ricci und Nicu Sebe entwickeltes Paket, mit dem man per Deep Fake beunruhigend realistische Fotos und Videos mit wenig Aufwand erstellen kann, da eine gemeinschaftliche Umgebung von den Machern auf Google Collab zur Verfügung gestellt wurde, sodass das Programm ohne technische Voraussetzungen gestartet werden kann!

Hat dir dieser Artikel gefallen? Möchtest du mehr über Deep Learning erfahren? Schau dir unser spezielles Dossier an oder beginne schnell eine Ausbildung in Data Science mit DataScientest!