Les entreprises migrent de plus en plus leurs services vers le cloud. À ce titre, l’importance et la nécessité de déployer, gérer et mettre à l’échelle des applications de manière fiable et efficace est devenue primordiale. Fort de ce constat, une technologie à émerger et à révolutionné la façon dont les applications sont orchestrées : Kubernetes.

Rappel : qu’est-ce que Kubernetes ?

Souvent abrégé « K8s », Kubernetes est un système open-source d’orchestration de conteneurs. Il facilite la tâche des équipes techniques lorsqu’il s’agit de déployer des applications à grande échelle sur une infrastructure, qu’elle soit située sur des serveurs physiques, des VM ou dans le cloud.

Les conteneurs, tels que Docker, ont changé la donne en permettant aux développeurs d’isoler leurs applications et toutes leurs dépendances dans une unité standardisée. Cependant, lorsqu’il s’agit de gérer des centaines voire des milliers de conteneurs (surtout en production), les choses peuvent vite devenir complexes : c’est là que Kubernetes entre en jeu.

Google Kubernetes Engine (GKE)

GKE est un service entièrement géré qui permet de déployer des clusters Kubernetes en s’affranchissant de la gestion de l’infrastructure sous-jacente. Ainsi, vous pouvez vous concentrer sur le déploiement de vos applications tout en laissant Google gérer les aspects de mise à jour, de surveillance ou encore de sauvegarde.

Pourquoi choisir GKS ?

L’une des principales raisons pour lesquelles les entreprises se tournent vers GKE est la promesse d’une expérience Kubernetes sans inquiétude. Google a joué un rôle déterminant dans le développement initial de Kubernetes et continue de contribuer activement au projet. Cette expertise se traduit par une solution Kubernetes bien intégrée et optimisée pour le cloud. De plus, avec la flexibilité offerte par le modèle de tarification de GCP, les entreprises peuvent optimiser leurs coûts tout en bénéficiant d’une infrastructure hautement disponible et sécurisée.

Fonctionnalités clés de GKE

Les fonctionnalités clés proposées par GKE le distinguent des solutions d’orchestration de conteneurs concurrentes.

1. Automatisation et gestion

- Mise à jour automatique des nœuds : GKE garantit que les nœuds de votre cluster sont toujours à jour avec les dernières versions de sécurité

- Réparation automatique : Si un nœud devient non sain, GKE le détecte et le remplace automatiquement, assurant ainsi la continuité de votre service.

- Équilibrage de charge : GKE intègre un équilibrage de charge natif, répartissant le trafic entrant entre les pods pour assurer une distribution uniforme de la charge et une haute disponibilité.

- Surveillance et journalisation : GKE offre des capacités de surveillance, de journalisation et d’alerte en temps réel pour vos applications et votre infrastructure.

2. Sécurité

- Authentification et autorisation basées sur le rôle (RBAC) : GKE s’intègre étroitement avec Cloud IAM, permettant un contrôle d’accès granulaire à vos ressources.

- Chiffrement : GKE assure le chiffrement des données en transit et au repos, avec des clés gérées soit par Google soit par le client, offrant une sécurité robuste pour vos données.

- Réseau privé : Avec le support des VPC natifs, GKE assure une isolation complète de votre réseau, vous permettant de définir des règles de pare-feu et d’assurer une communication sécurisée entre vos services.

3. Évolutivité

- Mise à l’échelle automatique des applications : GKE ajuste automatiquement le nombre de pods en fonction de la charge de travail, garantissant que votre application a toujours les ressources nécessaires pour fonctionner efficacement.

- Mise à l’échelle des nœuds du cluster : En fonction de la demande, GKE peut ajouter ou supprimer des nœuds de votre cluster, optimisant les coûts et les performances.

4. Intégration avec d’autres services GCP

- Services de données : GKE s’intègre facilement avec des services tels que Cloud Storage et BigQuery, permettant à vos applications de tirer parti des capacités avancées de stockage et d’analyse de GCP.

- Développement et CI/CD : GKE facilite le développement, le test et le déploiement continus de vos applications conteneurisées.

Prise en main de GKE

Connectez-vous à la console GCP avec votre compte Gmail. Par défaut, un projet intitulé « My First Project » sera créé pour vous. Il est impératif de compléter la vérification de facturation pour utiliser les services GCP. Une fois le compte de facturation vérifié, vous pouvez utiliser tous les services avec un crédit de 300$.

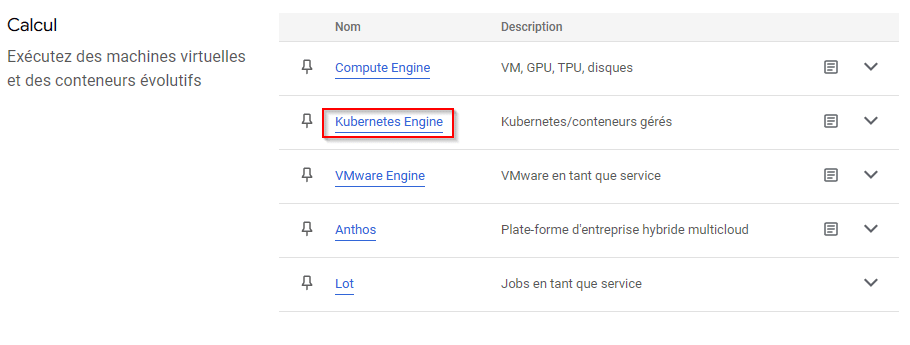

1. Accès au service GKE

Depuis la console, accéder aux services proposés par Google Cloud, et sélectionnez Kubernetes Engine.

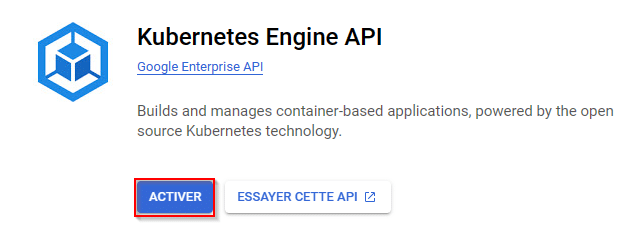

Activez à présent le service GKE :

2. SDK de Google Cloud

- Téléchargez et installez le SDK Google Cloud.

- Authentifiez-vous et configurez votre projet en utilisant

gcloud auth login et

gcloud config set project [PROJECT_ID]

3. Création d’un cluster Kubernetes

- Via la console GCP : Dans le menu de navigation, sélectionnez « Kubernetes Engine » > « Clusters », puis cliquez sur « Créer ».

- Via gcloud : Utilisez la commande suivante pour créer un cluster :

gcloud container clusters create [CLUSTER_NAME] 4. Déploiement d’une application

- Configurez kubectl, l’outil en ligne de commande de Kubernetes, pour utiliser le cluster que vous venez de créer :

gcloud components install kubectl - Déployez une application en utilisant une image Docker. Par exemple, pour déployer une image simple de Nginx :

kubectl create deployment nginx --image=nginx:1.17 - Exposez votre application à l’aide d’un service :

kubectl expose deployment nginx --type=LoadBalancer --port=80 Après quelques minutes, votre application sera accessible via une adresse IP externe.

5. Surveillance et gestion

- Utilisez la console GCP pour surveiller l’état et la performance de votre cluster. Vous pouvez visualiser l’utilisation des ressources, consulter les journaux et configurer des alertes.

- Pour une gestion plus fine, utilisez kubectl pour obtenir des informations sur vos pods, services, et autres ressources Kubernetes.

6. Nettoyage

- Une fois que vous avez terminé d’explorer, n’oubliez pas de supprimer les ressources que vous avez créées pour éviter des frais inutiles. Supprimez le cluster via la console GCP ou en utilisant gcloud :

gcloud container clusters delete [CLUSTER_NAME] Bonnes pratiques

Lorsqu’il s’agit de gérer des applications conteneurisées avec GKE, certaines bonnes pratiques peuvent vous aider à optimiser la performance, la sécurité et la rentabilité de votre infrastructure.

|

Tolérance aux pannes | - Envisagez de déployer votre application sur plusieurs zones / régions - Ayez suffisamment de réplicas pour une reprise rapide en cas de défaillance |

|---|---|---|

|

Sécurisation | - Utilisez des réseaux privés natifs pour isoler votre trafic et protéger votre cluster - Utilisez l'authentification et l'autorisation basées sur les rôles (RBAC) - Assurez-vous que votre cluster est toujours à jour. |

|

Gestion des coûts | - Utilisez la mise à l'échelle automatique des nœuds et des pods - Utilisez les outils de surveillance et d'alerte de GCP |

|

Monitoring | - Intégrez votre cluster GKE avec des outils de journalisation - Configurez des alertes pour être informé rapidement des problèmes potentiels |

|

Gestion des données | - Utilisez les volumes persistants de Kubernetes et envisagez d'utiliser des solutions comme Google Cloud Storage pour une durabilité et une disponibilité accrues. - Assurez-vous d'avoir une stratégie de sauvegarde en place pour vos données. |

Conclusion

En combinant simplicité, sécurité et évolutivité, GKE offre une plateforme robuste adaptée aux défis technologiques actuels en matière de gestion d’applications conteneurisées.