Nightshade, développé par des chercheurs de l'université de Chicago, représente une avancée majeure dans la protection des droits des artistes à l'ère numérique. Cet outil innovant vise à sauvegarder la propriété intellectuelle des créateurs en altérant les pixels des images pour prévenir leur exploitation abusive par des intelligences artificielles génératives.

Table des matières

Quelle est l'origine de Nightshade ?

L’outil Nightshade est une innovation majeure de l’Université de Chicago, spécifiquement développée pour contrer les défis posés par les IA génératives face à la propriété intellectuelle artistique.

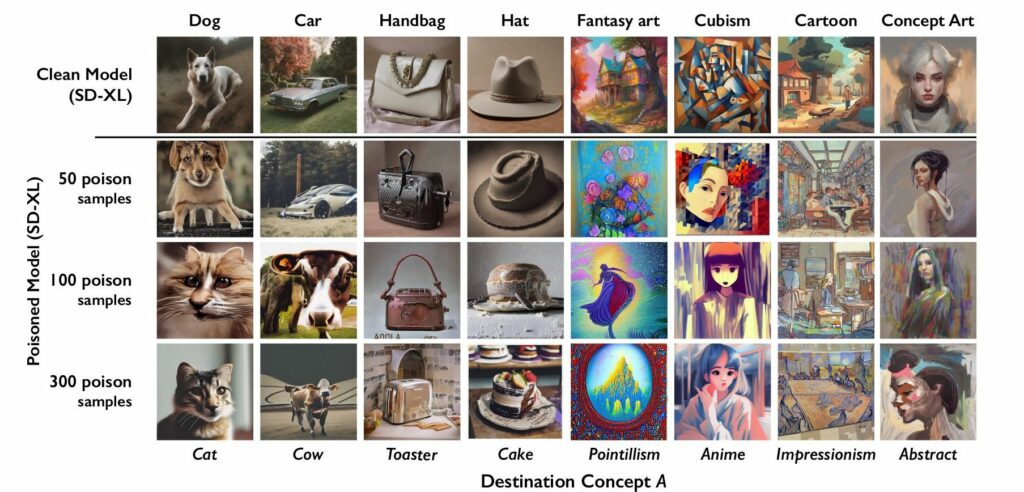

Face à l’essor des intelligences artificielles entraînées par des datasets contenant des œuvres dérivées sans consentement, Nightshade offre une solution unique. En altérant discrètement les pixels des images, il rend leur utilisation par les IA génératives inefficace. Pire encore, les images détériorent l’algorithme de reconnaissance de ces dernières.

Cela permet aux artistes de préserver l’intégrité de leurs œuvres et de lutter contre la duplication non autorisée, garantissant ainsi que leur propriété intellectuelle reste protégée dans le monde numérique où la duplication est facile et répandue.

Comment Nightshade modifie-t-il les pixels ?

Nightshade opère en modifiant subtilement le code des pixels. Cette modification est conçue pour être quasi imperceptible pour l’œil humain, tout en étant suffisamment distincte pour induire en erreur les algorithmes d’IA générative.

Lorsque ces images altérées sont intégrées dans des bases de données utilisées par des IA, elles perturbent la capacité de l’IA à interpréter correctement les données visuelles. Cela se traduit par la production de contenus erronés ou déformés lorsqu’une IA tente de créer de nouvelles images basées sur ces échantillons corrompus.

En somme, Nightshade crée un bouclier numérique autour des œuvres, protégeant ainsi leur authenticité et leur originalité.

Nightshade est-il une solution fiable pour les artistes ?

Cette technique, bien que prometteuse, soulève des questions sur sa fiabilité à long terme et son impact sur la formation des IA. Alors que Nightshade offre une barrière contre l’appropriation numérique, son efficacité face à l’évolution rapide des technologies d’IA reste à évaluer.

Existe-t-il d'autres logiciels de protection numérique pour les artistes ?

Le paysage des logiciels de protection numérique propose des solutions comme Glaze, offrant des approches différentes mais complémentaires à Nightshade.

En quoi consiste Glaze ?

Glaze, à l’instar de Nightshade, est une solution développée par l’Université de Chicago.

Ce logiciel est un système conçu pour protéger les artistes contre la copie de style par les IA. Il fonctionne en appliquant un filtre aux œuvres d’art, modifiant les pixels de manière minimale pour qu’ils apparaissent inchangés aux yeux humains, mais différemment aux modèles d’IA. Cette technique empêche les IA de reproduire le style de l’artiste lorsqu’elles sont sollicitées. Glaze est robuste contre diverses méthodes visant à annuler ses effets, agissant comme une nouvelle dimension artistique perceptible uniquement par les IA. Il est conçu pour être durable, mais des mises à jour continues sont nécessaires pour maintenir son efficacité contre les avancées de l’IA.

Quel avenir pour les artistes dans un monde dominé par la numérisation ?

L’ère de la numérisation transforme profondément le paysage artistique, offrant aux artistes des opportunités sans précédent tout en présentant des défis inédits. Avec l’accès à de nouveaux outils numériques, les artistes peuvent explorer de nouvelles formes de créativité et atteindre un public plus large. Cependant, cette ère apporte aussi des questions cruciales sur la protection des droits d’auteur et la préservation de l’authenticité des œuvres. La numérisation soulève la nécessité d’une adaptation continue et d’une vigilance face à l’utilisation non autorisée des œuvres par des technologies comme les IA génératives. Dans ce contexte, l’avenir des artistes dépendra de leur capacité à intégrer ces changements tout en défendant leur propriété intellectuelle avec des outils comme Nightshade et Glaze.