Le 25 mars 2025, OpenAI a franchi un cap majeur dans la course à l’intelligence artificielle créative. L’entreprise américaine a dévoilé une nouvelle version de ChatGPT dotée de fonctionnalités avancées de génération d’images et de voix, directement intégrées à son modèle GPT-4o. Objectif : rendre l’IA plus utile, plus fluide et plus accessible que jamais.

Une nouvelle génération d’images directement dans ChatGPT

DALL-E laisse place à GPT‑4o Image Generation, un outil nativement intégré à ChatGPT, qui, contrairement aux précédents modèles, permet une génération d’images contextualisée, précise et itérative, sans avoir à passer par une interface séparée ou un langage de prompt complexe.

Grâce à un entraînement multimodal (texte + image), GPT‑4o Image Generation comprend et traduit des descriptions en langage naturel en visuels cohérents, photoréalistes, stylisés ou techniques, selon les besoins. Il peut gérer jusqu’à 20 objets distincts, intégrer du texte lisible dans l’image, et suivre des consignes très précises : couleurs exactes, formats spécifiques (affiche, schéma, bande dessinée, etc.), style graphique…

Autre innovation : la conversation multi-tours. L’utilisateur peut affiner progressivement le visuel généré, corriger des détails ou combiner des éléments en plusieurs étapes.

Une IA plus multimodale que jamais

Avec GPT‑4o, OpenAI pousse l’idée de modèle omnimodal, capable de traiter et d’intégrer plusieurs types de données, à un niveau inédit. ChatGPT peut désormais analyser des images fournies par l’utilisateur, les modifier ou s’en inspirer pour générer un nouveau contenu. Jusqu’à 15 images peuvent être envoyées pour enrichir le contexte.

Voix et accessibilité : un écosystème qui s’élargit

Dans la foulée, OpenAI a également lancé trois modèles vocaux reposant sur GPT‑4o. Ces nouvelles IA vocales, accessibles via l’API, remplacent Whisper, l’ancien système ASR d’OpenAI, avec des performances améliorées :

- gpt‑4o-transcribe, pour la transcription multilingue de haute précision (taux d’erreur réduit à 2,46 % en anglais)

- gpt‑4o-mini-transcribe, version allégée pour intégration mobile

- gpt‑4o-mini-tts, capable de synthétiser des voix avec ton, accent et émotion personnalisables

Ces modèles permettent de créer des assistants vocaux contextuels, expressifs et multilingues, utiles pour des cas d’usage variés : support client, assistants virtuels, apps de formation ou interfaces vocales low-code via le SDK Agents.

Three new state-of-the-art audio models in the API:

— OpenAI Developers (@OpenAIDevs) March 20, 2025

🗣️ Two speech-to-text models—outperforming Whisper

💬 A new TTS model—you can instruct it *how* to speak

🤖 And the Agents SDK now supports audio, making it easy to build voice agents.

Try TTS now at https://t.co/MbTOlNYyca.

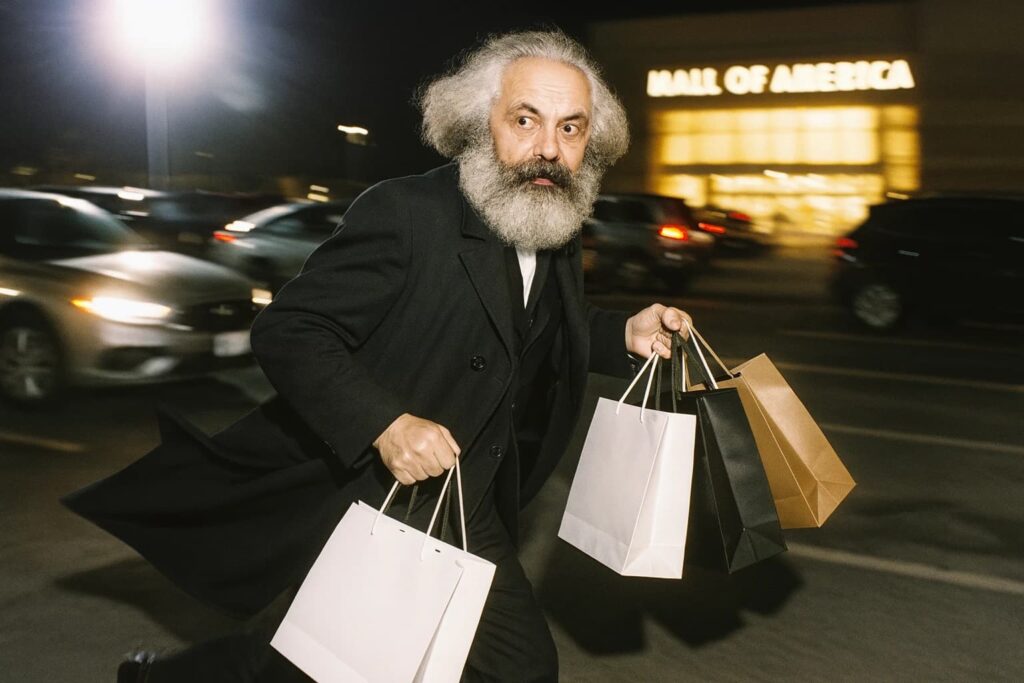

OpenAI sécurise son environnement

Sur le plan éthique, OpenAI insiste sur la sécurité. Toute image générée est marquée par des métadonnées C2PA, identifiant clairement son origine IA. L’entreprise a renforcé ses filtres de modération pour empêcher les dérives (deepfakes, nudité non consentie, contenus haineux). Un raisonneur LLM, formé à partir de règles humaines, interprète les ambiguïtés pour assurer un cadre éthique cohérent.

Autre grande nouveauté : la génération d’images est désormais disponible pour tous les utilisateurs, y compris en version gratuite. Les API pour développeurs suivront dans les prochaines semaines. Quant aux nostalgiques, DALL·E reste accessible via un GPT dédié.

Si cet article vous a plu et si vous envisagez une carrière dans la Data Science ou tout simplement une montée en compétences dans votre domaine, n’hésitez pas à découvrir nos offres de formations ou nos articles de blog sur DataScientest.

Source : openai.com