Es ist das am häufigsten verwendete Werkzeug in der Statistik... Ausgehend von einem bekannten Datensatz definiert die lineare Regression eine gerade Linie oder eine Kurve, die später dabei helfen wird, Phänomene vorherzusagen. Die lineare Regression wird in vielen Bereichen eingesetzt, z. B. beim maschinellen Lernen.

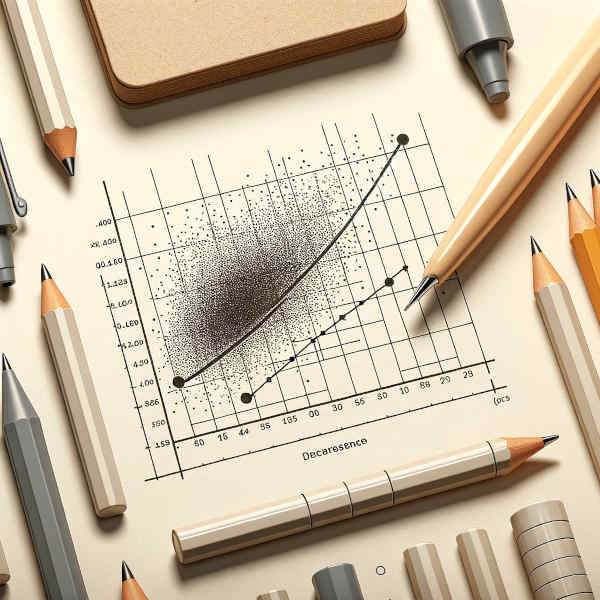

„Lineare Regression“ – dieser Name mag abschreckend klingen. In Wirklichkeit verbirgt sich dahinter eine grundlegende statistische Funktion. Ausgehend von einer Wolke von Punkten (aus numerischen Variablen) zeichnet die lineare Regression eine Linie oder Kurve, die allen Punkten am nächsten kommt. Diese geometrische Figur soll so zuverlässig wie möglich sein.

Lineare Regression: Ein Vorhersagetool

Wir haben es hier mit einem Vorhersagetool zu tun, denn ausgehend von einer oder mehreren Variablen, die wir ihm vorlegen, hilft die lineare Regression dabei, andere Variablen zu definieren, die in einer logischen Beziehung zueinander stehen.

Einige Beispiele für lineare Regression

Als eine auf Statistiken basierende Vorhersagemethode wird die lineare Regression in einer Vielzahl von Bereichen eingesetzt: Wirtschaft, Medizin, Umwelt, Sport etc.

Hier sind einige typische Anwendungsfälle:

- Schätzung der Verkaufsrate eines bestimmten Produkts in Abhängigkeit vom investierten Werbebudget und/oder einer bestimmten Altersgruppe der Verbraucher.

- Die Festigkeit eines Materials unter verschiedenen äußeren Bedingungen vorhersagen.

- Das Alter eines Sterns auf der Grundlage seiner Helligkeit und anderer Umgebungsfaktoren schätzen.

- Vorhersage der Entwicklung einer Aktienart an der Börse aufgrund der Analyse der öffentlichen Meinung über neue Produkte.

usw.

Wer hat die lineare Regression erfunden?

Das Konzept wurde von dem britischen Mathematiker und Statistiker Francis Galton (1822 – 1911) entwickelt. Als Cousin von Charles Darwin war er sehr an Konzepten wie Vererbung und Genetik interessiert. Er selbst versuchte, konkrete Probleme wie dieses zu lösen: Hilft die Größe der Eltern dabei, die Größe der Kinder vorherzusagen, wenn sie erwachsen sind?

Später verfeinerten andere Forscher die Methoden der linearen Regression.

Karl Pearson ist der Schöpfer des Pearson-Korrelationskoeffizienten, eines grundlegenden Instruments zur Untersuchung der Beziehungen zwischen Variablen. Wir gehen weiter unten darauf ein, was der Korrelationskoeffizient ist.

Ronald A. Fisher trug zur Formalisierung der linearen Regression bei. Eine der von ihm entwickelten Techniken dient zur Ableitung der Standardabweichung, einem weiteren grundlegenden Faktor, der weiter unten erläutert wird.

John Turkey entwickelte Techniken, die dabei helfen, Probleme in linearen Regressionsmodellen zu diagnostizieren.

Bradley Efron hat Methoden entwickelt, um die Genauigkeit von Parametern zu bewerten.

usw.

Einfache und multiple lineare Regression

Es gibt zwei Arten von linearen Regressionen:

- Diejenige, die auf den Beziehungen zwischen zwei Variablen X und Y basiert (wobei Y von X abgeleitet wird), erzeugt eine Gerade und wird als einfache lineare Regression bezeichnet.

- Diejenige, die auf mehreren X-Variablen basiert, erzeugt normalerweise eine Kurve. Sie wird als multiple lineare Regression bezeichnet.

Einfache lineare Regression

Die einfache lineare Regression beruht auf der folgenden Formel:

Y = β0 + β1 × X + ϵ.

Y ist die Variable, die vorhergesagt werden soll. Sie wird als „abhängige Variable“ bezeichnet.

β0 ist der Wert von Y, wenn X gleich null ist.

β1 steht für den „Regressionskoeffizienten“ und erzeugt die Steigung der Linie, also wie sehr sich Y verändert, wenn X um eine Einheit steigt.

X ist die Basisvariable.

ϵ bezeichnet die unvermeidbare Fehlermarge.

Im Grunde versuchen wir, β0 und β1 zu bewerten, um ϵ zu minimieren und die zuverlässigste Kurve am Kreuzungspunkt von X und Y zu erhalten.

Wir haben es hier mit einer einfachen Formel zu tun, da sie auf der Beziehung zweier Variablen beruht. Das von Francis Galton gestellte Problem (die Größe des erwachsenen Kindes in Abhängigkeit von der kumulierten Größe seiner Eltern zu schätzen) wäre ein gutes Beispiel für lineare Regression.

Multiple lineare Regressionen

Die Formel für die multiple lineare Regression ist eine Erweiterung ihrer einfachen Form:

Y = β0 + β1 × X1 + β2 × X2 + … + βn × Xn + ϵ.

Auch hier ist Y die abhängige Variable – die, die man versucht vorherzusagen – und ϵ ist die Fehlermarge. Die Paare βn × Xn bewegen sich auf demselben Modell wie bei der einfachen Regression, außer dass sie mehrfach vorhanden sind. Diesmal besteht das Ziel darin, die den Variablen Xn entsprechenden βn-Koeffizienten zu finden, die zusammen ϵ so gut wie möglich minimieren und so die bestmögliche Vorhersage produzieren.

Zum Beispiel könnten X-Daten wie die Größe eines Hauses, die Anzahl der bewohnbaren Zimmer, das Alter des Gebäudes und die Nähe zu öffentlichen Verkehrsmitteln dabei helfen, Y, also den Verkaufspreis der Immobilie, vorherzusagen.

Zwei Schlüsselbegriffe der linearen Regression

Andere Elemente sind bei der Berechnung einer linearen Regressionskurve von Bedeutung.

Korrelationskoeffizient

Dieses Maß beschreibt den Grad der linearen Beziehung zwischen zwei Variablen und variiert zwischen -1 und 1.

Wenn der Korrelationskoeffizient gleich 1 ist, besteht eine perfekte positive lineare Beziehung. Wenn eine der Variablen steigt, steigt auch die andere proportional dazu.

Wenn der Korrelationskoeffizient -1 beträgt, ist die Beziehung wieder perfekt, aber negativ.

Es kann also vorkommen, dass alle Punkte auf der Geraden / Kurve liegen, aber das ist äußerst selten. Normalerweise erscheint das lineare Regressionsmuster in der Mitte eines Satzes von Punkten, die auf beiden Seiten liegen.

Wenn der Korrelationskoeffizient schließlich gegen 0 geht, bedeutet dies, dass es keine lineare Beziehung zwischen den beiden Variablen gibt.

Standardabweichung

Dieses statistische Maß, misst, wie stark die einzelnen Werte vom Durchschnitt der Gesamtheit abweichen. Eine geringe Standardabweichung bedeutet, dass die Daten weitgehend dem Durchschnitt entsprechen. Eine hohe Standardabweichung deutet auf eine starke Streuung der Daten hin.

Lineare Regression im Machine Learning

Die lineare Regression wird beim maschinellen Lernen eingesetzt.

Grundsätzlich arbeitet Machine Learning mit einem Dataset (Daten in Form von Zeilen und Spalten), aus dem ein Algorithmus versucht, ein Modell zu definieren. Das Modell wird dann angepasst, um die Abweichungen zwischen der Kurve und den Punkten zu verringern und die Fehler zu minimieren.

Die lineare Regression ist das einfachste Modell für diejenigen, die mit dem maschinellen Lernen beginnen möchten, z. B. mit der mathematischen Bibliothek Numpy unter Python.

💡Auch interessant: