OpenAI, l’un des géants de l’intelligence artificielle, a sorti en mai 2020 le successeur de GPT-2. GPT pour ‘’ Generative Pre-Trained Transformer ‘’ est un modèle de langage non supervisé basé sur les modèles de transformateurs.

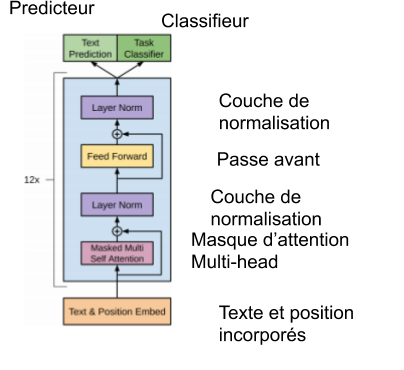

Un transformateur (transformer) est un modèle de Deep Learning utilisé principalement comme technique en NLP qui consiste en une architecture composée d’une partie encodeur et une partie décodeur, chacune contenant de multiples couches.

On peut résumer l’architecture transformateur de GPT par le schéma suivant :

GPT est capable de prédire la suite logique de n’importe quel type de texte, et les nouveaux modèles génèrent un contenu de plus en plus cohérent. Il a par exemple écrit une suite cohérente à la première phrase du roman 1984.

Mais quelle est vraiment la différence entre les différentes versions de GPT ?

Pour répondre à cette question, on va s’intéresser aux paramètres du modèle. Ce sont des mesures qui se mettent à jour durant l’entraînement du modèle pour s’adapter aux données en entrée.

Ainsi un plus grand nombre de paramètres augmente la complexité du modèle mais nécessite plus de puissance de calcul durant l’entraînement.

Le type et la taille des données influencent aussi l’entraînement des modèles.

GPT-2 était déjà un modèle utilisant un très grand nombre de paramètres ( 1.5 milliards! ), ce qui lui valait déjà d’être le modèle le plus robuste à sa sortie surpassant son concurrent de chez Google BERT.

Initialement , le nombre de paramètres considéré comme trop important, OpenAI avait rendu accessible au grand public des versions utilisant moins de paramètres de peur que le modèle soit utilisé à des fins malveillantes, car supposé capable de fonctionnalités plus avancées . La version complète est sortie plus tard mais n’était en réalité pas dangereuse ou révolutionnaire, car même si sa précision dans des tâches spécifiques de langage était sans précédent, le modèle échouait dans d’autres tâches qui sont censés être assez simple du point de vue humain.

Cette fois-ci, GPT-3 surpasse complètement son prédécesseur et atteint 175 milliards de paramètres. De plus, cette version améliore aussi d’autres aspects du modèle telles que son initialisation. Il atteint des scores élevés dans différents benchmark de NLP.

Cette version est actuellement toujours en beta test, ce qui restreint la visibilité de ses résultats au grand public. Cependant, certains bêta testeurs ont partagé des résultats d’application surprenants :

This is mind blowing.

— Sharif Shameem (@sharifshameem) July 13, 2020

With GPT-3, I built a layout generator where you just describe any layout you want, and it generates the JSX code for you.

W H A T pic.twitter.com/w8JkrZO4lk

GPT-3 arrive ainsi à exécuter des tâches qui dépassent le cadre textuel classique (langue) puisqu’il peut générer des bouts de code dans un langage de programmation.

Une telle performance peut créer une confusion entre du contenu créé par une IA ou par un être humain. Sur Hacker-News, un article [lien https://adolos.substack.com/p/feeling-unproductive-maybe-you-should] sur la productivité écrit par GPT-3 arrive en première place sans que quelqu’un devine qu’il n’a pas été conçu par un humain.

Mais une telle évolution entre GPT-2 et GPT-3 devrait atteindre des résultats encore plus impressionnants que la génération de texte, l’objectif étant d’émuler de quelque manière l’intelligence humaine. En réalité, ceci est loin d’être réalisé car ces modèles prédictifs semblent parfois avoir atteint leur limite.

Certains ont essayé de poser des questions qui testent le bon sens de l’IA à travers des questions assez simples dans le cadre des tests de Turing :

Q: How many eyes does a giraffe have?

A: A giraffe has two eyes.

Q: How many eyes does my foot have?

A: Your foot has two eyes.

On remarque que pour une question simple mais qui n’a pas vraiment de sens telle que ‘’ Mon pied a combien de yeux ? ‘’, l’IA force une réponse qui n’a aussi pas de sens.

L’IA a aussi du mal avec les séquences d’opérations :

Q: If I have a marble and a paper clip in a box, put a pencil in the box, and remove the marble, what is left?

A: A paper clip.

Q: If I have two shoes in a box, put a pencil in the box, and remove one shoe, what is left?

A: A shoe.

Il semblerait que la mémoire de l’IA est très courte ce qui restreint sa capacité à répondre à des successions d’opérations.

Les modèles GPT souffrent en général de problèmes qui limitent grandement leur potentiel :

Les données sont des sites web en grand nombre, la véracité du contenu n’est pas forcément vérifiée ce qui implique qu’on ne peut pas faire confiance aux réponses de l’IA.

L’IA semble forcer des réponses à tout type de question au lieu de se rendre compte de son incompétence à répondre.

Le modèle échoue complètement face à quelques tests de Turing comme vu précédemment.

Conclusion:

Les modèles GPT et surtout la dernière version GPT-3 sont impressionnants, et permettent la génération de contenus cohérents dont l’auteur peut être confondu avec un être humain.

Cette technologie impressionne encore plus dans sa rapidité d’exécution puisqu’il n’y a pas besoin de réentraîner le modèle quand on lui donne de nouvelles données.

Il n’empêche que la surmédiatisation entraîne de fausses rumeurs qui suggèrent que le modèle est capable d’émuler l’intelligence humaine, alors qu’en réalité il échoue déjà sur plusieurs tâches à priori simple.

Attendons cependant une potentielle sortie grand public du modèle, il est clair que nous verrons des applications très intéressantes dans un futur proche.

Pour plus de détails sur le fonctionnement des modèles NLP, n’hésitez pas à consulter notre article sur le sujet.