Meta vient de présenter dans un article de blog son nouveau modèle d’intelligence artificielle, ImageBind. Le logiciel en open source offre la capacité aux machines d’analyser et de lier 6 types de modalités différentes.

En quoi consiste ImageBind ?

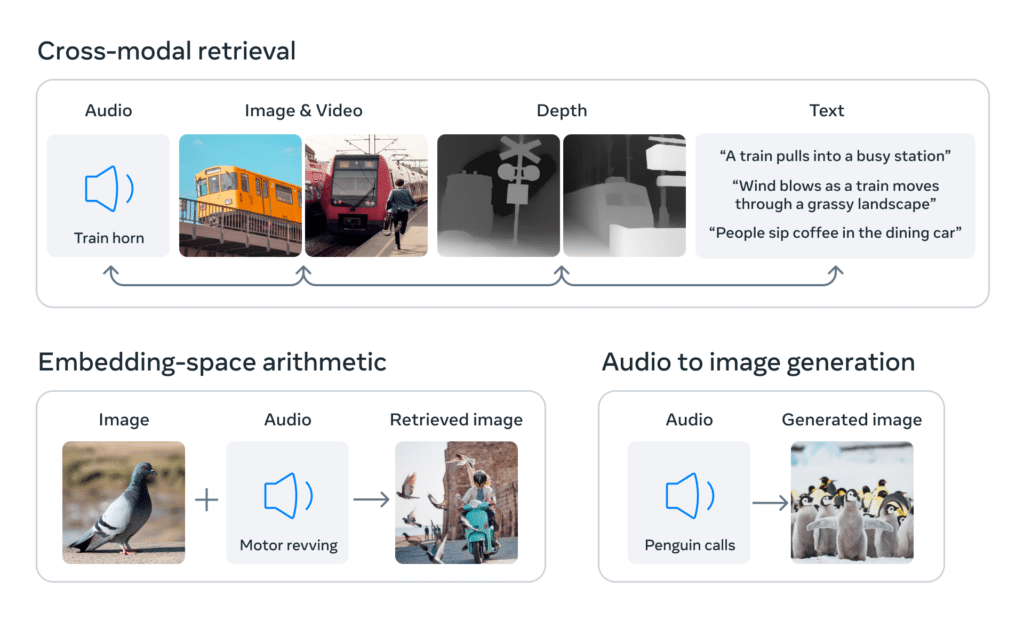

Dans son article de blog, Meta présente ImageBind comme le premier modèle d’IA capable de comprendre et de lier 6 types d’informations. ImageBind comprend la perception d’informations auditive, textuelle, visuelle (image/vidéo), la profondeur (3D), le rayonnement thermique et l’inertie du mouvement. Grâce à ses nouvelles fonctionnalités, ImageBind offre aux machines une compréhension holistique de leur environnement.

En ce qui concerne sa configuration et son entraînement, Meta a précisé qu’il n’est pas nécessaire de faire travailler ImageBind avec des datasets qui comportent 6 modalités. Ce choix est dû à la capacité d’ImageBind de pouvoir générer des rendus à partir d’informations fragmentées. Mais aussi, parce qu’il est impossible de créer des datasets avec des enregistrements audio et des cartes de rayonnement thermique en même temps.

À quoi servira ImageBind ?

Le nouveau bijou de Meta vient s’ajouter à la récente suite d’outils IA composée de DINOv2, une nouvelle technique d’entraînement pour la computer vision et de SAM, un modèle de segmentation universel.

Meta dévoile aussi qu’ImageBind pourra être intégré dans ses outils génératifs et donne l’exemple de Make a Scene ou Make a Video. Grâce à son nouveau modèle, les deux logiciels de création pourront développer des vidéos ou images à partir d’enregistrements audio.

Avec ImageBind, les développeurs pourront créer des environnements plus immersifs et vivants. Meta espère également que son modèle open source aidera les chercheurs en IA à créer des machines plus humaines, qui se basent sur les 5 sens.

Si cet article vous a plu et si vous envisagez une carrière dans la Data Science, n’hésitez pas à découvrir nos articles ou nos offres de formations sur DataScientest.

Source : ai.facebook.com