Meta a récemment dévoilé Code Llama-70B, une version avancée de son modèle de langage spécialisé dans le développement logiciel. Avec des performances équivalentes, voire supérieures à GPT-4, ce modèle open source vient se hisser en tête à tête avec le modèle dominant sur le marché.

Code Llama-70B une version avancée ?

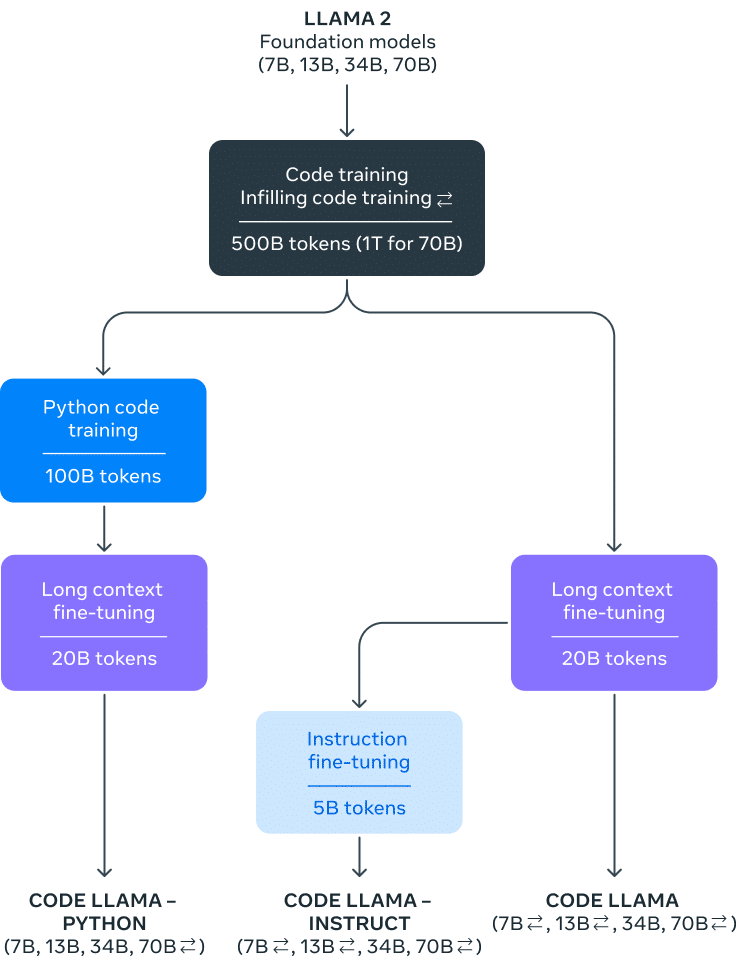

Fin d’été 2023, Meta annonçait Code Llama, un LLM orienté développement logiciel. Désormais Code Llama se décline en quatre versions : 7, 13, 34 et maintenant 70 milliards de paramètres.

Entraîné par 500 milliards de tokens, les trois premiers modèles de Code Llama restent de puissants outils rapides et plus adaptés aux petites configurations, 7B est capable de tourner sur un seul GPU. De son côté, 70B a été entraîné avec 1000 milliards de tokens, l’outil est présenté par Meta comme l’assistant parfait pour le développement.

En plus de l’aboutissement de 70B, Meta met aussi en avant deux versions de Code Llama : Code Llama Python et Code Llama Instruct, dans toutes les versions possibles (7, 13, 34 et 70). Tous ces modèles sont dérivés de Llama 2 et hébergés chez Hugging Face.

Quels sont les avantages de Code Llama Python et Instruct ?

Code Llama Python, est optimisée pour une grande variété de tâches en programmation, y compris le web scraping, l’analyse de données, et le développement web. Sa polyvalence et ses performances en font un outil précieux dans le domaine de la génération de code.

Code Llama Instruct peut lui effectuer de nombreuses tâches et manipulations en langage naturel. On compte parmi ses capacités le filtrage, la recherche, le tri et la manipulation de données, ainsi que la recherche binaire et factorielle.

Code Llama-70B plus puissant que GPT-4 ?

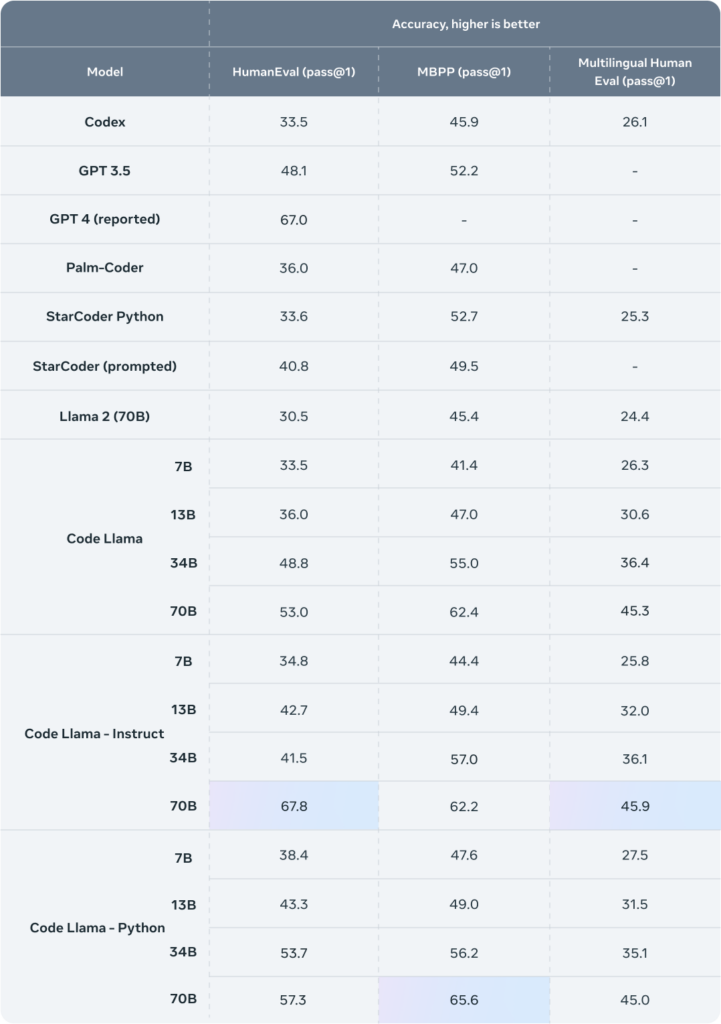

Pour avancer ses arguments, Meta indique avoir fait tester leur nouveau modèle avec HumanEval et Mostly Basic Python Programming (MBPP). HumanEval permet de tester les capacités du modèle à compléter un code et MBPP évalue les compétences du modèle à écrire du sur la base d’une description.

Résultat, Instruct 70B a atteint un score de 67,8 % sur HumanEval contre 67 % pour GPT-4. Python 70B a lui battu le précédent record de 62,4 % par Llama 70B et obtenu 65,6 %. Ces nouveaux records font de Llama le plus puissant LLM open source sur le marché.

Si cet article vous a plu, et si vous envisagez une carrière dans la Data Science ou tout simplement une montée en compétences dans votre domaine, n’hésitez pas à découvrir nos offres de formations ou nos articles de blog sur DataScientest.

Source : ai.meta.com