En décembre 2024, Cerebras Systems a marqué un tournant dans l’histoire de l’intelligence artificielle. En collaboration avec les Laboratoires Nationaux de Sandia, en Californie, ils ont entraîné un modèle d’apprentissage profond comprenant plus d’un trillion de paramètres sur un seul système CS-3. Cette avancée technique, réalisée sans infrastructure complexe ni modifications du code, redéfinit les standards de performance pour les modèles d’IA.

Pourquoi parle-t-on d’une révolution ?

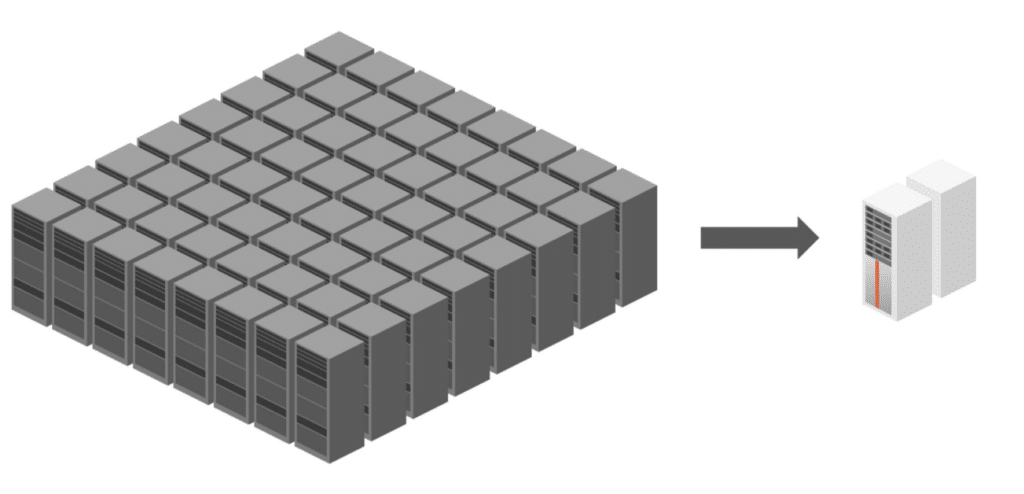

Jusqu’à présent, entraîner des modèles d’une telle envergure était un défi colossal. Des milliers de GPU et des semaines de configuration matérielle étaient indispensables pour accomplir ce type de tâche. Le Cerebras CS-3, équipé de la technologie Wafer Scale Cluster et du dispositif externe MemoryX, vient briser cette barrière en simplifiant radicalement le processus.

La solution réside dans la gestion de la mémoire. Les modèles à trillion de paramètres nécessitent plusieurs téraoctets de mémoire, bien au-delà des capacités d’une seule unité GPU. Le système CS-3 utilise MemoryX, un dispositif de mémoire externe capable de stocker et de gérer efficacement les poids du modèle. En quelques jours seulement, une configuration de 55 To a été mise en place, permettant un démarrage rapide des premières étapes d’entraînement.

Mais la vraie innovation réside dans la scalabilité linéaire. Après avoir démontré l’efficacité d’un seul système CS-3, les chercheurs ont étendu l’entraînement à 16 unités avec une accélération quasi linéaire de 15,3x.

🚨Cerebras Systems + Sandia National Labs have demonstrated training of a 1 trillion parameter model on a single CS-3 system (!)

— Cerebras (@CerebrasSystems) December 11, 2024

This is ~1% the footprint & power of an equivalent GPU cluster. pic.twitter.com/EvBVO2JjLe

Quel impact pour l’industrie de l’IA ?

L’avancée de Cerebras ouvre des perspectives pour l’ensemble de l’industrie de l’intelligence artificielle, avec des implications majeures :

- Accessibilité accrue aux modèles avancés

Les entreprises et les laboratoires n’auront plus besoin d’investir dans des infrastructures coûteuses et complexes. Avec le système CS-3, même les petites structures peuvent envisager de développer des modèles de pointe. - Réduction des coûts et de l’empreinte carbone

Les solutions traditionnelles nécessitent des milliers de GPU et consomment une énergie considérable. En utilisant une infrastructure compacte comme le CS-3, le coût énergétique et financier est drastiquement réduit. - Accélération du time-to-market pour les innovations IA

Grâce à la simplicité de configuration et à la scalabilité de la solution, les délais entre la conception d’un modèle et son implémentation sont réduits. Cela permettra à des entreprises de déployer des solutions plus rapidement et efficacement.

Alors que les géants de la technologie se battent pour développer des modèles toujours plus grands, le CS-3 prouve que la simplicité et l’efficacité peuvent surpasser la complexité.

Si cet article vous a plu et si vous envisagez une carrière dans la Data Science ou tout simplement une montée en compétences dans votre domaine, n’hésitez pas à découvrir nos offres de formations ou nos articles de blog sur DataScientest.

Source : cerebras.ai