Le lancement de WAN 2.1, un modèle open source développé par Alibaba, montre une fois de plus que le marché chinois vient dominer la création de contenu par IA. Si des acteurs comme Sora d’OpenAI s’inscrivent déjà comme des références dans ce domaine, l’arrivée de ce nouveau challenger gratuit et sans restrictions pourrait bien bouleverser les choses.

Un concurrent à la hauteur des IA américaines ?

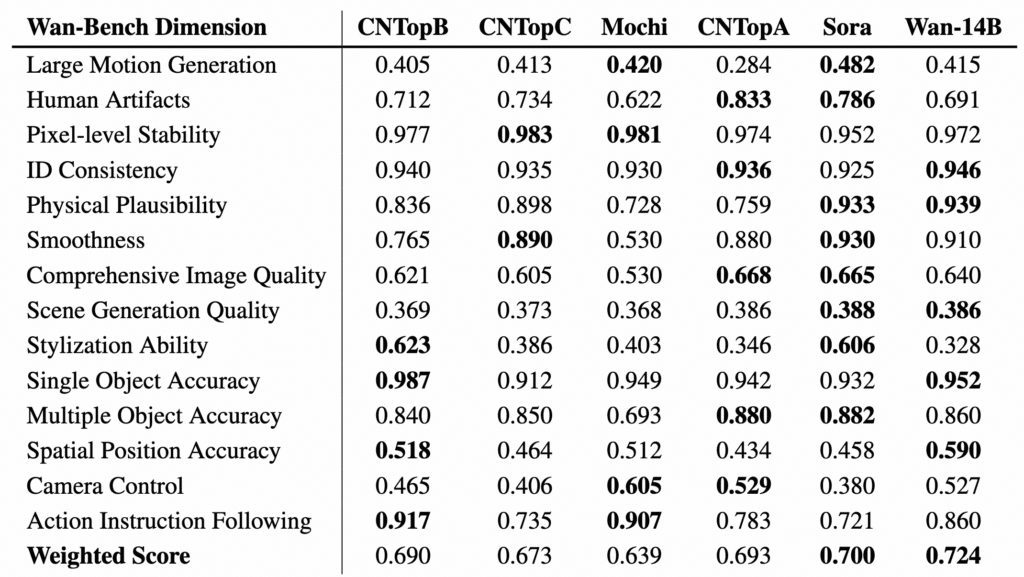

Avec un score de 86,22 % sur le benchmark VBench WAN 2.1 se place devant Sora (84,28 %) et Luma (83,61 %), qui sont pourtant deux des logiciels les plus développés sur le marché. Mais cette performance, qui pourrait en surprendre certains, s’explique par plusieurs avancées :

- Une meilleure gestion des interactions multi-objets, essentielle pour générer des vidéos complexes et naturelles.

- Un rendu plus fluide des mouvements, offrant des séquences plus réalistes et immersives.

- Une fidélité visuelle accrue grâce à des algorithmes optimisés pour la gestion des pixels.

Un autre atout clé de WAN 2.1 réside dans sa compatibilité avec des configurations informatiques grand public. Contrairement aux autres logiciels nécessitant des infrastructures coûteuses, sa version allégée T2V-1.3B fonctionne avec seulement 8,19 Go de mémoire vidéo, permettant de générer une vidéo en 480p en 4 minutes sur une Nvidia RTX 4090.

Une accessibilité qui pourrait séduire créateurs de contenu et PME cherchant des solutions performantes sans devoir contracter un prêt bancaire.

Des modèles pour tous les goûts

Plutôt que de proposer un unique modèle monolithique, Alibaba décline WAN 2.1 en plusieurs versions adaptées à différents usages :

- T2V-14B : conversion de texte en vidéo pour des animations automatisées.

- T2V-1.3B : version optimisée pour du matériel moins puissant.

- I2V-14B-720P & I2V-14B-480P : animation d’images statiques en vidéo fluide.

WAN 2.1 offre une solution adaptée à différents acteurs dans les domaines du cinéma, de la publicité, de l’éducation ou des réseaux sociaux. Mieux encore, il intègre des fonctionnalités innovantes absentes de nombreux concurrents :

- Effets de texte en chinois et en anglais, permettant d’intégrer des sous-titres dynamiques et du texte artistique directement dans les vidéos.

- Montage vidéo assisté par IA, facilitant l’édition et la personnalisation des contenus.

- Génération audio synchronisée (V2A), pour un alignement fluide entre image et son.

Alibaba comble de cette façon les lacunes des modèles américains, souvent critiqués pour leur manque de flexibilité et d’accessibilité.

🌟 Big News from @alibaba_cloud! 🌟

— Wan (@Alibaba_Wan) February 20, 2025

Meet WanX - our next-gen AI model redefining video generation !

🚀 Presenting mind-blowing demos from WanX 2.1!

🔥 Even more exciting:

WanX 2.1 will be OPEN-SOURCE !

Coming soon …#AIart #OpenSource pic.twitter.com/R1laOyJYAL

Alibaba mise sur l’open source

Contrairement à Google et OpenAI, Alibaba prend le contrepied en misant sur l’open source. WAN 2.1 est disponible sous licence Apache 2.0, permettant aux chercheurs et développeurs de modifier, adapter et intégrer l’IA dans leurs propres outils.

Cette philosophie d’ouverture pourrait accélérer l’innovation, notamment grâce aux plateformes comme GitHub, où le modèle est déjà accessible. Ce choix stratégique répond aussi à une volonté géopolitique et économique : renforcer l’écosystème technologique chinois face à l’hégémonie américaine.

Par ailleurs, Alibaba ne compte pas s’arrêter là. L’entreprise investira 50 milliards d’euros sur trois ans dans le développement de l’IA et du cloud computing, avec l’ambition de rivaliser durablement avec les leaders du secteur. Elle prévoit aussi le lancement de QwQ-Max, un modèle de raisonnement avancé, qui viendra compléter l’offre en open source. Si cet article vous a plu et si vous envisagez une carrière dans la Data Science ou tout simplement une montée en compétences dans votre domaine, n’hésitez pas à découvrir nos offres de formations ou nos articles de blog sur DataScientest.

Source : wan.video