Ici on ne parle pas de ChatGPT, mais c’est bien de là qu’il tient son nom.

Si vous n’avez jamais entendu parler de GPT, vous avez au moins déjà utilisé des IA génératives de texte, ou ‘LLM’ (Large Language Model). GPT est un type de LLM, sur lequel se base la plupart des IA génératives dont tout le monde parle en ce moment !

ChatGPT, vous comprenez pourquoi maintenant ?

GPT, c’est pour ‘Transformateur Génératif Pré-entraîné’ (pour la variante française), et c’est un nom très clair qui résume parfaitement son fonctionnement !

Comment ça vous n’êtes pas convaincus ?

Imaginez GPT comme un super-expert en prédiction de mots, son talent principal est de deviner quel mot serait le plus susceptible de compléter un début de phrase. En répétant cette prédiction encore et encore, mot après mot, il construit des phrases entières, des paragraphes, et même des articles complets !

Il a un peu aidé à écrire celui-là, mais il y a quand même un humain derrière…

Détaillons ensemble les différentes étapes de fonctionnement pour voir comment GPT apprend à comprendre la manière dont fonctionne le langage humain.

Étape 1 : Transformer les mots, en nombres

Les ordinateurs ne comprennent pas les mots comme nous. Pour eux, « chat » ou « maison » sont juste des suites de lettres, pour qu’une machine puisse travailler avec des mots, il faut les transformer en nombres.

C’est le rôle des Embeddings. Imaginez que chaque mot de la langue (ou presque) reçoit un code secret unique, qui est une liste de nombres.

Pensez à une immense bibliothèque. Chaque livre (chaque mot pour GPT) reçoit une étiquette spéciale avec un code-barres unique (le vecteur d’embedding). Ce code-barres n’est pas juste un numéro d’identification, il contient des informations cachées sur le livre.

Par exemple, les codes-barres des livres de science-fiction pourraient se ressembler, ceux des livres de cuisine aussi, et s’il s’agit de livres de science-fiction, qui en plus parlent de robots, leur code-barre seraient encore plus proches !

Plus deux mots ont un sens similaire, plus leur liste de nombres (leur vecteur d’embedding) sera « proche » dans un espace imaginaire. Par exemple, les vecteurs pour « roi » et « reine » seront très proches, et la différence entre le vecteur de « roi » et « homme » sera similaire à la différence entre « reine » et « femme » ! C’est super pratique, non ?

La première chose que fait GPT quand vous lui donnez du texte, c’est de regarder chaque mot et de trouver sa liste de nombres (vecteur d’embedding) correspondante dans sa « table de codes secrets ».

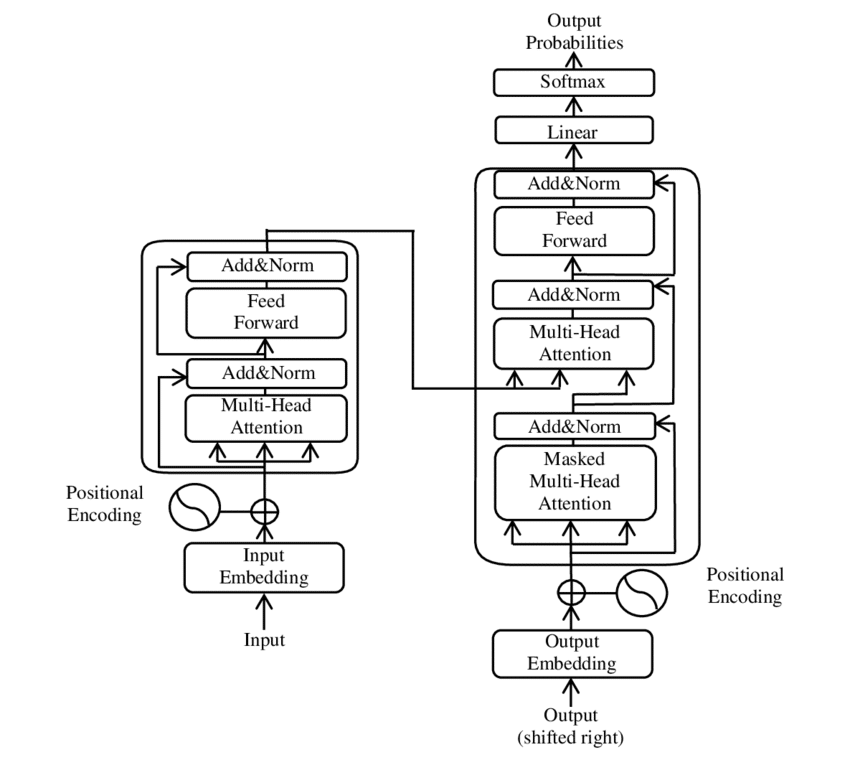

Étape 2 : L’ordre des mots (Encodage positionnel)

On a donc maintenant une liste de nombre pour chaque mot. En revanche, si on mélange les mots, la phrase perd son sens : « Le chat dort » n’a pas le même sens que « Dort le chat ». Je ne vous apprend rien, l’ordre des mots est crucial !

Le souci, c’est que notre modèle GPT traite les mots en parallèle (pour des raisons évidentes de temps d’exécution), donc sans se soucier de leur ordre. Pour résoudre ça, on ajoute une information supplémentaire à chaque liste de nombres des mots : un marqueur de position.

Ces marqueurs de position (l’Encodage Positionnel) sont aussi des listes de nombres, calculées avec des formules mathématiques spéciales.

On ne va pas rentrer dans les détails ici, retenons juste que ça marche super bien !

On les additionne simplement aux vecteurs d’Embedding des mots (leur code–barres rien qu’à eux).

Maintenant, le modèle a une liste de vecteur d’embedding de chaque mot, qui contient donc les informations de toute notre phrase, chaque élément de cette liste contient à la fois l’information sur le mot lui-même et sur l’endroit où il se trouve dans la phrase.

Étape 3 : Le Transformer

Rien à voir avec Optimus Prime, quoique…

La partie la plus intelligente de GPT est l’architecture Transformer. Voyez-le comme le cerveau qui va analyser la liste de nombres de la phrase pour comprendre le contexte et prédire le mot suivant.

Les modèles GPT utilisent une version simplifiée du Transformer original, appelée le Décodeur. Pourquoi ? Parce que leur travail est de générer du texte, et c’est le rôle du Décodeur !

Ce Transformer est construit en empilant plusieurs « blocs » identiques les uns sur les autres. Plus il y a de blocs (plus ça devient compliqué), plus il est puissant.

Chaque bloc a plusieurs étapes pour traiter les vecteurs d’Embedding de nos mots :

1. Le principe d’Attention

C’est l’idée géniale derrière le Transformer. Quand vous lisez une phrase, vous ne donnez pas la même importance à tous les mots pour comprendre le sens. Par exemple, dans « L’étudiant chez DataScientest qui avait bien révisé a réussi son examen », pour comprendre « réussi », vous vous concentrez sur « étudiant » et « examen ».

Le mécanisme d’Attention permet à notre modèle de faire la même chose : pour chaque mot de la phrase, il regarde tous les mots précédents et décide lesquels sont les plus importants pour comprendre le mot actuel et prédire le suivant !

Souvent, le Transformer utilise plusieurs « têtes d’attention » en parallèle. C’est comme si plusieurs personnes lisaient la phrase en même temps, chacune se concentrant sur un type de relation différent (une sur la grammaire, une sur le sens…), pour ensuite mettre leurs analyses en commun.

2. La Réflexion (Ou Feed-Forward)

Après que le mécanisme d’Attention ait permis à chaque mot d’intégrer le contexte des mots précédents, chaque vecteur d’Embedding passe indépendamment à travers plusieurs couches de fonctions mathématiques qui se basent sur des nombres, qu’on appelle des poids. Cet ensemble s’appelle un réseau neuronal.

Cette couche permet au modèle de faire des transformations plus complexes sur les informations que l’Attention a extraites.

Étape 4 : On prend les mêmes et on recommence !

Le vrai pouvoir de GPT vient du fait qu’il ne s’agit pas d’un seul bloc Transformer, mais de plusieurs (des dizaines, voire des centaines !) empilés les uns sur les autres.

Imaginez une usine à plusieurs étages, à chaque étage, nos vecteurs d’Embedding sont traités par les mécanismes d’Attention et de Réflexion. L’information qui sort d’un étage devient ensuite l’entrée de l’étage du dessous.

Les premières couches apprennent à gérer les relations simples entre les mots.

Les couches intermédiaires combinent ces informations pour comprendre des relations plus complexes, la structure des phrases. Les dernières couches comprennent le sens global, le ton, le style. L’information devient de plus en plus riche à mesure qu’elle descend les étages !

Et de plus en plus abstraite et incompréhensible pour nous, pauvres humains.

Étape 5 : L’entraînement

Imaginez qu’on donne à la machine des milliards de textes (des livres, des articles, des pages web…). On lui cache le mot suivant dans chaque phrase et on lui dit : « Devine ! ».

C’est l’entraînement.

Le modèle essaie de prédire le mot suivant en se basant sur les mots précédents.

Au début, il se trompe énormément, mais à chaque erreur on lui dit : « Non, le vrai mot était celui-ci », le modèle ajuste alors ses paramètres internes (les poids!) pour que la prochaine fois qu’il voit une situation similaire, il ait plus de chances de deviner le bon mot.

Ce processus d’ajustement basé sur les erreurs s’appelle la Descente de Gradient.

En jouant à ce jeu de prédiction des milliards de fois sur des milliards de textes, le modèle apprend non seulement quels mots vont souvent ensemble, mais aussi la grammaire, la syntaxe, et même différents styles d’écriture !

Étape finale : La Génération de Texte

Une fois que le modèle est entraîné, il est prêt à générer du texte, en se basant sur une première consigne pour pouvoir prédire des mots associés, le prompt !

- Le modèle prend votre prompt, le transforme en listes de nombres, et les fait passer par tous ses blocs Transformer.

- Il donne une liste de probabilités pour chaque mot possible du vocabulaire. Par exemple, après ‘Il était une fois…‘, le mot ‘un‘ a 80% de chance, ‘une‘ a 10%, ‘le‘ a 5%, ‘dans‘ a 3%…

- Le modèle choisit alors un mot parmi cette liste de possibilités. Il ne prend pas toujours le plus probable pour que le texte ne soit pas trop répétitif. Ce mot est ajouté à la séquence : « Il était une fois un« .

- Le modèle prend cette nouvelle séquence comme entrée et répète le processus : il prédit le mot suivant (« chevalier » ? « chat » ? « jour » ?), choisit un mot, l’ajoute à la séquence…

Et il continue, mot après mot, jusqu’à ce qu’il génère un mot spécial qui signifie « fin de phrase » ou « fin de texte », ou qu’il atteigne une longueur maximale !

Conclusion : Ça marche super bien ce truc !

La puissance de GPT vient de la combinaison de plusieurs éléments :

- L’architecture Transformer et le mécanisme d’Attention qui lui permettent de comprendre le contexte sur de très longues phrases.

- L’empilement des couches qui lui permet d’apprendre des représentations de plus en plus complexes du langage.

- L’entraînement massif sur des quantités de texte gigantesques, lui donnant une connaissance très large du langage et du monde.

- Le processus de génération mot par mot basé sur la prédiction, qui lui permet de créer du texte fluide et varié.

GPT ne « pense » pas : Il est extrêmement doué pour identifier des motifs statistiques complexes dans le langage et les utilise pour prédire la suite la plus probable d’une séquence de mots.

Mais le résultat de cette prédiction, grâce à l’échelle du modèle et des données d’entraînement, est souvent un texte qui nous semble intelligent, pertinent et créatif !