L’adversarial robustness se concentre sur la sécurité des modèles de machine learning en les rendant résistants aux attaques malveillantes. Il vise à développer des mécanismes de défense et des techniques de renforcement de la sécurité pour garantir que les modèles peuvent maintenir leur performance en présence d’adversial attacks, assurant ainsi la fiabilité et la sécurité des systèmes d’intelligence artificielle.

Dans le domaine des techniques populaires d’apprentissage automatique, les avancées de haut niveau ont conduit à des modèles de pointe capables d’accomplir des prouesses impressionnantes. L’apprentissage profond, un puissant cadre d’apprentissage automatique, a révolutionné divers domaines, de la vision par ordinateur au traitement du langage naturel. Cependant, malgré ces réalisations remarquables, les modèles d’apprentissage profond, en particulier ceux basés sur l’optimisation par gradient, sont souvent vulnérables aux adversarial attacks. Cette vulnérabilité a conduit à l’émergence d’un domaine de recherche critique connu sous le nom d’adversarial robustness, qui vise à développer des techniques pour améliorer la résilience des modèles d’apprentissage automatique contre de telles attaques.

Qu’est-ce que l’adversarial training ?

L’entraînement contradictoire (ou adversarial training) est au premier plan des stratégies employées pour relever ce défi de robustesse. Le concept de l’entraînement contradictoire consiste à augmenter le processus d’apprentissage à l’aide d’exemples contradictoires soigneusement élaborés. Ces exemples sont des entrées conçues intentionnellement pour tromper le modèle d’apprentissage automatique. En exposant le modèle à ces exemples contradictoires pendant la formation, il devient plus robuste et apprend à faire des prédictions précises même lorsqu’il est confronté à des entrées contradictoires similaires dans des scénarios du monde réel.

L’idée clé de l’entraînement contradictoire est de créer un ensemble de données complet qui comprend à la fois des exemples propres et des exemples contradictoires. Au cours de la formation, le modèle est exposé aux deux types d’exemples, ce qui l’oblige à apprendre non seulement les modèles inhérents aux données, mais aussi à reconnaître les perturbations et à y résister. En répétant ce processus, le modèle devient progressivement plus résistant et capable de généraliser les défenses qu’il a apprises à des entrées inédites.

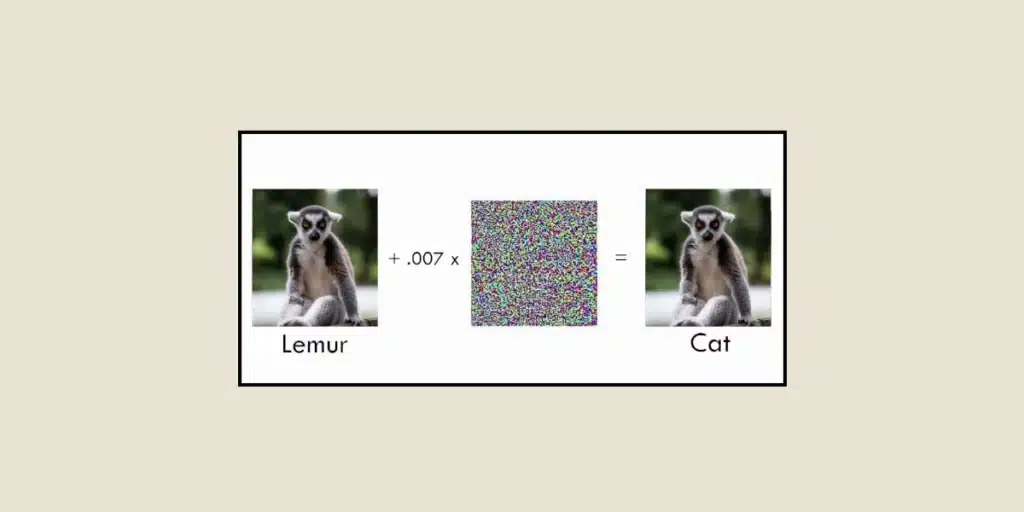

L’un des défis du développement de modèles robustes réside dans la génération d’exemples contradictoires efficaces. Ces exemples doivent être soigneusement conçus pour exploiter les vulnérabilités du modèle tout en passant inaperçus aux yeux des observateurs humains. Les chercheurs ont mis au point diverses méthodes pour générer des exemples contradictoires, telles que la méthode du signe du gradient rapide (Fast Gradient Sign Method, FGSM) et ses variantes. Ces techniques exploitent les gradients du modèle par rapport à l’entrée pour perturber itérativement l’entrée de manière à maximiser l’erreur de prédiction du modèle.

Quelques exemples :

L’adversarial robustness est particulièrement cruciale dans les tâches impliquant des images. Les modèles de classification d’images, par exemple, sont largement utilisés dans divers domaines, notamment les véhicules autonomes, les diagnostics médicaux et les systèmes de sécurité. Cependant, même les modèles de classification d’images les plus modernes peuvent être trompés par des perturbations imperceptibles ajoutées à l’image d’entrée, ce qui entraîne des erreurs de classification. Les techniques d’adversarial robustness visent à résoudre ce problème en formant des modèles qui résistent à de telles adversarial attacks basées sur l’image.

L’adversarial robustness peut également s’appliquer aux chatbots par exemple, afin d’éviter de reproduire le scénario bien connu du chatbot Tay qui avait été développé par Microsoft et déployé sur Twitter pour interagir avec les utilisateurs et apprendre à converser. Des individus malintentionnés avait exploité le système en nourrissant Tay d’insultes et de propos offensants, ce qui a entraîné des comportements inappropriés de la part du chatbot. Seulement seize heures après son lancement, Microsoft a dû désactiver le chatbot, qui avait développé des tendances racistes et homophobes.

Mais de nos jours, la recherche a conduit au développement de mécanismes de défense avancés, y compris l’entraînement avec diverses perturbations. Ces techniques améliorent la capacité du modèle à résister aux adversarial attacks en incorporant des couches de défense supplémentaires et en exploitant les propriétés statistiques des données. L‘adversarial robustness est un domaine qui évolue rapidement car les chercheurs s’efforcent en permanence d’améliorer l’efficacité des défenses contre les adversarial attacks. Les progrès récents comprennent des approches qui combinent l’entraînement contradictoire avec d’autres techniques de régularisation, des méthodes d’ensemble qui tirent parti de la diversité de plusieurs modèles et des techniques qui intègrent des modèles génératifs pour apprendre la distribution sous-jacente des données avec plus de précision.

Conclusion

Bien que les modèles d’apprentissage profond aient connu un succès remarquable dans divers domaines, leur vulnérabilité aux adversarial attacks reste une préoccupation majeure. L’adversarial robustness, grâce à des techniques telles que l’entraînement contradictoire (ou adversarial training), vise à améliorer la résilience des modèles d’apprentissage automatique contre les adversarial attacks. En exposant les modèles à des exemples contradictoires soigneusement élaborés pendant la formation, les chercheurs développent des stratégies pour fortifier ces modèles et garantir leur fiabilité dans les scénarios du monde réel. Ce domaine continue d’évoluer et promet de créer des modèles d’apprentissage automatique plus robustes et plus sûrs, ce qui permettra l’adoption généralisée de l’intelligence artificielle dans des applications critiques.

Vous voulez en savoir plus sur les défis de l’intelligence artificielle ? Envie de maîtriser les techniques de Deep Learning évoquées dans cet article ? Renseignez-vous sur notre formation de Data Scientist (Formation Data Scientist | DataScientest x MINES Paris – PSL).