Was genau ist eigentlich ein GPT-Modell? Es handelt sich um die Technologie, die vielen modernen KI-Anwendungen zugrunde liegt – einschließlich ChatGPT.

Hier geht es nicht um ChatGPT direkt – aber genau von dort kommt der Name.

Falls Du noch nie von GPT gehört hast, bist Du vermutlich trotzdem schon in Berührung damit gekommen: in Form von textgenerativer KI oder „LLM“ (Large Language Model). GPT ist ein Typ solcher Modelle – und die Grundlage für fast alle Systeme, über die gerade gesprochen wird.

GPT steht für „Generative Pre-trained Transformer“ – ein Name, der ziemlich genau beschreibt, wie das Ganze funktioniert.

Klingt trocken? Keine Sorge, wir machen es anschaulich.

Stell Dir GPT als einen Super-Experten für Wortvorhersagen vor. Sein Haupttalent besteht darin, zu erraten, welches Wort wohl am ehesten einen begonnenen Satz vervollständigen würde. Indem er diese Vorhersage immer wieder macht, Wort für Wort, baut er ganze Sätze, Absätze und sogar ganze Artikel!

GPT hat ein wenig bei der Erschaffung dieses Artikels geholfen, aber es gibt immer noch einen Menschen dahinter …

Lass uns gemeinsam die verschiedenen Arbeitsphasen der GPT-Modelle detailliert betrachten, um ihren Lernprozess über die menschliche Sprache zu verstehen.

Schritt 1: Wörter in Zahlen umwandeln

Für uns Menschen haben Wörter Bedeutung – sie wecken Bilder, Gefühle oder Assoziationen. Ein Computer hingegen sieht in Begriffen wie „Katze“ oder „Haus“ lediglich eine Folge von Zeichen. Damit ein GPT-Modell Sprache verarbeiten kann, muss es Wörter in eine für Maschinen verständliche Form übersetzen: in Zahlen.

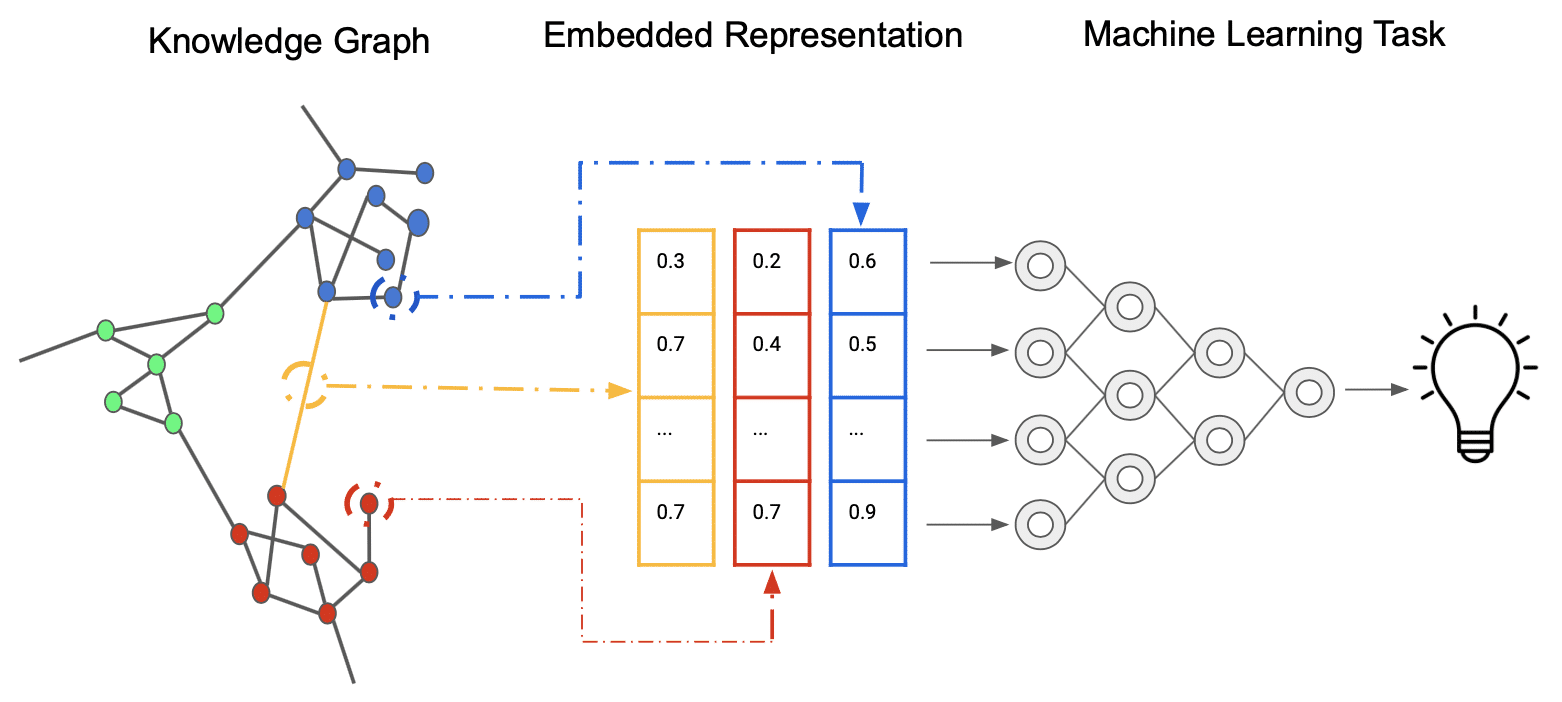

Genau das leisten sogenannte Embeddings. Sie geben jedem Wort (oder sogar jedem Wortteil) einen einzigartigen Zahlen-Code mit – einen sogenannten Vektor. Doch dieser Code ist mehr als nur eine Identifikationsnummer: Er speichert auch Informationen über die Bedeutung und den Zusammenhang des Wortes mit anderen.

Stell Dir eine riesige Bibliothek vor. Jedes Buch darin – also jedes Wort – bekommt ein spezielles Etikett mit einem Barcode (der Embedding-Vektor). Bücher, die thematisch verwandt sind, haben ähnliche Barcodes. Zum Beispiel die Barcodes der Science-Fiction-Bücher untereinander und auf der anderen Seite die der Kochbücher untereinander. Und, wenn es sich um Science-Fiction-Bücher handelt, in denen außerdem Roboter mitspielen, wären ihre Barcodes noch ähnlicher!

Je ähnlicher die Bedeutung zweier Wörter ist, desto „näher“ ist ihre Liste von Zahlen (ihr Embedding-Vektor) in einem imaginären Raum. Ein klassisches Beispiel: Die Embeddings von „König“ und „Königin“ liegen nahe beieinander. Und der Unterschied zwischen „König“ und „Mann“ ähnelt dem zwischen „Königin“ und „Frau“. Das zeigt, dass GPT nicht nur Wörter erkennt, sondern auch Beziehungen zwischen ihnen.

Wenn GPT einen Text verarbeitet, ist der erste Schritt, jedes Wort in seinen zugehörigen Embedding-Vektor zu übersetzen. Nur so kann das Modell überhaupt mit Sprache umgehen – indem es Bedeutung in Zahlen verwandelt.

Schritt 2: Die Wortreihenfolge verstehen (Positionale Kodierung)

Wir haben nun für jedes Wort eine Zahlenliste. Doch Sprache besteht nicht nur aus den Wörtern selbst, sondern auch aus ihrer Reihenfolge. „Die Katze schläft“ ist etwas anderes als „Schläft die Katze“. Du erkennst sofort den Unterschied – für das GPT-Modell ist das jedoch nicht selbstverständlich. Denn das Modell verarbeitet die Wörter parallel – also gleichzeitig –, um schneller zu arbeiten. Dabei geht die Reihenfolge der Wörter verloren.

Um dieses Problem zu lösen, bekommt jedes Wort eine zusätzliche Information mit: einenPositionsmarker. Auch dieser besteht aus einer Zahlenliste – man nennt siepositionale Kodierung. Sie wird mithilfe mathematischer Formeln berechnet und drückt aus, an welcher Stelle im Satz das jeweilige Wort steht.

Wir gehen hier nicht ins Detail – nur so viel: Diese Technik funktioniert erstaunlich gut!

Die positionalen Kodierungen werden einfach zu den ursprünglichen Embedding-Vektoren addiert – also zu den „Barcodes“, die die Wortbedeutung enthalten. So entsteht für jedes Wort ein kombinierter Vektor, der sowohl dessen Bedeutung als auch seine Position im Satz widerspiegelt.

Das Ergebnis ist eine Liste von Vektoren, die den ganzen Satz abbildet – mit vollständiger Information über was gesagt wird und wo es im Satz steht. Damit kann GPT den Satz korrekt interpretieren.

Schritt 3: Der Transformer

Keine Sorge – dieser Transformer hat nichts mit Optimus Prime zu tun.

Der klügste Teil von GPT ist seine Transformator-Architektur. Du kannst sie Dir wie das Gehirn des Modells vorstellen: Sie analysiert die Zahlenlisten aus den vorherigen Schritten, um den Kontext zu erfassen und das nächste Wort vorherzusagen.

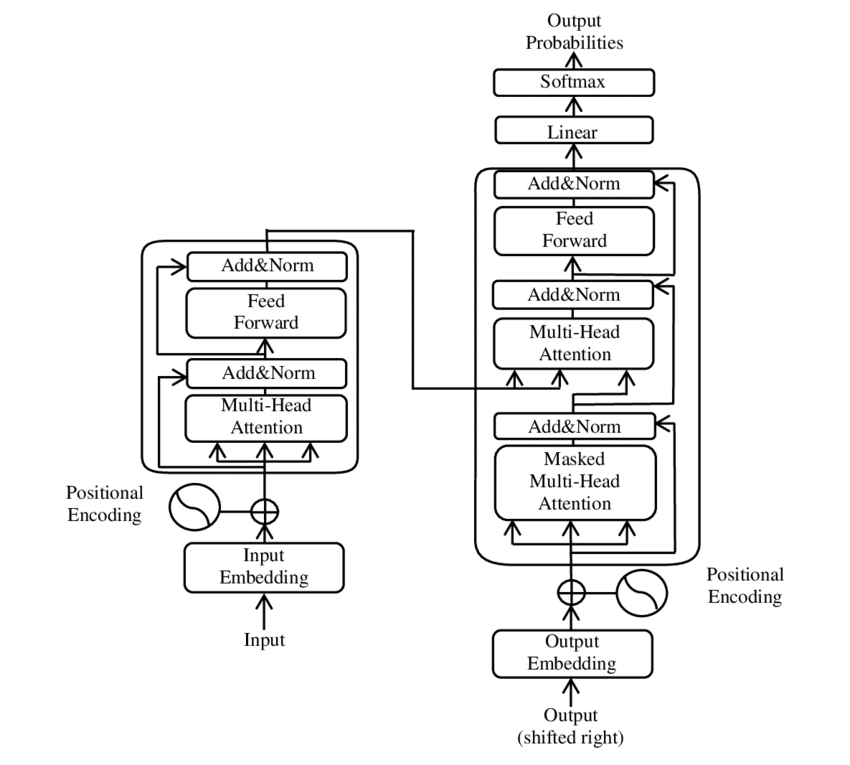

GPT verwendet eine vereinfachte Version des ursprünglichen Transformers – genauer gesagt nur den Decoder. Warum? Weil GPT Texte generiert – und genau dafür ist der Decoder zuständig.

Dieser Transformer-Decoder besteht aus mehreren identischen „Blöcken“, die übereinandergestapelt sind. Je mehr Blöcke, desto leistungsfähiger das Modell.

Jeder dieser Blöcke verarbeitet die Embedding-Vektoren der Wörter in mehreren Phasen:

1. Aufmerksamkeit - die geniale Idee hinter dem Transformer

Wenn Du einen Satz liest, achtest Du nicht auf jedes Wort gleich stark. Um den Sinn zu erfassen, legst Du den Fokus gezielt auf bestimmte Wörter. Zum Beispiel: In „Der Student bei DataScientest, der gut gelernt hatte, hat seine Prüfung bestanden“ konzentrierst Du Dich auf „Student“ und „Prüfung“, um das Wort „bestand“ richtig einzuordnen.

DerSelf-Attention-Mechanismus macht genau das: Das Modell schaut sich für jedes Wort alle vorherigen Wörter an und bewertet, welche besonders wichtig sind – um das aktuelle Wort zu verstehen und das nächste sinnvoll vorherzusagen.

Meistens nutzt der Transformer mehrere Aufmerksamkeitsschichten gleichzeitig. Das ist, als würden mehrere Personen denselben Satz lesen, wobei jede sich auf etwas anderes konzentriert: eine auf Grammatik, eine auf Bedeutung, eine auf Satzstruktur. Am Ende fließen alle Perspektiven zusammen.

2. Die Reflexion - oder: Feed-Forward-Schicht

Nachdem das Modell durch Aufmerksamkeit erkannt hat, welche Wörter für den Kontext wichtig sind, verarbeitet es jedes Wort noch einmal einzeln weiter. Dafür durchläuft der Embedding-Vektor eines jeden Wortes mehrere Schichten mathematischer Funktionen. Diese bestehen aus Zahlenoperationen mit sogenannten Gewichten – das Ganze nennt man ein neuronales Netz.

Diese Phase ermöglicht dem Modell, die durch Aufmerksamkeit gewonnenen Informationen noch tiefer zu analysieren und in abstraktere Bedeutungen zu überführen.

Schritt 4: Viele Schichten - viel Verstehen

Die eigentliche Stärke von GPT liegt nicht darin,was es tut – sondernwie oft. Denn GPT besteht nicht nur aus einem Transformer-Block, sondern aus vielen: Dutzende, manchmal sogar Hunderte werden übereinandergestapelt.

Stell Dir das Modell wie eine mehrstöckige Fabrik vor. Auf jeder Etage werden die Embedding-Vektoren durch Aufmerksamkeit und Feed-Forward weiterverarbeitet. Die Ergebnisse aus einer Schicht dienen dabei als Eingang für die nächste – Etage für Etage wird die Information verfeinert.

Die unteren Schichten erkennen einfache Zusammenhänge zwischen Wörtern – zum Beispiel, dass „Katze“ oft mit „schnurren“ zusammen vorkommt.

Die mittleren Schichten kombinieren diese Informationen zu komplexeren Strukturen: Sie verstehen etwa, wie sich ein Nebensatz in einen Hauptsatz einfügt.

Die oberen Schichten erkennen schließlich den Gesamtsinn, den Tonfall, den Stil – oder ob ein Satz vielleicht ironisch gemeint ist.

Je höher wir hinaufsteigen, desto abstrakter wird das, was das Modell versteht – und desto schwerer fällt es uns Menschen, diese „Gedankengänge“ nachzuvollziehen.

Schritt 5: Das Training

Stell Dir vor, wir geben dem Modell Milliarden von Texten: Bücher, Artikel, Webseiten … Und in jedem Satz decken wir ein Wort ab und sagen: „Rate, welches fehlt!“

Das ist das Grundprinzip des Trainings.

GPT versucht, das nächste Wort auf Basis der bisherigen Wörter vorherzusagen. Am Anfang liegt es oft daneben – aber jedes Mal sagen wir: „Nein, das richtige Wort war dieses.“ Dann passt das Modell seine internen Einstellungen (die sogenannten Gewichte) an.

Diesen Lernprozess nennt man Gradientenabstieg: Bei jedem Fehler wird das Modell ein kleines Stück klüger.

Indem GPT dieses Vorhersagespiel Milliardenfach wiederholt, lernt es nicht nur, welche Wörter häufig zusammengehören – es entwickelt ein Gespür für Grammatik, Satzbau, Sprachstile und sogar für komplexe Konzepte. So wird aus reinem Raten nach und nach beeindruckende Sprachkompetenz.

Letzter Schritt: Die Textgenerierung

Sobald das GPT-Modell trainiert ist, kann es Texte generieren – und zwar basierend auf einer Eingabe, dem sogenannten Prompt.

- Das Modell nimmt Deinen Prompt, wandelt die Wörter in Zahlen (Embeddings) um und schickt sie durch alle seine Transformer-Blöcke.

- Es gibt eine Liste von Wahrscheinlichkeiten für jedes mögliche nächste Wort aus. Zum Beispiel: Nach „Es war einmal…“ könnte „ein“ mit 80 % Wahrscheinlichkeit folgen, „eine“ mit 10 %, „der“ mit 5 % und so weiter.

- GPT wählt nun ein Wort aus dieser Liste. Dabei nimmt es nicht immer das wahrscheinlichste – sonst würden die Texte schnell eintönig wirken. Stattdessen wählt es zufällig aus den wahrscheinlichsten Kandidaten aus.

- Das gewählte Wort wird an den Text angehängt, z. B.: „Es war einmal ein“. Diese neue Sequenz wird erneut durch das Modell geschickt, um das nächste Wort vorherzusagen.

Und so geht es weiter – Wort für Wort –, bis ein spezielles Endsignal erzeugt wird oder die maximale Textlänge erreicht ist.

Fazit: Kein Denken, aber beeindruckende Vorhersagekraft

Die Stärke von GPT liegt in der Kombination mehrerer Schlüsselelemente:

-

Der Transformer-Architektur mit ihrem Aufmerksamkeitsmechanismus, die es dem Modell erlaubt, auch in langen Texten den Kontext zu erfassen.

-

Der gestapelten Schichtenstruktur, die zunehmend komplexere Sprachmuster erlernt – von Wortbeziehungen bis hin zu Stil und Ton.

-

Dem umfangreichen Training auf riesigen Textmengen, das GPT ein breites Sprachverständnis und viel Weltwissen verleiht.

-

Dem Wort-für-Wort-Vorhersageprinzip, das natürliche, flüssige und überraschend kreative Texte ermöglicht.

GPT „denkt“ nicht wie ein Mensch. Aber es ist extrem gut darin, komplexe statistische Muster in der Sprache zu erkennen – und so sehr überzeugend vorherzusagen, was als Nächstes kommt.

Das Ergebnis? Texte, die für uns intelligent, relevant und manchmal sogar originell wirken.

Wenn Dich das Thema fasziniert: DataScientest bietet praxisnahe Weiterbildungen an, die ideal sind, um noch tiefer in die Funktionsweise von Modellen wie GPT einzusteigen.