Pour définir un modèle prédictif, les datas scientists font appel à de multiples observations. Mais si l’étude de ces observations permet d’aboutir à un résultat optimal, les experts de la data disposent souvent de peu de temps pour analyser l’ensemble des hypothèses. Alors comment trouver le bon modèle en un minimum de temps ? C’est à cet instant qu’intervient l’optimisation bayésienne. De quoi s’agit-il ? Comment cela fonctionne-t-il ? Les réponses sont ici.

Qu'est-ce que l’approche bayésienne ?

À travers ce théorème, vous avez une valeur y qui est fonction de x. L’idée est alors de déterminer la valeur de x en optimisant la valeur de y. Ici, x est constitué d’un ensemble de paramètres (ou d’observation).

Concrètement, cela peut s’appliquer dans une multitude de situations, telles que la fixation d’un prix idéal pour maximiser les marges, la configuration d’une application ou d’une base de données pour maximiser ses performances, la gestion des paramètres pour optimiser l’apprentissage supervisé, etc.

Dans toutes ces hypothèses, les Data Scientists ne disposent que d’un nombre limité d’observations pour atteindre un résultat optimal (que ce soit à cause de contraintes temporelles, financières ou matérielles).

En effet, pour définir le meilleur modèle, il faut généralement tester de nombreuses hypothèses, réaliser plusieurs entraînements et validations. Mais toutes ces phases de tests prennent du temps. Il n’est donc pas possible d’étudier une quantité illimitée d’hypothèses.

Pour faire face à ces contraintes, l’optimisation bayésienne a été mise en place.

Comment fonctionne l’optimisation bayésienne ?

L’idée centrale de l’optimisation bayésienne est de minimiser le nombre d’observations tout en convergeant rapidement vers la solution optimale. Pour cela, il convient de connaître trois principes fondamentaux.

Le processus Gaussien

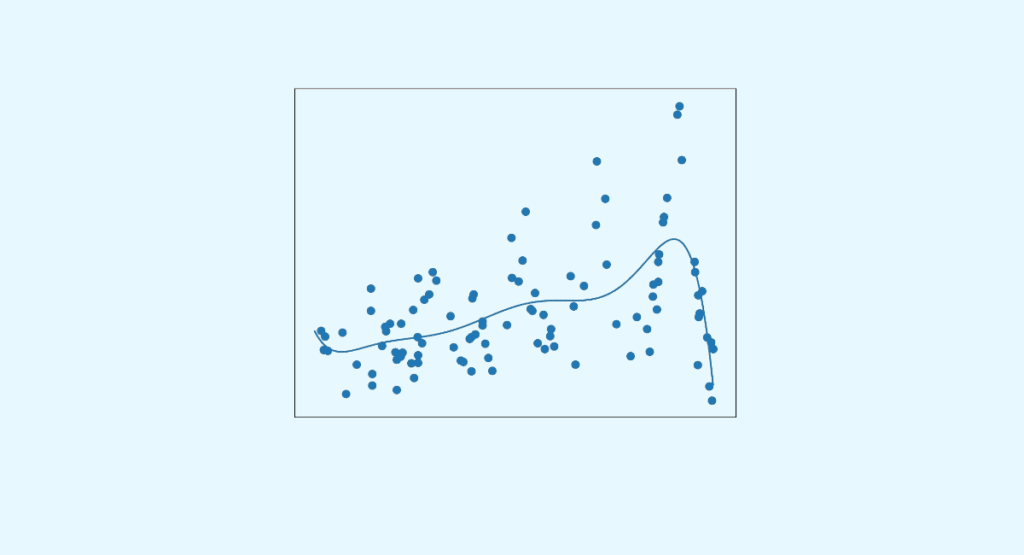

L’idée de l’approche bayésienne est d’exploiter les observations connues pour en déduire des probabilités d’événement qui n’ont pas encore été observées. Afin d’aboutir à cette conclusion, il convient de déterminer pour chaque valeur X la distribution de probabilité.

Pour cela, la méthode la plus efficace est sans aucun doute le processus gaussien. Celui-ci permet d’identifier la valeur la plus probable (appelée moyenne µ) et la dispersion probable de la valeur autour de la moyenne (appelé écart-type σ). Cet écart-type σ s’affaiblit à mesure que vous vous rapprochez d’un point déjà observé.

Idéalement, il faudra calculer ces valeurs et ces distances pour chaque point d’observation. Mais dans la pratique, cette représentation exhaustive n’est pas possible faute de temps. Il convient donc de sélectionner les points à évaluer.

L’exploration et l’exploitation

Pour concevoir un modèle prédictif performant, les Data Scientists doivent définir les points les plus pertinents. Cela se passe en deux temps :

- L’exploration : celle-ci est intéressante lorsque l’écart-type est particulièrement grand. Autrement dit, la variable inconnue dans l’espace de recherche est élevée. Cela permet alors de tester plusieurs modèles et d’améliorer la connaissance de la fonction à optimiser.

- L’exploitation : à ce stade, il s’agit d’affiner les modèles testés en amont. L’idée est de trouver le point maximum ou maximal. Pour cela, les Data Scientists exploitent la moyenne µ. Si celle-ci se situe dans les extrêmes, il est plus facile d’identifier le bon modèle.

Attention, il convient de trouver le juste équilibre entre l’exploration et l’exploitation. En effet, si vous privilégiez l’exploration, vous risquez de laisser de côté d’autres modèles éventuellement plus performants. À l’inverse, si vous favorisez l’exploitation, vous pourriez ignorer des améliorations nécessaires.

La fonction d’acquisition

La fonction d’acquisition permet de trouver le bon compromis entre ces deux variables. En effet, pour chaque point de l’espace de recherche, la fonction identifie un potentiel d’optimisation. Parmi tous ces points, la fonction identifie un maximum. C’est le prochain point à tester. Il suffit de répéter le calcul autant de fois que nécessaire jusqu’à obtenir une convergence entre le maximum et le minimum. Ce couple de paramètres est celui qui doit permettre d’atteindre la meilleure performance.

Bon à savoir : Des bruits peuvent altérer les données et rendre plus difficile l’apprentissage. Alors pour éviter cette situation, il est primordial de vérifier que l’environnement soit suffisamment stable et les observations reproductibles avant toute utilisation de l’optimisation bayésienne.

Comment mettre en pratique l’optimisation bayésienne ?

Pour simplifier les calculs de l’optimisation bayésienne, le plus simple est d’utiliser de bons outils. Comme le package Python scikit-optimize ou bayesian-optimization. Il suffit alors de définir un espace de recherche, et l’outil se chargera ensuite de trouver les points à fort potentiel, notamment grâce au processus Gaussien. Là encore, il faudra relancer Python jusqu’à obtenir un résultat satisfaisant.