À une époque où les deepfakes en image et vidéo prolifèrent sur internet. De nouvelles applications servant à les reconnaître et à les cataloguer font leur apparition. Cependant, un nouvel adversaire pourrait bientôt faire son entrée, les deepfakes audio. En effet, Microsoft a récemment publié une démo de son nouvel outil VALL-E, un chatbot audio capable de synthétiser votre voix avec un simple échantillon de trois secondes.

Comment fonctionne VALL-E ?

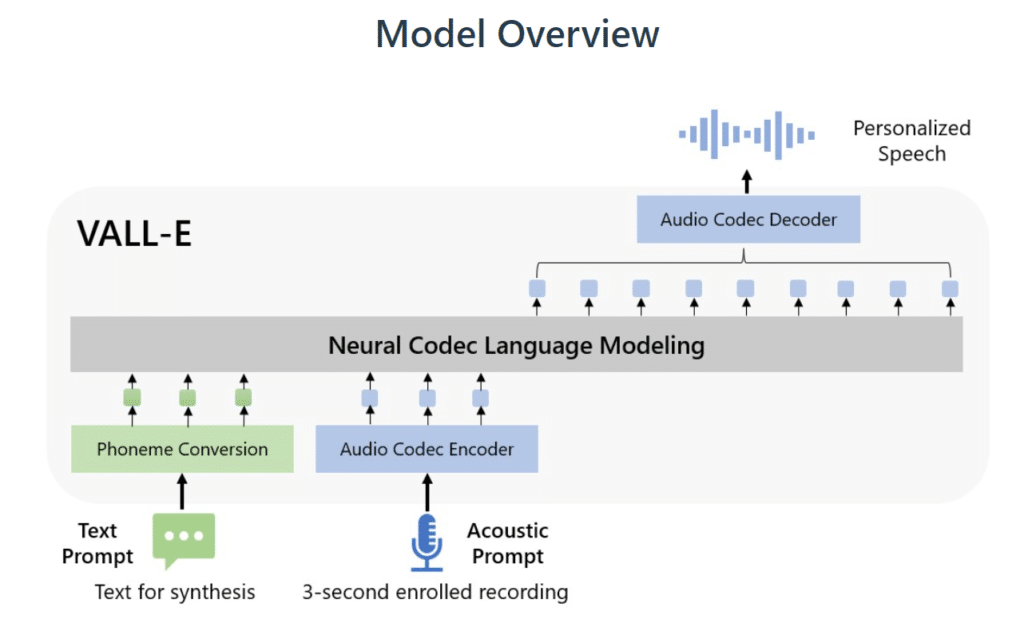

VALL-E est un modèle de synthèse vocale basé sur le machine learning, qui utilise EnCodec, une technologie de compression audio. Grâce à cela, il peut analyser un échantillon audio de trois secondes, afin de décomposer les informations de la voix en tokens. Ensuite, son système de machine learning fait correspondre les données enregistrées avec ce qu’il a appris à partir de 60 000 heures de discours.

Cette bibliothèque d’enregistrement provient de LibriLight et regroupe des discours de 7 000 locuteurs provenant de livres audio. Afin que VALL-E génère un résultat pertinent, l’échantillon qu’il cherche à reproduire doit correspondre étroitement à une voix dans les données d’apprentissage.

LANCEZ VOTRE CARRIÈRE :

DEVENEZ DATA SCIENTIST !

Une reconversion dans le big data vous intéresse, mais vous ne savez pas par où commencer ? Découvrez notre formation de Data Scientist.

LANCEZ VOTRE CARRIÈRE :

DEVENEZ DATA SCIENTIST !

Une reconversion dans le big data vous intéresse, mais vous ne savez pas par où commencer ?

Quels sont les risques d’utilisation ?

L’imitation de la voix de VALL-E est bluffante et Microsoft propose des dizaines d’exemples pour illustrer son propos. Malgré ça, des internautes s’interrogent sur l’utilisation malveillante de cette technologie. L’entreprise se veut rassurante, répondant être au courant des risques liés comme l’usurpation d’identité, la création de deepfake audio ou encore le phising.

Elle affirme que le code source de VALL-E ne sera pas disponible aux utilisateurs. De plus, pour atténuer ces risques, le géant de l’informatique compte développer un modèle de détection pour discerner si un clip audio a été synthétisé par VALL-E.

Avec une popularité grandissante pour les technologies comme ChatGPT ou les modèles génératifs comme DALL-E ou Stable Diffusion, il n’est pas étonnant d’y voir des utilisations malveillantes. C’est pourquoi des régulations ou des outils de reconnaissances doivent être développés et mis en place pour garder une bonne utilisation de ces systèmes. Si cet article vous a plu, et si vous envisagez une carrière dans les métiers de la Data Science, découvrez nos offres de formations sur Datascientest.

Source : valle-demo.github.io