One-Hot Encoding est une technique d’encodage qui permet de convertir des données catégorielles en vecteurs numériques exploitables par les modèles de machine learning. Découvrez tout ce qu’il faut savoir sur cette méthode !

Les algorithmes de machine learning sont d’incroyables calculateurs, mais ils ont un gros point faible : ils ne comprennent pas le texte. Pour eux, les mots comme « bleu », « Paris » ou « chat » sont du bruit pur. Or, dans les jeux de données du monde réel, les variables catégorielles sont partout. Nom d’un produit, statut marital, pays, type de carte bancaire… ces colonnes non numériques représentent jusqu’à 40 % des données traitées dans les cas d’usage en IA.

Alors, pour les rendre compréhensibles par nos modèles, il faut les traduire. Et l’une des méthodes les plus simples et populaires pour ça, c’est le One-Hot Encoding : une technique qui transforme chaque catégorie en vecteur binaire, lisible, sans ambiguïté. Mais derrière sa simplicité se cache une mécanique à double tranchant : utile, mais parfois trop lourde. Voyons donc pourquoi, quand, et comment bien l’utiliser !

Variables catégorielles : un défi omniprésent

On les retrouve dans tous les tableaux de données, et pourtant elles passent souvent inaperçues au premier coup d’œil : les variables catégorielles sont ces colonnes qui ne contiennent pas des chiffres, mais des noms, des types, des statuts. Par exemple, si vous avez une colonne « couleur » avec les valeurs « rouge » « vert » « bleu », vous êtes face à une variable catégorielle.

Le souci ? Les algorithmes de machine learning, qu’ils soient linéaires, en arbre ou à base de réseaux de neurones, ne savent manipuler que des nombres. Si vous laissez des chaînes de caractères dans vos données, vous pouvez être certain que vos modèles vont planter. Ou pire, apprendre n’importe quoi.

Et il ne suffit pas de convertir ces chaînes en nombres arbitraires (« rouge » = 1, « vert » = 2, etc.). Car dans ce cas, le modèle interprète ces chiffres comme une hiérarchie ou une distance, ce qui est souvent faux. C’est pourquoi l’encodage est une étape incontournable du prétraitement ! Et le One-Hot Encoding est souvent la solution par défaut. Mais avant d’y plonger, prenons un instant pour bien comprendre son principe.

Le principe qui transforme le texte en vecteurs

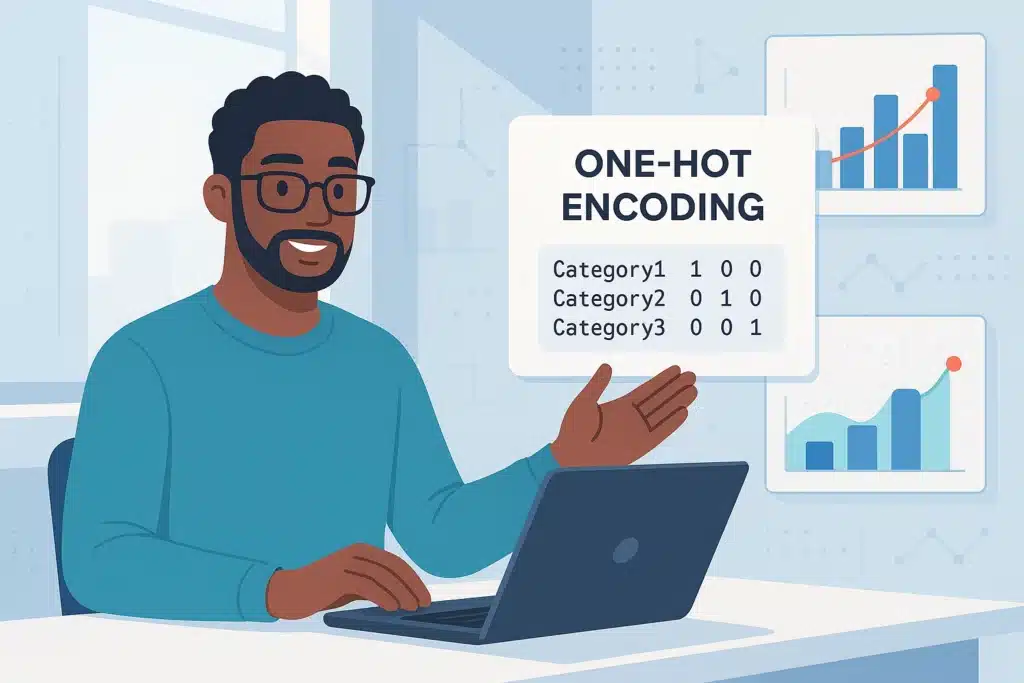

Le One-Hot Encoding, qu’on pourrait traduire par encodage « binaire à chaud », repose sur une idée simple mais redoutablement efficace : créer une colonne pour chaque valeur possible d’une variable, puis activer uniquement celle qui correspond à la donnée observée. On remplit les autres avec des zéros.

Prenons un exemple : vous avez une colonne « couleur » avec les valeurs « rouge », « vert » et « bleu ». En One-Hot Encoding, on crée trois colonnes : couleur_rouge, couleur_vert et couleur_bleu. Si une ligne contient « rouge », on met un 1 dans couleur_rouge et des 0 dans les deux autres. Si c’est « bleu », ce sera 1 dans couleur_bleu, et 0 ailleurs. L’intérêt ? On évite d’induire un ordre fictif entre les catégories. Car si on encode « rouge » = 1, « vert » = 2, « bleu » = 3, un algorithme pourrait penser que « bleu » > « vert » > « rouge »… alors que ces valeurs n’ont aucun sens ordinal.

Avec le One-Hot Encoding, chaque catégorie est traitée comme une entité indépendante, sans lien numérique ou hiérarchique avec les autres. Ainsi, les modèles n’introduisent aucun biais lié à une fausse structure dans les données. Ce type d’encodage est donc parfaitement adapté aux variables catégorielles nominales, c’est-à-dire sans logique d’ordre (comme le genre, la ville, ou le type de contrat).

Mais comme on le verra plus loin, cette approche a aussi ses revers. Surtout quand le nombre de catégories explose.

Implémentation en Python : pandas ou scikit-learn, le match des encodeurs

Le One-Hot Encoding est propre, sans biais de hiérarchie, compatible avec tous les modèles. Mais il a un sacré défaut structurel : il génère des colonnes à foison.

Prenons un exemple bien réel. Vous travaillez sur un jeu de données de e-commerce avec une variable « produit » qui contient 1 200 références différentes. Après One-Hot Encoding, vous aurez donc 1 200 colonnes. Ce n’est pas juste un problème esthétique. C’est une bombe à retardement pour votre modèle. Deux problèmes concrets émergent.

D’abord, une explosion de la dimensionnalité, car chaque nouvelle catégorie crée une colonne. Ceci alourdit considérablement le modèle, augmente le temps d’entraînement et peut induire de l’overfitting. Surtout pour des modèles sensibles comme les KNN ou les arbres de décision.

Second souci : une sparsity extrême. Dans une matrice de 1 200 colonnes, il n’y a qu’un seul 1 par ligne. Donc plus de 95% de zéro dans la majorité des cas. Si vous stockez ça en format dense, bon courage à votre RAM !

Le One-Hot Encoding n’est donc pas scalable sans précaution. Dès qu’on touche à des variables à haute cardinalité, il faut réfléchir à deux fois avant d’appuyer sur « encode ».

Jusqu’où peut-on aller ? Les seuils critiques à connaître

À partir de combien de modalités faut-il éviter le One-Hot Encoding ? Il n’y a pas de règle absolue, mais les retours de la communauté sont clairs : au-delà de 10 à 15 catégories uniques, mieux vaut envisager une alternative.

Plusieurs problèmes s’accumulent. La multicolinéarité, avec le fameux « dummy trap ». En créant une colonne par modalité, vous introduisez une redondance totale (la somme de toutes les colonnes donne toujours 1). Certains modèles peuvent en souffrir, surtout les régressions linéaires. La solution : supprimer une colonne de référence.

L’instabilité sur les petits jeux de données. Avec peu d’observations mais beaucoup de catégories, le risque d’overfitting est maximal. De plus, les données peuvent être déséquilibrées. Certaines catégories peuvent n’apparaître qu’une ou deux fois, créant des colonnes quasi-vides inutilisables.

Bref, plus il y a de modalités, plus le One-Hot devient une arme à double tranchant. Heureusement, ce n’est pas la seule option dans la boîte à outils du data scientist.

Quand utiliser One-Hot Encoding… ou pas

Choisir sa méthode d’encodage est très important. Voici quelques cas où le One-Hot Encoding est pertinent… et d’autres où il vaut mieux s’en abstenir.

Cette approche est parfaite face à des variables avec peu de modalités uniques (pays, genre, type de contrat…), ou avec des données équilibrées, sans catégories rares.

Elle est également idéale sur des modèles simples ou linéaires (régression logistique, SVM, perceptron), ou pour des cas d’usage explicables : churn, scoring client, marketing.

En revanche, c’est à éviter sur des colonnes avec des dizaines ou centaines de catégories. Idem sur des jeux de données faiblement peuplés ou avec de nombreuses valeurs manquantes.

Alternatives malines : quand le One-Hot ne suffit plus

Quand le nombre de catégories explose, le One-Hot Encoding montre ses limites. Heureusement, l’écosystème du machine learning propose plusieurs alternatives, chacune avec ses cas d’usage privilégiés.

Avec le Label Encoding, chaque catégorie est remplacée par un entier unique. Simple et rapide, mais à éviter avec des modèles linéaires ou basés sur la distance. Pour cause, il introduit un ordre artificiel (« vert » = 1, « rouge » = 2, « bleu » = 3…). C’est donc une méthode utile pour les arbres de décision, qui ne sont pas sensibles à l’ordre.

Une autre approche est le Target Encoding, aussi appelé Mean Encoding. On remplace chaque catégorie par la moyenne de la variable cible pour cette catégorie. Par exemple : si les clients « Premium » achètent en moyenne pour 300 €, on encode « Premium »avec 300. C’est très performant sur les variables à forte cardinalité. En revanche, attention au risque de fuites de données si on l’utilise sans cross-validation adaptée. Et attention au surapprentissage.

Par ailleurs, popularisés par le deep learning, les « embeddings » transforment les catégories en vecteurs continus appris automatiquement par le modèle. Chaque modalité devient un point dans un espace vectoriel, proche des autres si elles ont des comportements similaires. C’est ultra-efficace sur les très gros jeux de données, notamment en NLP ou recommandation produit.

Citons aussi le Feature Hashing. On n’encode plus chaque catégorie explicitement, mais on la passe dans une fonction de hachage qui l’attribue à une colonne parmi un nombre fixe. Moins lisible, mais très utile pour éviter l’explosion de colonnes. À manier avec précaution, car plusieurs catégories peuvent tomber dans le même « bucket ». On parle alors de « hash collision ».

Parmi ces différentes stratégies, à vous de choisir la plus adaptée selon la taille du jeu de données, le modèle utilisé, et la nature de vos catégories.

One-Hot Encoding et Deep Learning : alliance ou obsolescence ?

Dans les architectures de deep learning, on pourrait croire que le One-Hot Encoding est dépassé. Et pourtant, il est encore largement utilisé… dans certains cas. Il reste utile dans des tâches simples de classification avec peu de classes, ou en prétraitement de séquences courtes (ex. : caractères ou tokens en NLP). C’est une approche qui reste également pertinente dans des architectures où on n’a pas d’embedding learnable ou peu de données.

Mais dès qu’on touche à des problématiques plus profondes (NLP, recommandation, données utilisateurs…), on lui préfère clairement les embeddings, qui sont plus compacts, plus riches en signification, et appris directement par le modèle. Exemple typique : plutôt que de transformer chaque mot en une colonne binaire longue comme le bras, on utilise un embedding vectoriel de 300 dimensions qui capte du sens, du contexte, des similarités.

Conclusion : One-Hot Encoding, une méthode simple pour encoder vos variables catégorielles

Le One-Hot Encoding, c’est un peu le couteau suisse du data scientist débutant : facile à prendre en main, compatible avec presque tous les modèles, et suffisamment robuste pour un grand nombre de cas pratiques. Mais derrière cette simplicité se cachent des pièges : explosion de colonnes, matrices creuses, overfitting, multicolinéarité… autant de raisons de ne pas l’utiliser les yeux fermés. Bien encadré, bien calibré, il reste un standard incontournable du prétraitement. Mal employé, il peut devenir un fardeau qui pèse sur vos performances.

Si vous souhaitez approfondir la maîtrise des techniques de prétraitement des données, d’encodage, de machine learning et de deep learning, les formations Intelligence Artificielle de DataScientest sont faites pour vous. Nos programmes complets vous permettront de comprendre les fondements des modèles IA, manipuler des jeux de données réels, implémenter des pipelines complets avec Scikit-learn et TensorFlow. Vous apprendrez aussi à exploiter le meilleur de chaque méthode comme le One-Hot, les embeddings ou le PCA.

Grâce à une pédagogie axée sur la pratique et des cas concrets, vous deviendrez capable de déployer des modèles performants et d’obtenir une certification reconnue. Nos formations s’adaptent à votre rythme : BootCamp intensif, format continu ou en alternance, avec des dispositifs de financement comme le CPF ou France Travail. Rejoignez DataScientest et donnez du sens aux données !

Vous savez tout sur le One-Hot Encoding. Pour plus d’informations sur le même sujet, découvrez notre dossier complet sur les Category Encoders et notre dossier sur le Deep Learning.