Le métier de Data Analyst repose sur l’exploitation efficace des données pour en extraire des informations utiles à la prise de décision. Pour y parvenir, il est essentiel de maîtriser un certain nombre d’outils qui couvrent les différentes étapes du cycle d’analyse (ou pipeline) : extraction, exploration, transformation, visualisation, et partage.

Dans cet article, nous vous présentons 7 catégories d’outils essentiels pour les data analysts, accompagnées à chaque fois d’une alternative selon les contextes ou préférences. Que vous soyez en poste ou en transition, ce tour d’horizon vous aidera à structurer votre boîte à outils.

1. Langage de programmation : Python (principal) et R (alternatif)

Tout Data Analyst qui se respecte commence par choisir son langage de prédilection. Python est aujourd’hui le chouchou du monde de la data : c’est un langage à usage général, que de nombreux Data Analysts (et autres) utilisent couramment. Grâce à sa syntaxe claire et lisible, Python est réputé facile à apprendre et très polyvalent. Il dispose surtout d’un écosystème immense de bibliothèques (pandas pour la manipulation, NumPy / SciPy pour les calculs, scikit-learn pour le ML, etc.), ce qui le rend idéal pour (presque) toutes les tâches d’un Data Analyst. C’est un peu le couteau suisse de la data.

Python propose également Jupyter Notebook (et sa version plus moderne JupyterLab) qui est sans doute le notebook le plus célèbre. C’est une application web open source qui permet de combiner code, visualisations, équations mathématiques et texte dans un même document. On peut ainsi écrire du code Python, voir aussitôt le résultat graphique qui s’affiche dans la page, annoter d’explications au milieu des cellules, et tout sauvegarder dans un seul fichier .ipynb et l’exporter dans plusieurs formats (pdf, docx, html…). Jupyter supporte plus de 40 langages (avec l’accent sur Python), et on l’utilise aussi bien pour le prototypage rapide que pour les présentations de résultats.

En alternative, on pense aussitôt à R, dont la popularité reste forte dans la communauté data. Avec ses packages du tidyverse (dplyr, ggplot2, etc.), R excelle dans l’analyse statistique et la création de graphiques de qualité. R peut être préféré si vous travaillez dans un environnement très axé statistiques (université, recherche) ou si votre équipe maîtrise déjà ce langage. En somme, Python et R se tiennent souvent à égalité : Python domine souvent en entreprise (ML, automatisation, big data), tandis que R brille en analyse pure et visualisation raffinée.

2. Outil de visualisation de données (dataviz) : Matplotlib (principal) et ggplot2 (alternatif)

Une fois le code et la data prêts, il faut pouvoir visualiser les résultats. Côté Python, Matplotlib est la bibliothèque de visualisation classique (2D). Elle permet de tracer toutes sortes de graphiques (courbes, histogrammes, barres, nuages de points, etc.) avec un contrôle fin sur la forme (titres, légendes, couleurs). Par exemple, Matplotlib produit des tracés de qualité dans tous les formats et environnements. En pratique, on l’utilise souvent via son interface pyplot pour créer rapidement un graphique linéaire de l’évolution de ventes au fil du temps, ou un histogramme de distribution d’une variable. Pour des visuels plus “jolis” et modernes en Python, on peut aussi utiliser Seaborn et Plotly, mais Matplotlib reste la base robuste et incontournable.

En R, la référence est ggplot2, qui suit la célèbre Grammar of Graphics. On commence avec ggplot() et on ajoute des couches de géométrie (geom_point, geom_line, etc.), de colorisation, de facettes, etc. Cela permet de construire des visualisations complexes de façon déclarative et modulaire. Par exemple, avec ggplot2 on peut superposer un nuage de points coloré et une courbe de régression en quelques lignes, tout en séparant le même graphique pour deux sous-groupes avec un facet. La force de ggplot2, c’est sa logique élégante et le rendu esthétique par défaut. Par ailleurs, d’autres outils comme Datawrapper existent pour la dataviz, mais Matplotlib et ggplot2 restent les bases programmatiques préférées des analystes débutants et intermédiaires.

3. Outil ETL / manipulation de données : Pandas (principal) et KNIME (alternatif)

Une large partie du travail de Data Analyst consiste à préparer les données : nettoyer, filtrer, transformer, agréger… Pour cela, les bibliothèques de manipulation de données sont nos alliées. En Python, le graal est Pandas, cette librairie fournit le type DataFrame, structure de données tabulaire efficace, et regorge de méthodes pour traiter les données : filtres, jointures (merge), tri, groupby, pivot, nettoyage de valeurs manquantes, etc. Par exemple, un Data Analyst peut charger plusieurs fichiers CSV, les concaténer, appliquer des calculs statistiques ligne par ligne, et obtenir en une ou deux commandes Python des données prêtes à l’analyse. Pandas reste l’outil de facto pour le nettoyage de données dans les scripts Python.

En alternative (particulièrement en no-code/low-code), il existe des plateformes comme KNIME Analytics Platform. KNIME est un logiciel ETL open source gratuit qui fonctionne par glisser-déposer de “nœuds” de données. Selon KNIME, sa plateforme assure des processus ETL puissants, évolutifs et reproductibles. Concrètement, un analyste peut, sans programmer, récupérer des sources diverses (Excel, base SQL, API Web), puis faire glisser des modules pour filtrer, agréger, joindre, nettoyer, et enfin exporter vers d’autres outils (par exemple envoyer le résultat vers Power BI ou une base de données). C’est très utile pour ceux qui préfèrent une interface visuelle : on voit le flux de données comme un diagramme de flux, ce qui peut rendre plus intuitif le traitement de gros volumes ou la création de pipelines réutilisables. KNIME ou des outils comme Alteryx/Power Query peuvent ainsi être préférés pour des tâches où on veut rapidement bâtir un ETL sans écrire de code long.

4. Outil de dashboarding : Power BI (principal) et Tableau (alternatif)

Au bout du pipeline analytique, il faut souvent présenter les résultats via un tableau de bord interactif ou un rapport visuel. Microsoft Power BI est le leader dans le domaine. Power BI peut se connecter directement à Excel, Azure, SQL Server et à plein d’autres sources, et transforme les données via son moteur Power Query avant de les afficher. Selon le fameux Gartner Magic Quadrant, Power BI est actuellement la meilleure des solutions BI. Il se distingue par un tarif plus abordable (même gratuit pour les petits volumes) et la multiplicité des services compatibles et en particulier son intégration transparente avec l’écosystème Microsoft.

Une alternative BI tout aussi capable est Tableau. Fondé en 2003, il s’est fait une réputation comme « outil de visualisation de données puissant et populaire ».

Son atout : des visualisations très affinées et des fonctionnalités avancées (calculs dans les vues, intégration IA récente). Cependant, Tableau est souvent jugé complexe au départ et assez coûteux (pas de version gratuite). On le préfèrera quand on a un budget d’entreprise, un besoin de visuels professionnels très customisés, et un public exigeant (grands managers, clients VIP).

En résumé, Tableau offre de la sophistication et de la variété visuelle pour de la BI lourde, tandis que Power BI mise sur la simplicité d’accès et l’intégration Office 365. Les deux valent le coup d’œil selon votre contexte : coûts, compétences de l’équipe et contraintes techniques guideront votre choix.

5. Système de gestion de base de données (SGBD) & SQL

Le Système de gestion de base de données est un outil crucial pour le Data Analyst, il permet de stocker les données et forme la première étape du pipeline du Data Analyst. Cependant, un Data Analyst n’a pas toujours le luxe de choisir la base de données sur laquelle il travaille (PostgreSQL, MySQL, Oracle, etc.). Par contre, il doit absolument maîtriser le SQL. C’est la clé pour extraire, filtrer, agréger les données dans la majorité des entreprises. Même en environnement cloud ou big data, des variantes de SQL sont toujours présentes.

Alternative : SQL + ORM (via Python ou R)

Si vous êtes plus à l’aise avec le code, vous pouvez utiliser des bibliothèques comme SQLAlchemy (Python) pour manipuler la base via du code plutôt que du SQL brut. Pratique, mais ne remplace pas une vraie compréhension du SQL.

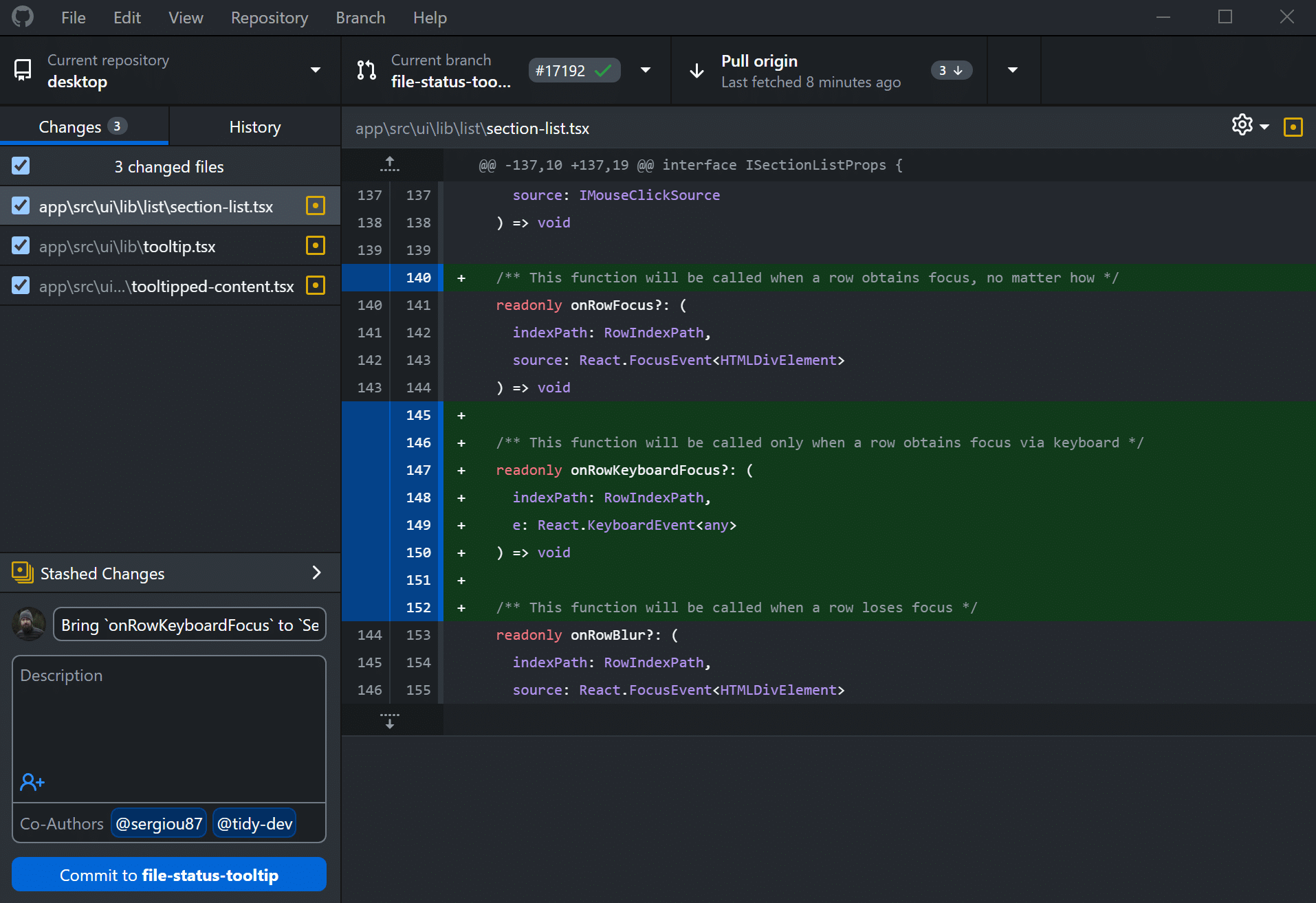

6. Outil de versioning / collaboration : Git + GitHub

Enfin, n’oublions pas l’aspect collaboration et versionnage. Un analyste qui code (scripts Python/R, notebooks, requêtes SQL) a besoin de tracer les modifications et de travailler en équipe. Git est le système de contrôle de version standard et open source. On l’utilise pour suivre l’historique de chaque fichier de code : chaque commit enregistre un changement, ce qui permet de revenir en arrière en cas de pépin. Git est conçu pour aller vite et gérer des projets petits ou très grands, avec des fonctionnalités puissantes (branchements locaux « cheap », indexation, etc.). La plupart des Data Analysts intermédiaires utilisent Git depuis la ligne de commande ou via des clients graphiques légers (ex. GitHub Desktop).

Là-dessus s’agrègent des plateformes collaboratives. Le plus connu est GitHub, un service web d’hébergement de code basé sur Git. GitHub se présente comme « un service d’hébergement open source permettant aux programmeurs de partager le code de leurs projets et de collaborer ». Des millions de développeurs l’utilisent pour travailler ensemble : on crée des repositories, on pousse ses notebooks, on ouvre des pull requests pour réviser le code, etc. Pour un Data Analyst, GitHub facilite la collaboration (partager ses analyses, récupérer celles des collègues, gérer les retours) et sert souvent de portfolio professionnel.

7. Analyse rapide et prototypage (Excel)

À connaître : Excel

Malgré l’essor des outils spécialisés, Excel reste un incontournable dans de nombreuses entreprises. Sa prise en main rapide, ses fonctions de calcul, ses tableaux croisés dynamiques et ses capacités de visualisation en font un excellent outil pour une analyse exploratoire rapide, un prototypage, ou des rapports ponctuels. Il est aussi souvent le point d’entrée ou de sortie des données dans les workflows métiers.

Alternative : Google Sheets

Moins puissant sur les gros volumes de données, mais collaboratif par nature et accessible en ligne. Parfait pour les équipes distribuées ou pour partager des tableaux simples de manière fluide. De plus en plus de connecteurs et d’automatisations sont disponibles pour l’intégrer à des outils cloud ou des API.

Conclusion

En bref, un bon Data Analyst a sa panoplie d’outils bien huilés, à la fois flexibles et complémentaires. On a couvert sept catégories clés :

- Un langage de programmation (Python en tête, R en alternative) pour orchestrer les analyses.

- Un outil de visualisation de données (Matplotlib vs ggplot2) pour explorer et présenter les données sous forme de graphiques.

- Un outil ETL/transformations (pandas vs KNIME) pour nettoyer et préparer les données brutes.

- La maîtrise d’au moins un SGBD et de SQL pour stocker et interroger efficacement de grands volumes de données structurées.

- Un outil de dashboarding (Tableau ou Power BI) pour construire des rapports visuels percutants.

- Un outil de versioning/collaboration (Git/GitHub) pour versionner le code et partager avec l’équipe.

- Un outil de prototypage (Excel) pour créer des modèles et visualisations simples rapidement.

Chaque outil a ses points forts : simplicité, puissance, flexibilité ou coût. L’idée n’est pas de tous les maîtriser à fond d’un coup, mais d’en connaître au moins un par catégorie. Avec ce bagage, un analyste de niveau intermédiaire pourra naviguer entre projets et technologies : il aura la bonne clé à chaque serrure data, qu’il s’agisse d’un petit script exploratoire ou d’un pipeline industriel. Alors n’hésitez pas à tester ces outils, trouver ceux qui collent le mieux à votre contexte et, surtout, garder l’esprit curieux (et un brin léger) dans cette aventure data !