Neuronale Netze Architektur: Der Einsatz von Deep-Learning-Modellen wird für Unternehmen immer notwendiger. Ihre Implementierung stellt jedoch eine Herausforderung dar, wenn es darum geht, ein Modell zu erstellen, das sich gut an die Bedürfnisse anpasst und gleichzeitig effizient und ressourcenschonend ist. Daraus ergibt sich die Notwendigkeit, KI mit einem tieferen Verständnis und mehr Autonomie auszustatten.

In diesem Artikel erfährst du alles über die aufkommende Revolution, neuronale Netze Architektur, die Entwickler von der mühsamen Arbeit des manuellen Designs und der Optimierung befreit. Der Artikel beleuchtet die Herausforderungen, die Funktionsweise und die potenziellen Anwendungen in verschiedenen Bereichen, die eine faszinierende Zukunft für selbstlernende KI erwarten lassen.

Woher kommt der LLM?

Die automatische Suche nach neuronaler Architektur (NAS, Neural Architecture Search) entstand aus dem Bedürfnis heraus, die Erstellung und Parametrisierung von Machine-Learning-Modellen zu optimieren. NAS versucht, die Frage zu beantworten, ob es möglich ist, einen Algorithmus zu entwickeln, der neuronale Netze erstellt, die besser sind als die von Hand erstellten und parametrisierten.

Die ersten Artikel, die sich mit diesem Thema beschäftigen, stammen aus dem Jahr 2016. Zunächst Barret Zoph und Quoc V in ihrem Artikel Neural Architecture Search with Reinforcement Learning. Und kurz darauf Bozen Baken, Otkrist Gupta, Nikhil Naik und Ramesh Raskar in ihrem Artikel Designing Neural Network Architectures using Reinforcement Learning.

Neuronale Netze sind oft schwierig zu erstellen, wenn die zu lösenden Probleme komplexer werden: Die Erstellung ist nicht nur zeitaufwendig, sondern auch anstrengend, erfordert Fachwissen und viele Anpassungen der Parameter.

Um diese Ressourcen besser zu nutzen, automatisieren NAS die Erstellung von neuronalen Netzen.

Die automatische Suche nach neuronaler Architektur verstehen

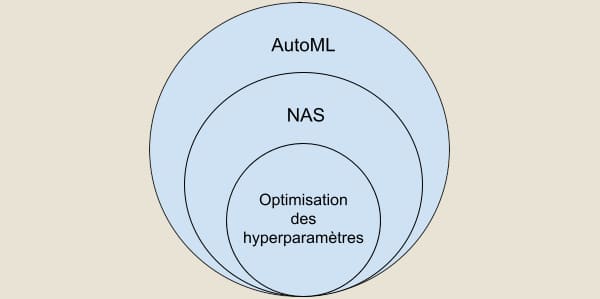

Die automatische Suche nach neuronalen Architekturen ist von Anfang an ein Teilbereich von AutoML oder Automated Machine Learning, einem Bereich, der die langwierigen und iterativen Aufgaben bei der Entwicklung von Machine-Learning-Modellen automatisiert. Die Optimierung von Hyperparametern ist ein Teilbereich der NAS.

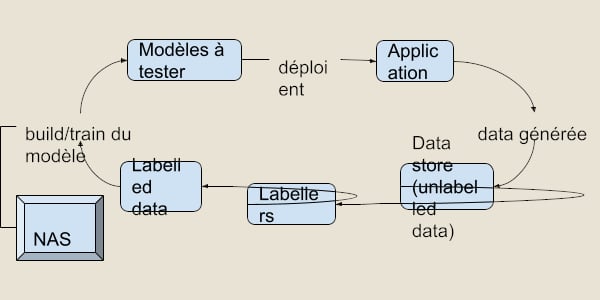

Nachdem wir die Rolle der SINs definiert haben, stellt sich natürlich eine Frage: Wo genau sind sie am Prozess der Modellentwicklung beteiligt?

Nun, die automatische Suche nach der neuronalen Architektur findet im Zugteil des Arbeitsablaufs statt: Wie der Name schon sagt, wird nach der optimalen Architektur des neuronalen Netzes gesucht.

KI, die KI schafft

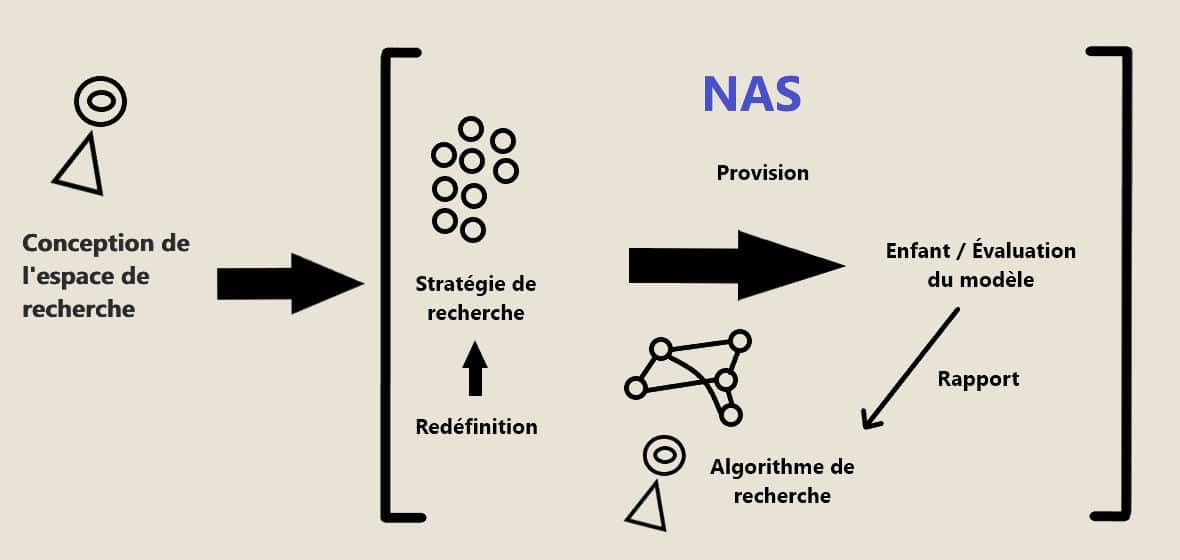

Die automatische Suche nach neuronalen Architekturen hat vier Hauptachsen oder Bausteine, die sie bei der Erstellung eines neuronalen Netzes verwendet:

- Der Suchraum: Er besteht aus der Menge der Architekturkandidaten, aus denen man auswählen kann, sowie den Operatoren, aus denen sie bestehen.

- Die Suchstrategie: Sie bestimmt die Art und Weise, wie die Suche durchgeführt wird. Sie führt eine Stichprobe unter den vorgeschlagenen Architekturen durch, ohne das Modell zu konstruieren oder zu trainieren, sodass man eine Schätzung der theoretischen Leistung des Modells erhalten kann.

- Der Suchalgorithmus: Er erhält die geschätzten Leistungen und optimiert die Parameter, um Kandidaten zu erhalten, die besser abschneiden.

- Die Bewertung: Die Modelle werden von der NAS erstellt und sie werden bewertet und verglichen.

Um die Interaktion zwischen diesen Achsen besser zu verstehen, kann man das folgende Diagramm betrachten.

Die verschiedenen Arten von Ansätzen

Verstärktes Lernen

Die allerersten Ansätze nutzten das Lernen durch Verstärkung. Bei dieser Art von Ansatz wird der Suchraum als eine Umgebung betrachtet, in der man sich bewegen kann und in der man eine Belohnung vergibt, die nach der Methode zur Bewertung der Leistung der erstellten Architektur berechnet wird.

Diese Methode hat jedoch einige Nachteile:

Vor allem die Ressourcen, die benötigt werden, um eine ausreichend leistungsfähige Architektur zu erhalten – Tausende von GPU-Stunden sind dafür notwendig.

Gradientenabstieg

Eine andere Möglichkeit, nach einer differenzierbaren neuronalen Architektur zu suchen, besteht darin, eine Reihe von Parametern durch stochastischen Gradientenabstieg zu optimieren. In diesem Fall stellen die Parameter, auch Gewichte genannt (kontinuierliche Variablen, die mit 𝛼 denotiert werden), die Operationen dar, die von der Kandidatenarchitektur ausgeführt werden.

Sobald die Suche abgeschlossen ist, wird das endgültige Modell erstellt, indem die Operationen, aus denen die Architektur unter Berücksichtigung der Gewichte 𝛼 besteht, abgetastet werden.

Die Methoden des Samplings können variieren, wie z. B. 𝛼 mithilfe einer Softmax-Funktion in eine Wahrscheinlichkeitsverteilung umzuwandeln.

Zusätzlich können Rechen- und Zeitressourcen durch die Implementierung von Mechanismen zum Teilen von Parametern weiter eingespart werden, so dass der Suchraum in mehrere Zellen aufgeteilt wird, die elementare Komponenten darstellen und aus denen eine vollständige neuronale Architektur aufgebaut werden kann.

Der Vorteil dieses Mechanismus liegt darin, dass es nicht mehr notwendig ist, die gesamte Architektur zu suchen, sondern nur noch einige Teile.

Infolgedessen nehmen die differenzierbaren Methoden nur einige Dutzend GPU-Stunden in Anspruch.

Genetische Algorithmen

In diesem Fall wird das darwinistische Prinzip der genetischen Algorithmen angewandt. Hier werden Architekturkandidaten als die Menge von Individuen betrachtet, die sich untereinander fortpflanzen können, indem sie ihre Operationen (Gene) so mischen, dass neue Architekturen entstehen. Auf diese Weise wird eine Startpopulation schrittweise verfeinert, indem nur die besten Individuen, die nach einer bestimmten Bewertungsmethode ausgewählt wurden, sich fortpflanzen dürfen.

Ähnlich wie bei den Ansätzen zum Lernen durch Verstärkung sind diese Methoden teuer in den GPU-Stunden.

Die Anwendungen

NAS ist ein wachsender Bereich, der sich mit hoher Geschwindigkeit weiterentwickelt und immer wieder handgefertigte Architekturen überholt. Es ist auch ein Bereich mit enorm vielen Anwendungen, um nur einige zu nennen:

- Die Klassifizierung von Bildern

- Erkennung von Objekten

- Die Verarbeitung natürlicher Sprache

- Die Verarbeitung von Zeitreihen

- Die Erzeugung von Bildern, Videos und Sounds.

Vorteile und Einschränkungen

Eine wichtige Einschränkung der SINs ist der Rechenaufwand, den sie verursachen können, wenn man versucht, komplexe Themen mit einer großen Anzahl von latenten Lösungen anzugehen.

Je größer der Suchraum ist, desto mehr Optionen können getestet, trainiert und bewertet werden.

Es ist auch wichtig zu beachten, dass es schwierig ist, die Leistung eines potenziellen Modells vorherzusagen, wenn es in realen Daten evaluiert wird.

Außerdem muss der Suchraum immer von Hand definiert werden. Andererseits ist die Beherrschung des Themas kein Hindernis mehr für die Effizienz der Architektur.

Diese Schwierigkeiten werden jedoch mit dem Aufkommen schnellerer und umfassenderer Methoden zur Bewertung von Architekturen verschwinden.

Das bedeutet, dass die automatische neuronale Architektursuche bald in allen Unternehmen leicht anwendbar sein wird, um flexibel und effizient Lösungen zu finden, die den jeweiligen Bedürfnissen entsprechen.

Fazit

Die automatische Suche nach neuronaler Architektur ermöglicht es uns, neue Modelle von Grund auf neu zu erstellen, die besser sind als die von Hand erstellten, und zwar auf schnellere und bessere Weise, während wir gleichzeitig flexibel gegenüber möglichen Änderungen bleiben, die wir von Hand vornehmen möchten.