One-Hot-Encoding ist eine Methode, um kategorische Daten in numerische Vektoren zu verwandeln, die von Machine-Learning-Modellen verarbeitet werden können. Entdecke hier alles, was Du über diese Technik wissen musst!

Machine-Learning-Algorithmen sind leistungsstarke Rechner – mit einem großen Manko: Sie verstehen keinen Text. Für sie sind Wörter wie „blau“, „Paris“ oder „Katze“ reines Rauschen. Doch genau solche kategorialen Variablen sind in realen Datensätzen allgegenwärtig. Produktname, Familienstand, Land, Kartentyp… Nicht-numerische Spalten machen oft bis zu 40 % der Daten in KI-Anwendungsfällen aus.

Damit Modelle sie sinnvoll verarbeiten können, müssen diese Kategorien in Zahlen übersetzt werden. Eine der einfachsten und am weitesten verbreiteten Methoden dafür ist das One-Hot-Encoding: eine Technik, die jede Kategorie in einen binären Vektor umwandelt – eindeutig lesbar und ohne Mehrdeutigkeit. Doch hinter dieser scheinbaren Einfachheit steckt eine Mechanik, die gleichzeitig nützlich und manchmal auch etwas sperrig sein kann.

Lass uns anschauen, warum, wann und wie man One-Hot-Encoding sinnvoll einsetzt!

Kategorische Variablen: Eine allgegenwärtige Herausforderung

Sie tauchen in fast jeder Datentabelle auf und fallen doch nicht sofort ins Auge: kategorische Variablen sind Spalten, die keine Zahlen, sondern Namen, Typen oder Statuswerte enthalten. Wenn Du zum Beispiel eine Spalte „Farbe“ mit den Werten „rot“, „grün“ und „blau“ hast, arbeitest Du mit einer kategorialen Variable.

Das Problem? Machine-Learning-Algorithmen – egal ob linear, baumbasiert oder neuronale Netzwerke – können nur mit Zahlen umgehen. Lässt Du Zeichenfolgen in Deinen Daten, kannst Du sicher sein, dass Dein Modell entweder abstürzt oder, schlimmer noch, völlig falsche Schlüsse zieht.

Einfach „rot“ = 1, „grün“ = 2 und „blau“ = 3 zu setzen, reicht nicht – denn so entsteht für das Modell ein Eindruck von Reihenfolge oder Distanz, der gar nicht existiert. Deshalb ist Encoding ein unverzichtbarer Schritt in der Datenvorbereitung. Und eine der häufigsten Lösungen dafür ist das One-Hot-Encoding.

Doch bevor wir tiefer einsteigen, werfen wir einen Blick auf das grundlegende Prinzip.

Das Prinzip, das Text in Vektoren umwandelt

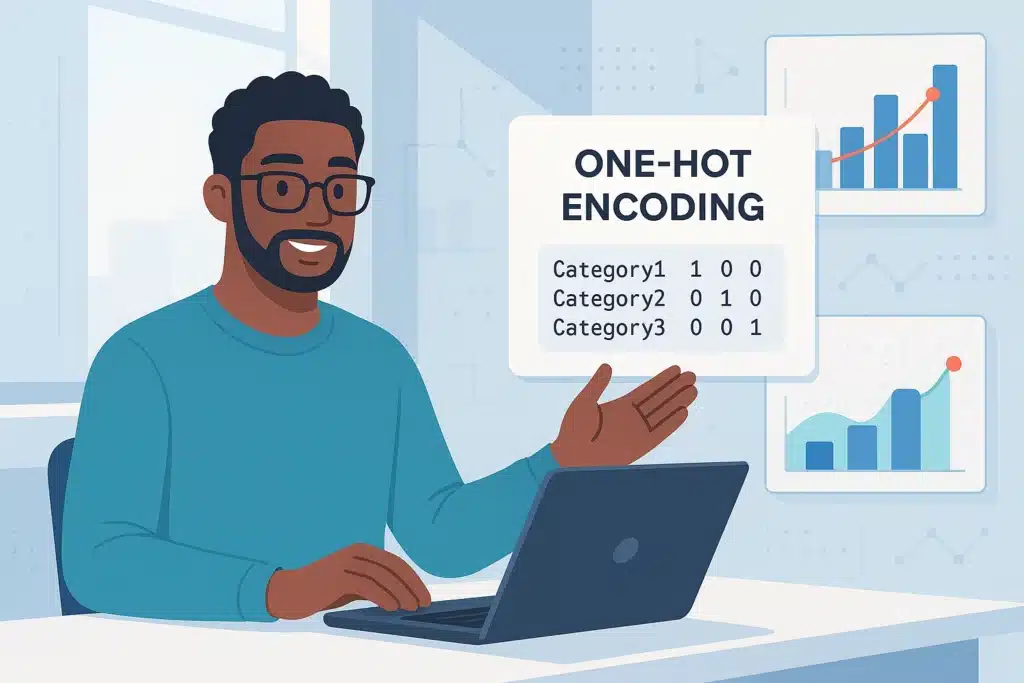

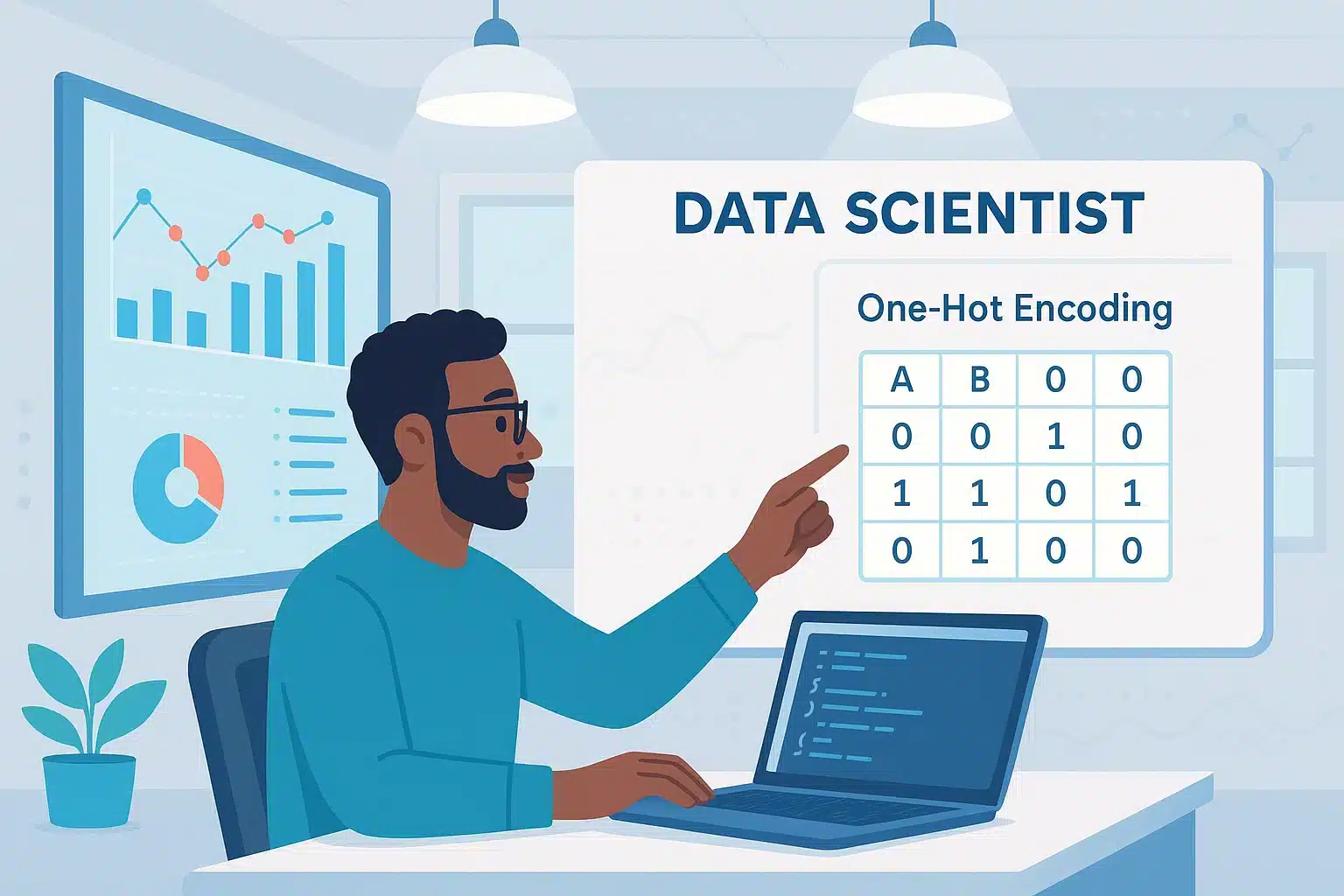

One-Hot-Encoding, auf Deutsch etwa „heiße binäre Codierung“, beruht auf einer simplen, aber äußerst wirkungsvollen Idee: Für jeden möglichen Wert einer kategorischen Variable wird eine eigene Spalte erstellt – und nur die Spalte, die dem tatsächlichen Wert entspricht, wird aktiviert. Alle anderen bleiben auf Null.

Ein Beispiel: Du hast eine Spalte „Farbe“ mit den Werten „rot“, „grün“ und „blau“. Beim One-Hot-Encoding entstehen daraus drei neue Spalten: farbe_rot, farbe_gruen und farbe_blau. Wenn eine Zeile den Wert „rot“ enthält, steht in farbe_rot eine 1 – und in den beiden anderen eine 0. Ist der Wert „blau“, steht die 1 in farbe_blau, die anderen bleiben Null.

Der Vorteil? Du vermeidest, dass das Modell eine falsche Ordnung zwischen den Kategorien hineininterpretiert. Würdest Du z. B. „rot“ = 1, „grün“ = 2 und „blau“ = 3 kodieren, könnte ein Algorithmus annehmen, dass „blau“ > „grün“ > „rot“ – obwohl diese Werte keine natürliche Reihenfolge haben.

Mit One-Hot-Encoding wird jede Kategorie als eigenständige Einheit behandelt – ganz ohne numerische oder hierarchische Beziehung zu den anderen. So vermeidest Du Verzerrungen durch eine künstliche Struktur in den Daten.

Diese Codierung ist ideal für nominale Variablen, also Kategorien ohne natürliche Ordnung – wie Geschlecht, Stadt oder Vertragsart.

Aber: Wie wir gleich sehen werden, hat diese Methode auch ihre Schwächen – vor allem, wenn die Zahl der Kategorien durch die Decke geht.

Implementierung in Python: Pandas oder Scikit-Learn - der Vergleich der Encoder

One-Hot-Encoding ist sauber, frei von Hierarchieverzerrungen und mit allen Modellen kompatibel. Aber es hat einen entscheidenden strukturellen Nachteil: Es erzeugt schnell eine riesige Anzahl von Spalten.

Ein Beispiel aus der Praxis: Du arbeitest mit einem E-Commerce-Datensatz, in dem die Variable „Produkt“ 1.200 verschiedene Referenzen enthält. Nach One-Hot-Encoding entstehen 1.200 Spalten. Das ist nicht nur unübersichtlich – es kann auch ernsthafte Probleme für Dein Modell verursachen. Zwei typische Herausforderungen tauchen auf:

Explosion der Dimensionalität: Jede neue Kategorie erzeugt eine Spalte. Das belastet das Modell, erhöht die Trainingszeit und kann Overfitting begünstigen – besonders bei empfindlichen Algorithmen wie KNN oder Entscheidungsbäumen.

Extreme Sparsity: In einer Matrix mit 1.200 Spalten gibt es pro Zeile nur eine einzige 1. Mehr als 95 % der Werte sind Null. Wenn Du das dichte Format verwendest, leidet Dein RAM spürbar.

One-Hot-Encoding ist also nicht ohne Vorsichtsmaßnahmen skalierbar. Bei Variablen mit hoher Kardinalität solltest Du genau überlegen, bevor Du einfach auf „Enkodiere“ klickst.

Wie weit kann man gehen? Kritische Schwellen, die Du kennen solltest

Ab wie vielen Modalitäten sollte man One-Hot-Encoding vermeiden? Es gibt keine absolute Regel, aber die Community ist sich einig: Ab etwa 10 bis 15 einzigartigen Kategorien lohnt es sich, über Alternativen nachzudenken.

Mehrere Probleme häufen sich:

Multikollinearität und die „Dummyfalle“: Wenn für jede Kategorie eine Spalte erstellt wird, entsteht eine vollständige Redundanz (die Summe aller Spalten ergibt immer 1). Manche Modelle, besonders lineare Regressionen, leiden darunter. Die Lösung: eine Referenzspalte löschen.

Instabilität bei kleinen Datensätzen: Bei wenigen Beobachtungen, aber vielen Kategorien steigt das Overfitting-Risiko stark. Außerdem können Daten unausgewogen sein – einige Kategorien tauchen nur ein- oder zweimal auf und erzeugen fast leere Spalten.

Kurz gesagt: Je mehr Modalitäten, desto eher wird One-Hot-Encoding zu einer zweischneidigen Waffe. Zum Glück ist es nicht die einzige Option im Werkzeugkasten eines Data Scientists.

Wann Du One-Hot-Encoding verwenden solltest – und wann nicht

Die Wahl der Encodierungsmethode ist entscheidend. Einige Situationen eignen sich hervorragend für One-Hot-Encoding, andere weniger.

Sinnvoll ist es für:

Variablen mit wenigen einzigartigen Kategorien, z. B. Land, Geschlecht oder Vertragsart, oder wenn die Daten gut ausgeglichen sind und es kaum seltene Kategorien gibt.

Einfache oder lineare Modelle wie logistische Regression, SVM oder Perceptron.

Erklärbare Anwendungsfälle wie Churn-Analyse, Kundenscoring oder Marketingprojekte, bei denen die Interpretierbarkeit der Features wichtig ist.

Vermeiden solltest Du One-Hot-Encoding bei:

Spalten mit Dutzenden oder Hunderten von Kategorien.

Datensätzen mit wenigen Beobachtungen oder vielen fehlenden Werten.

Kluge Alternativen: Wenn One-Hot-Encoding an seine Grenzen stößt

Wenn die Anzahl der Kategorien stark ansteigt, stößt One-Hot-Encoding schnell an seine Grenzen. Zum Glück gibt es im Machine-Learning-Ökosystem mehrere Alternativen – jede mit ihren bevorzugten Anwendungsfällen.

Label Encoding ersetzt jede Kategorie durch eine eindeutige Ganzzahl. Einfach und schnell, aber bei linearen Modellen oder distanzbasierten Algorithmen problematisch, da eine künstliche Ordnung eingeführt wird („grün“ = 1, „rot“ = 2, „blau“ = 3…). Für Entscheidungsbäume hingegen ist diese Methode unkritisch, da sie nicht empfindlich auf die Reihenfolge reagiert.

Target-Encoding (auch Mean-Encoding genannt) ersetzt jede Kategorie durch den Durchschnitt der Zielvariablen für diese Kategorie. Beispiel: „Premium“-Kunden kaufen im Schnitt für 300 €, also wird „Premium“ mit 300 kodiert. Dies ist leistungsfähig bei Variablen mit hoher Kardinalität, erfordert jedoch sorgfältige Cross-Validation, um Datenlecks oder Überanpassung zu vermeiden.

Embeddings sind in Deep-Learning-Anwendungen populär. Hierbei werden Kategorien in vom Modell gelernte kontinuierliche Vektoren transformiert. Ähnliche Kategorien liegen nah beieinander im Vektorraum. Besonders effektiv bei sehr großen Datensätzen, z. B. in NLP oder Produktempfehlungen.

Feature Hashing kodiert Kategorien nicht explizit, sondern überführt sie per Hash-Funktion auf eine feste Anzahl von Spalten. Das reduziert die Spaltenexplosion, ist aber weniger lesbar, und es können mehrere Kategorien im gleichen „Bucket“ landen (Hash-Kollision).

Letztlich hängt die Wahl der Methode von der Größe deines Datensatzes, dem verwendeten Modell und der Art der Kategorien ab.

One-Hot-Encoding und Deep Learning: Allianz oder Veralterung?

In Deep-Learning-Architekturen könnte man denken, dass One-Hot-Encoding überholt ist. Trotzdem wird es nach wie vor verwendet – in bestimmten Fällen. Es bleibt nützlich für einfache Klassifikationsaufgaben mit wenigen Klassen oder bei der Vorverarbeitung kurzer Sequenzen (z. B. Zeichen oder Tokens im NLP). Auch wenn es keine lernenbaren Embeddings gibt oder die Datenmenge klein ist, kann es relevant sein.

Sobald es jedoch um komplexere Probleme geht – NLP, Empfehlungen, Benutzerdaten – sind Embeddings eindeutig die bessere Wahl. Sie sind kompakter, aussagekräftiger und werden direkt vom Modell gelernt. Typisches Beispiel: Anstatt jedes Wort in eine lange binäre Spalte zu verwandeln, verwendet man einen Embedding-Vektor mit z. B. 300 Dimensionen, der Bedeutung, Kontext und Ähnlichkeiten abbildet.

Fazit: One-Hot-Encoding – einfach, aber mit Vorsicht

One-Hot-Encoding ist wie das Schweizer Taschenmesser für Data-Science-Anfänger: leicht zu handhaben, mit fast allen Modellen kompatibel und für viele praktische Fälle robust. Doch hinter der Einfachheit verbergen sich Fallen: Spaltenexplosion, dünnbesetzte Matrizen, Overfitting, Multikollinearität. Gründe genug, es nicht blind einzusetzen.

Richtig eingegrenzt und kalibriert bleibt es ein unverzichtbarer Standard der Vorverarbeitung. Falsch eingesetzt, kann es aber zu einer Last werden, die die Leistung deiner Modelle beeinträchtigt.

Wenn Du Deine Kenntnisse in Datenvorverarbeitung, Encodierung, Machine Learning und Deep Learning vertiefen möchtest, sind die KI-Schulungen von DataScientest ideal. Unsere Programme vermitteln die Grundlagen der KI-Modelle, den Umgang mit realen Datensätzen und die Umsetzung kompletter Pipelines mit Scikit-learn und TensorFlow. Du lernst, das Beste aus Methoden wie One-Hot-Encoding, Embeddings oder PCA herauszuholen.

Dank praxisorientierter Lernmethoden und konkreten Übungen wirst Du leistungsstarke Modelle entwickeln können und eine anerkannte Zertifizierung erlangen. Die Schulungen passen sich Deinem Tempo an: intensives BootCamp, kontinuierliches Format oder im Wechsel, mit Finanzierungsmöglichkeiten wie CPF oder France Travail. Lerne mit uns bei DataScientest, den Daten einen Sinn zu geben!