La Low Rank Adaptation ou adaptation à faible rang est une technique permettant d’adapter facilement un modèle de machine learning à plusieurs domaines après son entraînement initial sur une tâche spécifique. Découvrez tout ce que vous devez savoir sur cette méthode et ses avantages !

Le Machine Learning est désormais utilisé dans une large variété de domaines dont la reconnaissance vocale, la vision par ordinateur ou le traitement du langage naturel.

Il sert de fondation à la révolution de l’intelligence artificielle, et notamment pour les outils devenus incontournables comme ChatGPT ou Google Bard.

Toutefois, la plupart des systèmes d’apprentissage automatique sont spécifiquement conçus et formés pour des tâches particulières et des ensembles de données spécifiques.

C’est l’une des principales limites actuelles de l’IA, car la généralisation des modèles à de nouvelles situations ou à des domaines différents se révèle souvent décevante et infructueuse.

Afin de transférer un modèle ML à un nouveau domaine et d’améliorer ses performances, une récente technique d’adaptation s’avère particulièrement efficace : l’adaptation à faible rang, ou Low Rank Adaptation.

Qu’est-ce que la Low Rank Adaptation ?

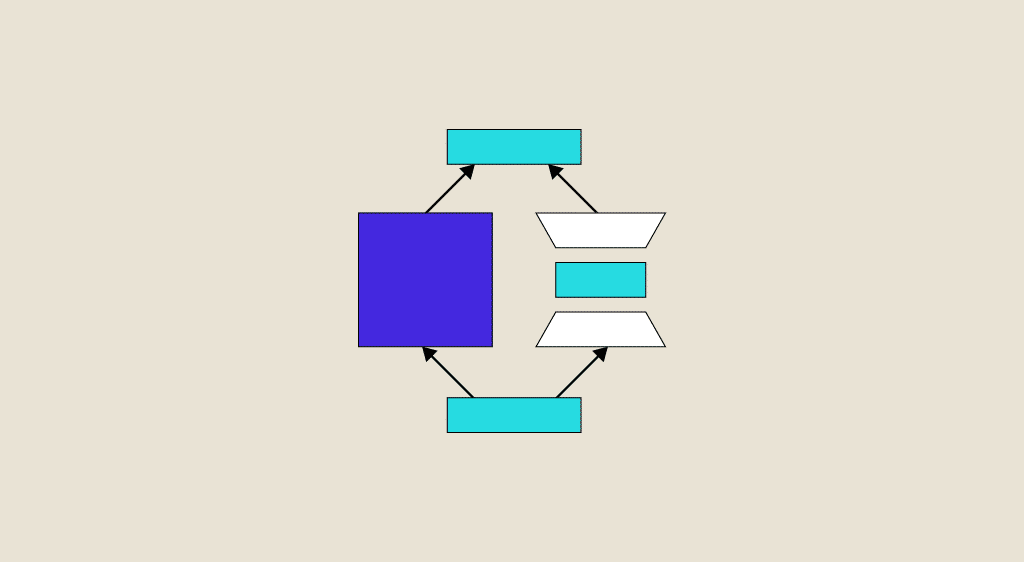

Cette approche novatrice se concentre sur la réduction de la dimensionnalité des données, dans le but de faciliter l’adaptation de domaine : le transfert d’un modèle depuis un domaine source où il est entraîné vers un domaine cible où les données peuvent être différentes.

Un concept central de cette méthode est la décomposition à faible rang des matrices. Celle-ci permet de représenter les données sous une forme plus compacte, tout en préservant leur structure sous-jacente.

Dans le contexte de l’apprentissage automatique, cette décomposition vise à extraire les caractéristiques les plus importantes des données d’entraînement. Le but est de construire un modèle plus généralisable pour le domaine cible.

Il existe différentes méthodes pour y parvenir. Les plus utilisées sont la décomposition en valeurs singulières (Singular Value Decomposition ou SVD) et la décomposition en facteurs non négatifs (Non-Negative Matrix Factorization ou NMF).

Grâce à la réduction de dimensionnalité des données, on évite les problèmes de surajustement (overfitting) pouvant survenir quand les modèles sont directement appliqués à des données de cibles différentes. C’est ce qui simplifie le transfert de connaissances.

L’un des principaux points forts de la Low Rank Adaptation est sa capacité à capturer les corrélations et dépendances entre les caractéristiques des données. Ainsi, l’information cruciale pour l’adaptation est mieux représentée.

Un autre avantage est la possibilité d’appliquer cette approche à différentes tâches de Machine Learning comme la classification, la régression ou même la génération de données synthétiques.

À quoi ça sert ? Quelles sont les applications ?

La Low Rank Adaptation est une méthode qui a fait ses preuves, et qui est déjà adoptée dans de nombreux domaines du Machine Learning.Dans la vision par ordinateur (Computer Vision), elle est utilisée pour la reconnaissance d’objets au sein d’environnements différents de ceux utilisés pour l’entraînement initial.

En utilisant des décompositions à faible rang sur les représentations des caractéristiques des images, les modèles ML peuvent mieux généraliser à de nouvelles conditions d’éclairage, d’angle de vue ou d’environnement pour améliorer considérablement leurs performances dans le monde réel.

Pour le NLP ou traitement naturel du langage, cette approche s’avère aussi très efficace pour les tâches de traduction automatique.

Alors que les données des domaines sources et cibles peuvent considérablement varier, l’adaptation à faible rang permet de créer des modèles plus flexibles en extrayant les aspects linguistiques essentiels et en les appliquant au nouveau domaine. La traduction dans des contextes différents s’en trouve améliorée.

De même, pour la reconnaissance de la parole, la Low Rank Adaptation est utile pour adapter les modèles de reconnaissance vocale à des locuteurs spécifiques ou à différents environnements acoustiques.

Les techniques de décomposition à faible rang permettent aux systèmes de mieux capturer les variations entre les interlocuteurs et donc d’obtenir une meilleure précision dans des situations variées.

Enfin, en intégrant cette méthode d’adaptation aux architectures de réseaux de neurones, l’apprentissage par transfert est facilité. Les connaissances acquises dans un domaine sont transmises à un domaine cible, augmentant fortement les performances pour une large variété de tâches.

Les défis de la Low Rank Adaptation

Tous les exemples évoqués dans le chapitre précédent démontrent l’efficacité de la Low Rank Adaptation pour surmonter les défis liés à l’adaptation de domaine dans le Machine Learning.

Malgré ses nombreux avantages, cette approche présente aussi des défis spécifiques à relever. Par exemple, la gestion du surajustement (overfitting) et du sous-ajustement (underfitting) des modèles peut être difficile.

Une décomposition à faible rang trop restrictive peut entraîner une perte d’informations cruciales, tandis qu’une décomposition trop complexe peut conduire à la suradaptation aux données d’entraînement. Trouver le bon équilibre est donc essentiel pour l’optimisation des performances sur de nouvelles données.

Autre problème potentiel : les domaines sources et cibles peuvent être extrêmement différents, ce qui entraîne une hétérogénéité des données compliquant fortement l’adaptation.

La diversité des caractéristiques entre les deux domaines peut en effet affecter la capacité du modèle à transférer des connaissances de manière appropriée.

Pour éviter ce désagrément, il convient de développer des techniques de décomposition à faible rang capables de capturer les variations tout en conservant les structures essentielles.

Enfin, dans de nombreuses situations, il n’est pas toujours évident d’obtenir des données étiquetées dans le domaine cible. Elles peuvent être limitées, ou tout simplement trop coûteuses.

Or, la Low Rank Adaptation requiert généralement une large quantité de données pour construire des modèles généralisables. Ceci exige des recherches supplémentaires pour développer des méthodes exploitant les données non étiquetées ou semi-étiquetées, comme l’adaptation à faible rang transductive.

Conclusion : la Low Rank Adaptation, une avancée vers l’émergence d’une IA générale

En permettant de résoudre les problèmes liés à l’adaptation de domaine, la Low Rank Adaptation aide à transférer efficacement les performances d’un modèle de Machine Learning vers différents domaines.

Ainsi, cette méthode constitue une piste potentielle vers le développement d’une IA générale (AGI) capable d’exceller sur n’importe quelle tâche et d’apprendre sans avoir besoin de données. Une telle invention est considérée par beaucoup comme le but ultime de la recherche en intelligence artificielle…

Afin d’apprendre à maîtriser la Low Rank Adaptation et toutes les meilleures techniques de Machine Learning, vous pouvez choisir DataScientest.

Nos formations aux métiers de la Data Science comportent toutes un ou plusieurs modules dédiés à l’apprentissage automatique. Vous découvrirez notamment les techniques de classification, régression et clustering avec scikit-learn, les réseaux de neurones et les outils tels que Keras, TensorFlow et PyTorch.

Au fil du cursus, vous pourrez acquérir toutes les compétences requises pour devenir Data Analyst, Data Engineer, Data Scientist ou Machine Learning Engineer.

Tous nos programmes se complètent entièrement à distance, et notre organisme reconnu par l’État est éligible au CPF pour le financement. À la fin du parcours, vous pourrez recevoir un diplôme délivré par MINES Paris Executive Education et un certificat de nos partenaires cloud AWS et Microsoft Azure. Découvrez DataScientest !

Vous savez tout sur la Low Rank Adaptation. Pour plus d’informations au sujet du Machine Learning, découvrez notre dossier sur le Transfert Learning !