Phi-4 est le dernier modèle de langage développé par Microsoft et qui repousse les limites des small language models avec pas moins de 14 milliards de paramètres. Conçu pour des performances de pointe en raisonnement complexe, notamment en mathématiques, tout en excellant dans le traitement linguistique classique.

Phi-4 : C’est quoi exactement ?

Phi-4 est un petit modèle de langage (SLM) développé par Microsoft, doté de 14 milliards de paramètres. Initialement disponible sur Azure AI Foundry, il est désormais accessible en open source sur Hugging Face sous licence MIT.

Ce modèle se distingue par ses performances supérieures à celles de Google Gemini Pro 1.5 et OpenAI GPT-4, notamment dans des tâches complexes comme le raisonnement mathématique, tout en consommant moins de ressources informatiques que les grands modèles de langage (LLM).

Conçu à partir d’un mélange de données synthétiques, de sites web du domaine public, de littérature académique et de jeux de données de questions-réponses, Phi-4 a été optimisé pour offrir des résultats de haute qualité avec un raisonnement avancé. Microsoft a mis l’accent sur la robustesse et la sécurité du modèle, en utilisant des techniques de réglage fin supervisé (SFT) et d’optimisation directe des préférences (DPO) pour garantir une adhésion précise aux instructions et des mesures de sécurité solides.

Phi-4 est particulièrement adapté aux environnements avec des contraintes de mémoire et de calcul, ainsi qu’aux scénarios nécessitant une faible latence. En somme, il représente une avancée significative dans la recherche sur les modèles de langage, offrant une alternative performante et économe en ressources pour les applications d’IA générative.

Quelles sont les performances de Phi-4 ?

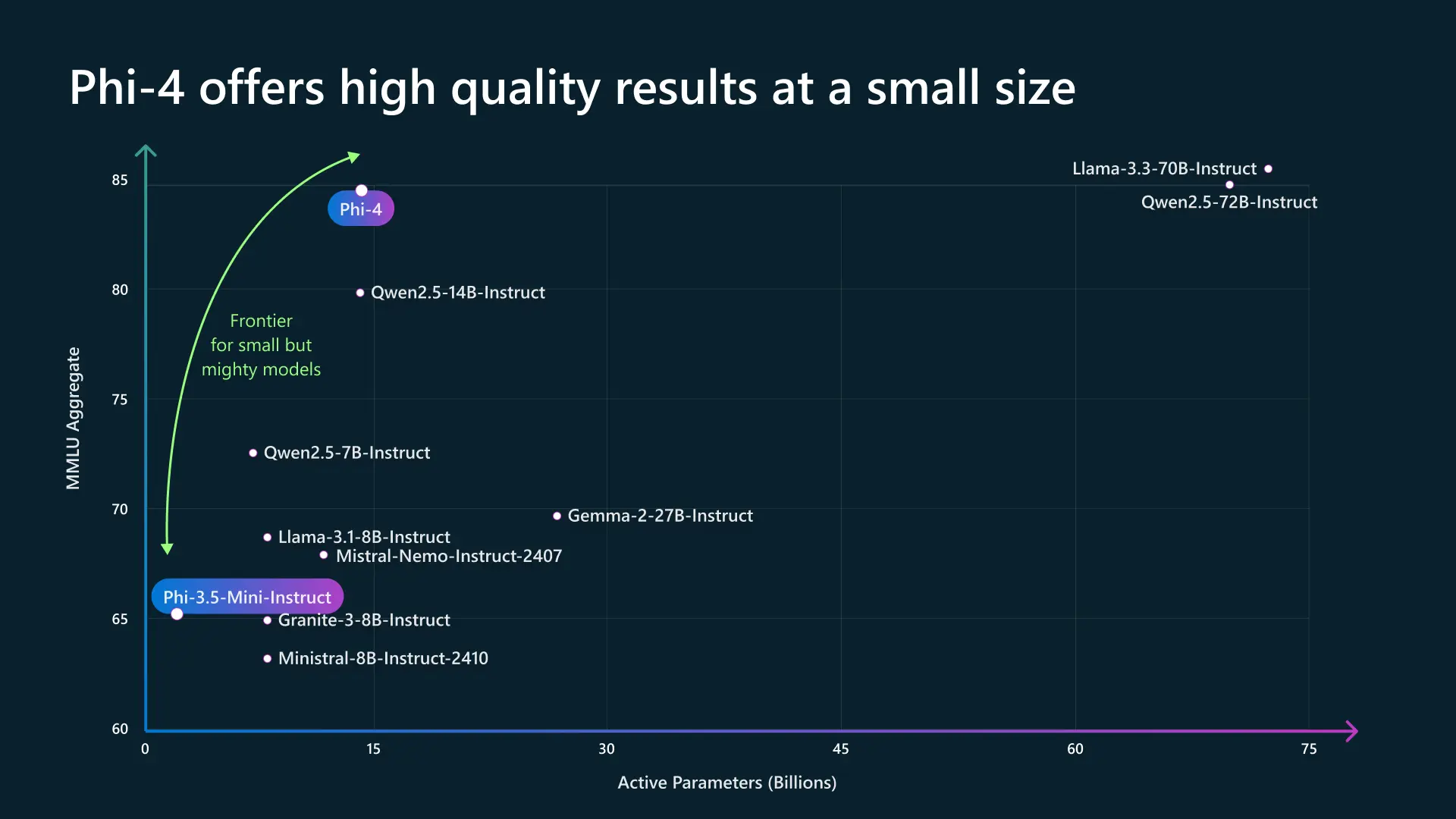

Dans un paysage où la puissance des modèles de langage est souvent associée à leur taille, Phi-4 bouscule cette tendance en prouvant qu’un modèle compact peut rivaliser avec des architectures bien plus massives. Grâce à une optimisation poussée, il parvient à atteindre un haut niveau de performance en compréhension et en raisonnement, tout en conservant une empreinte réduite.

Là où d’autres modèles nécessitent des dizaines de milliards de paramètres actifs pour offrir des résultats comparables, Phi-4 s’impose comme un équilibre parfait entre efficacité et puissance. Ce positionnement stratégique répond à une demande croissante pour des IA plus accessibles et économes en ressources, sans compromis sur la qualité.

Son architecture optimisée permet non seulement une exécution plus rapide, mais aussi une meilleure adaptabilité à des environnements aux ressources limitées, comme les applications embarquées ou les serveurs à faible consommation énergétique. En réduisant la dépendance à des infrastructures massives, Phi-4 ouvre la voie à une démocratisation de l’intelligence artificielle, où performances élevées et efficacité énergétique ne sont plus incompatibles. Il illustre ainsi une nouvelle génération de modèles capables de répondre aux besoins industriels et académiques tout en restant agiles et évolutifs.

Qu’est-ce qui différencie Phi-4 des autres modèles similaires ?

Phi-4 se distingue par son excellente optimisation, rivalisant avec des modèles légèrement plus grands (comme Qwen2.5-14B ou Mixtral) tout en restant léger et performant. Son score MMLU de 85 en fait un modèle très compétitif dans la catégorie des SLM (Small Language Models).

Modèle | Paramètres actifs (B) | Score MMLU | Type | Avantages principaux | Inconvénients |

Phi-4 | ~10B | ~85 | Modèle optimisé, compact | Excellente performance pour sa taille, efficace en inférence, bon raisonnement | Moins puissant que les modèles plus grands comme GPT-4 ou Llama 3-70B |

Mixtral (Mistral AI) | 12.9B (MoE, 2 experts actifs) | ~82-83 | MoE (Mixture of Experts) | Très bon équilibre entre performance et efficacité, rapide et optimisé | Plus lourd en inférence que Phi-4 |

Qwen2.5-14B-Instruct | 14B | ~80 | Modèle dense | Bonne compréhension du langage naturel, fort en tâches générales | Moins optimisé que Phi-4, nécessite plus de puissance |

Llama 3.1-8B-Instruct | 8B | ~70 | Modèle dense | Léger et efficace, bon compromis pour certaines tâches | Inférieur en performance globale à Phi-4 |

Mistral-8B-Instruct | 8B | ~68-70 | Modèle dense | Très efficace en inférence, open-source | Score MMLU plus bas que Phi-4, moins polyvalent |

Granite-3-8B-Instruct | 8B | ~65-67 | Modèle dense | Compact et rapide | Moins performant que Phi-4 sur le raisonnement et l’analyse |

Là où d’autres modèles nécessitent davantage de paramètres pour atteindre des performances similaires, Phi-4 tire parti d’une architecture avancée et d’optimisations spécifiques pour maximiser son efficacité. Cela lui permet non seulement de surpasser des modèles d’une taille comparable, mais aussi de s’approcher des capacités de modèles plus massifs, tout en maintenant une empreinte réduite.

Son inférence rapide et son équilibre entre puissance et consommation de ressources le rendent idéal pour des cas d’usage variés, notamment en milieu professionnel et académique. Contrairement aux modèles plus lourds qui exigent des infrastructures robustes pour fonctionner de manière optimale, Phi-4 se positionne comme une solution agile, parfaitement adaptée aux systèmes contraints en puissance de calcul. En intégrant des mécanismes avancés de traitement du langage et de raisonnement, il se démarque comme un choix stratégique pour ceux qui recherchent une IA performante, accessible et efficace.

Cas d’usage : Phi-4 face à un problème de logique mathématique

Imaginons un étudiant préparant un examen de mathématiques et confronté à un problème complexe :

« Un escargot grimpe un mur de 10 mètres. Chaque jour, il monte de 3 mètres mais glisse de 2 mètres la nuit. En combien de jours atteindra-t-il le sommet ? »

Un modèle classique pourrait simplement donner une réponse en calculant mécaniquement :

- Jour 1 : il monte à 3 m, redescend à 1 m

- Jour 2 : il monte à 4 m, redescend à 2 m

- Etc.

Mais Phi-4 va plus loin en appliquant un raisonnement structuré :

- Il identifie le schéma récurrent : chaque jour, l’escargot progresse réellement de 1 mètre net.

- Il optimise le raisonnement : au bout de 7 jours, il atteindra 7 mètres.

- Il détecte une exception : le huitième jour, il grimpe directement de 3 mètres et atteint le sommet sans redescendre.

- Il conclut donc correctement que l’escargot met 8 jours à arriver en haut.

Ce type de raisonnement structuré montre comment Phi-4 ne se limite pas à des réponses automatiques : il décompose un problème, en identifie les pièges cachés et aboutit à une solution de manière logique et efficace.

Conclusion

En conclusion, Phi-4 incarne une avancée majeure dans le domaine des petits modèles de langage (SLM), combinant performance, efficacité et accessibilité. Ce modèle positionne Microsoft à la pointe de l’innovation en IA générative, offrant une alternative puissante et polyvalente pour des applications variées, notamment en raisonnement complexe et en traitement linguistique.